ICCV 2019:华为、北大等首创GAN剪枝算法,线上加速 3 倍以上

新智元专栏

新智元专栏

作者:王云鹤 (华为诺亚)

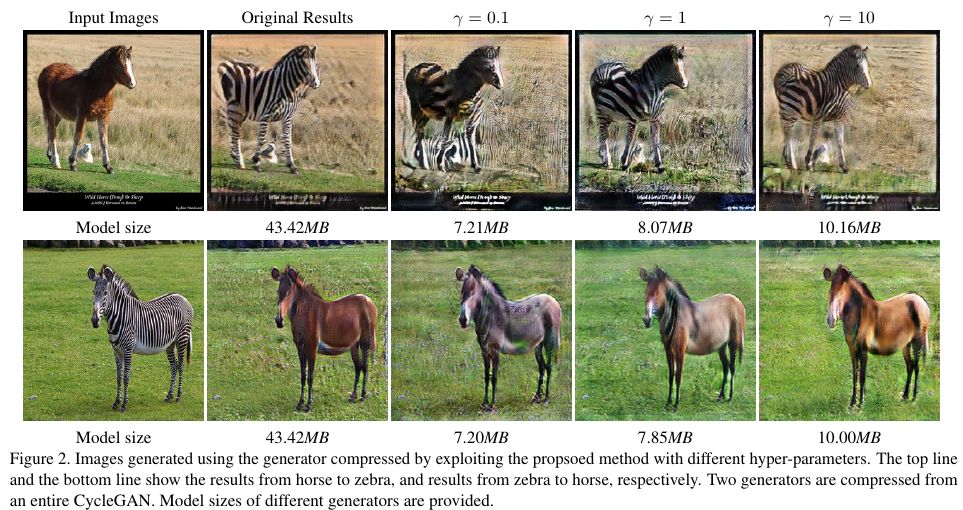

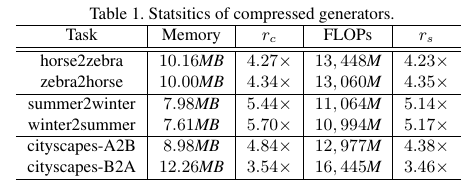

【新智元导读】华为诺亚方舟实验室最新研究首次提出针对GAN中生成网络的剪枝算法,在图像迁移任务中,可以在保持迁移效果的情况下,网络参数量和计算量压缩四倍以上,实测推理时间压缩三倍以上。论文已被ICCV 2019录用。

和原始生成器

和原始生成器

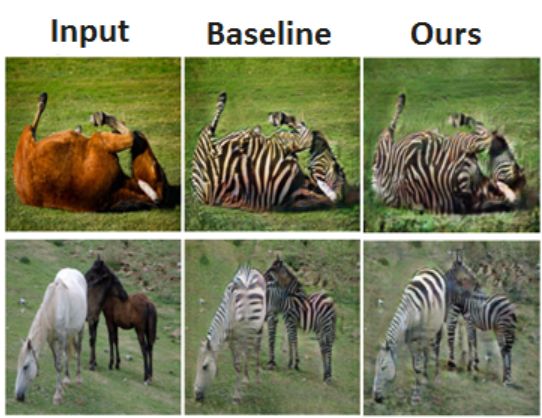

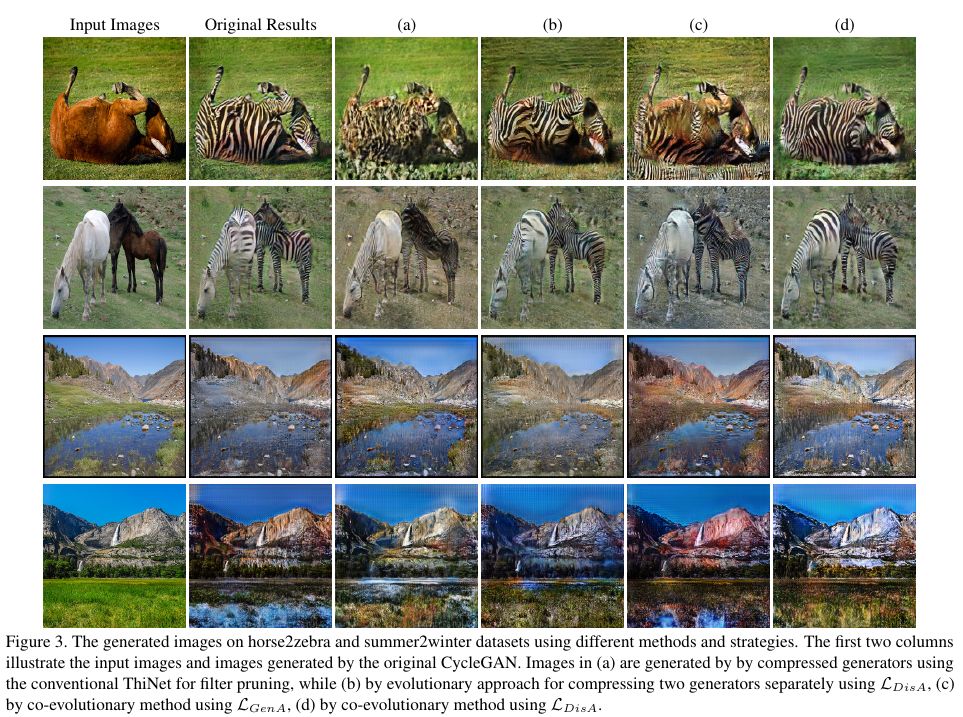

尽量像素相近,但是在图像风格迁移任务中确没必要。比如,一个 “斑马”,不管是有 5 条还是 8 条白色条纹,都可以看成是成功的风格迁移,但是体现在公式 1 中的差别可能很大。所以优化公式 1 并不能准确地去除风格迁移任务中的参数冗余。

尽量像素相近,但是在图像风格迁移任务中确没必要。比如,一个 “斑马”,不管是有 5 条还是 8 条白色条纹,都可以看成是成功的风格迁移,但是体现在公式 1 中的差别可能很大。所以优化公式 1 并不能准确地去除风格迁移任务中的参数冗余。

经常不会被使用,但是判别器

经常不会被使用,但是判别器

中包含了判别图像域的重要信息,因此论文提出了判别器感知损失来牵引生成器的压缩过程。

中包含了判别图像域的重要信息,因此论文提出了判别器感知损失来牵引生成器的压缩过程。

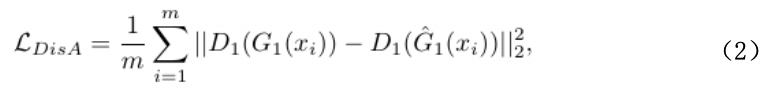

是原始网络中的判别器。与公式 1 相比,公式 2 并不直接关注压缩前后的生成器模型在像素级别的相似性,而是通过判别器,更加关注压缩前后风格的一致性,这对压缩生成器是一个更好的优化方向。

是原始网络中的判别器。与公式 1 相比,公式 2 并不直接关注压缩前后的生成器模型在像素级别的相似性,而是通过判别器,更加关注压缩前后风格的一致性,这对压缩生成器是一个更好的优化方向。

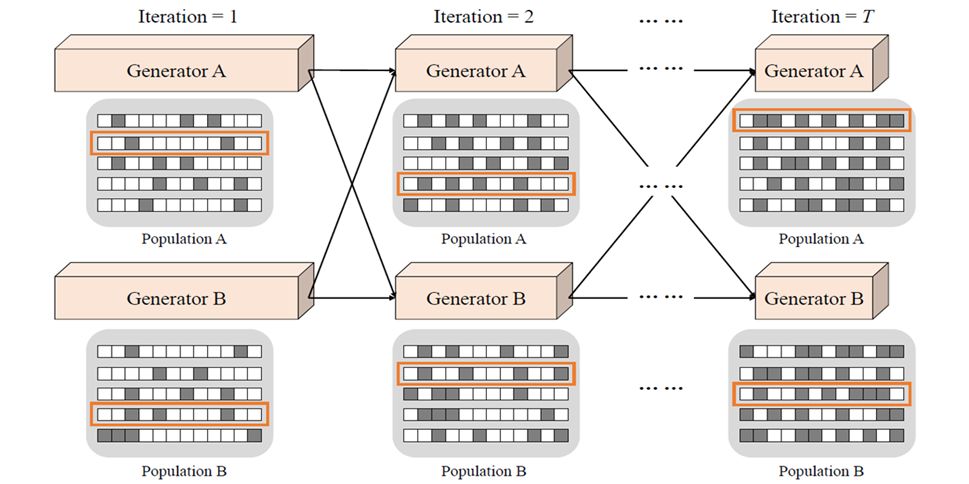

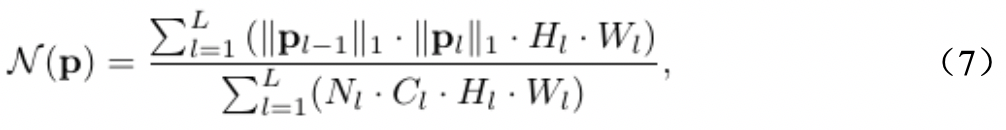

表示网络的参数量,

表示网络的参数量,

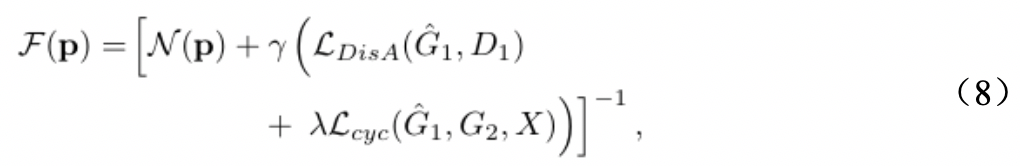

用来平衡网络参数量和压缩模型的误差。

用来平衡网络参数量和压缩模型的误差。

: 压缩后的

: 压缩后的

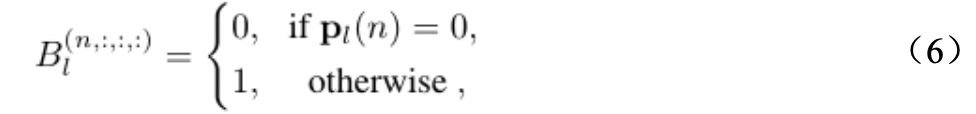

由一串固定长度的二值编码表示,编码的每一位表示网络的每一个通道,如公式 6 所示。

由一串固定长度的二值编码表示,编码的每一位表示网络的每一个通道,如公式 6 所示。

表示生成网络中第

表示生成网络中第

层的通道编码,

层的通道编码,

表示把第 n 个卷积通道去除,反之则保留。

表示把第 n 个卷积通道去除,反之则保留。

:

与

:

与

一样,对

一样,对

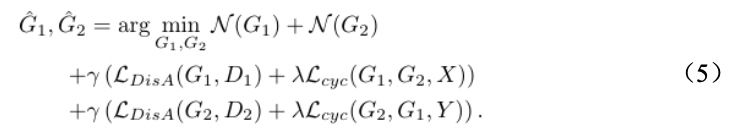

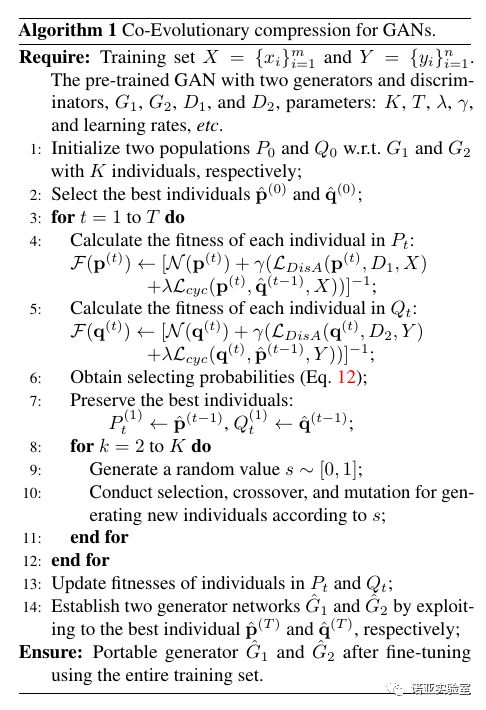

维持一个种群,也可以通过进化算法选出适应值最优的个体。但是,通过公式 8 可以看出,循环一致性误差计算同时涉及两个生成器,所以同时对

维持一个种群,也可以通过进化算法选出适应值最优的个体。但是,通过公式 8 可以看出,循环一致性误差计算同时涉及两个生成器,所以同时对

和

和

分别维护一个种群。具体来说,在 t 次迭代中,用 t-1 次迭代中适应值最优的

分别维护一个种群。具体来说,在 t 次迭代中,用 t-1 次迭代中适应值最优的

去和

去和

种群训练,得到适应值最优的

种群训练,得到适应值最优的

,然后用适应值最优的

,然后用适应值最优的

和

和

种群训练,得到 t 迭代

种群训练,得到 t 迭代

种群的适应值。

种群的适应值。

登录查看更多

相关内容

专知会员服务

26+阅读 · 2019年11月23日

专知会员服务

17+阅读 · 2019年11月17日

Arxiv

9+阅读 · 2019年2月21日

Arxiv

5+阅读 · 2018年7月6日