BAT机器学习面试1000题(396~400题)

点击上方蓝字关注

BAT机器学习面试1000题(396~400题)

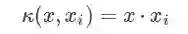

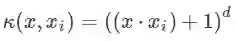

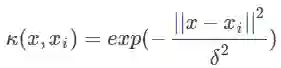

396题

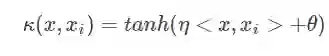

请说说常用核函数及核函数的条件

点击下方空白区域查看答案

▼

397题

请具体说说Boosting和Bagging的区别

点击下方空白区域查看答案

▼

398题

逻辑回归相关问题

点击下方空白区域查看答案

▼

399题

什么是共线性, 跟过拟合有什么关联?

点击下方空白区域查看答案

▼

400题

用贝叶斯机率说明Dropout的原理

点击下方空白区域查看答案

▼

题目来源:七月在线官网(https://www.julyedu.com/)——面试题库——面试大题——机器学习

分享一哈

分享完机器学习面试题

再和大家分享一哈

我们的

【计算机视觉第二期】

正在火热报名中喔

还没报名的小伙伴们

抓紧时间喽

2人及2人以上组团

立减100元

想组团者可以添加客服:

julyedukefu_02

让客服帮忙组团享受优惠喔

点击下方“阅读原文”

可在线报名

更多资讯

请戳一戳

往期推荐

机器学习中4种常见的防止过拟合方法,你都知道哪些?(文末有惊喜)

点击“阅读原文”,可在线报名

登录查看更多