ICLR 2022 | 图与主动学习:软标签情况下如何设计图上主动学习策略?

©作者 | PKU-DAIR

来源 | PKUDAIR

ICLR (International Conference on Learning Representation) 国际表征学习大会是公认的深度学习领域国际顶级会议之一,关注有关深度学习各个方面的前沿研究,在人工智能、统计和数据科学领域以及机器视觉、语音识别、文本理解等重要应用领域中发布了众多极其有影响力的论文。

论文标题:

Information Gain Propagation: A New Way To Graph Active Learning With Soft Labels

收录会议:

ICLR 2022

问题背景

举个具体的例子就是,在 arxiv 的论文分类中,金融的细分分类有计算金融、数学金融等,那么计算金融的专家只能知道某篇论文是否属于计算金融,但判定不出它具体的分类。这时,专家给出的标签就只能是软标签而不是传统的 one-hot 硬标签。如何设计在软标签下的图主动学习策略是该论文要解决的问题。

▲ 图1. 硬标签和软标签以及对应oracle的区别

相关工作

与训练数据独立同分布的图像、文本或表格数据不同,图数据样本通过图中的边连接而互相影响。所以图神经网络通过聚合邻居的节点嵌入或特征以增强它们沿边的嵌入,以利用图数据特定的结构信息。图神经网络有许多变种,比如 GCN [1]、MVGRL [2] 等。

2.2 主动学习(AL)

主动学习通过更好的样本点选择来提高模型的效果和效率。常见的主动学习方法有如下几种:不确定性抽样方法通过考虑信息量选择模型预测最不确定的节点;Query-by-Committee [3] 方法训练一个模型委员会,并根据模型不同意的程度选择样本;基于密度、聚类和多样性的方法选取选择最具代表性的样本。此外,针对多标签分类问题和类不平衡问题也有相应的方法。

IGP方法

▲ 图2. IGP框架

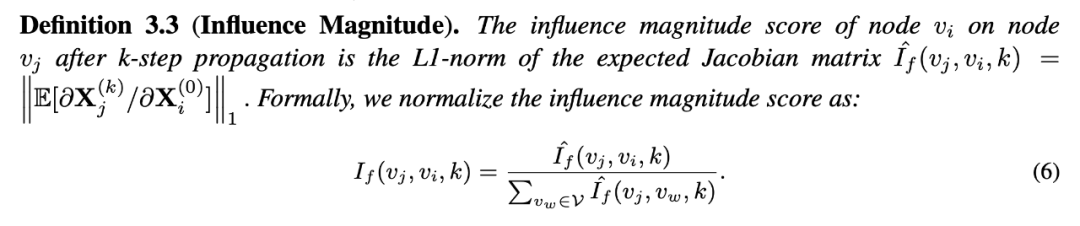

与之前的标注方式要求 oracle 直接提供标注不同,IGP 中的 oracle 只需要判断模型的预测是否正确即可。而正确和不正确的预测都将提供信息增益使节点标签的不确定性会降低,从而增强标签监督,如果丢弃不正确的预测,就会损失这一部分的信息。我们通过交叉熵来计算每一种可能的信息增益并将它们作加权平均。

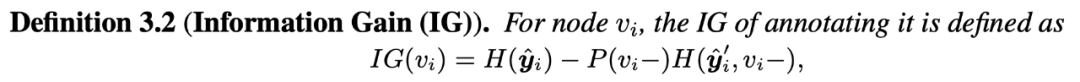

每个新标注的节点都会将其标签信息传播给 k 层图神经网络中的 k 跳邻居,并相应地影响这些节点的标签分布。由于节点对其不同邻居的影响可能是多种多样的,我们通过计算节点 i 的输入标签的变化对 k 步传播后节点 j 的传播标签的影响来衡量它,公式如下图:

对于 k 层 GNN,一个节点的监督信号可以传播到其 k 跳邻域节点,然后影响这些邻域的标签分布。因此,在节点选择过程中只考虑节点自身的信息增益是不合适的。于是我们扩展了图 3 中定义的单个节点的信息增益到图中它的 k-hop 邻居,具体公式如下:

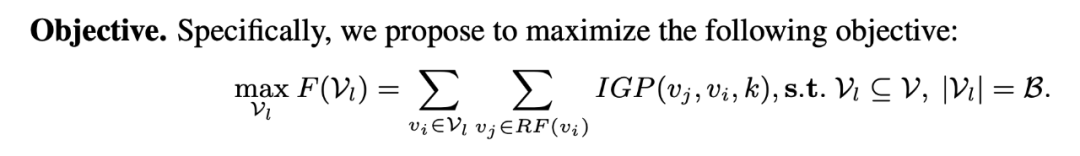

在确定了每个点对于全图的信息增益后,我们在每一批选点中,都优先挑选信息增益最大的点来给 oracle 打标签,并将得到的软标签交给模型进行下一步的训练迭代,直至用完所有的打标签预算。具体优化目标的公式如下:

▲ 图6. 选点目标公式

实验

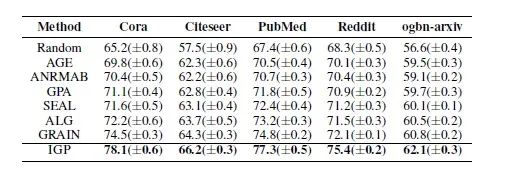

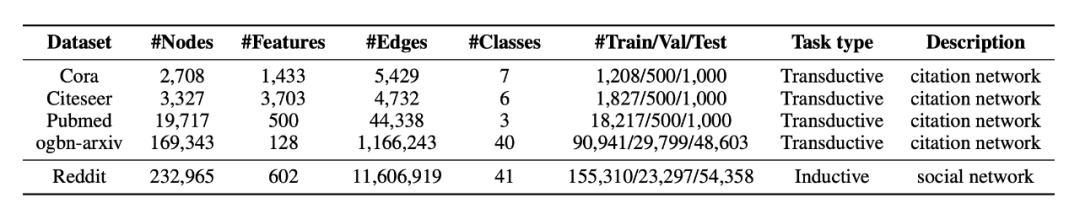

4.1 数据集与baseline

数据集使用了 3 个论文引用数据集:Cora、Citseer 和 PubMed。一个社区数据集 Reddit。一个 OGB 公开数据集 ogbn-arxiv,具体细节信息如表格所示。而对比的 baseline 里我们选择了 GRAIN [4] 和 ALG [5] 等最新的在图上做主动学习的方法。

▲ 表1. 数据集详细信息

4.2 端到端实验结果

我们将选点的预算设置为节点类目数量的二十倍,所得的结果如下,可以看出 IGP 显著优于其他方法。

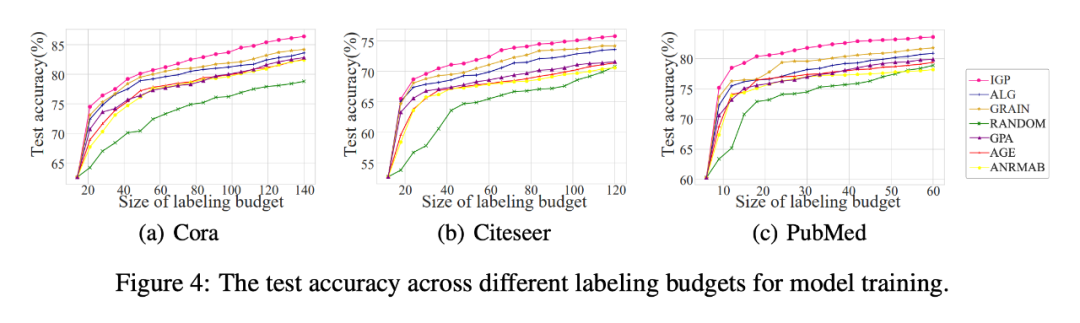

4.3 选点预算实验结果

我们测试了所有方法随着选点预算增加时的准确率,结果如图,证明 IGP 方法在任何选点预算下都优于其他方法。

▲ 图7. 选点预算实验结果

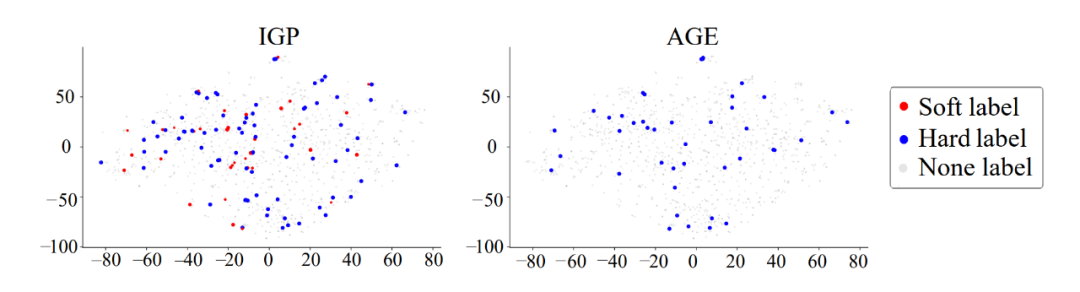

4.4 可解释性实验

▲ 图8. 可解释性实验结果

该论文提出了 IGP 方法,这是第一个考虑软标签情况下基于图神经网络的主动学习方法,具体来说,IGP 结合领域专家和图神经网络模型,在有限预算的情况下详尽地标记节点。IGP 允许使用轻松的查询,即领域专家(oracle)只判断预测标签的正确性而不是准确的分类,并且通过最大化信息增益传播来进行选点。对与真实世界数据集的实证研究表明,IGP 方法在很大程度上优于其他方法,尤其是在类数量很大的专家领域情况下。

参考文献

[1] Thomas N. Kipf and Max Welling. Semi-supervised classification with graph convolutional networks. In 5th International Conference on Learning Representations, ICLR 2017, Toulon, France, April 24-26, 2017, Conference Track Proceedings, 2017b.

[2] Kaveh Hassani and Amir Hosein Khasahmadi. Contrastive multi-view representation learning on graphs. In International Conference on Machine Learning, pp. 4116–4126. PMLR, 2020.

[3] Robert Burbidge, Jem J Rowland, and Ross D King. Active learning for regression based on query by committee. In International conference on intelligent data engineering and automated learning, pp. 209–218. Springer, 2007.

[4] Wentao Zhang, Zhi Yang, Yexin Wang, Yu Shen, Yang Li, Liang Wang, and Bin Cui. Grain: Improving data efficiency of graph neural networks via diversified influence maximization. Proc. VLDB Endow., 14(11):2473–2482, 2021b.

[5] Wentao Zhang, Yu Shen, Yang Li, Lei Chen, Zhi Yang, and Bin Cui. ALG: fast and accurate active learning framework for graph convolutional networks. In SIGMOD ’21: International Conference on Management of Data, Virtual Event, China, June 20-25, 2021, pp. 2366–2374, 2021a.

更多阅读

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧