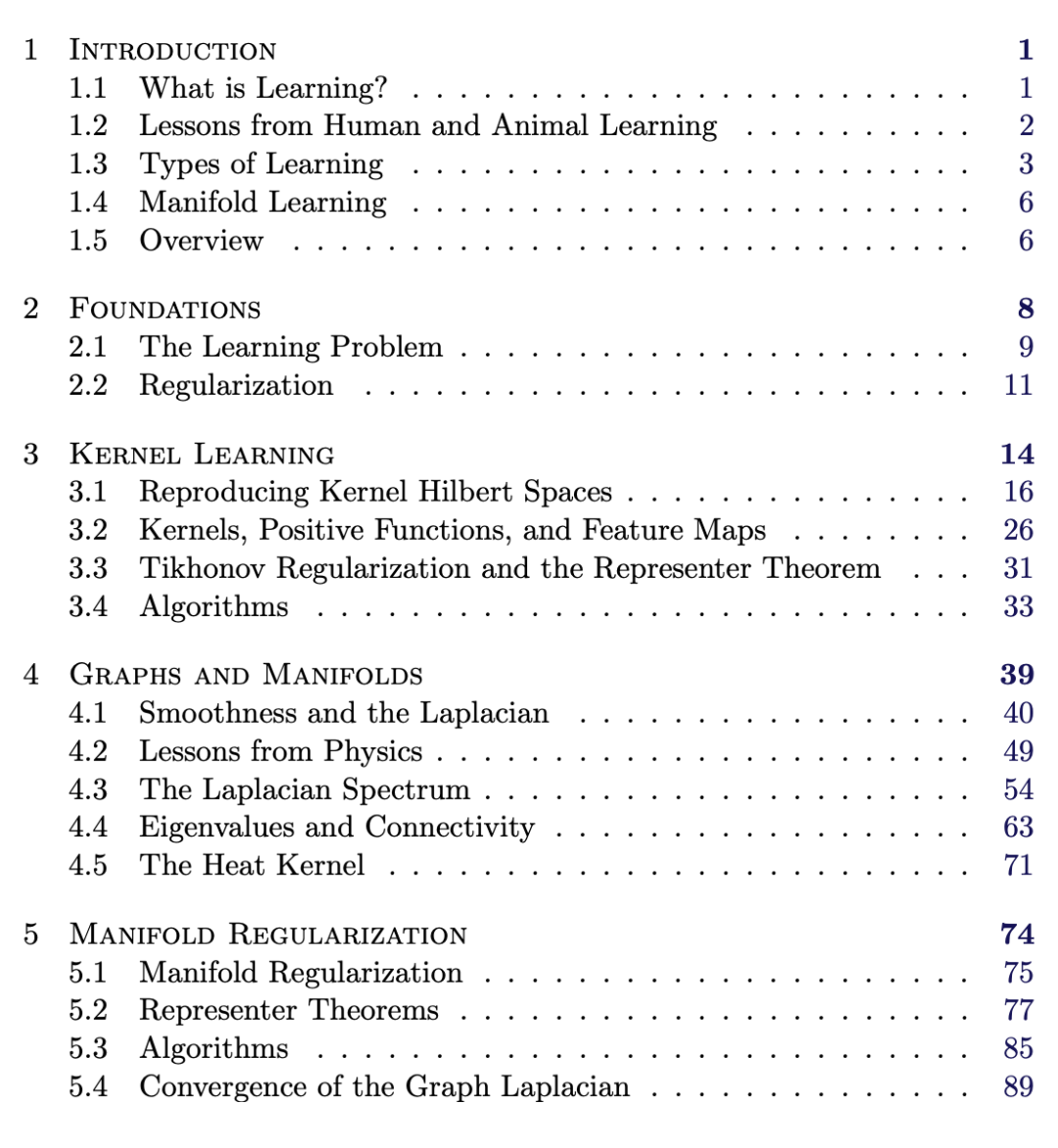

124页《流行学习数学基础》,哈佛数学系本科论文

转载机器之心

近日,哈佛大学数学系毕业生、现牛津大学博士 Luke Melas-Kyriazi 发布其本科毕业论文,结合统计学习、谱图理论和微分几何三个数学领域介绍流形学习。

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“ML124” 可以获取《124页哈佛数学系本科论文,带你了解流形学习的数学基础》专知下载链接索引

登录查看更多

相关内容

Arxiv

5+阅读 · 2018年8月6日