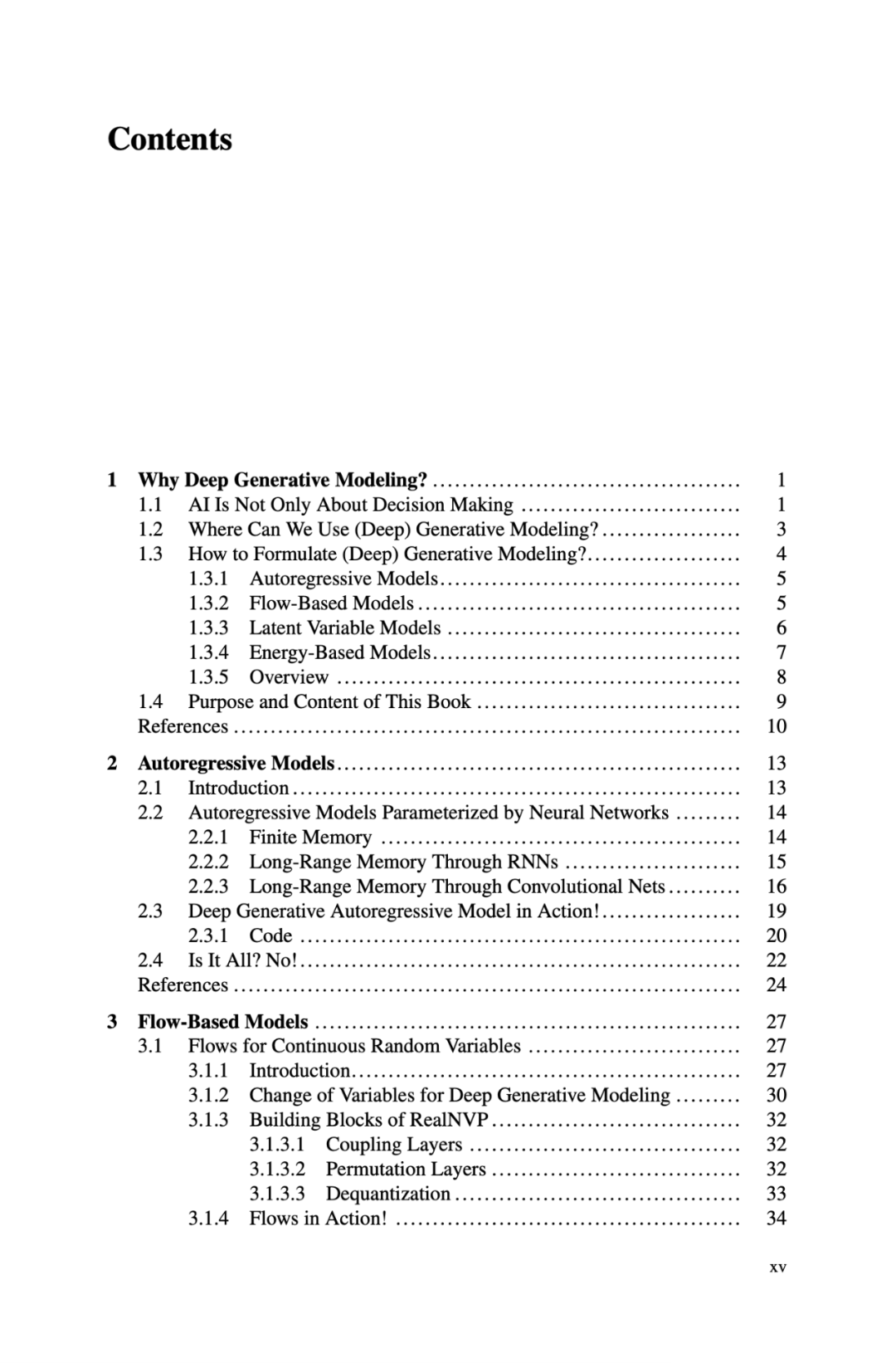

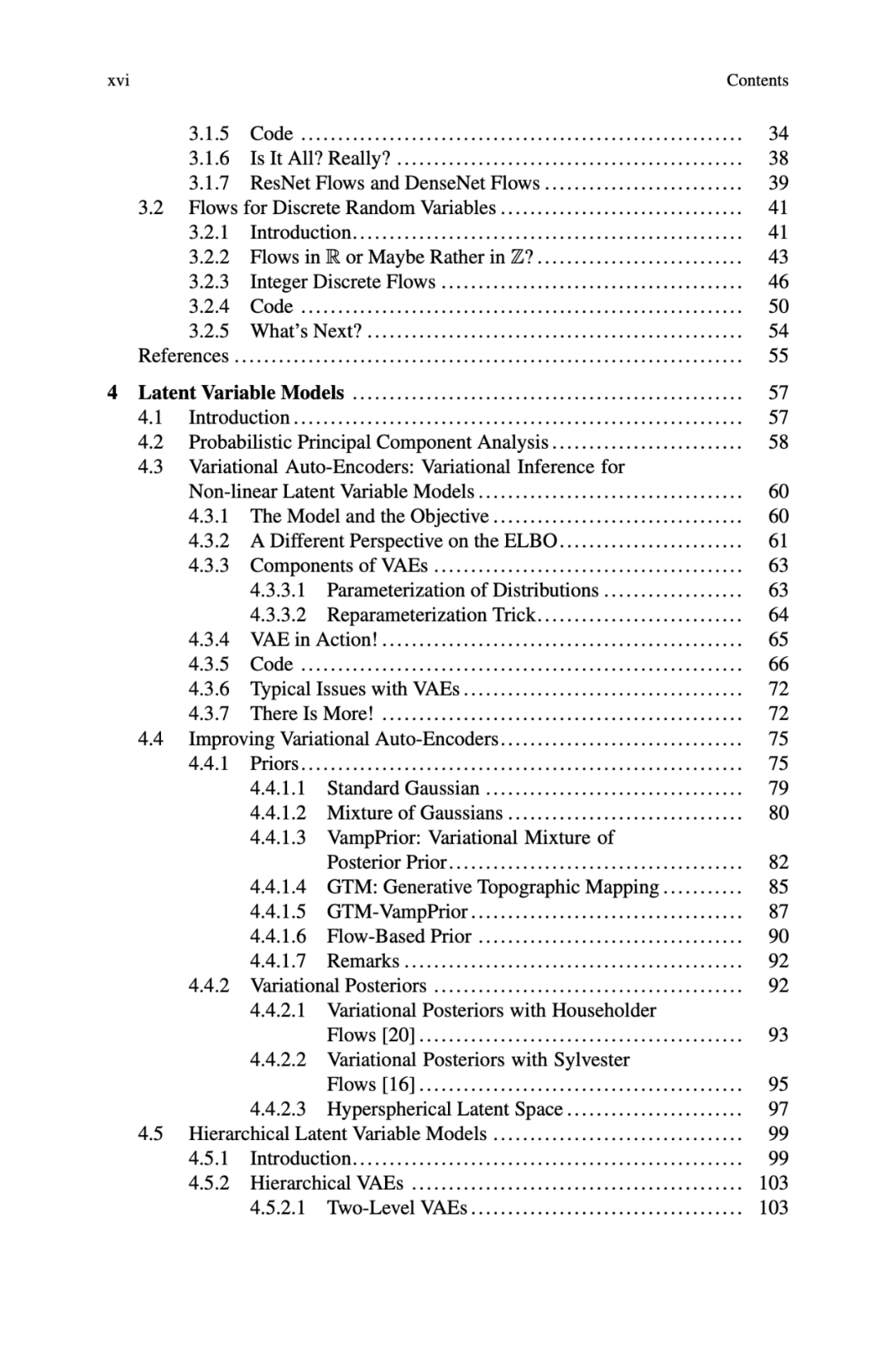

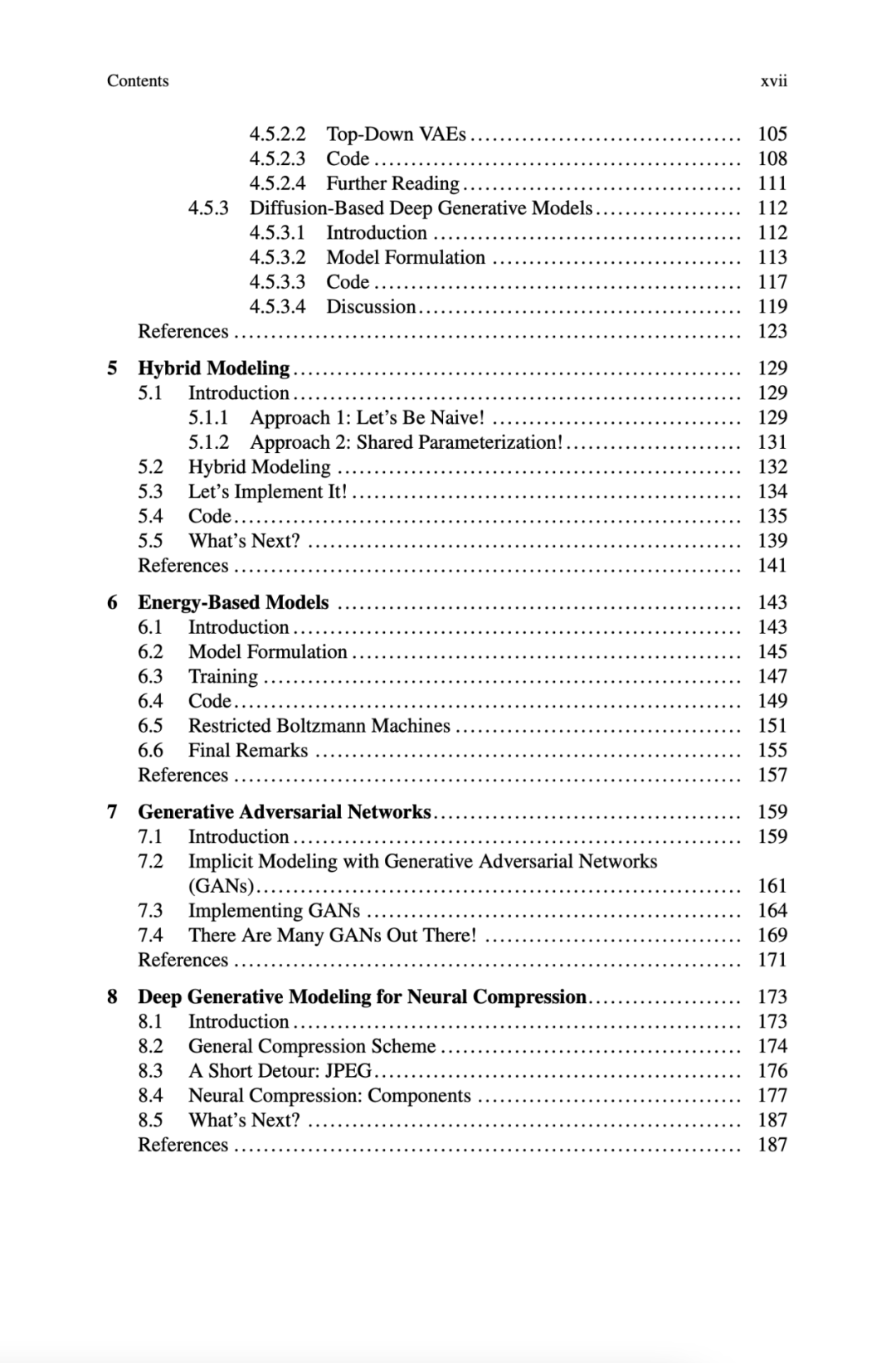

2022新书《深度生成模型》出版,前高通AI研究员Jakub Tomczak力作,Max Welling作序,200+pdf

这本书的代码已经全部开放,读者可以边看边实践,学会实现「深度生成模型」。

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“DGM200” 就可以获取《Max Welling作序,前高通AI研究员Jakub Tomczak2022新书《深度生成模型》出版,200+pdf》专知下载链接

登录查看更多

相关内容

专知会员服务

61+阅读 · 2022年3月11日

Arxiv

0+阅读 · 2022年4月16日