最近,图注意力网络一作 Petar Veličković 在母校剑桥大学做了一场讲座,介绍图神经网络的理论基础。

图神经网络(GNN)是机器学习中最热门的研究方向之一,在提出后的十几年里被不断扩展,先后发展出了图卷积网络、 图注意力网络、图自编码器、图生成网络和图时空网络等多个子领域。

最近,图注意力网络的第一作者 Petar Veličković 回到母校剑桥大学计算机实验室做了一场主题为《图神经网络理论基础》的讲座。在演讲中,Petar 尝试从基本原理推导 GNN,介绍其在多个学科中的应用,并解释 GNN 如何在多个研究路线中并行出现。

![]()

讲座幻灯片地址:https://petar-v.com/talks/GNN-Wednesday.pdf

Petar 表示,这个演讲「浓缩」了他 4 年 GNN 研究的精华,「这些年我用多种方式讲授 GNN,现在我终于找到了最『自然』的讲解方式。」他表示,这个 70 分钟的讲座既可以帮助初学者,也可以为 GNN 实践者提供新的角度。

Petar Veličković:我找到了最「自然」的 GNN 讲解方式

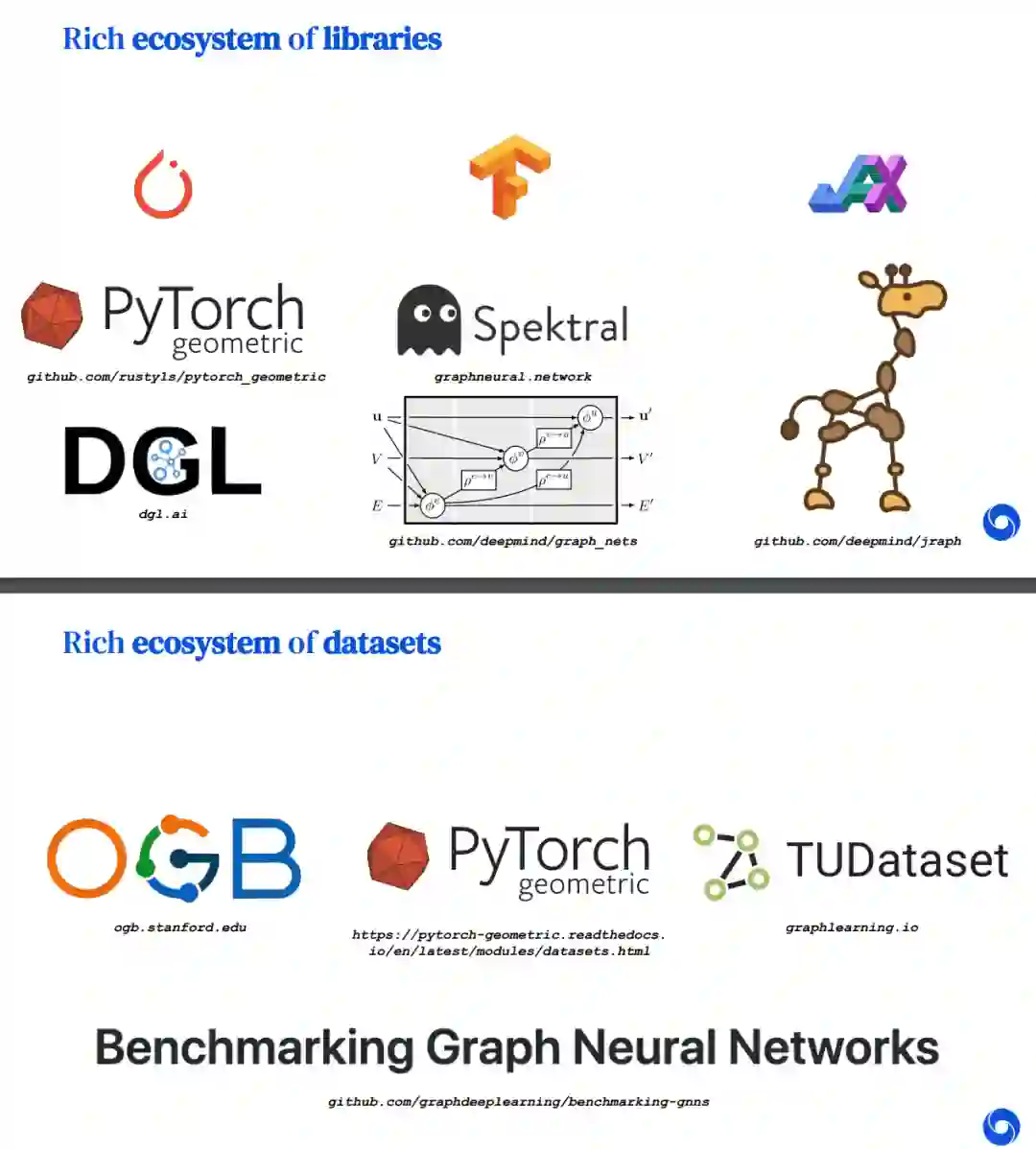

Petar 首先介绍了现实世界中的图、图神经网络的实际应用,以及 GNN 的相关库和数据集等。

![]()

![]()

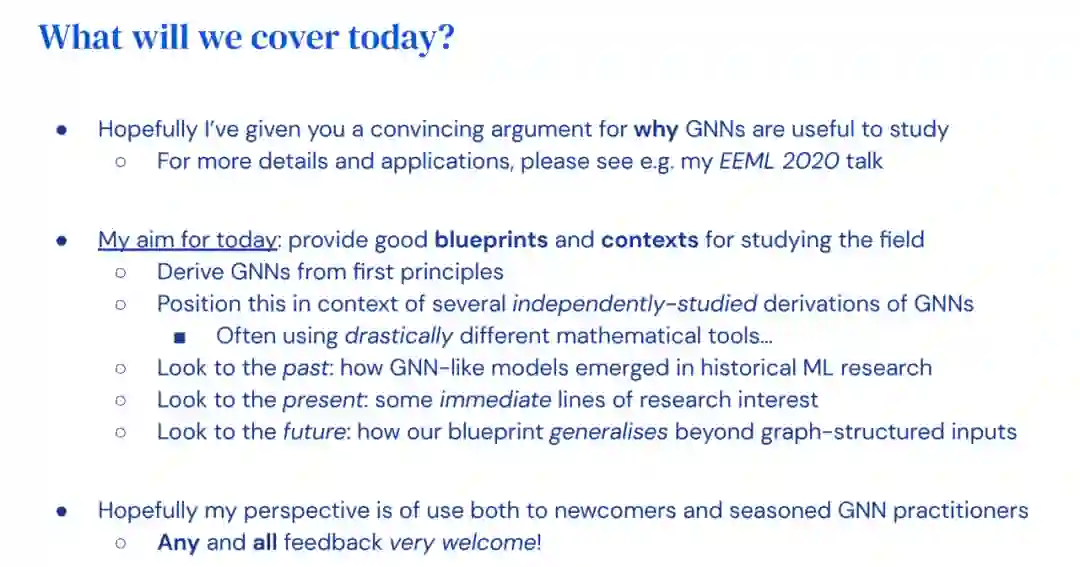

Petar 表示,该讲座的内容基于其关于几何深度学习的研究、麦吉尔大学助理教授 William Hamilton 的著作《图表示学习》,以及 Yoshua Bengio、Marco Gori、Jürgen Schmidhuber 等多位研究者的工作。

![]()

Petar 首先从基本原理定义 GNN,然后介绍了对 GNN 处理图数据有用的特性,并列举了一些示例。

![]()

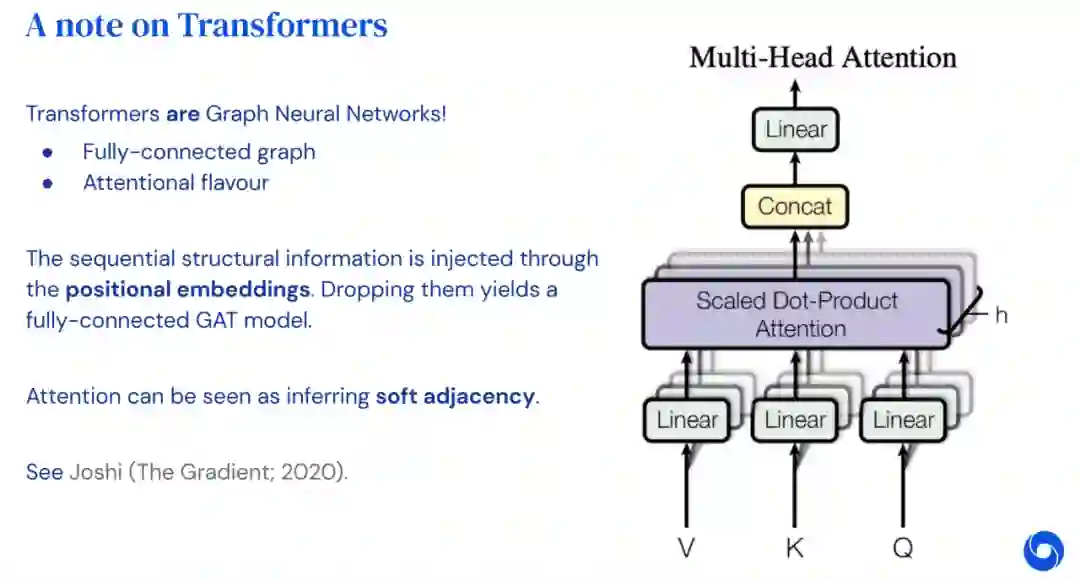

Petar 介绍了 GNN 的发展过程与研究蓝图,及其在多个研究领域中的并行出现。例如,自然语言处理与 GNN。

![]()

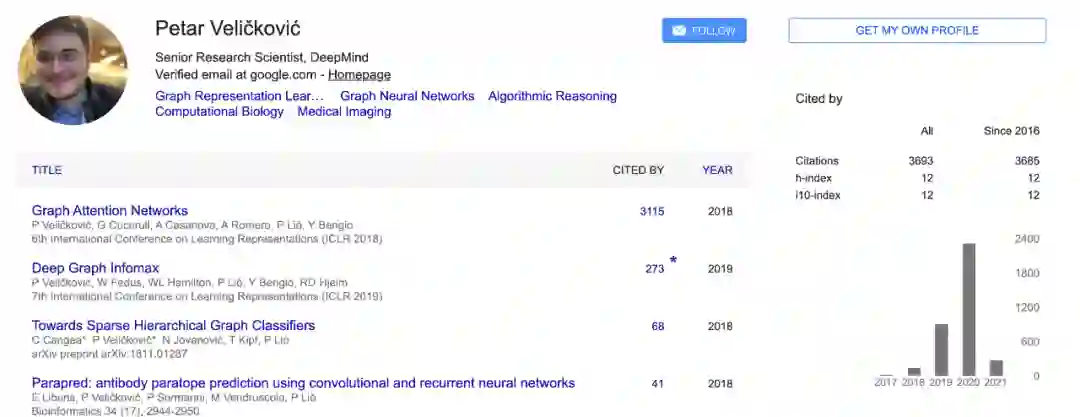

Petar Veličković现为 DeepMind 高级研究科学家。他于 2019 年从剑桥大学获得计算机科学博士学位,导师为 Pietro Liò。他的研究方向包括:设计在复杂结构数据上运行的神经网络架构(如图网络),及其在算法推理和计算生物学方面的应用。

Petar Veličković是图注意力网络的一作,他和 Guillem Cucurull、Yoshua Bengio 等人一起完成了图注意力网络的开山之作——《Graph Attention Networks》,这篇论文被 ICLR 2018 接收,目前被引量超过 3000。

![]()

除了图注意力网络,他还是《Deep Graph Infomax》的一作。在这篇论文中,他和 William Fedus、Yoshua Bengio 等人提出了以无监督方式学习图结构数据中节点表示的通用方法,该论文被 ICLR 2019 接收。

去年,机器之心曾报道过他的博士论文,Petar 用 147 页篇幅详述了「结构在神经网络中的复兴」,涵盖他之前的研究工作和其他关于 GNN 的内容。而今天介绍的这个讲座更是融合了他「近 4 年 GNN 研究的精华」,对图神经网络领域感兴趣的读者可以一看。

个人主页地址:https://petar-v.com/

建新·见智 —— 2021亚马逊云科技 AI 在线大会

4月22日 14:00 - 18:00

大会包括主题演讲和六大分会场。内容涵盖亚马逊机器学习实践揭秘、人工智能赋能企业数字化转型、大规模机器学习实现之道、AI 服务助力互联网快速创新、开源开放与前沿趋势、合作共赢的智能生态等诸多话题。

亚马逊云科技技术专家以及各个行业合作伙伴将现身说法,讲解 AI/ML 在实现组织高效运行过程中的巨大作用。每个热爱技术创新的 AI/ML 的爱好者及实践者都不容错过。

识别二维码或点击阅读原文,免费报名看直播。

![]()

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:content@jiqizhixin.com