Prompt——2022年发表NLP论文万能金钥匙!

要说NLP领域这一两年的热词,除了“Transformer”、“预训练”,“Prompt”绝对是不得不提的一个。学习NLP,就不能忽略Prompt。

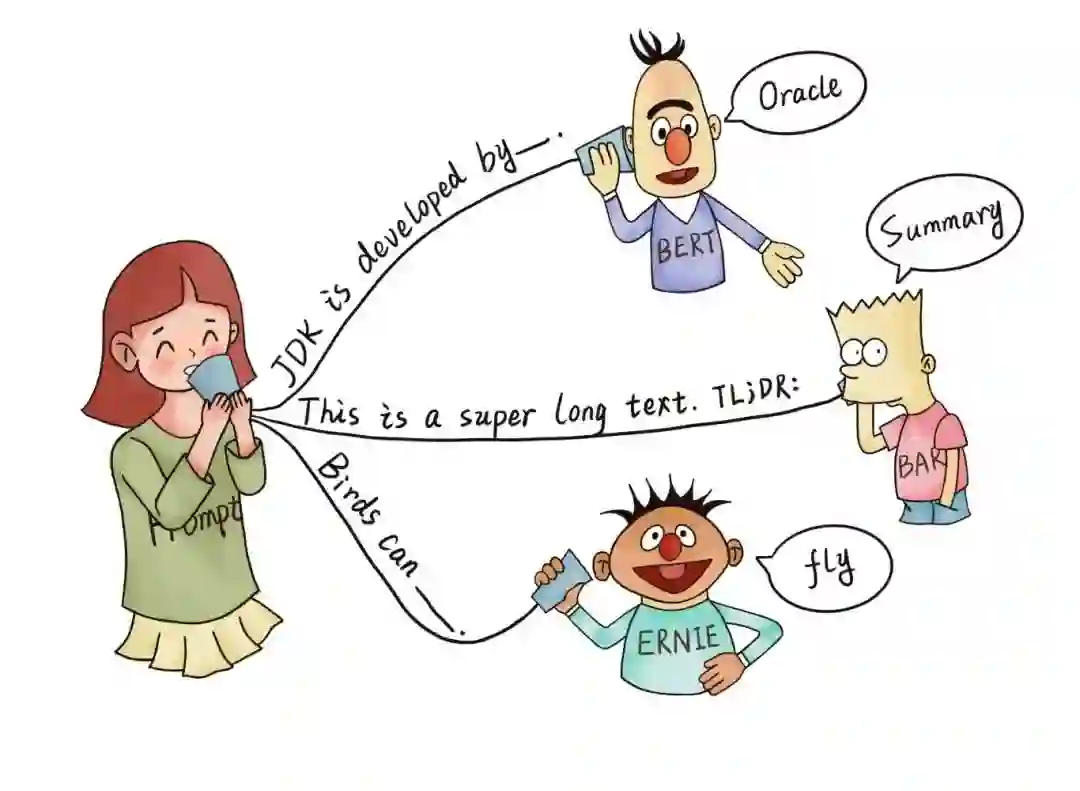

图片来源:《Pre-train, Prompt, and Predict: A Systematic Survey of Prompting Methods in Natural Language Processing》

Prompt是近几年开始火热的新方法,被称作自然语言处理第四代范式。

P1. 非神经网络时代的完全监督学习(Fully Supervised Learning, Non-Neural Network)

P2. 基于神经网络的完全监督学习 (Fully Supervised Learning, Neural Network)

P3. 预训练,精调范式 (Pre-train, Fine-tune)

P4. 预训练,提示,预测范式(Pre-train, Prompt, Predict)

prompt是研究者们为下游任务设计的一种模板或者范式,这种范式能够帮助预训练模型“回忆“起自己在预训练中“学到“的知识。融入了Prompt的新模式大致可以归纳成”pre-train, prompt, and predict“,在该模式中,下游任务被重新调整成类似预训练任务的形式。比如说MLM。

对于输入文本 ,经过函数 得到

该函数首先会使用一个模板,通常为自然语言(就是一句通顺的话),因为预训练模型训练数据都是基于自然语言的,该模板一般包含两个空位置:用于填输入 的位置 和用于生成答案文本的 位置 。

9月7、8日老师现场运行、讲解前沿论文代码

扫码即刻预约前沿论文带读

(一起get 2022最好发NLP论文的方向)

举个🌰

假设输入是:x = " I love this movie."

使用的模板是" [X] Overall, it was a [Z] movie."

那么通过范式得到的 就是 "I love this movie. Overall it was a [Z] movie."

有质疑精神的同学会问:加个模板、改变下学习形式有什么厉害的呢?

prompt之所以之所以被捧上神坛,可不是花拳绣腿的表面工夫。原来的 预训练+微调 方法,在预训练阶段和下游任务中一般相对独立,不能很好适配。而Prompt,首先它使用了预训练方法,继承了预训练的优点,同时它加了提示信息,这些提示信息可以让下游任务做一些改进来适配预训练,这样下游任务就会更适合已经预训练的模型。“Fine-tuning中是预训练语言模型迁就各种下游任务,而Prompt中是各种下游任务迁就预训练语言模型。”

9月7、8日老师现场运行、讲解前沿论文代码

扫码即刻预约前沿论文带读

(一起get 2022最好发NLP论文的方向)

Prompt作为近几年十分火热的一个方法或者说研究方向,其核心原理简单,理论较为直观,可迁移性较强,可以应用的领域非常广泛,例如面向医疗、法律以及金融文本的各类任务,它适用于情感分析、信息抽取、序列标注、问答、文本摘要、文本翻译等多种任务,是2021年后发表NLP论文的万能金钥匙,也是各大主流NLP比赛中的上分利器。

9月7、8日,沃恩智慧论文带读公开课,Kimi老师将带读关于prompt的NLP前沿论文。

带大家了解 prompt 的前世今生,现场运行论文代码,让大家能够从0复现 一个prompt 方法。为自己后续的任务奠定基础!

小编表示已经按耐不住了!想发论文最好的方法之一就是紧跟风口,作为当前NLP的热门,而又亲切不高冷易掌握的prompt,谁不心动,谁不想赶紧拿来用?

9月7、8日老师现场运行、讲解前沿论文代码

扫码即刻预约前沿论文带读

(一起get 2022最好发NLP论文的方向)