近期必读的五篇AAAI 2021【序列推荐(SR)】相关论文和代码

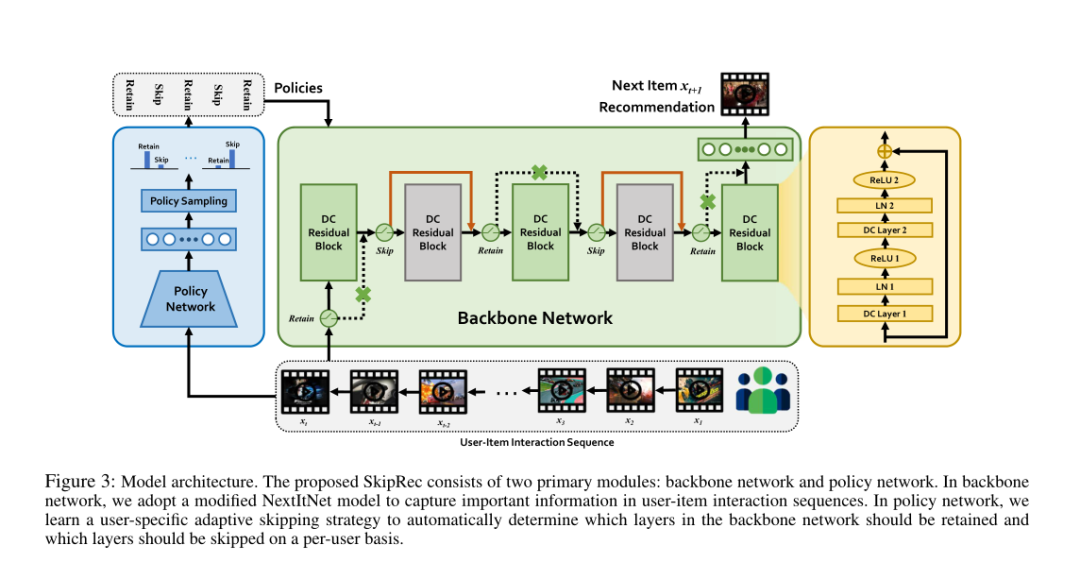

1. A User-Adaptive Layer Selection Framework for Very Deep Sequential Recommender Models

作者:Lei Chen, Fajie Yuan, Jiaxi Yang, Xiang Ao, Chengming Li, Min Yang

摘要:序列推荐系统(SRS)已成为最近的研究热点。由于需要吸引用户的动态兴趣,因此与标准协同过滤方法相比,基于序列神经网络的推荐器模型通常需要堆叠更多的隐藏层(例如,最多100层)。但是,将非常深的推荐模型部署到生产环境中时,高网络延迟已成为主要障碍。在本文中,我们认为,在推理阶段将所有用户均等对待的经典预测框架在运行时间上效率低下,并且准确性不够理想。为了解决这个问题,我们提出了SkipRec,这是一种自适应推理框架,通过学习在每个用户基础(per-user basis)上跳过不活跃的隐藏层。具体来说,我们设计了一个策略网络来自动确定应保留哪些层以及允许跳过哪些层,从而实现特定于用户的决策。为得出最佳的跳过策略,我们建议使用gumbel softmax和强化学习来解决反向传播期间的不可微问题。我们在三个真实世界的推荐数据集上进行了广泛的实验,并证明SkipRec可以在相当短的推理时间内获得可比或更高的准确性。

网址:

http://34.94.61.102/paper_AAAI-3389.html

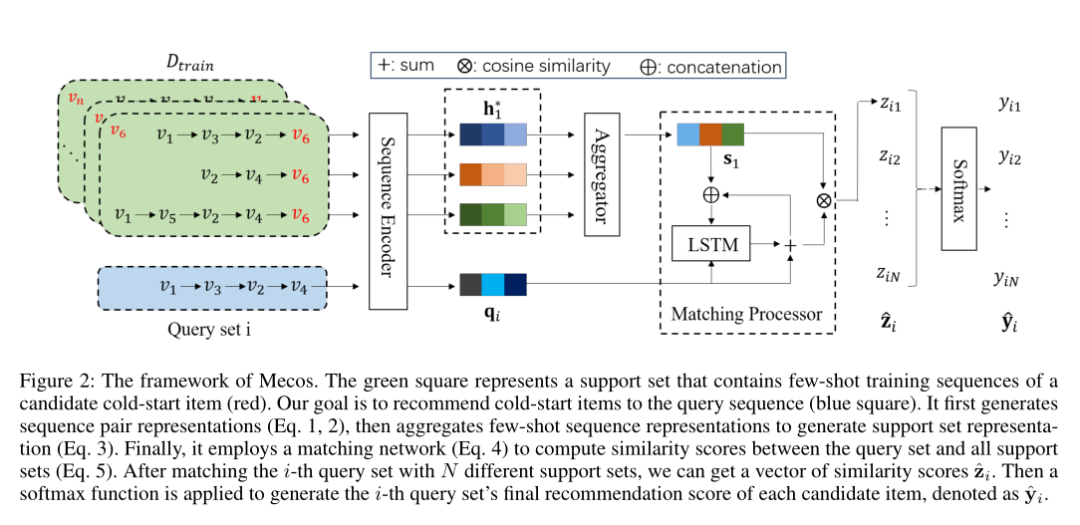

2. Cold-start Sequential Recommendation via Meta Learner

作者:Yujia Zheng, Siyi Liu, Zekun Li, Shu Wu

摘要:本文探索了序列推荐的元学习,以缓解项目的冷启动问题。序列推荐旨在根据历史行为序列来捕获用户的动态偏好,并充当大多数在线推荐方案的关键组成部分。但是,大多数以前的方法都很难推荐冷启动商品。由于在序列推荐任务的设置中通常没有辅助信息,因此当仅用户-商品交互可用时,无法应用先前的冷启动方法。因此,我们提出了一种基于元学习的冷启动序列推荐框架Mecos,以缓解序列推荐中的商品冷启动问题。这项任务并非易事,因为它的目标是在新颖而富挑战性的背景下解决一个重要问题。Mecos有效地从有限的交互中提取用户的偏好,并学习将目标冷启动商品与潜在用户进行匹配。此外,我们的框架可以与基于神经网络的模型轻松集成。在三个真实的数据集上进行的广泛实验证明了Mecos的优越性,与最先进的基准方法相比,HR @ 10的平均提升高达99%,91%和70%。

网址:

https://www.zhuanzhi.ai/paper/9e994364361a8060ccdd8be25b4398fd

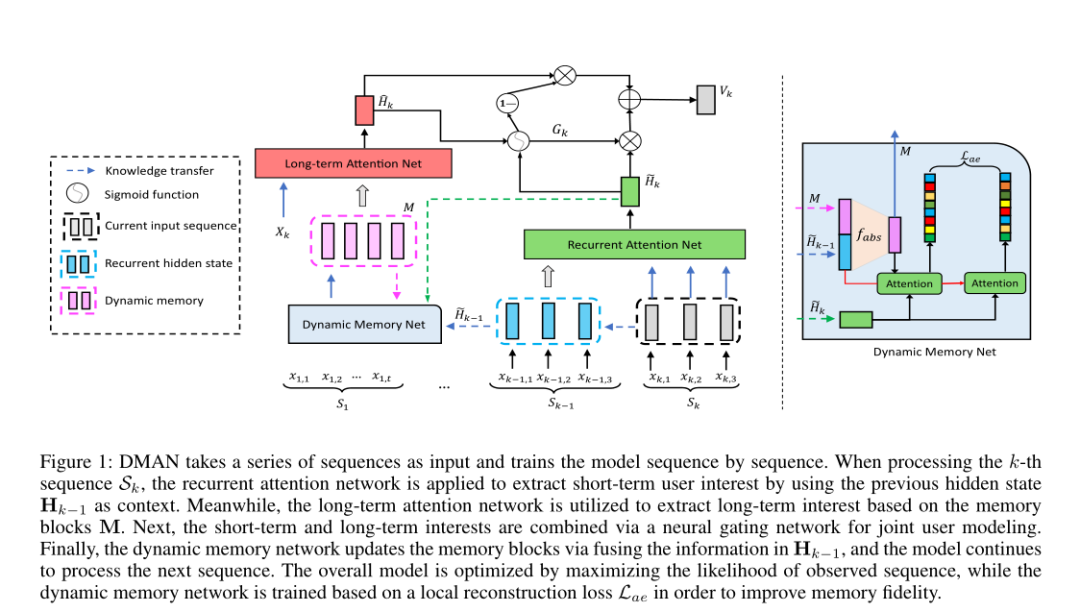

3. Dynamic Memory Based Attention Network for Sequential Recommendation

作者:Qiaoyu Tan, Jianwei Zhang, Ninghao Liu, Xiao Huang, Hongxia Yang, Jingren Zhou, Xia Hu

摘要:在各种在线服务中,序列推荐已变得越来越重要。它旨在根据用户的历史交互来建模其动态偏好,并预测其下一个商品。实际系统上累积的用户行为记录可能会很长,这些丰富的数据带来了跟踪用户实际兴趣的机会。先前的工作主要集中在根据相对近期的行为上提出建议。但是,可能无法有效地利用总体序列数据,因为早期交互可能会影响用户当前的选择。此外,由于实际系统需要较短的响应时间,因此无法承担在为每个用户执行推理时扫描整个行为序列。为了弥合差距,我们提出了一种新颖的长序列推荐模型,称为基于动态记忆的注意力网络(DMAN)。它将整个长期行为序列划分为一系列子序列,然后训练模型并维护一组记忆块(memory blocks),以维护用户的长期利益。为了提高记忆保真度,DMAN通过最大程度地减少辅助重建损失,将每个用户的长期兴趣动态地抽象到其自己的记忆块中。基于动态记忆,可以明确提取用户的短期和长期兴趣,并将其组合起来以进行有效的联合推荐。在四个基准数据集的实验结果表明,我们的模型在捕获与各种最新序列模型的长期依赖关系方面具有优势。

网址:

http://34.94.61.102/paper_AAAI-7500.html

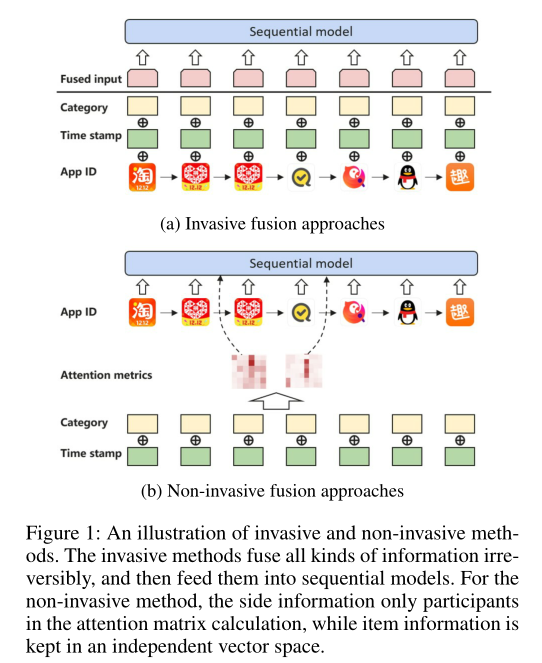

4. Non-invasive Self-attention for Side Information Fusion in Sequential Recommendation

作者:Chang Liu, Xiaoguang Li, Guohao Cai, Zhenhua Dong, Lifeng Shang, Hong Zhu

摘要:序列推荐系统旨在根据用户的历史行为来模拟他们不断发展的兴趣,从而制定与时间相关的自定义推荐。与传统模型相比,CNN和RNN等深度学习方法在推荐任务方面取得了显著进步。最近,由于BERT框架在处理序列数据中的自注意力机制,其也成为一种有前途的方法。但是,原始BERT框架的局限性在于它仅考虑自然语言 tokens的一种输入来源。在BERT框架下利用各种类型的信息仍然是一个悬而未决的问题。尽管如此,从直觉上讲,利用其他辅助信息(例如商品类别或标签)来获得更全面的描述和更好的建议。在我们的试验性实验中,我们发现了一些简单的方法,它们直接将各种辅助信息融合到商品嵌入中,通常带来的影响很小甚至是负面的。因此,在本文中,我们提出了NOninVasive自注意力机制(NOV A),以在BERT框架下有效利用辅助信息。NOVA利用辅助信息来产生更好的注意力分布,而不是直接更改商品嵌入,可能导致信息的不堪重负。我们在公共和商业数据集上都验证了NOVA-BERT模型,并且我们的方法可以以可忽略的计算开销稳定地胜过最新模型。

网址:

http://34.94.61.102/paper_AAAI-5262.html

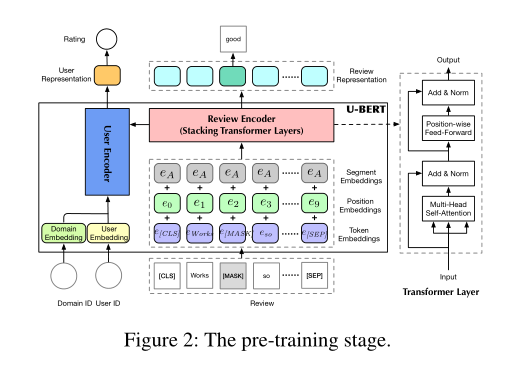

5. U-BERT: Pre-training User Representations for Improved Recommendation

作者:Zhaopeng Qiu, Xian Wu, Jingyue Gao, Wei Fan

摘要:学习用户表示对于推荐系统来说是一项关键任务,因为它可以对个性化服务的用户偏好进行编码。通常从行为数据(例如单击交互和评论)中学习用户表示。但是,对于不太流行的领域,行为数据不足以学习精确的用户表示。为了解决这个问题,自然的想法是利用内容丰富的领域来补充用户表示。受到BERT在NLP中的最新成功的启发,我们提出了一种新颖的基于预训练和微调的方法U-BERT。与典型的BERT应用程序不同,U-BERT是为推荐而定制的,并在预训练和微调中使用了不同的框架。在预训练中,U-BERT专注于内容丰富的领域,并引入了用户编码器和评论编码器来对用户的行为进行建模。提出了两种预训练策略来学习一般的用户表示形式。在微调中,U-BERT专注于目标内容不足的领域。除了从预训练阶段继承的用户和评论编码器之外,U-BERT还引入了项目编码器来对项目表示进行建模。此外,提出了一个评论匹配层,以捕获用户和商品评论之间的更多语义交互。最后,U-BERT结合了用户表示,项目表示和审阅交互信息以提高推荐性能。在来自不同领域的六个基准数据集的实验证明了U-BERT的最新性能。

网址:

http://34.94.61.102/paper_AAAI-2116.html

请关注专知公众号(点击上方蓝色专知关注)

后台回复“AAAI2021SR” 就可以获取《5篇顶会AAAI 2021 序列推荐(Sequential Recommendation,SR)相关论文》的PDF下载链接~