【导读】人工智能顶级会议AAAI2021接收结果已经公布,本次AAAI 2021一共收到9034篇论文提交,其中有效审稿的只有7911篇,最终录取的数量为1692篇,接收率为21.4%,相比去年的20.6%高0.8%,竞争越来越激烈。近期,所有paper list 放出,小编发现基于视频理解(Video Understanding)相关的接受paper很多,视频理解,比如视频分割、视频分类以及视频描述生成等等一些列前沿的方法和应用受到了很多人的关注。

为此,这期小编为大家奉上AAAI 2021必读的六篇视频理解相关论文——视频实例分割、无监督视频目标分割、粗到细视频描述生成、时空图神经网络视频目标分割、视频情感分析

AAAI 2021 Accepted Papers : https://aaai.org/Conferences/AAAI-21/wp-content/uploads/2020/12/AAAI-21_Accepted-Paper-List.Main_.Technical.Track_.pdf

AAAI2021CI、AAAI2021CL、ICLR2020CI、ICML2020CI

1. CompFeat: Comprehensive Feature Aggregation for Video Instance Segmentatio

作者:Yang Fu, Linjie Yang, Ding Liu, Thomas S. Huang, Humphrey Shi

摘要:视频实例分割是一项复杂的任务,我们需要针对任何给定视频对每个目标进行检测,分割和跟踪。先前的方法仅将单帧特征用于目标的检测,分割和跟踪,并且当遇到诸如运动模糊和剧烈的外观变化之类情形,它们在视频场景中会遭受损失。为了消除仅通过使用单帧特征引入的歧义,我们提出了一种新颖的综合特征聚合方法(comprehensive feature aggregation, CompFeat),以利用时间和空间上下文信息在帧级和目标级完善特征。我们使用新的注意力机制精心设计了聚合过程,该机制会显着提高学习特征的判别力。通过合并特征相似性和空间相似性,我们通过siamese设计进一步提高了模型的跟踪能力。在YouTubeVIS数据集上进行的实验验证了我们提出的CompFeat的有效性。

图片 代码:

https://github.com/SHI-Labs/CompFeat-for-Video-Instance-Segmentation.

网址:

https://arxiv.org/abs/2012.03400

2. F2Net: Learning to Focus on the Foreground for Unsupervised Video Object Segmentation

作者:Daizong Liu, Dongdong Yu, Changhu Wang, Pan Zhou

摘要:尽管基于深度学习的方法在无监督的视频目标分割中取得了很大的进步,但是仍然不能很好地处理困难的场景(例如,视觉相似性,遮挡和外观变化)。为了缓解这些问题,我们提出了一种新颖的Focus on Foreground Network(F2Net),该框架深入研究了前景目标的帧间细节,从而有效地提高了分割性能。具体来说,我们提出的网络由三个主要部分组成:siamese编码器模块,中心指导外观扩散( Center Guiding Appearance Diffusion)模块和动态信息融合模块。首先,我们使用siamese编码器提取成对帧(参考帧和当前帧)的特征表示。然后,设计了中心指导外观扩散方式,以捕获帧间特征(参考帧与当前帧之间的密集对应关系),帧内特征(当前帧中的密集对应关系)以及当前帧的原始语义特征。具体来说,我们建立了一个中心预测分支来预测当前目标在当前帧中的中心位置,并在增强帧间和帧内特征提取之前利用中心点信息作为空间指导,因此特征表示相当集中在前景目标上。最后,我们提出了一种动态信息融合模块,可以通过上述三个不同级别的特征自动选择相对重要的特征。在DAVIS2016,Youtube-object和FBMS数据集上进行的大量实验表明,我们提出的F2Net可以实现最先进的性能,并且具有显着的改进。

图片 网址:

https://arxiv.org/abs/2012.02534

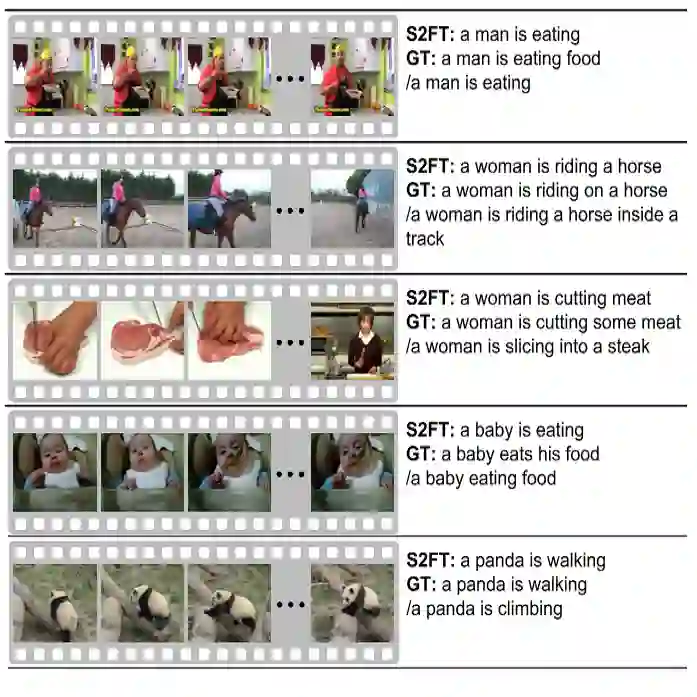

3. Non-Autoregressive Coarse-to-Fine Video Captioning

作者:Bang Yang, Yuexian Zou, Fenglin Liu, Can Zhang

摘要:目前在桥接视频(bridge videos)和自然语言方面取得了很不错的进展。然而,由于自动回归解码的顺序方式,主流视频字幕生成方法的推理速度较慢,并且由于对视觉单词(例如,名词和动词)的训练不足和解码范式不足,更倾向于生成一般描述。在本文中,我们提出了一种基于非自回归解码的模型,该模型具有从粗到精的字幕处理程序,可以缓解这些缺陷。在实现中,我们采用基于双向自注意力的网络作为我们的语言模型,以实现推理速度的提高,在此基础上,我们将视频描述生成过程分解为两个阶段,其中模型具有不同的聚焦点。具体而言,鉴于视觉单词决定字幕的语义正确性,我们设计了一种生成视觉单词的机制,不仅可以促进与场景相关的单词的训练,而且可以从视频中捕获相关细节以构建粗粒度的句子“模板”。此后,我们设计了专用的解码算法,该算法用合适的词填充“模板”,并通过迭代细化修改不适当的措词以获得细粒度的描述。在两个主流视频字幕基准(即MSVD和MSR-VTT)上进行的大量实验表明,我们的方法可实现最先进的性能,生成多种描述并获得较高的推理效率。

图片 网址:

https://arxiv.org/abs/1911.12018

4. Spatiotemporal Graph Neural Network based Mask Reconstruction for Video Object Segmentation

作者:Daizong Liu, Shuangjie Xu, Xiao-Yang Liu, Zichuan Xu, Wei Wei, Pan Zhou

摘要:本文解决了在半监督环境中分割与类无关的目标的任务。尽管以前的基于检测的方法实现了相对较好的性能,但是这些方法通过贪婪策略提取了最佳proposal,这可能会丢失所选候选目标之外的局部patch的详细信息。在本文中,我们提出了一种新颖的时空图神经网络(STG-Net),以重建用于视频目标分割的更准确的掩码(masks),该掩码通过利用所有proposal来捕获局部上下文。在空间图中,我们将一帧的目标proposal作为节点对待,并使用用于掩码上下文聚合的边缘权重策略表示它们的相关性。为了从先前的帧中捕获时间信息,我们使用记忆网络通过检索时间图中的历史掩码来细化当前帧的掩码。局部补丁细节和时间关系的共同使用使我们能够更好地解决诸如目标遮挡和丢失之类的挑战。在没有在线学习和微调的情况下,我们的STG网络在四个大型基准(DAVIS,YouTube-VOS,SegTrackv2和YouTube-Objects)上实现了最先进的性能,证明了该方法的有效性。

网址:

https://arxiv.org/abs/2012.05499

5. Quantum Cognitively Motivated Decision Fusion for Video Sentiment Analysis

作者:Dimitris Gkoumas, Qiuchi Li, Shahram Dehdashti, Massimo Melucci, Yijun Yu, Dawei Song

摘要:视频情感分析作为一个决策过程,其本质是复杂的,涉及多种模态的决策和由此引起的认知偏差的融合。受量子认知(quantum cognition)最新进展的启发,我们表明一种模态的情感判断可能与另一种模态的判断不兼容,即顺序很重要,无法共同衡量它们以做出最终决定。因此,认知过程表现出经典概率理论无法捕捉到的“量子式”偏见。因此,我们提出了一种根本上新颖的,量子认知动机的融合策略,用于预测情感判断。特别地,我们在具有正算子值测度的复值希尔伯特空间上,将话语表述为正负情绪判断的量子叠加状态,将单模态分类器表述为互不相容的可观测量。在两个基准数据集上进行的实验表明,我们的模型明显优于各种现有决策级别和一系列最新的内容级别融合方法。结果还表明,不兼容的概念允许有效处理所有组合模态,包括所有单峰分类器错误预测的极端情况。

图片 网址: