注意力模型深度综述:注意力类型和网络架构都有什么

选自arXiv

作者:Sneha Chaudhari 等

机器之心编译

参与:王淑婷、杜伟

注意力模型已成为神经网络中的一种重要概念,并在很多应用领域展开了研究。本文提出了一种分类方法,对这些研究进行了全面有序地综述,并对注意力模型在一些应用领域产生的重大影响进行了讨论。

注意力背后的直觉可以用人类的生物系统来进行最好的解释。例如,我们的视觉处理系统往往会选择性地聚焦于图像的某些部分上,而忽略其它不相关的信息,从而有助于我们感知。类似地,在涉及语言、语音或视觉的一些问题中,输入的某些部分相比其它部分可能更相关。通过让模型仅动态地关注有助于有效执行手头任务的部分输入,注意力模型引入了这种相关性概念。

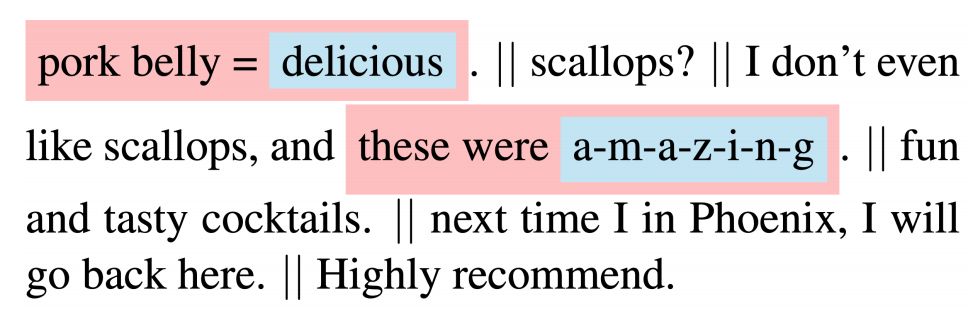

图 1 显示了使用注意力模型对 Yelp 评论进行情感分类的例子 [Yang et al., 2016]。在这个例子中,注意力模型知道了在五个句子中,第一句和第三句更相关。

图 1:用注意力建模对 Yelp 评论进行分类的例子。

此外,在这些句子中,单词 delicious 和 amazing 在决定评论的情感方面更有意义。

神经网络中建模注意力的快速发展主要源于三个方面。首先,这些模型对多个任务(如机器翻译、问答、情感分析、词性标注、句法解析和对话系统)来说是当前最佳的模型;其次,除了提高主要任务的性能,它们还有一些其它优势。它们还被广泛用于提高神经网络的可解释性,无法解释的神经网络被视为黑箱模型;第三,它们还有助于克服循环神经网络的一些挑战,如随着输入长度的增加而导致的性能下降,以及输入的序列处理所带来的计算效率低下。因此,本文旨在对注意力模型进行简短而又全面的综述。

论文:An Attentive Survey of Attention Models

论文地址:https://arxiv.org/abs/1904.02874

注意力模型已成为神经网络中的一种重要概念,并在各种应用领域进行了研究。本次综述全面有序地概述了建模注意力方面的发展。研究者特别提出了一种分类法,该方法将现有技术归并到连贯类别中。研究者对各种引入了注意力的神经架构进行了回顾,还展示了注意力如何提高神经模型的可解释性。最后,研究者讨论了建模注意力起到重大影响的一些应用。希望本次综述可以简明扼要地介绍注意力模型,为从业者提供指导,同时为其应用开发可行的方法。

注意力模型

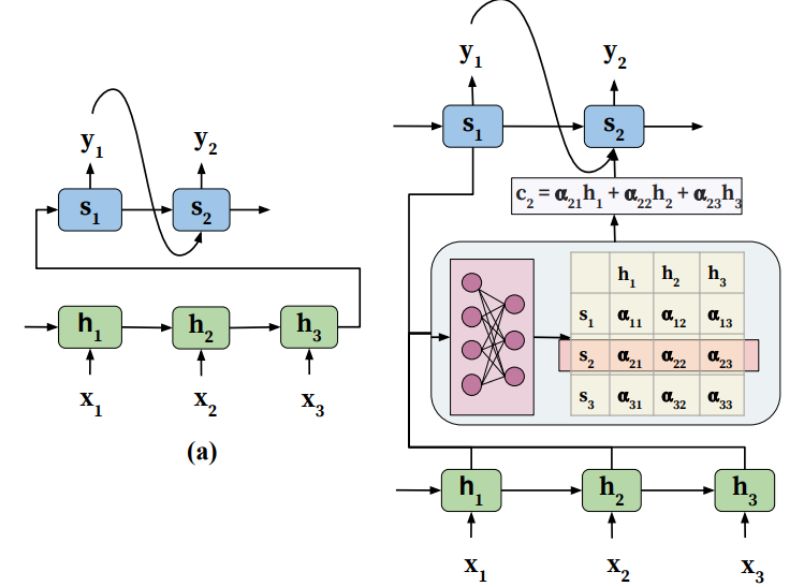

注意力模型意在通过让解码器访问完整的编码输入序列 {h_1, h_2, ..., h_T } 来减轻这些挑战。中心思想是在输入序列中引入注意力权重α,来对具有相关信息的位置集合进行优先级排序,以生成下一个输出 token。

图 2:编码器-解码器架构:(a) 为传统结构,(b) 为带注意力机制的结构。

具有注意力的相应编码器-解码器架构如图 2(b) 所示。架构中的注意力模块负责自动学习注意力权重α_ij,该权重会捕获 h_i(编码器隐状态,被称之为候选状态)和 s_j(解码器隐状态,被称之为查询状态)之间的相关性。这些注意力权重之后会被用于构建语境向量 c,而该向量被作为输入传递给解码器。

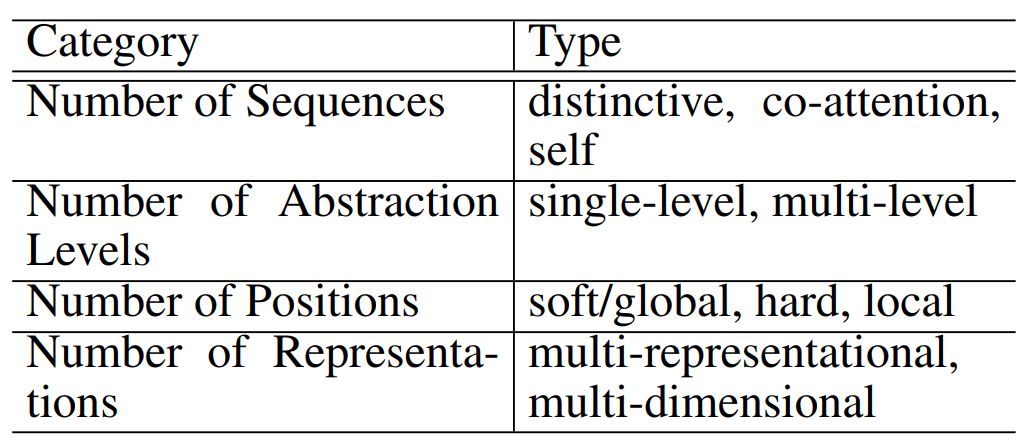

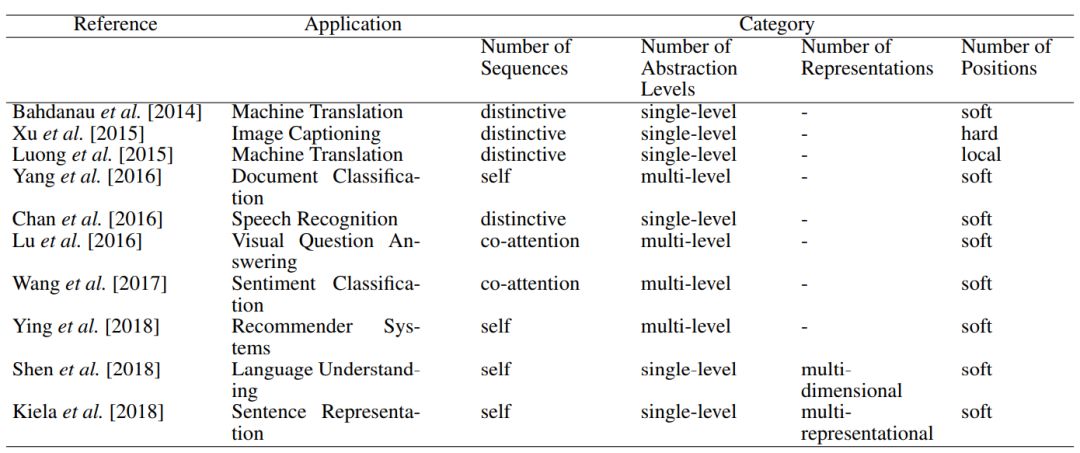

研究者将注意力分为四大类,并阐明了每一大类中不同类型的注意力,如下表所示(表 1)。

表 1:各大类别中的注意力类型。

为了理解这一概念,研究者提供了一系列重要的技术论文,并在表 2 中详细说明了本文方法所用到的多种注意力类型。

表 2:有关注意力模型技术方法的重要论文。『-』表示「不适用」。

注意力网络架构

在这一部分,研究者描述了与注意力相关的三种显著的神经架构:(1)编码器-解码器框架;(2)将注意力扩展至单个输入序列之外的记忆网络;(3)利用注意力规避循环模型序列处理组件的架构。

编码器-解码器

注意力最早用作基于 RNN 的编码器-解码器框架的一部分,以编码较长的输入语句。一个有趣的事实是,注意力模型可以接受任何输入表征,并将其减少为固定长度的单个语境向量,该向量可用于解码步骤。因此,研究者可以从输出中解耦输入表征。

记忆网络

像问答和聊天机器人这样的应用需要具备根据事实数据库中的信息进行学习的能力。端到端的记忆网络通过使用记忆模块阵列来存储事实数据库,并使用注意力来建模记忆中每个事实的相关性来回答问题,从而实现了这一点。

不带 RNN 的网络

Transformer 架构中,编码器和解码器由一堆相同的层组成,这些层则皆由两个子层组成:对应位置的前馈神经网络(FNN)层和多头自注意力层。Transformer 架构实现了重要的并行处理、更短的训练时间和更高的翻译准确率,而无需任何重复的组件。

用于可解释性的注意力

由于模型的性能以及透明性和公平性,人们对 AI 模型的可解释性产生了巨大的兴趣。从可解释性的角度来看,建模注意力尤其有趣,因为它让我们可以直接观察深度学习架构的内部工作机制。

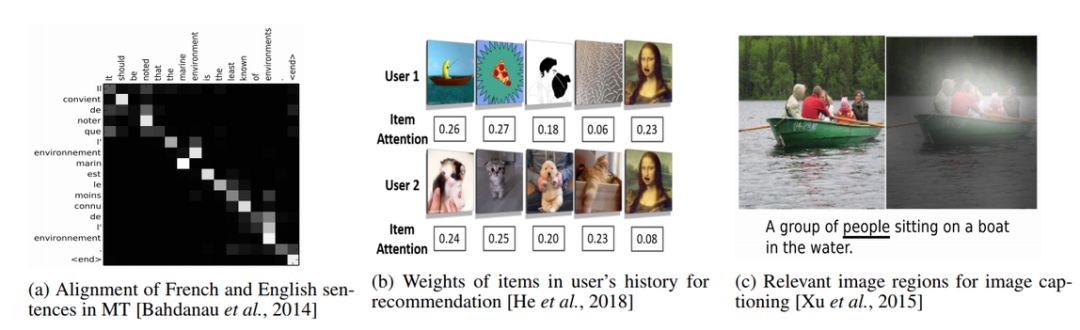

如图 4(a) 所示,Bahdanau 等人可视化了注意力权重,这些权重清楚地展示了法语和英语句子的自动对齐,尽管这两种语言中动词和名词的位置不同。

图 4:注意力权重的可视化例子。

图 4(b) 显示,注意力权重有助于识别用户的兴趣。用户 1 似乎偏好「卡通」视频,而用户 2 偏好关于「动物」的视频。

最后,Xu 等人提供了相关图像区域(即具有高注意力权重的区域)的大量可视化列表,这些区域对图像字幕任务(图 4(c))中生成的文本具有重大的影响。

虽然注意力机制有助于提高模型可解释性的这种观点比较普遍,但有研究者经过实验证明,标准的注意力模块在解释模型方面基本没什么用。

本文为机器之心编译,转载请联系本公众号获得授权。

✄------------------------------------------------

加入机器之心(全职记者 / 实习生):hr@jiqizhixin.com

投稿或寻求报道:content@jiqizhixin.com

广告 & 商务合作:bd@jiqizhixin.com