【泡泡一分钟】基于状态抽象的正则化强化学习

每天一分钟,带你读遍机器人顶级会议文章

标题:Regularizing Reinforcement Learning with State Abstraction

作者:Riad Akrour, Filipe Veiga, Jan Peters, Gerhard Neumann

来源:IROS 2018

编译:侯力玮

审核:颜青松 陈世浪

欢迎个人转发朋友圈;其他机构或自媒体如需转载,后台留言申请授权

摘要

离散化强化学习中的状态抽象可以将有类似最优动作的状态聚集起来,从而产生更容易求解的决策过程。本文将状态抽象的概念推广到连续动作强化学习中,将抽象状态定义为一个存在简单形状近似最优策略的状态簇。文中提出了一种分层强化学习算法,该算法可以同时发现每个聚类中的状态空间簇与最优子策略。该框架的主要优点是提供了一种可以控制学得策略的行为复杂性的方法来正则化强化学习。将算法应用在多个基准任务上,同时在机器人触觉操作任务上进行实验,结果表明,通过结合少量线性策略,能达到目前深度强化学习的最优效果。

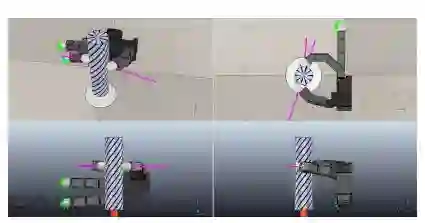

图1 上图是本文在V-REP中模拟的Allegro机械手,任务是尽可能使圆柱逆时针旋转。

Abstract

State abstraction in a discrete reinforcement learning setting clusters states sharing a similar optimal action to yield an easier to solve decision process. In this paper,we generalize the concept of state abstraction to continuous action reinforcement learning by defining an abstract state as a state cluster over which a near-optimal policy of simple shape exists. We propose a hierarchical reinforcement learning algorithm that is able to simultaneously find the state space clustering and the optimal sub-policies in each cluster. The main advantage of the proposed framework is to provide a straightforward way of regularizing reinforcement learning by controlling the behavioral complexity of the learned policy. We apply our algorithm on several benchmark tasks and a robot tactile manipulation task and show that we can match state-ofthe-art deep reinforcement learning performance by combining a small number of linear policies.

如果你对本文感兴趣,想要下载完整文章进行阅读,可以关注【泡泡机器人SLAM】公众号(paopaorobot_slam)。

欢迎来到泡泡论坛,这里有大牛为你解答关于SLAM的任何疑惑。

有想问的问题,或者想刷帖回答问题,泡泡论坛欢迎你!

泡泡网站:www.paopaorobot.org

泡泡论坛:http://paopaorobot.org/forums/

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com