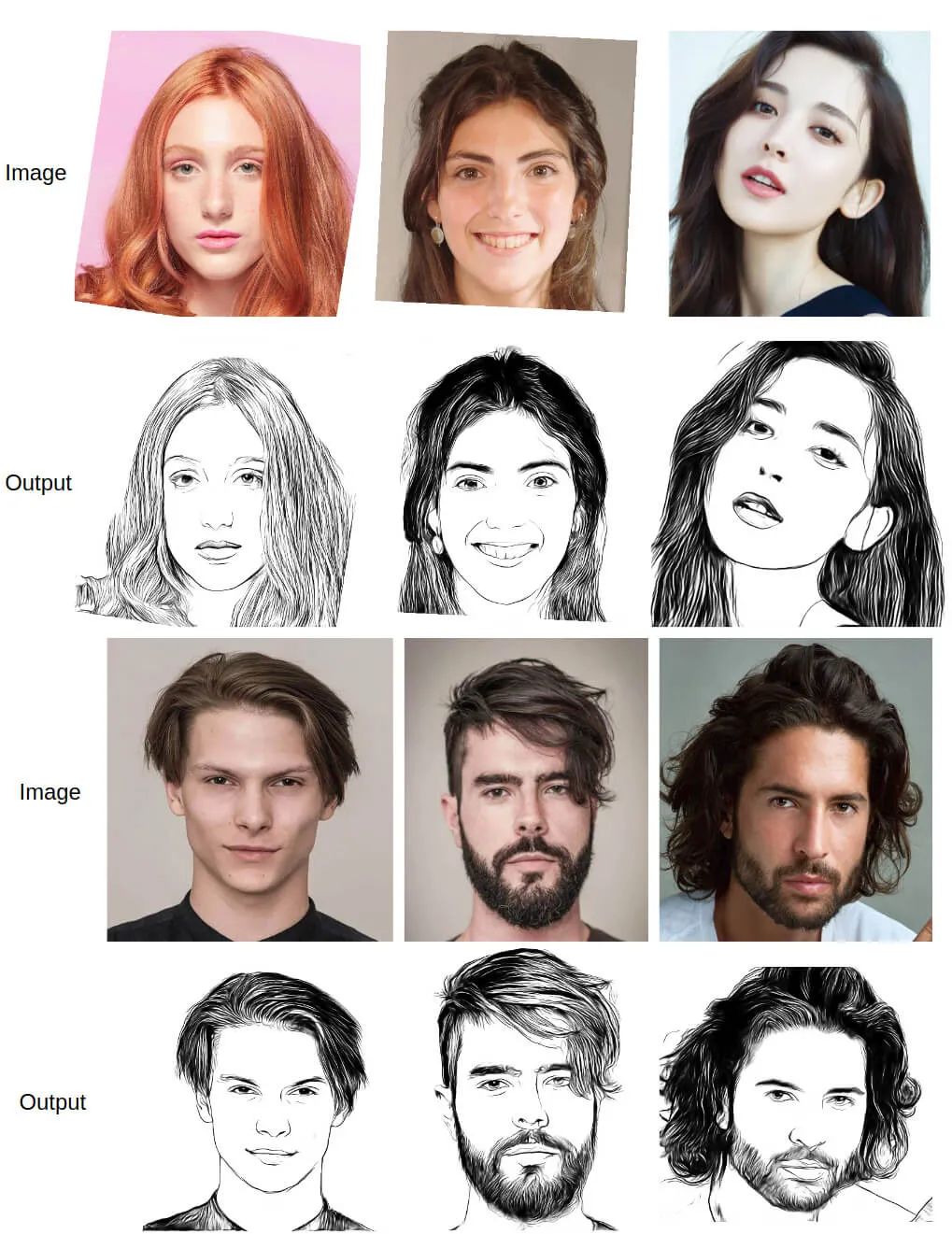

GitHub 标星 2.5K+,U^2-Net 跨界肖像画,完美复刻人物细节!

-

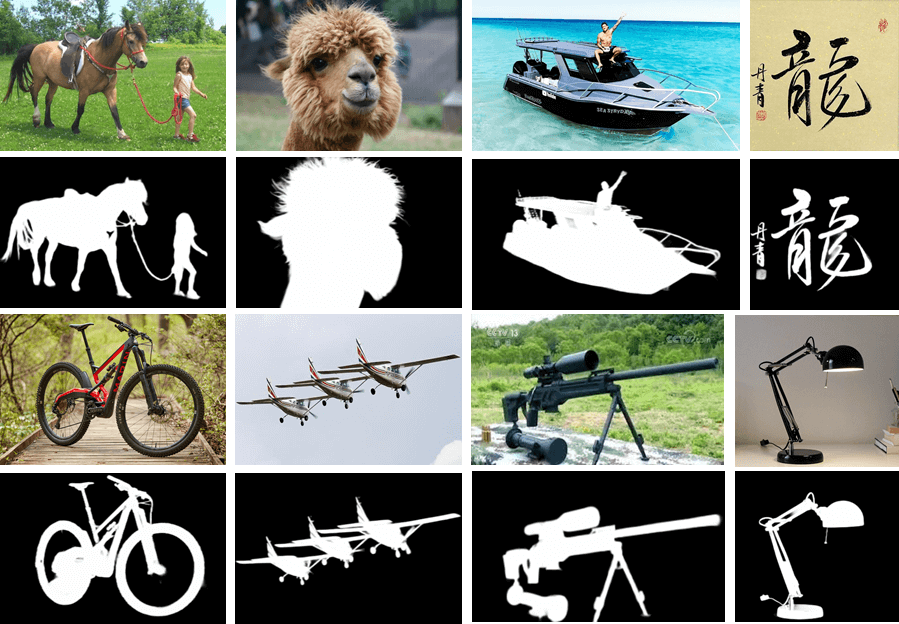

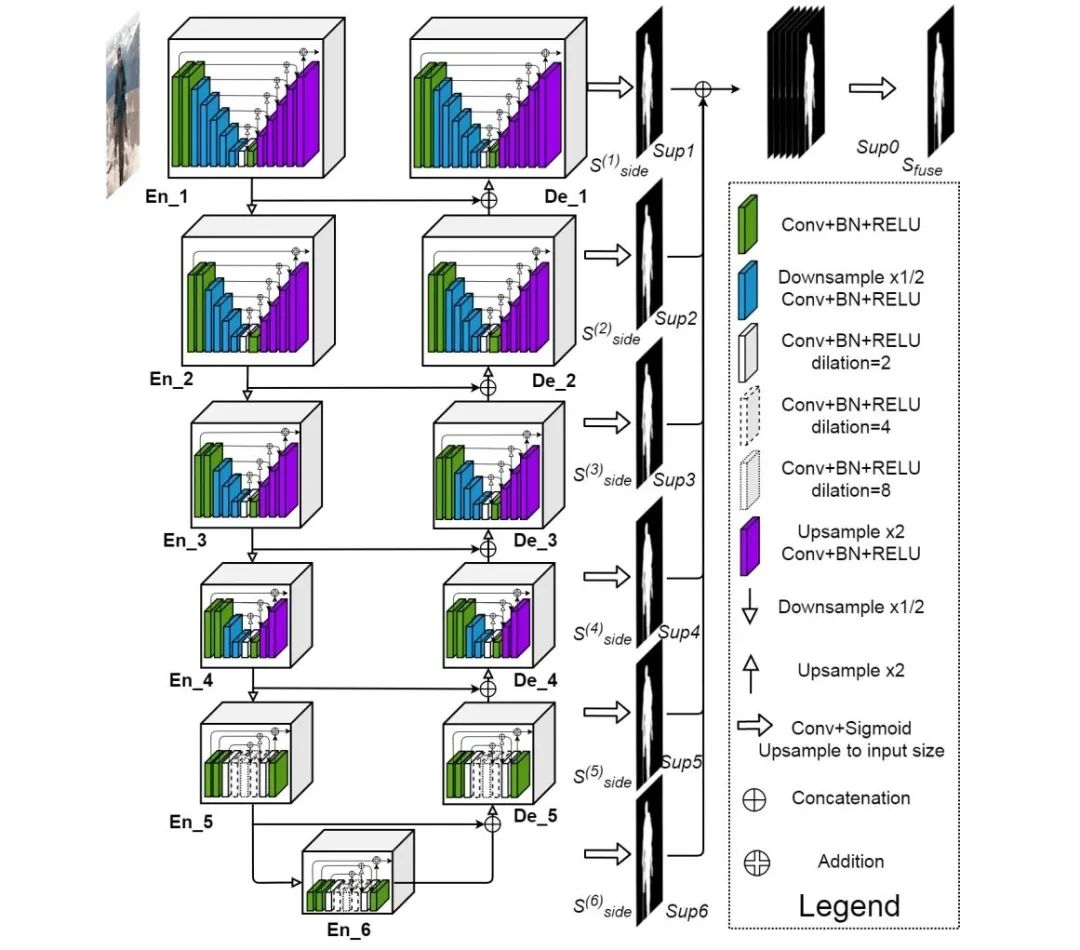

6 阶段编码器; -

5 阶段解码器; -

与解码器阶段和最后编码器阶段相连接的显著图融合模块。

为 Sup1, Sup2, ..., Sup6 输出的显著图,

为 Sup1, Sup2, ..., Sup6 输出的显著图,

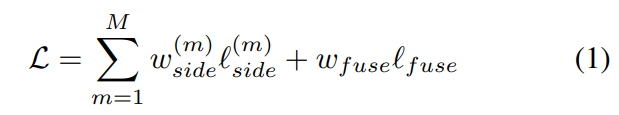

的损失函数;

的损失函数;

的损失函数;

的损失函数;

为每个损失函数的权重。

为每个损失函数的权重。

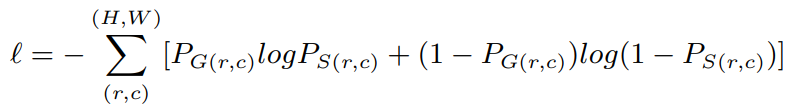

分别表示 GT 像素值和预测的显著概率图。

分别表示 GT 像素值和预测的显著概率图。

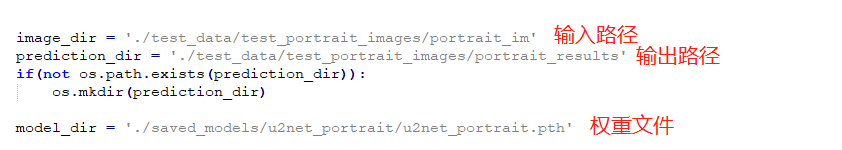

python u2net_portrait_test.py

br

更多精彩推荐

![]()

点分享

![]()

点点赞

![]()

点在看

登录查看更多

相关内容

Arxiv

3+阅读 · 2018年8月20日