【泡泡一分钟】利用监督学习的方法检测动态特征点(IV-1)

每天一分钟,带你读遍机器人顶级会议文章

标题:Learning to Detect Dynamic Feature Points

作者:Min-Gyu Park, Ju Hong Yoon, Jonghee Park, Jeong-Kyun Lee, and Kuk-Jin Yoon

来源:Intelligent Vehicles Symposium(IV 2017)

播音员:王肃

编译:陈建华

欢迎个人转发朋友圈;其他机构或自媒体如需转载,后台留言申请授权

摘要

大家好,今天为大家带来的文章是——利用监督学习的方法检测动态特征点,该文章发表于IV2017。

运动物体上动态点的检测是避免潜在碰撞的一项重要任务。然而,仅仅通过两帧图像来检测动态点是困难的,尤其是当输入数据(如车辆自身运动、视差图和光流)携带着各种噪声的时候。

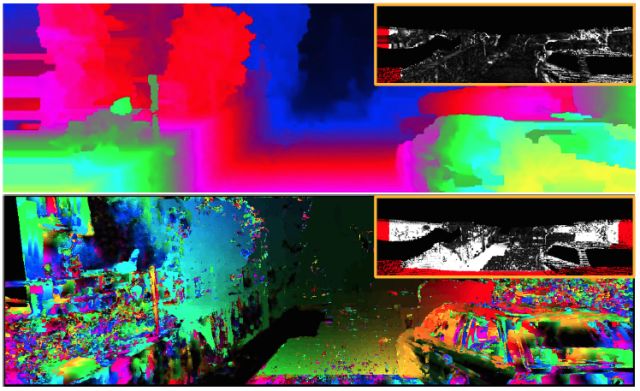

图1 带有噪声的各种输入数据

在本文中,作者提出了一种基于监督学习的方法,可以通过噪声数据来检测动态点。首先,考虑到深度不确定性随着与车辆距离增加按比例增长,作者将XZ平面(鸟瞰视图)划分为若干个区域。然后,基于两个运动度量指标计算得到运动矢量,并通过构建该运动矢量来训练每个区域的随机森林。

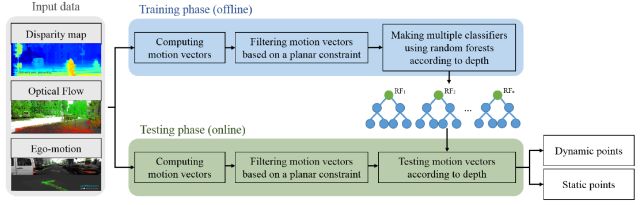

图2 本文方法的系统框架

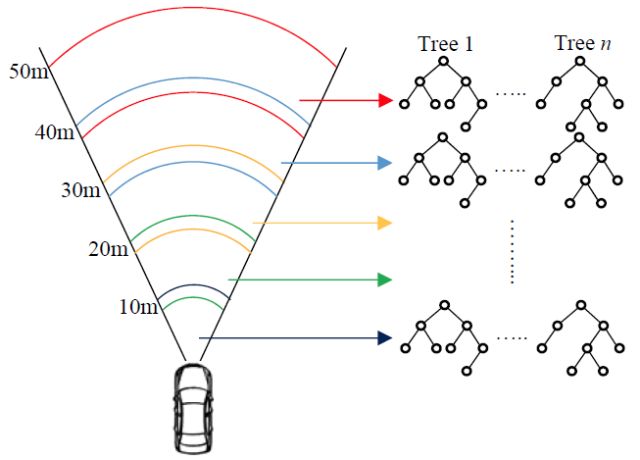

图3 区域划分与随机森林训练示意图

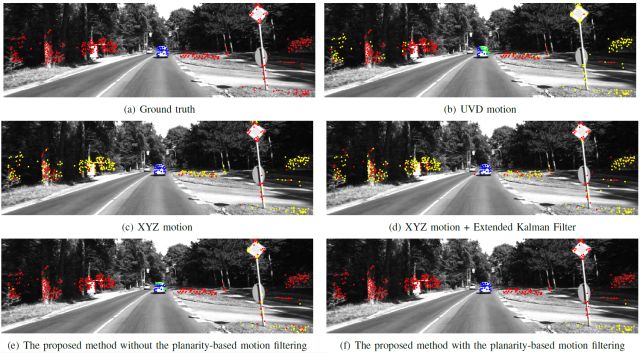

此外,为了减小输入数据的误差,作者通过成对像素点的平面性检查对运动矢量进行滤波,再将滤波后的运动矢量用于训练。最后的实验环节,作者通过与KITTI数据集上已有的方法进行检测性能比较,从而对本文所提出的方法进行验证。

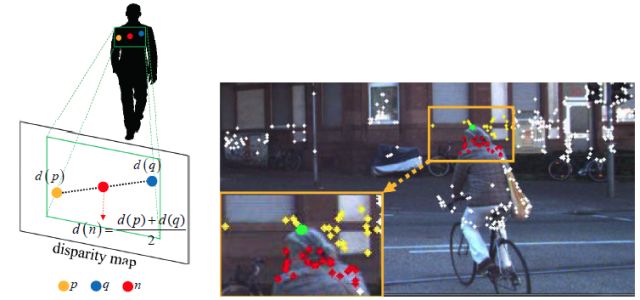

图4 像素点的平面约束示意图

图5 不同方法的动态点检测结果对比

Abstract

The detection of dynamic points on a moving platform is an important task to avoid a potential collision. However, it is difficult to detect dynamic points using only two frames, especially when various input data such as ego-motion, disparity map, and optical flow are noisy for computing the motion of points. In this paper, we propose a supervised learning-based approach to detect dynamic points in consideration of noisy input data. First of all, to consider depth ambiguity that proportionally increases according to the distance to the ego-vehicle, we divide the XZ-plane (bird-eye view) into several subregions. Then, we train a random forest for each subregion by constructing motion vectors computed based on two motion metrics. Here, in order to reduce errors of the input data, the motion vectors are filtered based on a pairwise planarity check and then filtered motion vectors are used for training. In the experiments, the proposed method is verified by comparing the detection performance with that of previous approaches on the KITTI dataset.

如果你对本文感兴趣,想要下载完整文章进行阅读,可以关注【泡泡机器人SLAM】公众号。

点击阅读原文,即可获取本文下载链接。

欢迎来到泡泡论坛,这里有大牛为你解答关于SLAM的任何疑惑。

有想问的问题,或者想刷帖回答问题,泡泡论坛欢迎你!

泡泡网站:www.paopaorobot.org

泡泡论坛:http://paopaorobot.org/forums/

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com