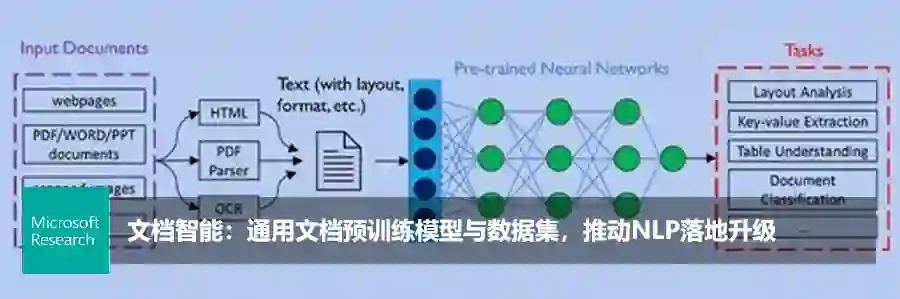

微软多语言预训练模型T-ULRv2登顶XTREME排行榜

编者按:为进一步实现用 AI 赋能用户体验,微软正在不断拓展多语言模型的边界。近日,由微软图灵团队与微软亚洲研究院联合探索的最新跨语言研究成果——多语言预训练模型 T-ULRv2,登顶 XTREME 排行榜,T-ULRv2 可以在相同向量空间表示和理解94种语言,提升所有语言的产品体验。本文编译自微软亚洲研究院副院长周明和微软副总裁、杰出工程师 Saurabh Tiwary 共同发表的微软研究院博客文章 “Microsoft Turing Universal Language Representation model, T-ULRv2, tops XTREME leaderboard”。

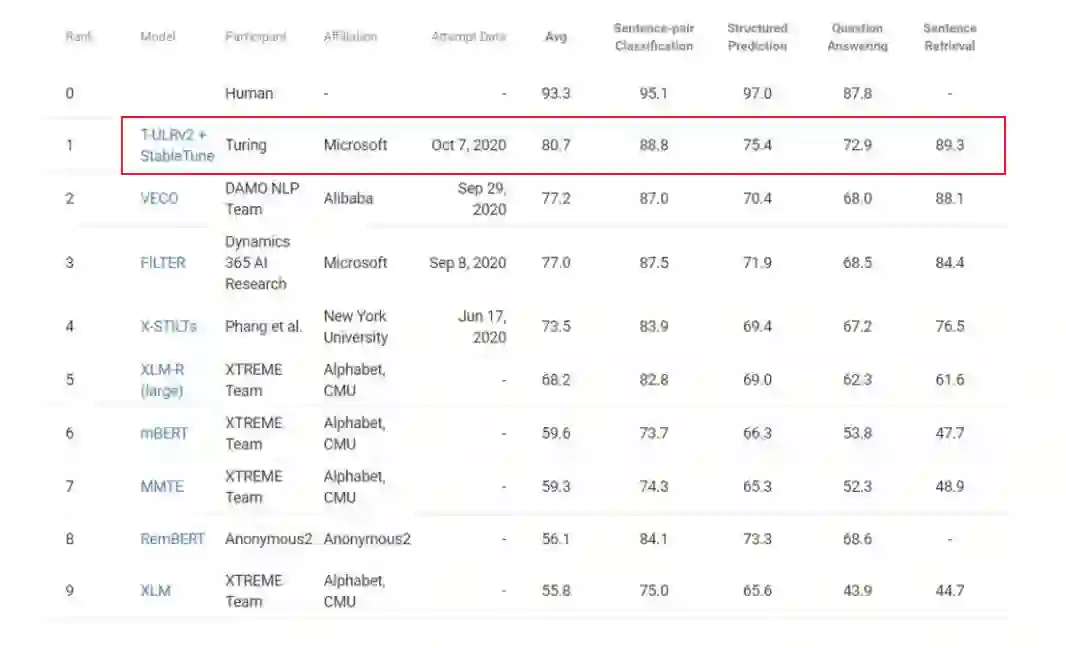

近日,由微软图灵团队与微软亚洲研究院联合开发的图灵多语言预训练模型 T-ULRv2 荣膺 XTREME 公共排行榜冠军,该模型比之前最好的模型 VECO 有了3.5的平均分提升。在此次突破中,除了预训练的模型外,微软的研究员们还提出了一种基于稳定性训练的新型多语言微调技术 StableTune。入围本次排行榜的其他模型还包括:XLM-R、mBERT 和 XLM 等。此前的最好模型 FILTER 也是由微软团队提交的。

长期以来,微软图灵团队坚信文本的语义表示是语言无关的。在2018年发表的论文 Towards Language Agnostic Universal Representations中(https://www.microsoft.com/en-us/research/publication/towards-language-agnostic-universal-representations/),微软的研究员们提出了一种方法,以无监督方式训练语言无关的语义表示。此方法可以让经过训练的模型在针对某一个语言加以微调后,立即应用于另一个语言。以往针对每个语言进行模型训练都要求具备该语言的标注数据,而此方法有效地解决了这一难题。无监督的预训练语言模型已成为所有 NLP 模型的基础,基于 Transformer 的模型则是所有此类创新的核心。

作为微软 AI at Scale(AI 规模化)研发的重要组成部分之一,图灵系列的 NLP 模型一直在为微软产品的下一代 AI 体验提供原动力。T-ULRv2 是跨语言研究的最新成果,它融合了微软亚洲研究院近期在 InfoXLM 论文(点击阅读原文,了解论文详情)中的创新,其所开发的多语言预训练模型可以用于94种语言的文本的自然语言理解任务。通过 T-ULR 可以将微软必应的智能问题解答服务扩展到所有受支持的语言和地区。而且这个模型还被用于将 Word 语义搜索功能扩展到英语之外的语言,并且实现对微软 Outlook 和微软 Teams 中“建议答复”功能地普遍支持。这些功能的体验将会很快与用户见面。

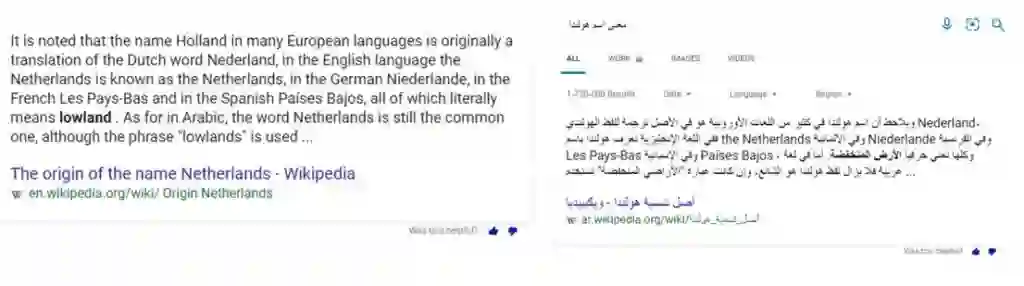

由 T-ULR 驱动的西班牙文及阿拉伯文版微软必应智能问题解答示例

由 T-ULR 驱动的法文版微软 Word 语义搜索示例

这些真实的产品场景对算法质量的要求极高,因此也为研究员们的 AI 模型提供了理想的测试平台。根据结果显示,T-ULR 在多语言 NLP 任务中的准确率和性能都达到了非常可观的效果。

多语言编码器的跨语言迁移能力评估 XTREME 基准涵盖了横跨12个语系的40种语言,其中包含的9项任务都需要对不同层级的语法或语义进行推理。XTREME 中的语言选择旨在最大程度地提高语言多样性、覆盖现有的任务范围,并考虑到训练数据的可用性。

XTREME 中包含的任务涵盖了包括语句文本分类、结构化预测、语句检索和跨语言问答等自然语言处理任务。因此,为了成功完成 XTREME 基准测试,模型必须学会可以跨语言迁移的表示。

有关基准测试和任务的完整说明,请参见《XTREME:A Massively Multilingual Multi-task Benchmark for Evaluating Cross-lingual Generalization》(https://arxiv.org/abs/2003.11080) 。

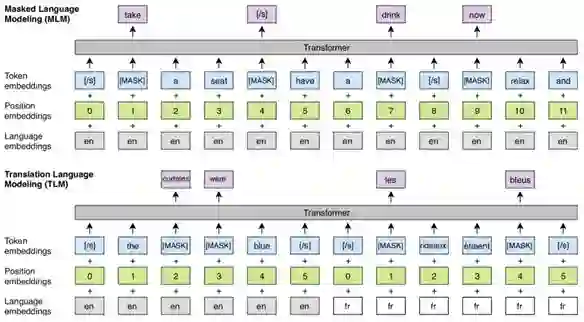

T-ULRv2 采用的是24层的 Transformer 架构,参数总量多达5.5亿个。T-ULRv2 预训练要完成三项不同的任务:多语言掩码语言模型(MMLM)、翻译语言模型(TLM)和微软研究团队提出的跨语言对比学习(XLCo)。MMLM 任务(也称为完形填空任务)的目标是根据输入的不同语言信息预测出被遮蔽的字符。T-ULRv2 使用了来自网络的多语言数据语料库,该语料库由94种语言组成,用于 MMLM 任务训练。

与 MMLM 相似,TLM 任务也是预测被遮蔽的字符,但该预测是针对拼接在一起的的平行句对。例如,给定一对英语和法语的平行句子,模型可以通过观察被遮蔽英语字符周边的英语字符或者它的法语翻译版来预测这个被遮蔽的英语字符。它能够帮助模型“对齐”不同语言的表示。

遮蔽语言建模(MLM)的跨语言预训练以及 TLM 任务(来源:XLM)

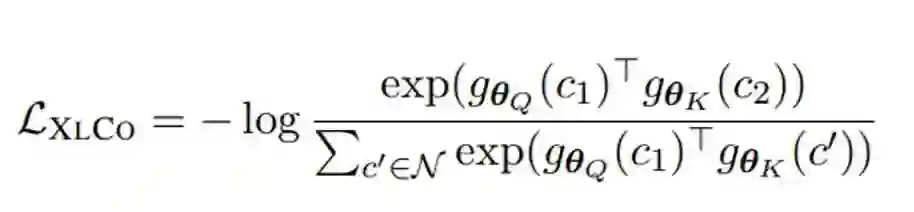

XLCo 任务则可以使用平行训练数据,其目的是让平行句子表示之间的互信息最大化。MMLM 和 TLM 的目标是使字符-序列互信息最大化,而 XLCo 的目标是序列级别的跨语言互信息最大化。对于 TLM 和 XLCo 任务,T-ULRv2 会用到含有14个语言对的平行数据。XLCo 的损失函数如下:

随后,它将计入 MMLM 和 TLM 的损失,得出跨语言预训练的总体损失:

有关 T-ULRv2 的更多信息,请参见论文《InfoXLM: An Information-Theoretic Framework for Cross-Lingual Language Model Pre-Training》(https://arxiv.org/abs/2007.07834) 。

在微软 Ignite 2020 大会上,微软宣布图灵模型将作为私人预览的一部分,用于构建定制化应用,而 T-ULRv2 也将成为该计划的一部分。目前,研究团队正在与微软 Azure 认知服务部门紧密合作,为当前及未来带有图灵模型的语言服务提供支持。微软 Azure 认知服务的现有客户将通过 API 自动享受这些升级服务。

微软认为,全球化发展不仅仅是个研究课题,也是一项必须直面的挑战。目前 Windows 在全世界范围内被使用,微软 Office 和微软必应也已在200个地区使用,且提供了超过100个语言版本。微软的客户遍及全球每个角落,他们都在以各自的母语使用着微软的产品。当下,微软的研究员们正在积极地拓展多语言模型的边界,像类似于 T-ULRv2 这样无语言差异的表示便是拓展之路上的又一次突破。它将可以提升所有语言的产品体验,赋能所有用户,真正实现 AI 体验的普及化。

你也许还想看: