![]()

在21世纪20年代的最后一个周末

,AI研习社联合阿里文娱和北理工等共同举办了一场「AAAI 2020论文解读会」。

AAAI 无需多言。2020年2月7日-12日,AAAI 2020 将于美国纽约举办。在11月中旬,大会官方公布了今年的论文收录信息:共有8800 篇提交论文,评审了 7737 篇,接收 1591 篇,接收率 20.6%。

随后国内先后举办了多场AAAI 论文分享活动,例如,

12月3日,苏州人工智能大会上由周国栋教授领衔、漆桂林教授主持的「

自然语言处理与AAAI 2020的石城邂逅

」;

12月22日,由中国中文信息学会青工委主办,北大王选计算所承办的「

AAAI 2020论文预讲会

」;

12月28日,有阿里文娱、北理工、AI研习社联合举办的「

AAAI 2020论文解读会

」。

以上三场AAAI 2020 论文预讲活动,AI研习社皆有直播,并将陆续放出录播视频,

![]()

感兴趣者可以扫描二维码观看回放:

![]()

或打开网页:https://www.yanxishe.com/meeting/80

本文将简要介绍 28 日「AAAI 2020 论文解读会」的 10 篇论文,并附相应讲解 PPT 及下载链接。

如对以下论文内容感兴趣,可关注 微信公众号「

AI 科技评论

」,回复「

AAAI2020@望京

」,打包下载全部 10 篇论文相关PPT。

AAAI 论文:MemCap: Memorizing Style Knowledge for Image Captioning

本文提出了一种通过记忆机制对语言风格相关的知识进行编码的风格化图像描述方法。由于语言风格无法直接从图像中得到,我们使用记忆模块存储语言风格相关的知识,并在生成风格化描述时根据图片中的内容检索这些知识。

AAAI 论文:Discovering New Intents via Constrained Deep Adaptive Clustering with Cluster Refinement

识别新用户的意图是对话系统中的重要任务,然而我们很难透过聚类方法获得令人满意的结果,因为意图定义受主观先验知识所影响。 现有方法透过过大量特征工程来融入先验知识,不仅会导致模型过拟合,也对聚类中心数敏感。

在本文中,我们提出了具有聚类细化的约束深度自适应聚类(CDAC+),这种端到端方法可以自然地将成对约束作为先验知识来指导聚类过程。 此外,我们通过强制模型从高置信度分配中学习来优化聚类。 在消除了低置信度分配之后,我们的方法对集群的数量出奇地不敏感。 在三个基准数据集上的实验结果表明,与强基准相比,我们的方法可以产生重大改进。

AAAI 论文:Deep Time-Stream Framework for Click-Through Rate Prediction by TrackingInterest Evolution

DTS (Deep Time-Stream Framework)是一个考虑了连续时间流信息的CTR预估框架。解决了目前现有的工业界广泛应用的CTR模型没能很好地建模连续时间信息的问题。其能够处理不同间隔下的用户序列行为,还能根据不同的预测时刻提供更加符合用户兴趣的视频。

AAAI 论文:Joint Commonsense and Relation Reasoning for Image and Video Captioning

本文提出了一种联合常识和关系推理的图像视频文本描述生成方法。该方法通过迭代学习算法实现,交替执行以下两种推理方式:(1) 常识推理,将视觉区域根据常识推理,嵌入到语义空间中从而构成语义图;(2) 关系推理,将语义图通过图神经网络编码,生成图像视频文字描述。

AAAI 论文:F3Net: Fusion, Feedback and Focus for Salient Object Detection

近期,许多显著性检测模型都是基于多尺度特征融合的,通过融合不同卷积层的特征,这些模型可以输出准确的显著图。然而由于不同卷积层具有不同感受野,来自这些卷积层的特征存在着较大的差异性,常见的特征融合策略(相加,拼接)忽略了这些差异性并可能导致模型性能受限。

在本文中,我们提出了F3Net来解决上述问题, 它主要包含交叉特征融合(CFM),级联的反馈解码器(CFD)以及像素位置敏感损失(PPA)。具体来说,交叉特征融合的目标是有选择地聚合多层特性。不同于相加或者拼接, 交叉特征融合自适应地在融合前从输入特征中选择互补成分,有效地避免了引入过多的冗余信息而破坏原有特征。

另外,级联的反馈解码器采用了多级反馈机制,将靠近监督信号的特征引入到前层的特征中进行补充矫正以及消除特征间的差异。在生成最终的显著图之前,这些细化的特性要经过多次类似的迭代。不同于二值交叉熵,像素位置敏感损失并不会平等对待每一个像素,它可以综合单一像素周围的结构特征,以指导网络关注局部细节。来自边界或易出错部分的困难像素将会得到更多的关注,以强调其重要性。F3Net能够准确地分割出显著性目标并提供清晰的局部细节。它在5个基准数据集以及4个评价指标上都取得了目前最好的性能。

AAAI 论文:Rule-Guided Compositional Representation Learning on Knowledge Graphs

知识图谱的表示学习是将知识图谱中的实体与关系嵌入低维实值向量空间。早期的知识图谱表示学习方法只关注知识图谱中三元组的结构信息,但由于知识图谱的结构稀疏性,会导致知识表示学习性能受限。最近的一些尝试考虑采用路径信息来扩展知识图谱的结构,但是在得到路径表示的过程中缺乏可解释性。

本文提出了一种新的基于规则和路径的联合嵌入的方法(RPJE),该方案充分利用了逻辑规则的可解释性和准确性、知识图谱表示学习的泛化性以及路径提供的语义结构。具体来说,首先从知识图谱中挖掘不同长度(规则体中的关系个数)的Horn子句形式的逻辑规则,并对其进行编码,用于表示学习。然后,应用长度为2的规则来准确地组合路径,而显式地使用长度为1的规则来创建关系之间的语义关联并约束关系的向量表示。此外,在优化过程中还考虑了各规则的置信度,以保证规则应用于表示学习的有效性。

大量的实验结果表明,RPJE在完成知识图谱补全任务方面优于其它baselines,这也证明了RPJE在完成知识图谱补全任务的优越性,验证了利用逻辑规则和路径提高知识图谱表示学习的精度和可解释性。

AAAI 论文:DualVD: An Adaptive Dual Encoding Model for Deep Visual Understanding in Visual Dialogue

近年来,跨模态研究引发了广泛关注并取得显著进展,综合分析语言和视觉等不同模态的信息对模拟现实社会中人类对于信息的认知过程具有重要意义。

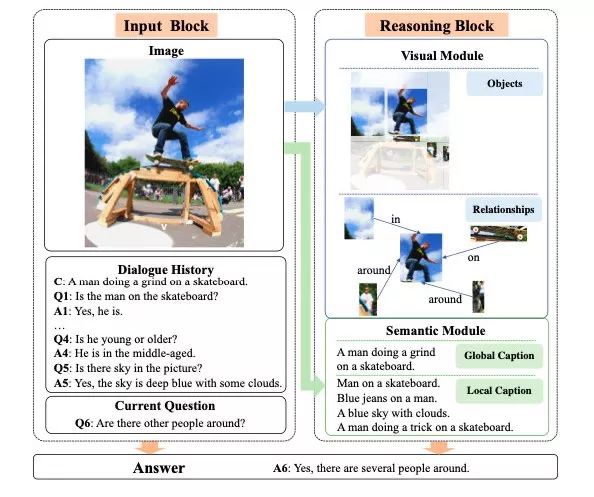

视觉对话问题是视觉问答任务的衍生任务,不同的是,视觉对话任务需要根据图像、历史对话回答当前问题,涉及多个问题且涵盖了可能与任何对象、关系或语义相关的广泛视觉内容,因此视觉对话需要根据对话的推进,不断调整关注区域使之有效地捕捉问题所涉及的视觉信息,针对不同问题对图像进行自适应的关注。

如下图 1 所示「Q1: Is the man on the skateboard?」, 需要关注「man」,「skateboard」等信息,当问题变换为「Q5: Is the sky in the picture」时,需要将关注区域转移至「sky」。问题 Q1 和 Q5 主要关注在表层(appearance-level)信息问题,而 Q4「Is he young or older」则需要进一步地视觉推理得到更高层的语义信息。因此,如何根据问题进行自适应调整并有效地捕捉视觉信息是视觉对话问题中的重要挑战之一。

根据认知学中的双向编码理论(Dual-Coding Theory), 人类认知信息的过程包含视觉表象和关联文本,人的大脑在检索关于某个概念的信息时会综合检索视觉信息以及语言信息,这种方式能够加强大脑的理解以及记忆能力。

作者根据此理论,提出从视觉和语义两个维度刻画视觉对话任务中图象信息的新框架:语义模块描述图像的局部以及全局的高层语义信息,视觉模块描述图像中的对象以及对象之间的视觉关系。基于此框架,作者提出自适应视觉选择模型 DualVD(Duel Encoding Visual Dialog),分别进行模态内与模态之前的信息选择。

AAAI 论文:Collaborative Sampling in Generative Adversarial Networks

生成对抗网络(GAN)中的标准做法是在生成样本时完全丢弃鉴别器。但是,这种采样方法会丢失鉴别者从数据分配中学到的有价值的信息。

在这项工作中,我们提出了在生成器和鉴别器之间的协作采样方案,以改善数据生成。在鉴别器的指导下,我们的方法通过在生成器的特定层通过基于梯度的优化来优化生成的样本,从而使生成器的分布更接近于实际数据分布。此外,我们提出了一种实用的鉴别器整形方法,该方法可以平滑损失情况,并进一步改善样品细化过程。

通过对合成数据集和图像数据集的实验,我们证明了我们提出的方法能够定量和定性地改善生成的样本,从而为GAN采样提供了新的自由度。我们最终展示了其解决模式崩溃的潜力以及对抗性示例。

AAAI 论文:Overcoming Language Priors in VQA via Decomposed Linguistic Representations

本文提出了一种基于语言注意力的视觉问答方法。我们的方法可以灵活地学习和利用问题中各种信息(问题类型,指代对象和期望概念)的分解表达。因此我们的方法可以最大程度地减少语言先验的影响,并实现透明的回答过程。

AAAI 论文:Revisiting Bilinear Pooling: A Coding Perspective

本文首先证明了常用的特征融合方法——双线性池化是一种编码-池化的形式。从编码的角度,我们提出了分解的双线性编码来融合特征。与原始的双线性池化相比,我们的方法可以生成更加紧致和判别的表示。

01. 时间可以是二维的吗?基于二维时间图的视频内容片段检测

02. 全新视角,探究「目标检测」与「实例分割」的互惠关系

03. 新角度看双线性池化,冗余、突发性问题本质源于哪里?

04. 复旦大学黄萱菁团队:利用场景图针对图像序列进行故事生成

05. 2100场王者荣耀,1v1胜率99.8%,腾讯绝悟 AI 技术解读

06. 多任务学习,如何设计一个更好的参数共享机制?

07. 话到嘴边却忘了?这个模型能帮你 | 多通道反向词典模型

08. DualVD:一种视觉对话新框架

![]()

![]()

AI 科技评论希望能够招聘 科技编辑/记者 一名

办公地点:北京

职务:以参与学术顶会报道、人物专访为主

工作内容:

1、参加各种人工智能学术会议,并做会议内容报道;

2、采访人工智能领域学者或研发人员;

3、关注学术领域热点事件,并及时跟踪报道。

要求:

1、热爱人工智能学术研究内容,擅长与学者或企业工程人员打交道;

2、有一定的理工科背景,对人工智能技术有所了解者更佳;

3、英语能力强(工作内容涉及大量英文资料);

4、学习能力强,对人工智能前沿技术有一定的了解,并能够逐渐形成自己的观点。

感兴趣者,可将简历发送到邮箱:jiawei@leiphone.com