深度学习进化编年大事记

安妮 编译自 Import.io官方博客

量子位出品 | 公众号 QbitAI

本文作者Andrew Fogg,可视化网页抓取网站Import.io的联合创始人。这篇文章阐明了人工智能、机器学习与深度学习的关系,进而讲述深度学习成长史,带你一文入门深度学习。

当你听到“深度学习”时,可以想象一个巨大的深度神经网络。“深度”指的是层数,媒体经常采用这种说法。

——杰夫·迪恩

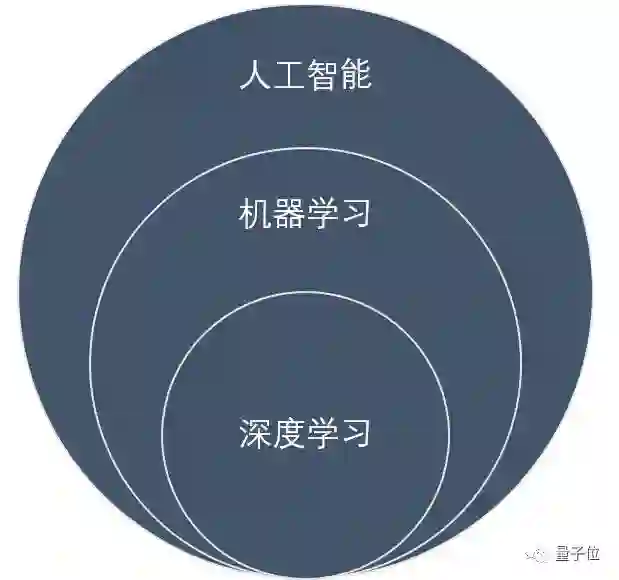

人工智能、机器学习和深度学习这三个词经常被互换,但它们的含义并不相同。我们用一张图概括三者关系——

△ 人工智能、机器学习与深度学习之间的关系

人工智能的定义颇具争议,一种说法就是“与人类思考方式相似的计算机程序”。根据应用范围的大小,我们将它分为通用型和应用型(应用范围窄)人工智能。

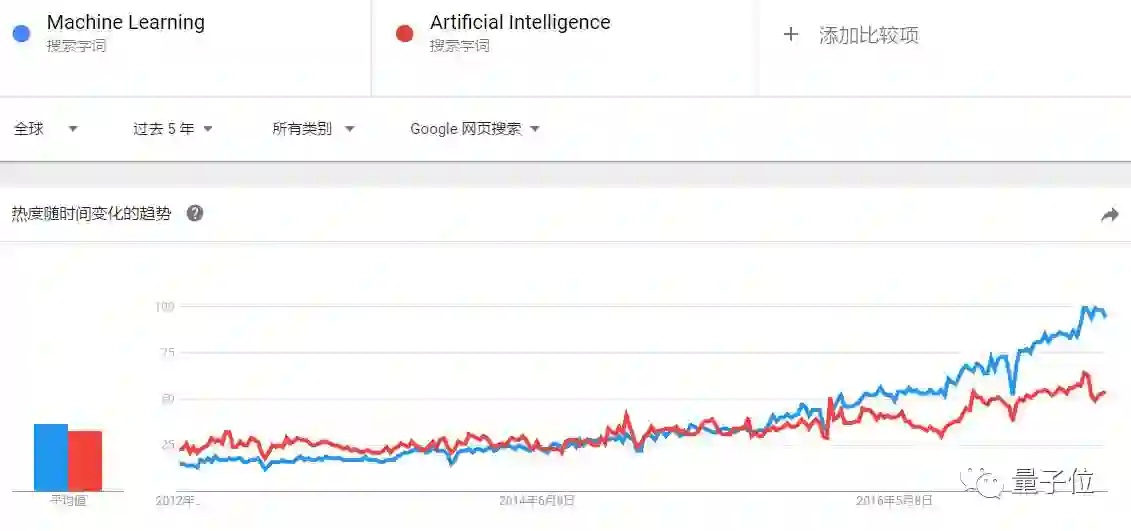

Google Trends数据显示,自2015年起,“机器学习”的搜索热度超过人工智能本身。机器学习是指在没有提供明确程序的情况下,机器自学完成任务。决策树、聚类、增强学习或贝叶斯网络等算法帮助它理解输入程序。

△ 2015年9月,谷歌搜索中机器学习的热度超过人工智能

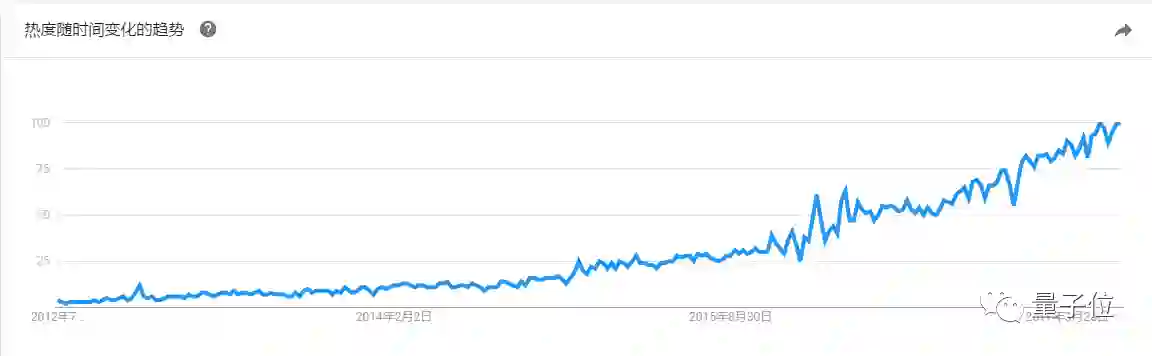

深度学习是在人工神经网络(ANN)基础上发展来的表示学习方法。它通过构建多层表示学习结构,组合原始数据中的简单特征,从而得到更高层、抽象的表示。

△ 深度学习趋势图

这是目前人工智能领域最振奋人心的发展,我们一起看看它的发展轨迹。

1943年:首个神经网络的数学模型诞生

推进人:Walter Pitts和Warren McCulloch

显然,想要解决机器与深度学习的问题,我们首先需要了解人类大脑的神经网络。

1943年,逻辑学家Walter Pitts和神经科学家McCulloch通过创造神经网络的数学模型解开了这个谜题。他们合著了《神经活动中固有的思维的逻辑运算》一书,书中提出将数学和算法的结合,模仿人类思维活动。

电子书地址(英文):

https://dl.acm.org/citation.cfm?id=104377

他们的模型被称为McCulloch-Pitts神经元(M-P神经元),至今仍然是标准模型。

1950年:机器学习的预测

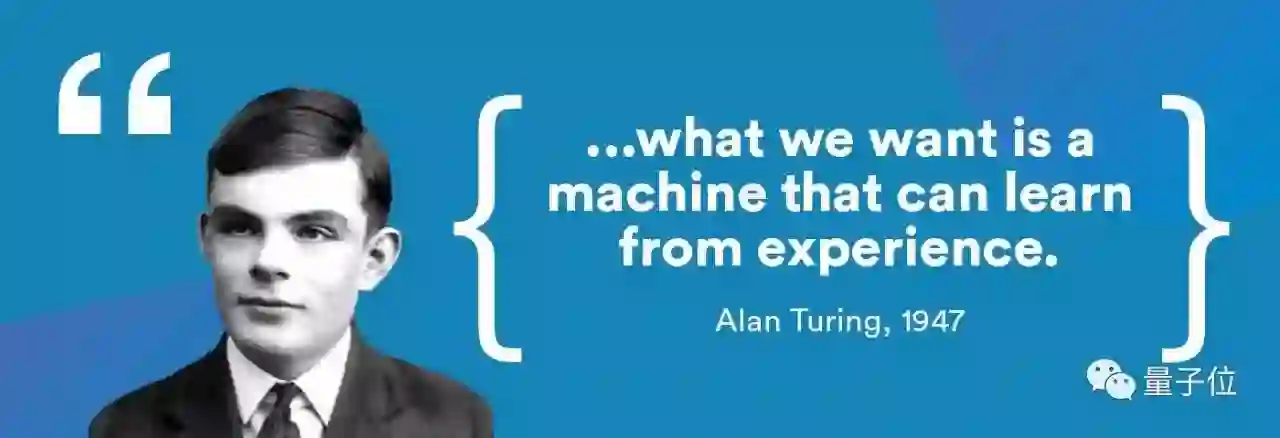

推进人:阿兰·图灵

图灵是一名英国数学家,因在二战中破解了德国的Enigma密码出名,但他的成就没有止步于此。

1947年,他预测出机器学习的发展趋势。这个趋势在70年后的今天看来,也颇具指导意义。

△ 图灵

1950年,图灵在他的论文《计算机器与智能》中精心设计了一场机器模仿人类的游戏,据此判断机器是否会“思考”,也就是著名的图灵测试。

论文地址(英文):

http://mpcrlab.com/2016/09/turing-alan-m-computing-machinery-and-intelligence-1950/

图灵测试让计算机通过文本方式与人类聊天5分钟,若人类无法确定对方为机器还是人类则测试通过。不得不说,这个简单的测试是机器学习史上浓墨重彩的一笔。

尽管这个测试的有效性还颇具争议,但却是60多年来研究人员的目标。

1957年:感知器神经网络模型问世

推进人:Frank Rosenblatt

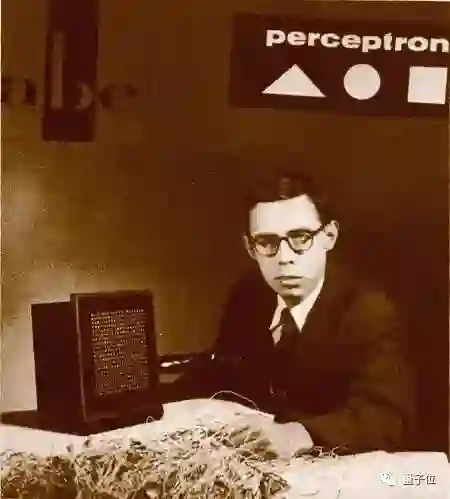

1957年,心理学家Rosenblatt向康奈尔航空实验所提交了一篇论文,题目为《感知器:感知和识别的自动机》。

△ Frank Rosenblatt

论文地址(英文):

https://blogs.umass.edu/brain-wars/files/2016/03/rosenblatt-1957.pdf

在这篇论文中,Rosenblatt提出感知器(Perceptron)的概念。这是首个用算法精确定义神经网络的数学模型,是后来很多神经网络模型的始祖。

他宣称,自己将构建一个电子或电动机械系统来学习识别不同模式之间的相似之处,某种程度上说,这与生物大脑的感知过程非常相似。

1959年:发现简单细胞和复杂细胞

推进人:David H. Hubel和Torsten Wiesel

1959年,诺贝尔生理学或医学奖获得者David H. Hubel与Torsten N. Wiesel合作,联手发现初级视觉皮层的两种类型的细胞:简单细胞和复杂细胞。

这项研究展示了视觉系统是怎样将简单的视觉特征在视皮层呈现出来的。此项研究不是深度学习的里程碑式的成果,但对该领域后续研究影响很大。

1960年:提出控制论

推进人:Henry J. Kelley

Kelley本是弗吉尼亚理工学院的航空航天和海洋工程专业的一名教授,1960年发表了论文《最佳飞行路径的梯度理论》。

论文地址(英文):

https://arc.aiaa.org/doi/10.2514/8.5282

他提出的很多控制理论已经被直接应用在AI和ANN中,比如输入系统的行为,被反馈修正的过程等问题。它们是训练神经网络的连续反向传播模型(也就是错误的反向传播)的基础。

1965年:首个有效深度学习网络诞生

推进人:Alexey Ivakhnenko和V.G. Lapa

数学家Ivakhnenko和Lapa等同事在1965年创建了首个有效深度学习网络。这是一个针对监督深度前馈多层感知的通用、可行的学习算法,首次将理论和想法应用到实践上。

Ivakhnenko提出数据分组处理 (Group Method of Data Handling,简称GMDH)的核心技术:这是一种基于计算机数学模型的多参数数据集的归纳算法,能够自动建模并优化参数。这项技术可以被应用到神经网络上。

GMDH官方介绍(英文):

http://www.gmdh.net/

出于这个原因,很多人认为Ivakhnenko是现代深度学习之父。

△ Alexey Ivakhnenko

他的算法使用深层前馈多层感知器,逐层统计寻找最佳的特征,并传递给系统。

在1971年,Ivakhnenko在当时计算条件的限制下,已经创造出了8层的深度网络,并成功演示了计算机识别系统Alpha的学习过程。

1970-80年:ANN学会识别视觉模式

推进人:Kunihiko Fukushima

日本的福岛邦彦(Kunihiko Fukushima)于1980年提出“新认知机”(Neocognitron)的概念。

新认知机介绍(英文):

http://www.scholarpedia.org/article/Neocognitron

这是一种学习如何识别视觉模式的人工神经网络。目前,这项技术已经被应用在手写字符和其他模式识别、推荐系统甚至自然语言处理等任务中。

1982年:创造出Hopfield网络

推进人:John Hopfield

1982年,Hopfield创立并推广了这个以他的名字命名的系统。

Hopfield网络是一种循环神经网络,也是一种综合存储系统。即使到了21世纪,它仍然是一种流行的深度学习实现工具。

什么是Hopfiled?这里有一份英文介绍:

http://www.scholarpedia.org/article/Hopfield_network

1985年:程序会读英语单词了

推进人:Terry Sejnowski

1985年,计算神经科学家Terry Sejnowski利用通过理解人类学习过程创建了NETtalk。

不妨听作者自己讲讲什么是NETtalk:

http://cs.union.edu/~rieffelj/classes/2009-10/csc320/readings/Sejnowski-speech-1987.pdf

该程序学习英语单词的方法与人类孩童无异,程序文本转换为语音的质量也随着时间推移进步。

1986年:形状识别和词汇预测水平提高

推进人:David Rumelhart, Geoffrey Hinton, and Ronald J. Williams

1986年,Rumelhart、Hinton和Williams提出误差反向传播算法(Error BackPropagation Algorithm),也就是现在说的BP算法。这项算法至今仍被应用在形状识别,词汇预测等任务中。

论文链接(英文):

https://www.researchgate.net/publication/229091480_Learning_Representations_by_Back_Propagating_Errors

Hinton是公认的“深度学习之父”,他对神经网络的其他贡献包括分散表示、延时神经网络、专家混合系统和亥姆霍兹机等。目前Hinton任职于多伦多大学与Google。

1989年:机器读取手写数字

推进人:Yann LeCun

LeCun是深度学习领域中的另一个“摇滚明星”,他发现了如何在光学字符识别和计算机视觉上使用卷积神经网络 (CNN),因此被称为卷积网络之父。

1989年,他将卷积神经网络和反向传播理论结合起来,创造出能“读懂”手写数字的学习方法。

1989年:Q-learning诞生

推进人:Christopher Watkins

Watkins在1989年发表的博士论文《延迟奖励学习》中,提出Q-learning的概念,提高了强化学习的实用性和可行性。

论文地址(英文):

http://www.cs.rhul.ac.uk/~chrisw/new_thesis.pdf

这种新算法表明,可以直接学习最优控制,而不需要对马尔可夫决策过程的转移概率或预期回报进行建模。

1993年:解决了“很深度学习”的任务

推进人:Jürgen Schmidhuber

德国计算机科学家Schmidhuber在1993年解决了一个“很深度学习”的任务,允许循环神经网络中包含1000个层。

这是神经网络处理复杂性问题能力的巨大飞跃。

1995年:支持向量机

推进人:Corinna Cortes和Vladimir Vapnik

支持向量机(SVM)自20世纪60年代问世以来,经过了数十年的改进。

SVM英文介绍:

http://www.cs.rhul.ac.uk/~chrisw/new_thesis.pdf

目前的标准模型由Corinna Cortes和Vladimir在1993年设计出来,并于1995年提出的。

简单来说,SVM是一种用于识别和映射类似数据的系统,可用于文本分类,手写字符识别和图像分类。

1997年:提出LSTM

推进人:JürgenSchmidhuber和Sepp Hochreiter

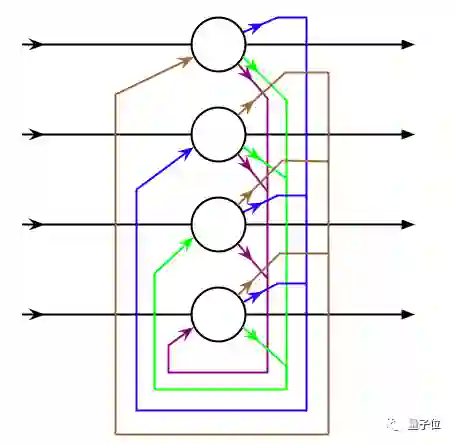

20年前,Schmidhuber和Hochreiter提出了一种循环神经网络框架,称之为长短时瞬时记忆(LSTM)。

△ LSTM经典模型

或许你需要这份资料(英文):

https://colah.github.io/posts/2015-08-Understanding-LSTMs/

LSTM解决了长期依赖性问题,提高了循环神经网络的效率和实用性,也就是说它可以“记住”更长时间的信息。

随着时间的推移,LSTM网络在深度学习圈中得到了广泛应用。最近,谷歌还将其应用在Android智能手机的语音识别软件中。

1998年:提出基于梯度的学习

推进人:Yann LeCun

1998年,Yann LeCun发表了开创性论文《基于梯度学习的文档识别方法》,标志着LeCun在深度学习领域取得了又一次进步。

论文地址:

http://yann.lecun.com/exdb/publis/pdf/lecun-01a.pdf

随机梯度下降算法(又称基于梯度的学习)与反向传播算法相结合,是目前常用的深度学习方法。

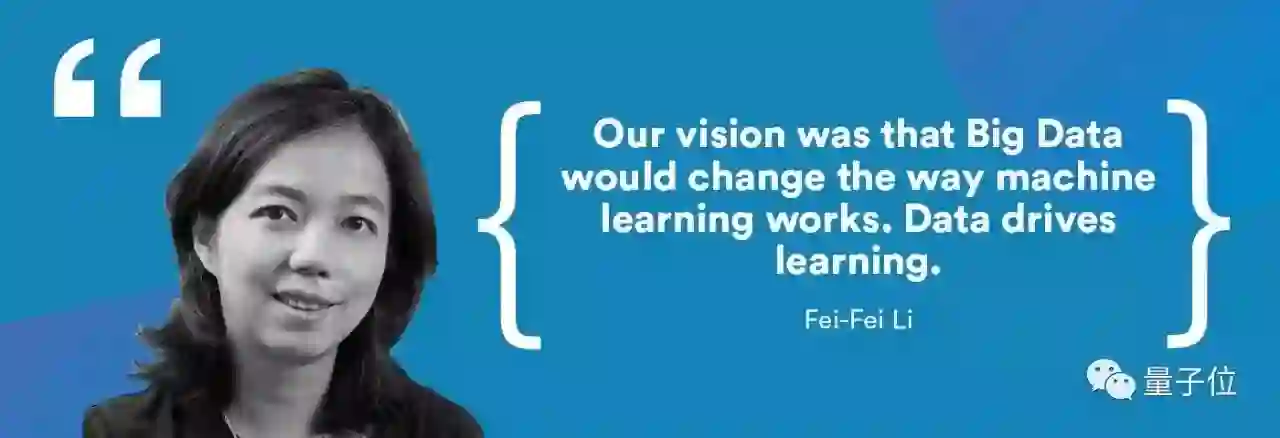

2009年:ImageNet创立

推进人:李飞飞

2009年,斯坦福大学人工智能实验室(SAIL)的负责人李飞飞启动了ImageNet,也就如今全球最大的图像识别数据库。

ImageNet官网:

http://image-net.org/

这是一个免费的图像数据库,里面涵盖了超过1400万张图像,为研究人员、教育工作者和学生提供了有标签的图片。

这些图片被打上标签并通过英文词汇数据库Wordnet管理。

2011年:AlexNet问世

推进人:Alex Krizhevsky

AlexNet是2012年ImageNet竞赛冠军获得者Alex Krizhevsky设计的,是卷积神经网络的一种。

AlexNet改进了LeNet5(早些年由Yann LeCun创建)。它最初只有8个层,包含5个卷积层和3个全连接层,并通过修正线性单元来加强速度和dropout。

自AlexNet被发现后,更多更深的神经网络也相继出现,它甚至为后续的CNN甚至是R-CNN等其他网络都定下了基调。

2012年:关于猫的实验

“猫的实验”?

你一定在心里画上了个问号。这听起来很可爱,好像也不重要,但它确实是深度学习向前迈进的一大步。

实验介绍(英文):

http://www.nytimes.com/2012/06/26/technology/in-a-big-network-of-computers-evidence-of-machine-learning.html

实验团队在数千台电脑上使用一个神经网络,将1千万张没有标记的YouTube视频截图上传至系统,并运行。

当这种无监督学习完成时,程序已经学会了如何自己鉴定并识别猫咪,运行正确率约为70%,相对于其他辨认程序,这个结果要好很多。

但是它也并不完美。这个网络可以仅能识别出约15%的表示对象。也就是说,距离真正的智能,它也仅推进了一小步。

2014年:DeepFace诞生

推进人:Facebook团队

Facebook团队在2014年首次公布了DeepFace研究,通过神经网络将人脸识别正确率提升到97.35%。这是一项重大突破,准确率比之前提高了27%。

目前人脸识别已经无处不在,下图为谷歌图片中用到的类似的程序。

2014年:发现生成式对抗网络(GAN)

推进人:Ian Goodfellow

自从两年前蒙特利尔大学的Ian Goodfellow等人提出GAN的概念以来,GAN呈现出井喷式发展。Yann LeCun也非常喜欢GAN——

“深度学习最近出现了很多有趣的进展。我认为最有意思的是生成式对抗网络。GAN和它的变体是机器学习领域最近十年最有趣的想法。”Yann LeCun说。

什么是生成式对抗网络?

http://blog.aylien.com/introduction-generative-adversarial-networks-code-tensorflow/

看,提起GAN,连大牛都觉得有趣吧。

简单来讲,GAN里隐含了两个互相对抗的网络:生成网络与判别网络。生成网络负责获取样例并尝试创建能够以假乱真的样例,而判别模型则需要判断每个数据点是真实的还是生成的。

量子位曾经介绍过GAN的诞生史:

2016年:各种强大的机器学习产品

2016年被称为人工智能的元年。在这一年里,不仅有AlphaGo与李世石的围棋对决这样的大事件,还涌现出很多基于机器和深度学习的产品和解决方案。

Cray(克雷公司)在XC50超级计算机上使用微软的神经网络软件,和近千个英伟达Tesla P100 GPU,可以在几个小时内处理过去几天才能完成的深度学习任务。

总结

在过去的60年里,人类在AI、ML、DL领域有了不小的突破,我们可以将这些进展整理成一条粗略的时间线。

1960年:浅层神经网络

1960-70年:反向传播出现

1974-80年:第一次人工智能的冬天来临

1980年:出现卷积的概念

1987-93年:第二次人工智能冬天再次降临

1990年:无监督学习问世

1990-2000年:监督深度学习重新流行

2006年-至今 现代深度学习

现在,深度学习不经意间就会出现在我们的生活中——它是谷歌的声音和图像识别,是Netflix和亚马逊的推荐引擎,是苹果的Siri,是电子邮件和短信的自动回复,是智能聊天机器人……

深度学习的下一步发展还不能确定。对于如此复杂的学习,我们无法推测它的发展时间表。

唯一能够肯定的是,未来是有趣的。

【完】

一则通知

量子位读者5群开放申请,对人工智能感兴趣的朋友,可以添加量子位小助手的微信qbitbot2,申请入群,一起研讨人工智能。

另外,量子位大咖云集的自动驾驶技术群,仅接纳研究自动驾驶相关领域的在校学生或一线工程师。申请方式:添加qbitbot2为好友,备注“自动驾驶”申请加入~

招聘

量子位正在招募编辑/记者等岗位,工作地点在北京中关村。相关细节,请在公众号对话界面,回复:“招聘”。

△ 扫码强行关注『量子位』

追踪人工智能领域最劲内容