CS224n 更新 | 第十二讲 - 语音处理的端对端模型

深度自然语言处理课 CS224n(2016-2017)为斯坦福官方开源最新版本,由斯坦福大学教授、 Salesforce 首席科学家 Richard Socher 授权雷锋字幕组翻译。

每周三,同步更新在 AI 研习社、AI 慕课学院。

第十二讲

语音处理的端对端模型

上手视频约 8 分钟

▼

翻译 | 吴晓曼 校对 | 程炜 字幕 | 凡江

课程直达

扫下方二维码

免费无限次观看 CS224n 中英字幕版

中文版 CS224d 课程介绍

自然语言处理(NLP)是信息时代最重要的技术之一。理解复杂的语言话语也是人工智能的重要组成部分。 NLP 的应用无处不在,因为人与人之间大部分的沟通都需要语言:网络搜索,广告,电子邮件,客户服务,语言翻译,放射报告等。

NLP 应用程序背后有大量的基础任务和机器学习模型。最近,深度学习方法通过不同的 NLP 任务实现了超高性能。这些模型通常可以通过单一的端到端模型进行训练,而不需要传统的、特定任务特征的工程。

CS224d ( 2016-2017 ) 中英字幕版

在这个冬季课程中,学生将学习执行、训练、调试、可视化和创造他们自己的神经网络模型。该课程全面介绍了应用于NLP的深度学习尖端研究。在模型方面,介绍词向量表示、基于窗口的神经网络、时间递归神经网络、长期短期记忆模型、结构递归神经网络、卷积神经网络以及一些涉及存储器组件的最新模型。

学生通过讲座和编程作业,可以掌握用神经网络解决实际问题的必备技巧。

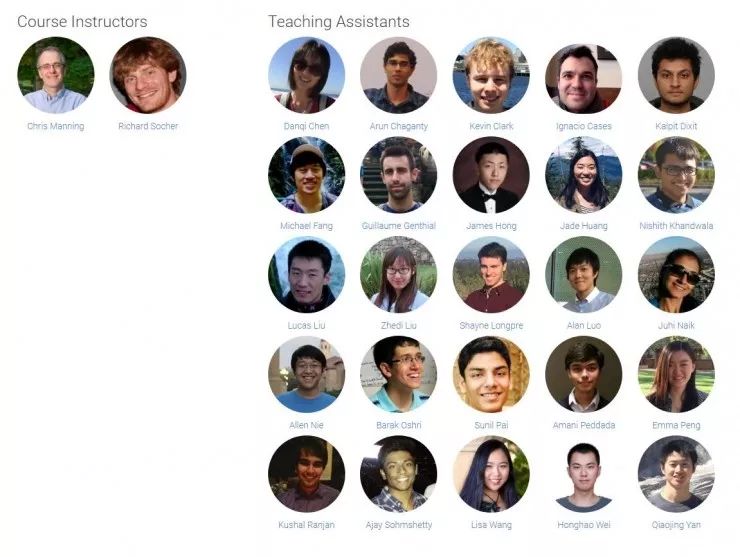

领衔主讲人是 Christopher Manning、Richard Socher

2016-2017 年版 CS224d 课程讲座,由斯坦福大学教授 Christopher Manning、Richard Socher 领衔主讲。

Christopher Manning 是斯坦福大学计算机科学和语言学系机器学习领域的首席教授。Manning 是将深度学习运用于自然语言处理的先驱,他希望能够创造出能够智能处理、理解、生成人类语言材料的计算机。同时,Manning 还是国际计算机学会( ACM )、国际人工智协会( AAAI )、国际计算语言学会(ACL)等国际权威学术组织的会士,曾获 ACL、 EMNLP 、 COLING 、CHI 等国际顶会最佳论文奖。

领衔主讲人 Christopher Manning

Richard Socher 是 Salesforce 的首席科学家,也是斯坦福大学计算机科学系的兼职教授。2016年曾担任被 Salesforce 收购的 MetaMind 的创始人兼首席执行官兼首席技术官。

主讲人 Richard Socher

CS224d ( 2016-2017 ) 原版授课团队

学习 CS224d 的必备知识

熟练掌握 Python

所有课堂作业将在 Python 中(使用 Numpy 和 Tensorflow)。这里有一个教程,用于那些不熟悉 Python 的人。如果你有很多编程经验,但使用不同的语言(例如 C / C ++ / Matlab / Javascript ),可能会更好。

大学微积分、线性代数

你应该会求导数,也了解矩阵向量运算与符号。

基本概率和统计

你应该知道概率、高斯分布、均值、标准差等基本知识。

机器学习基础

我们会用梯度下降制定成本函数、求导数及执行优化。CS221 或 CS229 都会涵盖这些内容。掌握一些凸优化知识,优化技巧将会更直观。

课程大纲

第一讲 - NLP和深度学习入门

第二讲 - 词向量表示: word2vec

第三讲 - 高级词向量表示

第四讲 - Word Window 分类与神经网络

第五讲 - 反向传播和项目建议

第六讲 - 依存分析

第七讲 - TensorFlow入门

第八讲 - RNN和语言模式

第九讲 - 机器翻译和高级循环神经网络 LSTMs 和 GRUs

第十讲 - 神经机器翻译和注意力模型

第十一讲 - GRU 及 NMT 的其他议题

第十二讲 - 语音处理的端对端模型

第十三讲 - 卷积神经网络

第十四讲 - 树 RNN 和短语句法分析

第十五讲 - 共指解析

第十六讲 - 用于回答问题的动态神经网络

第十七讲 - NLP 的问题和可能性架构

第十八讲 - 应对深度 NLP 的局限性

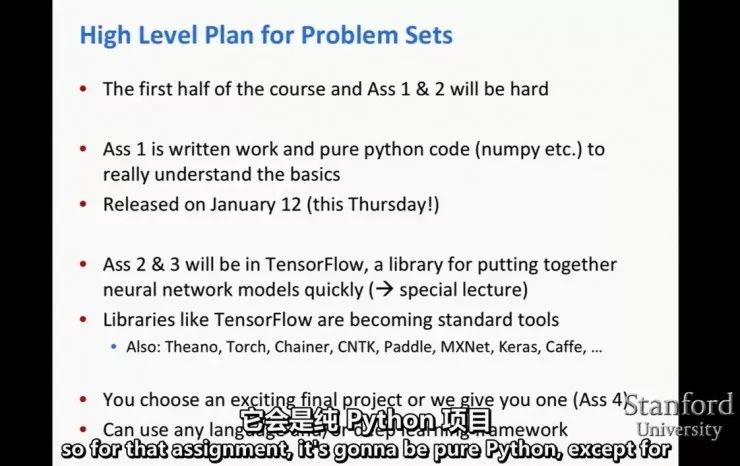

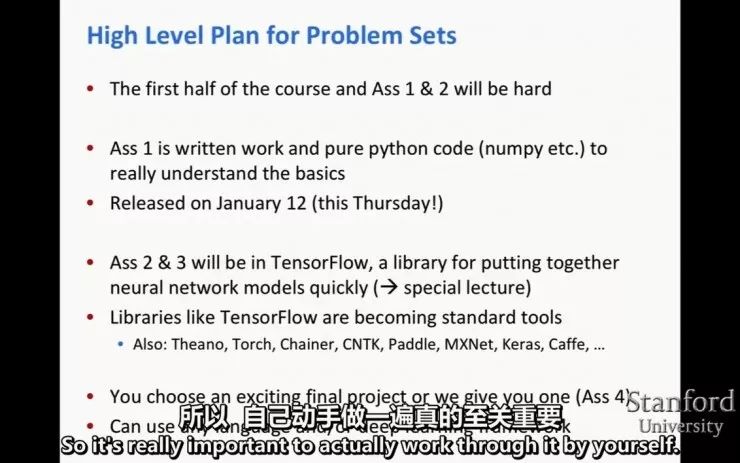

课后作业

作业1:在这个任务中,我们将熟悉神经网络,词向量及其在情绪分析中的应用的基本概念。

作业2:在本作业中,您将学习 TensorFlow 的基础知识,使用 TensorFlow 为基于转换的依赖性分析实现前馈神经网络,并通过计算递归神经网络语言模型的渐变深入研究反向传播。

作业3:在本作业中,您将学习关于命名实体识别和实现基线窗口模型以及循环神经网络模型。该任务还涵盖门控周期性单位,将其应用于简单的一维序列和命名实体识别。

作业4:自己动手一个终极项目。

值得注意的是,CS224d 中英字幕课程也会放出课后作业和项目练习。

CS224d ( 2016-2017 ) 作业概览

同时,为了提高用户的学习效果,在持续几个月的课程期间,雷锋字幕组联合 AI 慕课学院将安排 NLP 领域专家直播为学员答疑解惑。

CS224d ( 2016-2017 ) 作业概览

感兴趣且有梯子的小伙伴可以戳这里:

http://web.stanford.edu/class/cs224n/archive/WWW_1617/index.html

斯坦福大学「CS224d:深度自然语言处理课程」中英字幕版:

http://www.mooc.ai/course/494

想阅读更多AI视频?

欢迎点击“阅读原文”

或者移步 AI 研习社社区~