【深度】伯克利发布目前最大规模、内容最具多样性的高质量标注公开驾驶数据集BDD100K

来源:将门创投

原文链接:http://bair.berkeley.edu/blog/2018/05/30/bdd/

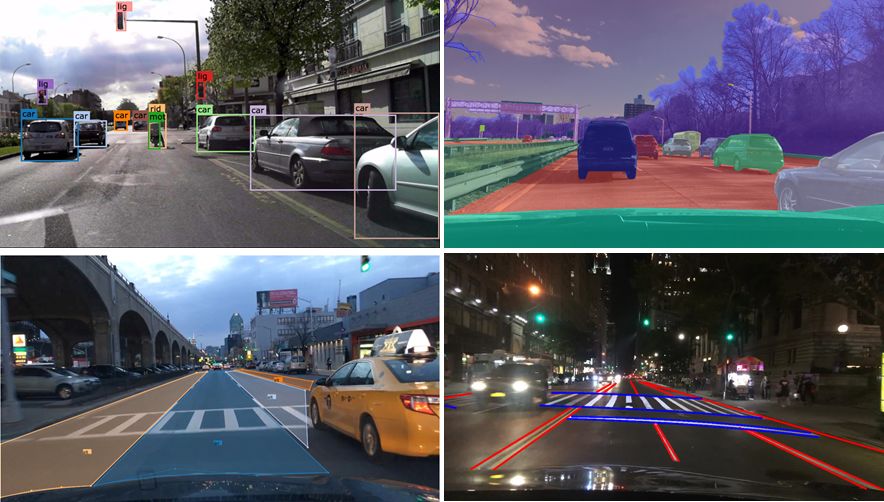

近日,UC Berkeley大学AI实验室(BAIR)发布了目前最大规模、内容最具多样性的高质量标注公开驾驶数据集BDD100K,其中包含了100k段超过1100小时的高清驾驶视频数据、100k张标记二维边框的道路目标检测数据、10k幅实例分割数据、100k张可行驶区域数据、以及100k张车道线标记数据。数据库翔实丰富,覆盖了不同的时间、光照、天气和地理位置,甚至包含了GPS和IMU以及对应的时间戳信息。

相信新数据集的发布将会为自动驾驶领域带来更好的benchmark,训练出性能更强大的算法。接下来就让我们一起深入了解这一强大的数据集。

1. 大规模多样性的驾驶视频数据

毫无疑问自动驾驶将会极大地改变我们的生活方式,但是从最近发生的相关事件来看我们还不清楚如何利用人造的感知系统在真实世界中避免一些在我们人类看来十分明显的错误。计算机视觉领域对于研发用于自动驾驶的前沿算法有着浓厚的兴趣。但为了设计和测试算法,我们需要通过真实的驾驶平台收集的数据来帮助我们进行研发。数据集一般需要满足一下四个方面的要求:大规模、多样性、在道路上获取并包含时间信息。其中数据的多样性对于验证感知算法的鲁棒性十分关键。然而目前的公开数据集并没有完全覆盖上述特性。

为了弥补其中的不足提供更加完善的数据,在智能驾驶app公司Nexar的帮助下,伯克利发布了全新的驾驶数据集——Berkeley DeepDerive(BDD100k)数据集。它是目前计算机视觉领域最大最具多样新的自动驾驶公开数据集。这一工作在伯克利DeepDrive组织和资助下得以完成。

这一数据集包含了100k视频片段,每一片段长度为40秒、分辨率为720p帧率为30fps。同时由于数据来自智能app,所以同时包含了当时的GPS/IMU数据以及相应的时间戳。这可以使得研究人员获取车辆粗略的轨迹信息,这对于学习驾驶策略十分有用。为了使得数据库更具多样性,视频数据主要从美国的四个主要城市和地区收集。

同时数据集的多样性还涵盖了不同的天气和光照状况,包含了不同的天气状况(晴天、阴天、雨天)、一天中不同的时间段和夜晚时段。下表显示了BDD100k数据集与其他数据集的比较结果:

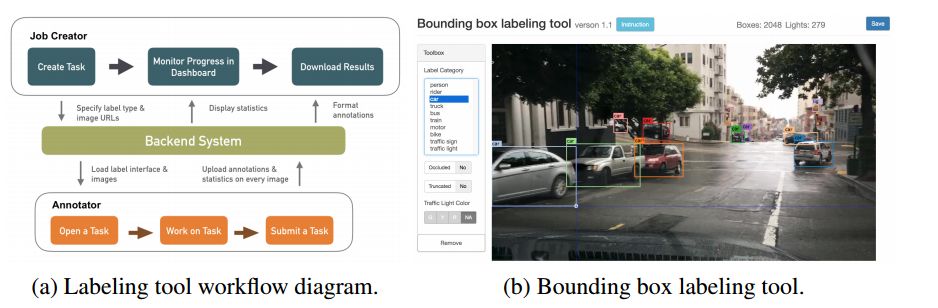

2. 标 注

数据集中还提供了关键帧的详细标注。数据集以每段视频的第十秒帧作为关键帧,并在不同层次上对其进行了标注,包括:图像标签、道路对象边界框、可行驶区域、车道线以及完整的实例分割标注。这些标注将会帮助我们更好的理解数据的多样性以及在不同场景下的目标统计信息。

值得一提的是,为了进行高效的标注这一团队还研发了一套大规模的标注系统,为大规模的驾驶数据提供了综合全面的标注信息。

3. 道路目标检测

为了了解道路上目标的分布和位置,这一数据集提供100k幅关键帧中物体的边框标注,下图显示了道路中常见的物体及其统计数据量。除此之外,人们可以对不同天气状况或者不同场景下的道路目标进行统计。下图同时显示了数据集中目标的多样性和规模性,其中汽车就超过了100万个样本。并且这些样本都是具有不同纹理和外观的明显区别的。

同时这一数据集也适合研究某些具体领域的问题,例如如果你对检测和规避路上的行人感兴趣、你可以利用这一数据集中丰富的标注来完成这一工作。

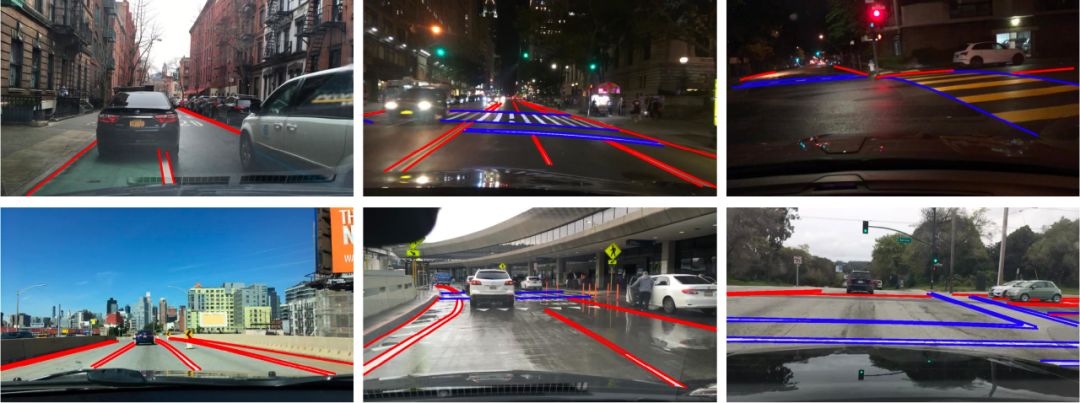

4. 车道线

车道线对于人类来说是重要的参考物,同样对于自动驾驶来说车道线为行驶方向和位置提供了重要的参考,特别是在GPS和地图不够精确的时候。在这一数据集中,研究人员将道路标志分为了两类,一类是沿着行进方向的车道线、另一类是人行横道线,对于车道线还分别标注了虚线、实线和双实线属性。

下表描述了与相关数据集的比较结果:

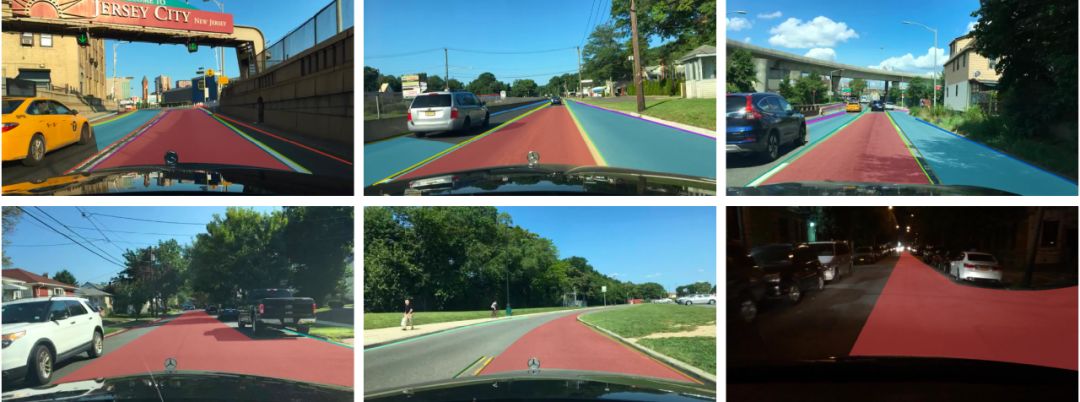

5. 可通行区域

在路上安全行驶不仅仅依赖于车道线和交通灯,它同样还依赖于与其他交通参与者共同分享使用道路。所以理解哪些地方是可行驶区域是十分重要的。为了研究这一问题,BDD100K提供了下图所示的可行驶区域标注,根据车辆的轨迹将其分为了直接可通行区域和可选择的通行区域两部分。下图中红色部分为直接可行驶区域,这意味着车在这一区域拥有道路优先权可以保持行驶,而蓝色的备选区域意味着车辆可以行驶但需要十分小心,注意其他拥有道路优先权的车辆。

6. 全图分割标注

已有研究表明在城市中数据集中的全幅细粒度的图像分割标注能大大提高密集预测与目标检测的表现、大大提高了计算机视觉应用的能力。由于目前的数据集覆盖了不同的领域,通过提供实例分割标注有助于比较不同领域数据集的迁移表现。对于精确的像素级的标注工作十分庞大,但利用研发的标注系统,减小了50%的工作量。最终实现了10k全幅的细粒度实例分割数据。这一数据集的标签兼容Cityscapes数据集,对于研究不同数据集间的域差别(domain shift)更为容易。

7. 比赛

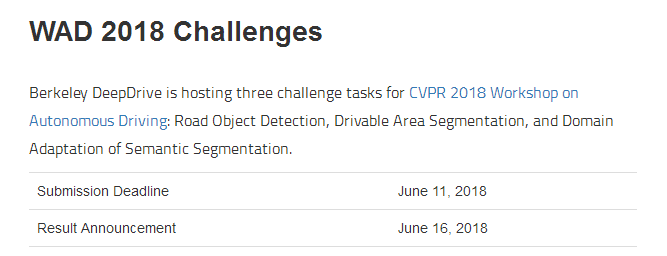

在这些数据集的基础上,今年的CVPR自动驾驶研讨会中举办了3个挑战赛,分别是道路目标检测、可行驶区域预测、以及基于语义分割的领域适应性。最后的领域迁移测试数据集来自于中国,这意味着利用美国数据训练出的模型需要在北京的道路上也能正常工作。好消息是目前比赛还没有结束。

看完数据集想试试的小伙伴可以登录:

http://bdd-data.berkeley.edu/login.html

开始比赛,并在这里找到有用的代码:

https://github.com/ucbdrive/bdd-data

8. 未来的工作

目前数据集只包含了单目数据,但自动驾驶的感知系统同时还有丰富的立体和全景数据,以及大量的激光雷达数据,未来的数据集将会考虑整合这些多模态数据,为研究人员提供更为完善的信息。

温馨提示:在数据集的注册页面上注册激活就可以下载数据了。但数据较大video:1833.92G,segmentation:1.22G,Driverable:660.93M,iamge:6.64G),做好心理准备。

DataSet:http://bdd-data.berkeley.edu/index.html

https://www.getnexar.com/

https://blog.getnexar.com/

更多参考:DeepDrive:https://deepdrive.berkeley.edu/

数据集详细技术报告:https://arxiv.org/abs/1805.04687

-The End-

☞【学界】OpenPV:中科院研究人员建立开源的平行视觉研究平台

☞【征稿通知】IEEE IV 2018“智能车辆中的平行视觉”研讨会

☞【征稿】神经计算专刊Virtual Images for Visual Artificial Intelligence

☞【学界】ParallelEye:面向交通视觉研究构建的大规模虚拟图像集

☞【CFP】Virtual Images for Visual Artificial Intelligence

☞【最详尽的GAN介绍】王飞跃等:生成式对抗网络 GAN 的研究进展与展望

☞【智能自动化学科前沿讲习班第1期】王飞跃教授:生成式对抗网络GAN的研究进展与展望

☞【智能自动化学科前沿讲习班第1期】王坤峰副研究员:GAN与平行视觉

☞【重磅】平行将成为一种常态:从SimGAN获得CVPR 2017最佳论文奖说起

☞【学界】CVPR 2018 | 牛津大学&Emotech首次严谨评估语义分割模型对对抗攻击的鲁棒性