真假难辨,AI就能分得清?

常言道,耳听为虚,眼见为实。但随着人工智能技术的发展,眼见可不一定为实。其背后的技术被称作深度伪造技术,简称深伪技术或者深度伪造,是Deep Learning(深度学习)和Fake(伪造)的混成词,一种基于人工智能的人体图像合成技术,该技术的扩散与发展,引起了人们的担忧。

2018年,英伟达研究人员利用生成对抗网络算法生成了非真人照片,该算法让两个神经网络互相对抗,其中A试图发现假货,B则试图生成更逼真的假货来骗过A。它俩可以像用为所欲为玩成语接龙一样,一直不停。也就意味着,只要有足够的时间,GANs可以生成一个比真人更像真人的假货。

随着人工智能生成人体图像的能力大大提高,也带来了一些不好的影响。骗子能利用这些生成的假货欺骗人们,在不经本人同意的情况下将人脸拼接到色情电影中去,以此来满足个别变态的欲望,甚至破坏了人们对在线媒体的信任。而且生成的假照片,比真人照片更容易取得人们的信赖。虽然利用人工智能本身有可能发现深度伪造,但由于科技公司没能有效的调节那些复杂的材料,因此这条路走不通。

还有一个更重要的问题是人类能否发现假人照片和真人照片之间的差异,以及它们与深度伪造有什么关联。PNAS上的一项研究结果显示,情况并不可观,人们发现假照片的能力还没有随机猜测的准确率高,而且他们觉得捏造的面孔比真实的面孔更值得信赖。该研究报告的作者写道:”我们对人工智能合成的面孔的逼真度的评估表明,合成引擎已经达到了堪称不可思议的地步,能够创造出无法区分的面孔,而且比真实面孔更值得信任。”

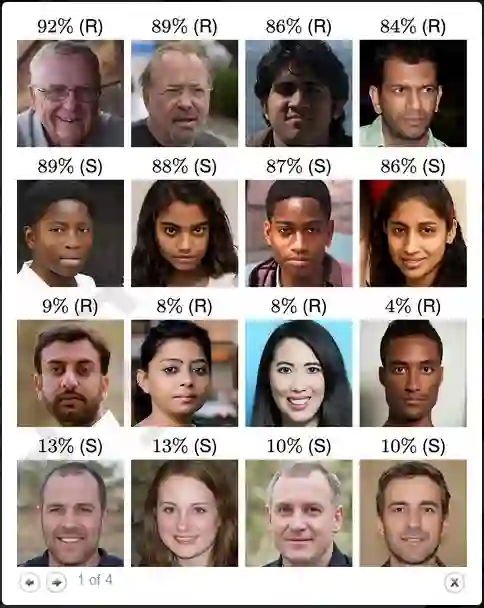

图片来源PANS,部分人脸照片分辨的准确率(S代表合成,R代表真人)

为了测试对假脸的反应,研究人员使用了Nvidia的GAN的更新版本来生成400张假脸,其中性别比例相同,四个种族群体各100张。黑人、高加索人、东亚人和南亚人。他们将这些面孔与从最初用于训练GAN的数据库中提取的真实面孔进行匹配,这些面孔被不同的神经网络判定为相似。

然后他们从亚马逊Mechanical Turk众包平台上招募了315名参与者。每个人被要求从合并的数据集中判断128张脸,并决定它们是否是假的。而最后他们的准确率只有48%,比从随机猜测中获得的50%的准确率还要低。

深度伪造出来得假照往往有特征性的缺陷和故障,可以帮助人们将其识别出来。因此,研究人员对另外219名参与者进行了第二次实验,在让他们判断相同数量的面孔之前,对他们进行了一些基本训练,告诉他们应该注意什么。可结果是,他们的表现只略有改善,达到59%,只提高了11%。

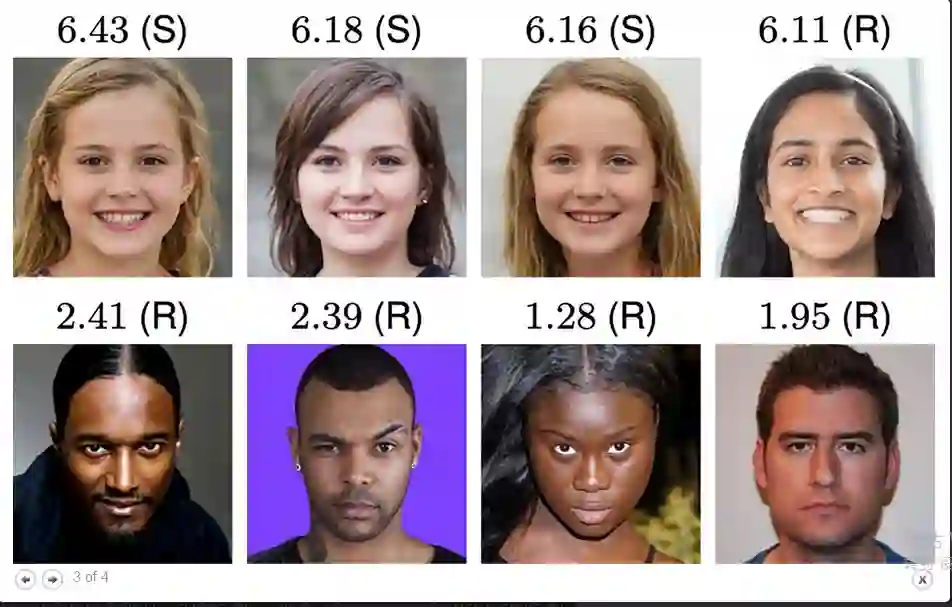

在最后一个实验中,研究小组决定看看对人脸直觉反应是否能提高准确率。人们通常在一瞬间会根据自己的第一直觉来确定难以判断的东西。而对于人脸,可信度无疑是人们判断一个人的第一反应。但是,当另外223名参与者对128张面孔进行可信度评分时,研究人员发现,人们对于假脸的可信度评价比真脸的可信度评价居然高出8%,这个差异不大,但是具有重要的统计学意义。

研究人员发现,假脸之所以看起来比真脸更可信的原因是,假脸往往看起来更像是一张普通人的面孔,而热门往往更信任普通人的脸,尤其是那种看起来人畜无害的脸更能博取人们的信任。通过观察四张最不值得信任的面孔(都是真的)和三张最值得信任的面孔(都是假的),这一点得到了证实。

图片来源PANS,信任度评分为1-7分,可信度越高评分越高

这个研究指出,那些开发深度伪造技术背后的基础技术的人需要认真的思考一下自己在做什么。要好好地问自己,该技术的带来的好处是否已经超过了它带来的风险。该行业还应该认真的考虑简历一些保障措施,比如让利用该技术造价的人,输出的照片中会出现水印等。该研究报告的作作者表示:由于这一强大技术的使用对人们的生活造成了重大的威胁,我们应该认真的考虑下公开和无限制的深度伪造代码可被任何人随意纳入任何程序的做法,是不是应该加入一些限制。但不幸的是,现在可能已经太晚了。公开的模型已经能够产生非常真实的深度伪造照片,而且我们想把模型收回也不太可能了。

任何技术都是双刃剑,准确来说任何科技都是双刃剑,一项开发者想用来造福人类的技术,被一个心里充满恶念的人拿到,就有可能造成不可逆转的恶果。我想这应该引发人们的思考,一些可能会被拿来作恶的代码或技术真的可以毫无限制的开放吗?当然这是笔者的个人看法,欢迎大家讨论。

参考链接:https://singularityhub.com/2022/02/21/people-trust-deepfake-faces-more-than-real-ones-study-finds/

《新程序员001-004》全面上市,对话世界级大师,报道中国IT行业创新创造

☞