强化学习常用算法+实际应用 ,必须get这些核心要点!

新智元报道

【新智元导读】强化学习(RL)是现代人工智能领域中最热门的研究主题之一,其普及度还在不断增长。本文介绍了开始学习RL需要了解的核心要素。戳右边链接上 新智元小程序 了解更多!

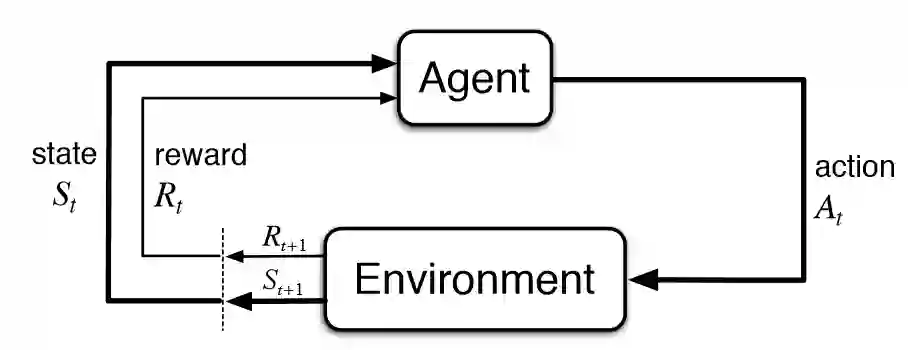

环境-智能体在其中运行的物理状态

状态-智能体的当前状况

奖励-来自环境的反馈

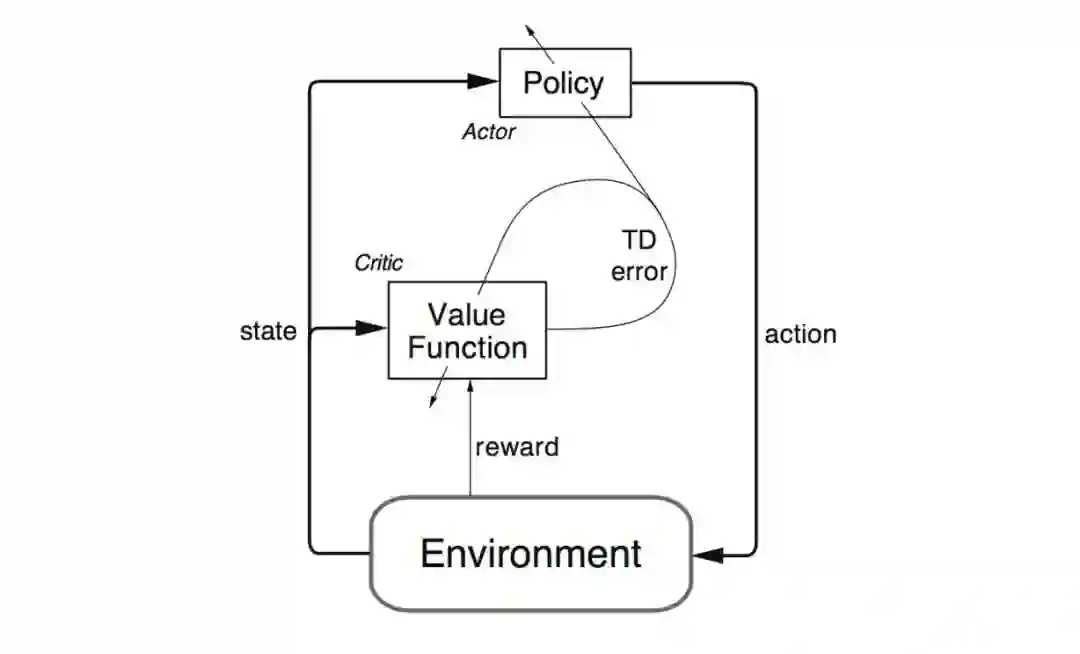

策略-映射智能体状态到动作的方法

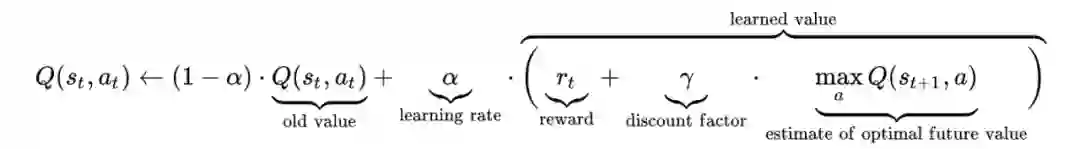

值-智能体在特定状态下采取的行动将获得的未来奖励

登录查看更多

相关内容

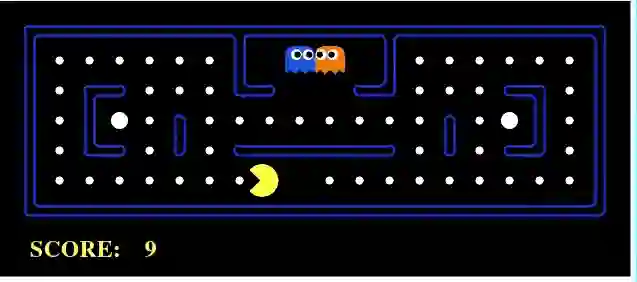

强化学习(RL)是机器学习的一个领域,与软件代理应如何在环境中采取行动以最大化累积奖励的概念有关。除了监督学习和非监督学习外,强化学习是三种基本的机器学习范式之一。

强化学习与监督学习的不同之处在于,不需要呈现带标签的输入/输出对,也不需要显式纠正次优动作。相反,重点是在探索(未知领域)和利用(当前知识)之间找到平衡。

该环境通常以马尔可夫决策过程(MDP)的形式陈述,因为针对这种情况的许多强化学习算法都使用动态编程技术。经典动态规划方法和强化学习算法之间的主要区别在于,后者不假设MDP的确切数学模型,并且针对无法采用精确方法的大型MDP。