【NeurIPS2020】无限可能的联合对比学习

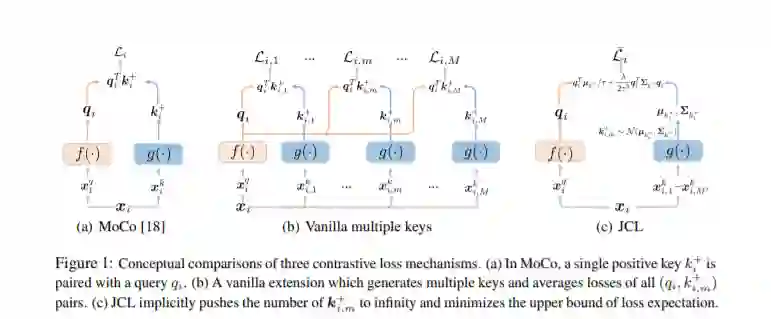

本文通过新的概率建模方法,对对比学习的最新发展进行了有益的改进。我们推导了一种特殊形式的对比损失,称为联合对比学习(JCL)。JCL隐含地涉及到同时学习无限数量的查询键对,这在搜索不变特征时带来了更严格的约束。我们推导了这个公式的上界,它允许以端到端训练的方式进行解析解。虽然JCL在许多计算机视觉应用程序中实际上是有效的,但我们也从理论上揭示了控制JCL行为的某些机制。我们证明,提出的公式具有一种内在的力量,强烈支持在每个实例特定类内的相似性,因此在搜索不同实例之间的区别特征时仍然具有优势。我们在多个基准上评估这些建议,证明了对现有算法的相当大的改进。代码可以通过以下网址公开获得

https://github.com/caiqi/Joint-Contrastive-Learning

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“JCL” 可以获取《【NeurIPS2020】无限可能的联合对比学习》专知下载链接索引

登录查看更多

相关内容

Arxiv

1+阅读 · 2020年12月2日