DARPA《可解释人工智能》概述

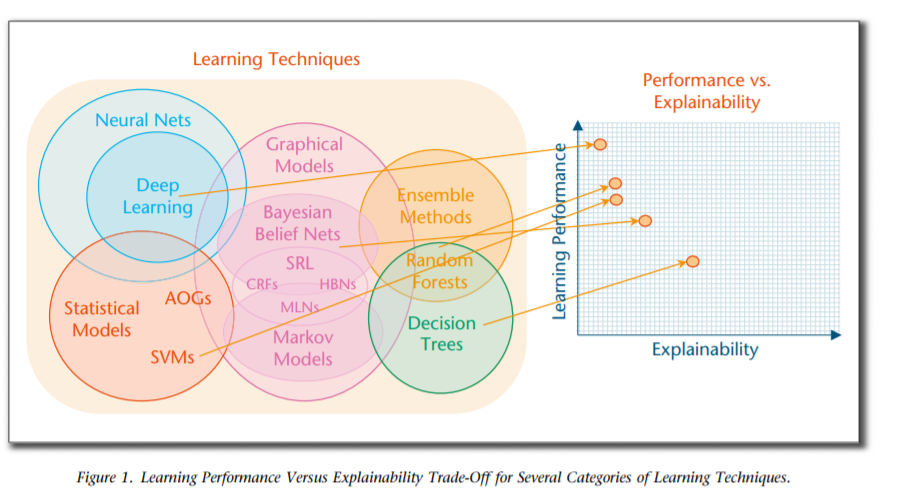

机器学习的巨大成功导致了AI应用的新浪潮(例如,交通、安全、医疗、金融、国防),这些应用提供了巨大的好处,但无法向人类用户解释它们的决定和行动。DARPA的可解释人工智能(XAI)项目致力于创建人工智能系统,其学习的模型和决策可以被最终用户理解并适当信任。实现这一目标需要学习更多可解释的模型、设计有效的解释界面和理解有效解释的心理要求的方法。XAI开发团队正在通过创建ML技术和开发原理、策略和人机交互技术来解决前两个挑战,以生成有效的解释。XAI的另一个团队正在通过总结、扩展和应用心理解释理论来解决第三个挑战,以帮助XAI评估人员定义一个合适的评估框架,开发团队将使用这个框架来测试他们的系统。XAI团队于2018年5月完成了第一个为期4年的项目。在一系列正在进行的评估中,开发人员团队正在评估他们的XAM系统的解释在多大程度上改善了用户理解、用户信任和用户任务性能。

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“多模态情绪” 可以获取《DARPA可解释人工智能》专知下载链接索引

登录查看更多

相关内容

一个可以解释的AI(Explainable AI, 简称XAI)或透明的AI(Transparent AI),其行为可以被人类容易理解。它与机器学习中“ 黑匣子 ” 的概念形成鲜明对比,这意味着复杂算法运作的“可解释性”,即使他们的设计者也无法解释人工智能为什么会做出具体决定。 XAI可用于实现社会解释的权利。有些人声称透明度很少是免费提供的,并且在人工智能的“智能”和透明度之间经常存在权衡; 随着AI系统内部复杂性的增加,这些权衡预计会变得更大。解释AI决策的技术挑战有时被称为可解释性问题。另一个考虑因素是信息(信息过载),因此,完全透明可能并不总是可行或甚至不需要。提供的信息量应根据利益相关者与智能系统的交互情况而有所不同。

https://www.darpa.mil/program/explainable-artificial-intelligence

Arxiv

4+阅读 · 2020年2月27日

Arxiv

4+阅读 · 2018年2月19日