AAAI 2020 最新“可解释人工智能 XAI”教程

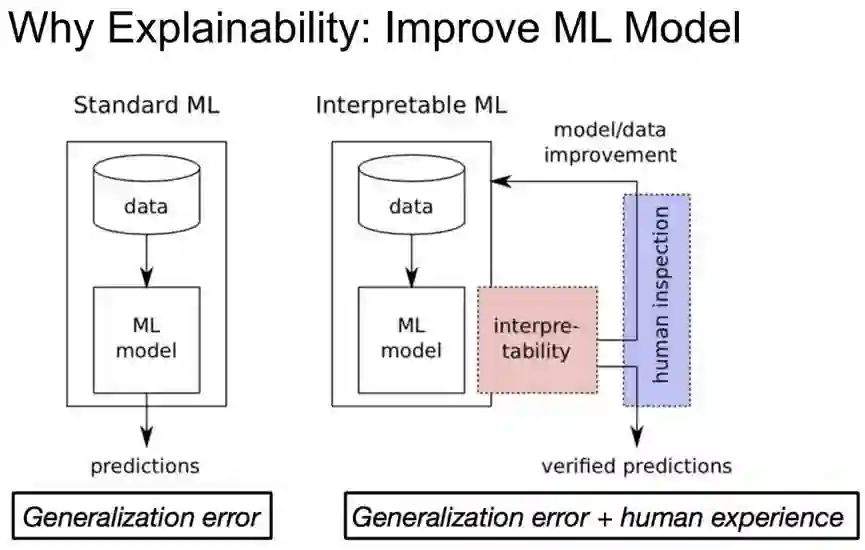

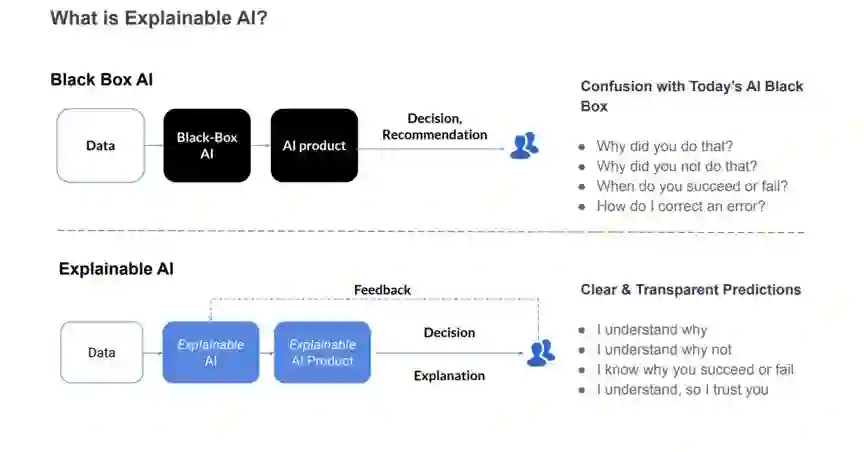

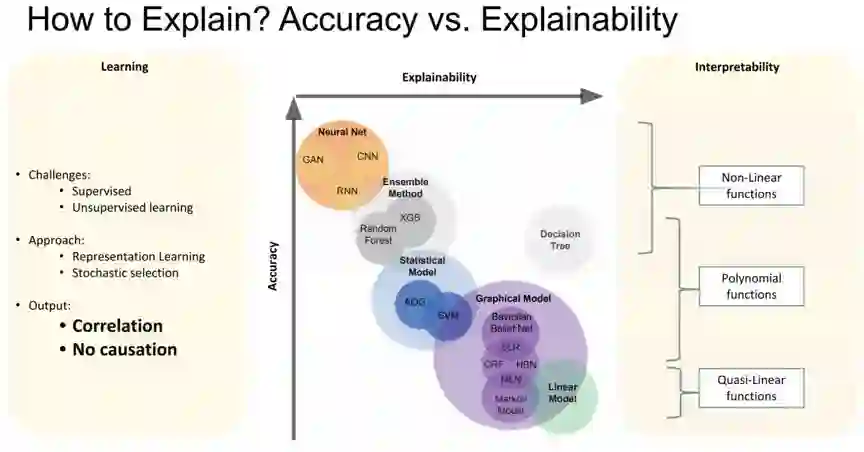

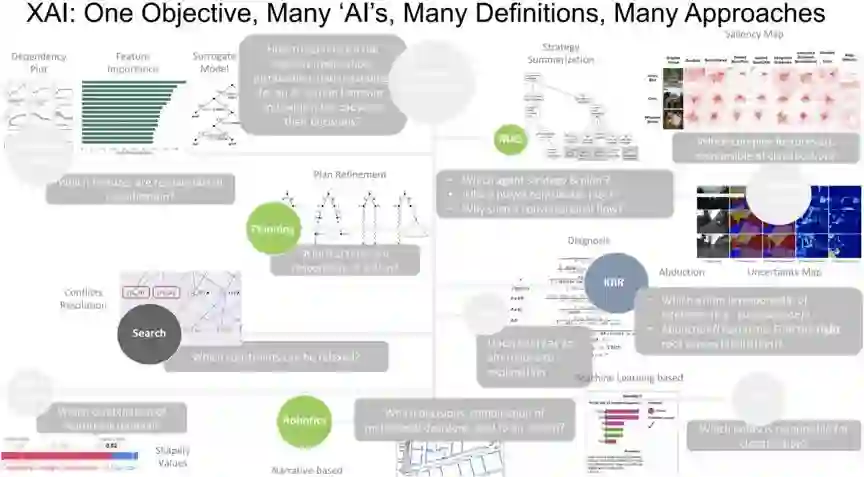

什么是可解释的 AI(XAI)?

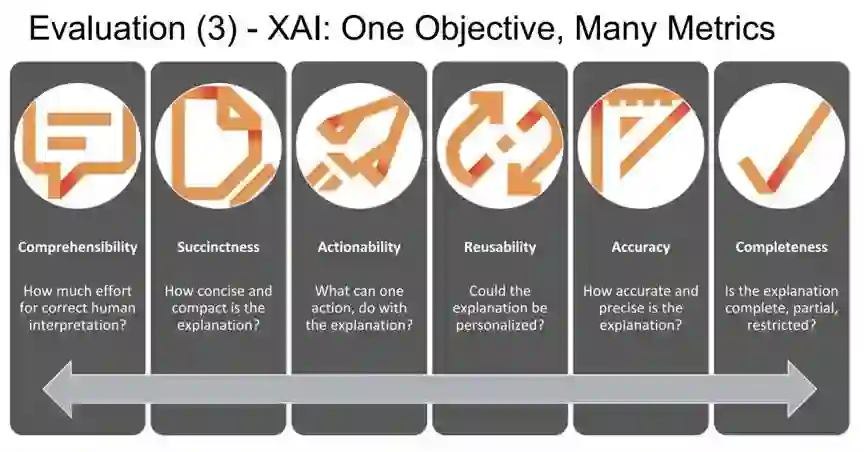

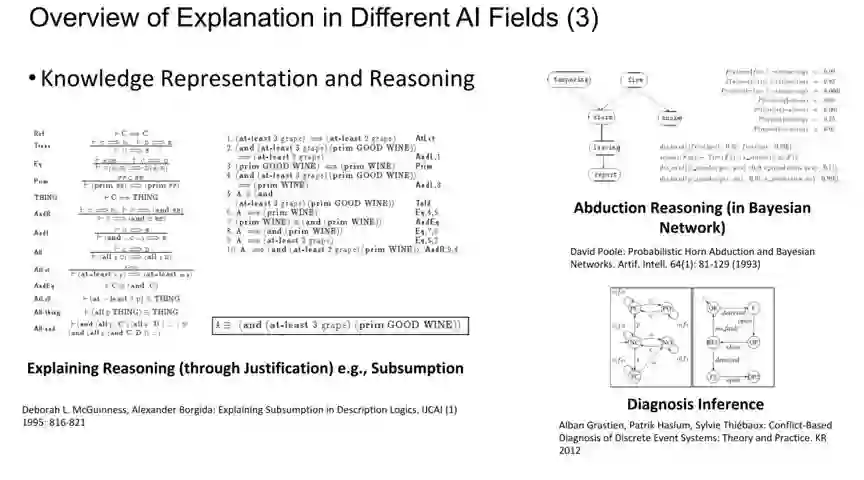

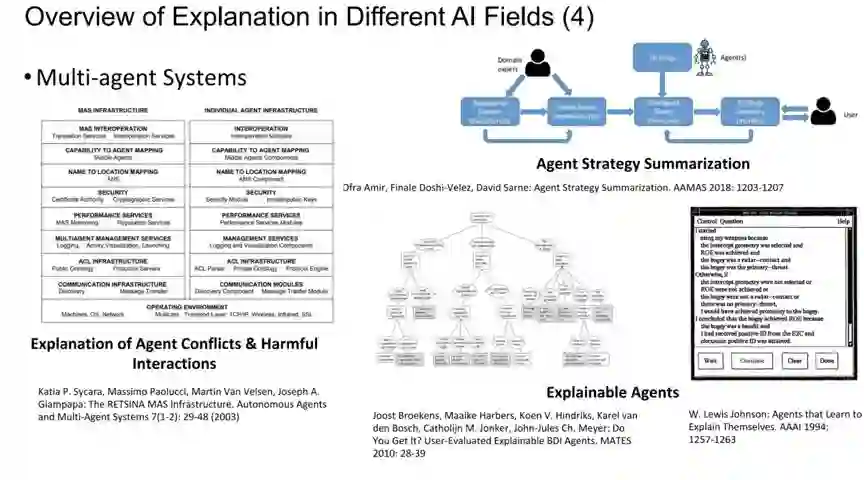

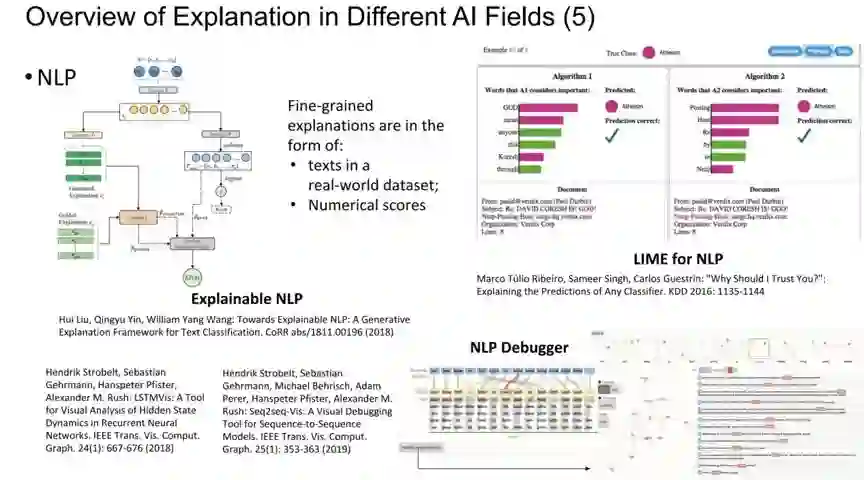

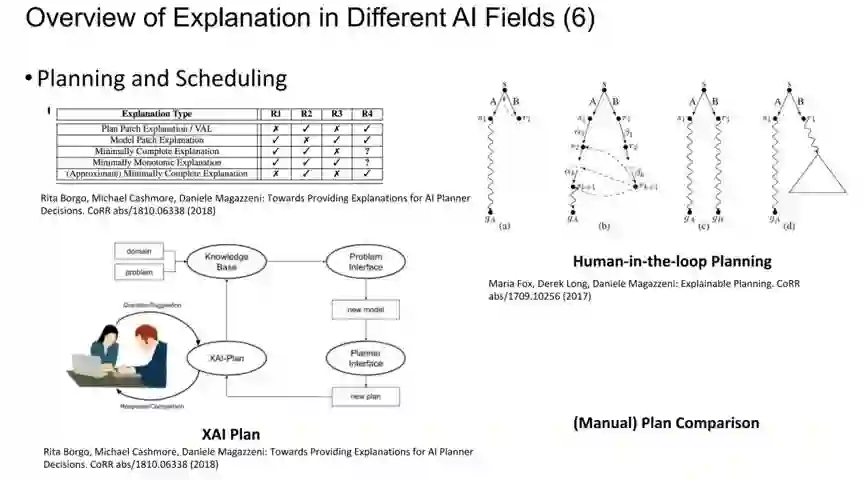

什么是可解释的 AI(Explainable AI,简称 XAI)?来自 AI 社区(机器学习、逻辑学、约束编程、诊断)的各种流的解释是什么?解释的指标是什么?

我们为什么要关心?

为什么可解释的 AI 重要?甚至在某些应用中至关重要?AI 系统的动机是什么?

哪里是关键?

大规模部署 AI 系统时,真正需要解释的实际应用是什么?

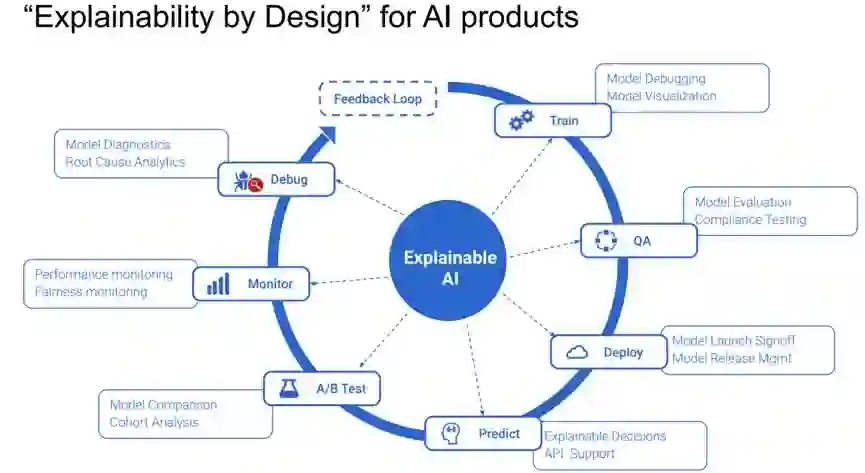

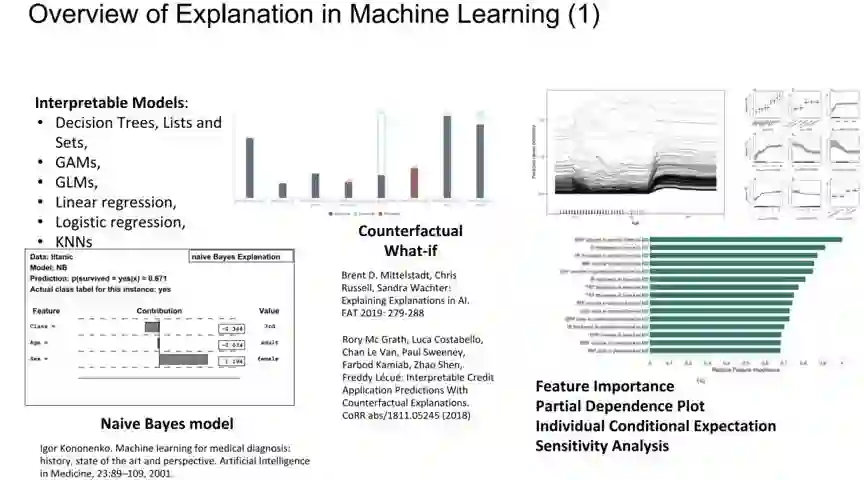

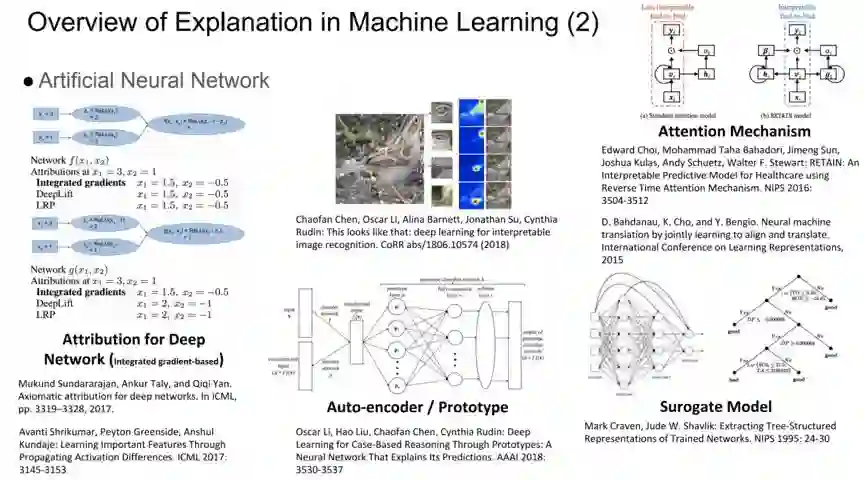

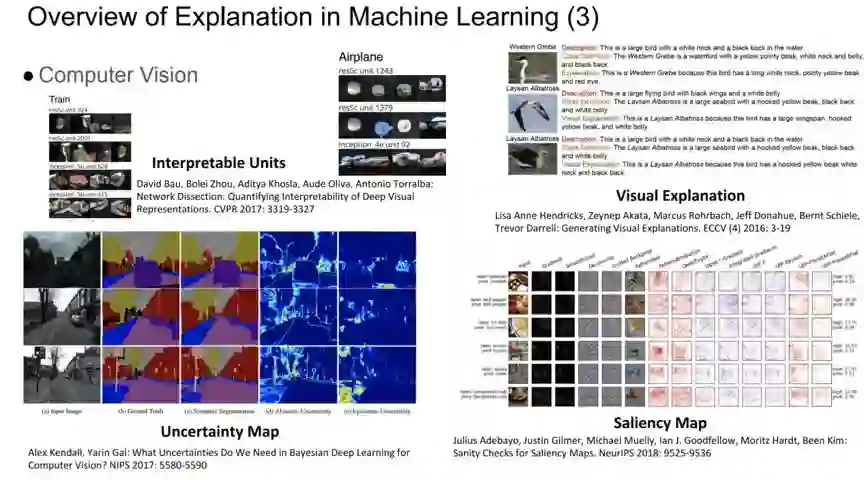

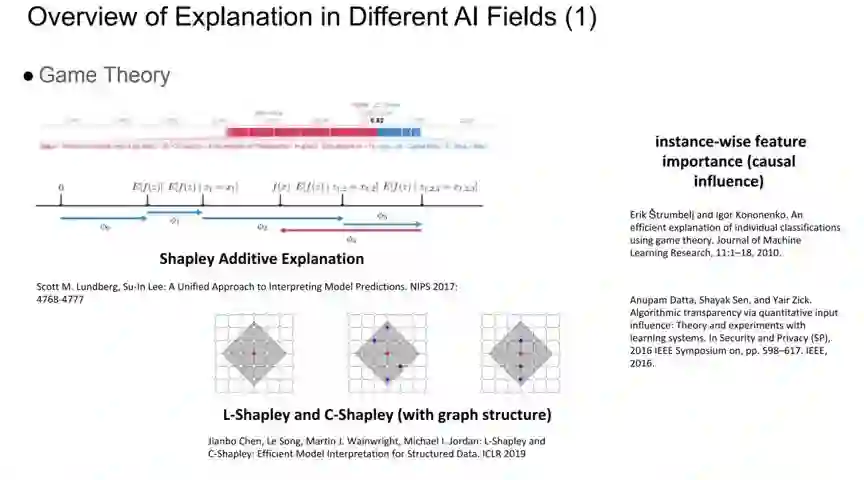

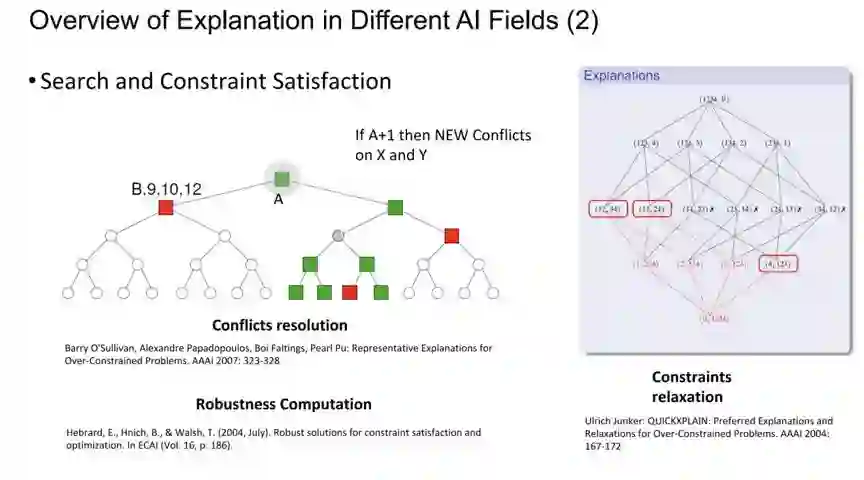

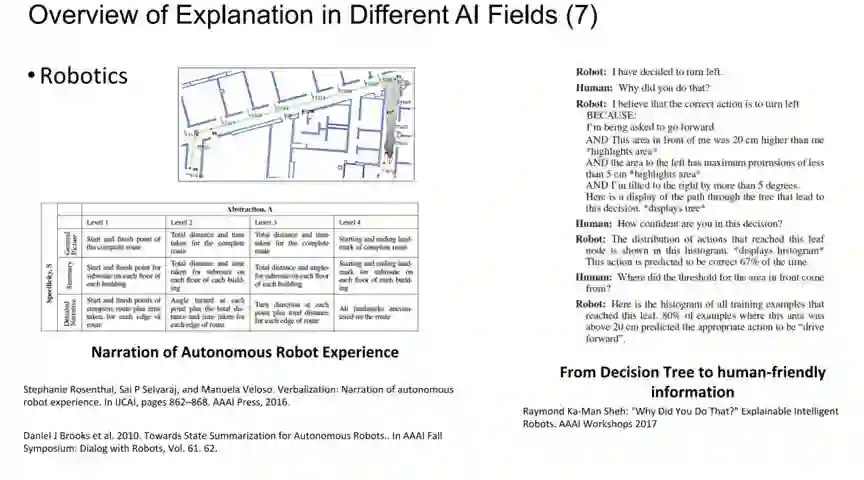

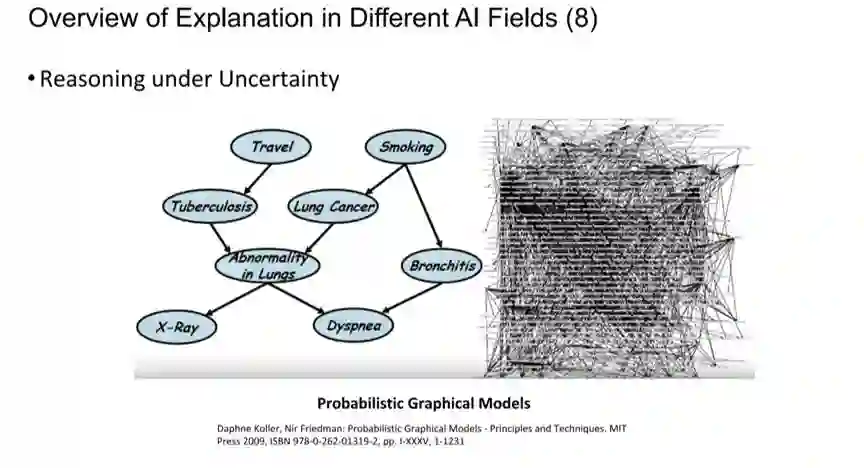

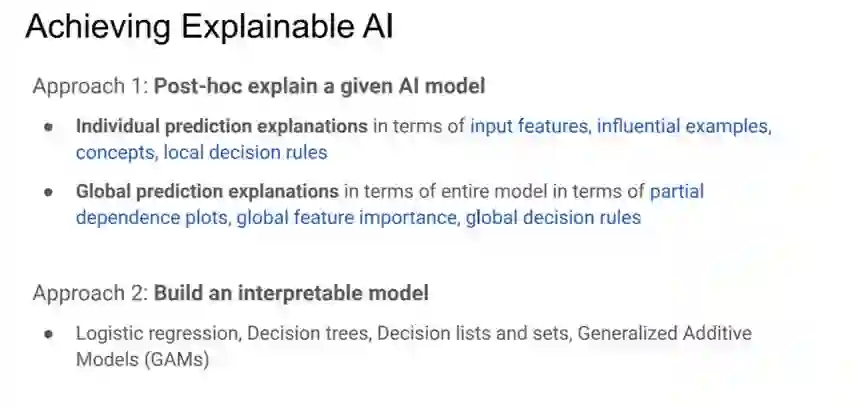

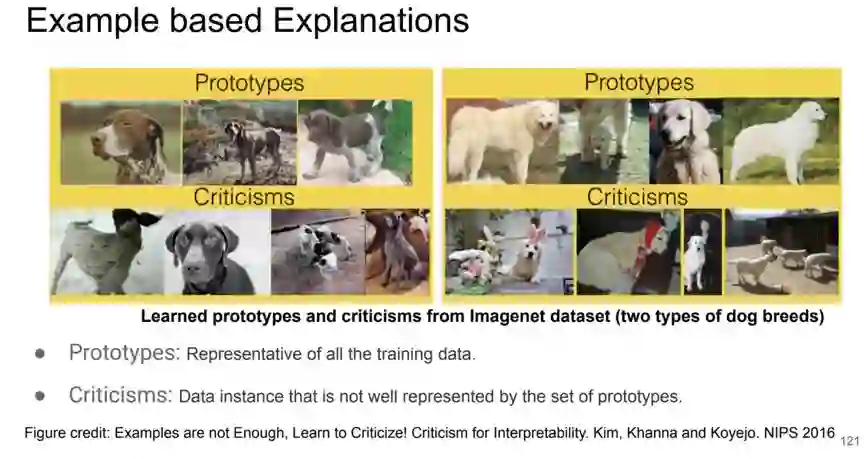

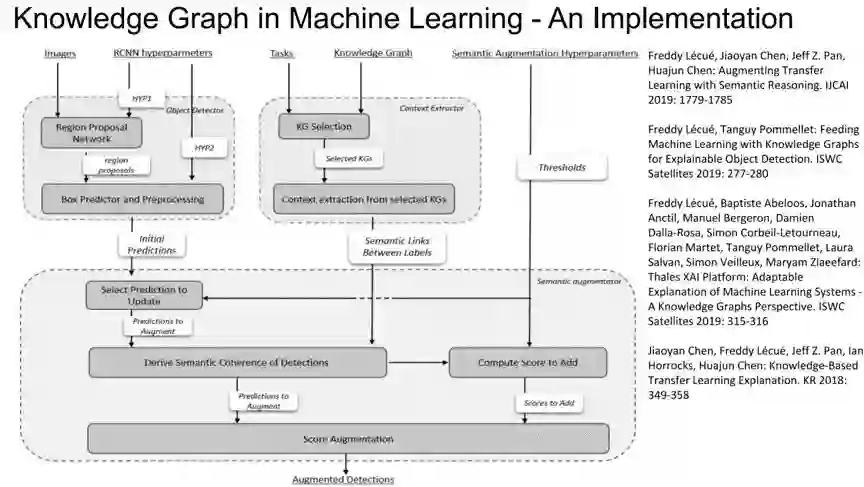

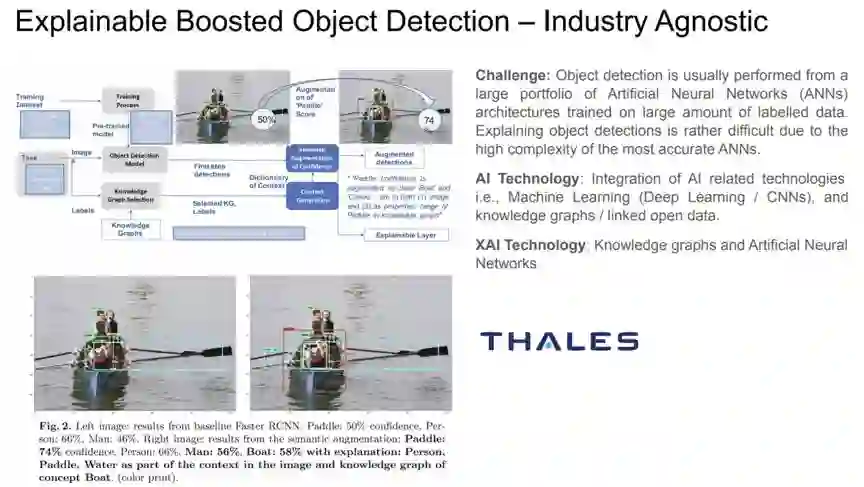

它是如何工作的?

在计算机视觉、自然语言处理方面,最先进的解释技术是什么?对于哪种数据格式、用例、应用程序、行业,什么是有效的,什么是无效的?

我们学到了什么?

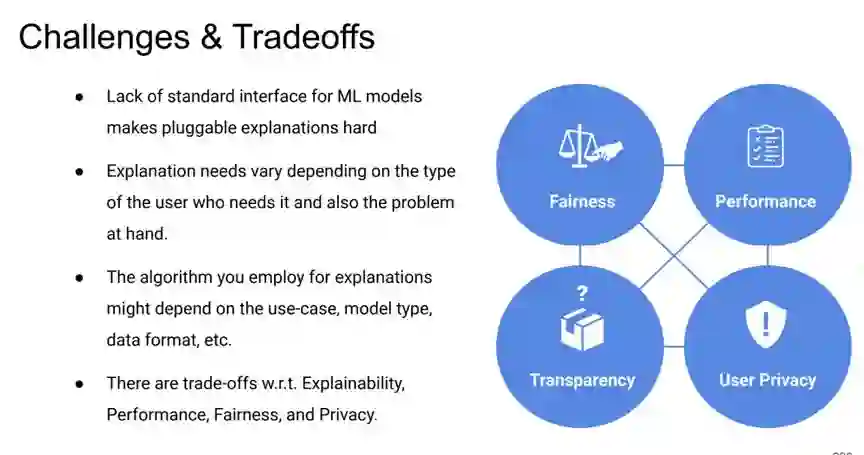

部署现有 XAI 系统的经验教训和局限性是什么?向人类传达解释?

下一步是什么?

XAI 的未来前景如何?

登录查看更多

相关内容

Arxiv

4+阅读 · 2019年11月5日

Arxiv

4+阅读 · 2019年5月30日