个性化语音识别模型,帮助语言障碍人士正常交流

发布人:Google Research 软件工程师 Katrin Tomanek 和技术项目经理 Bob MacDonald

语言障碍症状影响着数百万人的生活,其产生原因很多,包括神经或遗传疾病、身体缺陷、脑损伤或听力丧失等,而由此导致的症状也各不相同,如口吃、构音障碍 (Dysarthria)、失用症 (Apraxia) 等,这些症状对患者的自我表达、社会生活参与,以及使用语音技术,都会产生不利影响。

自动语音识别 (ASR, Automatic Speech Recognition) 技术可以通过提升设备的听写和家居自动化能力以及沟通能力,来帮助语言障碍人士克服上述问题。然而,尽管随着深度学习系统计算能力的提升,以及有大型训练数据集可供使用,ASR 系统在准确率方面有所提升,但是对于许多具有语言障碍的人而言,系统的性能仍有所欠缺,导致许多本应受益良多的患者无法有效利用这项技术。

2019 年,我们推出了 Euphonia 项目,探讨如何通过个性化的识别语言障碍 ASR 模型,实现在典型语音上与通用 ASR 模型相同水平的准确率。今天我们为大家分享两项在 Interspeech 2021 上发布的研究成果,这两项研究目的在于让更多用户群体可以利用个性化 ASR 模型。在“无序语音数据集合:从 Euphonia 项目 100 万条语音中总结的经验 (Disordered Speech Data Collection: Lessons Learned at 1 Million Utterances from Project Euphonia)”中,我们介绍了一个涵盖范围广泛的无序语音数据集合,其中包含的语音数据超过 100 万条。在“自动识别无序语音:在短语方面个性化模型较人类表现更佳 (Automatic Speech Recognition of Disordered Speech: Personalized models outperforming human listeners on short phrases) ”中,我们讨论了在基于该语料库生成个性化 ASR 模型上所开展的工作。与利用典型语音训练的开箱即用的语音模型相比,这种方法可以产生准确率更高的模型,在特定的语境中,字错误率 (WER, Word error rate) 可降低高达 85% 。

Euphonia

https://blog.google/outreach-initiatives/accessibility/impaired-speech-recognition/

无序语音数据集合:从 Euphonia 项目 100 万条语音中总结的经验

https://www.isca-speech.org/archive/interspeech_2021/macdonald21_interspeech.html

自动识别无序语音:在短语方面个性化模型较人类表现更佳

https://www.isca-speech.org/archive/interspeech_2021/green21_interspeech.html

自 2019 年起,不少语障人士为支持 Euphonia 项目的研究工作提供了语音样本。他们的严重程度不同,症状也不一样。这项工作将 Euphonia 项目的语料库扩展至超过 100 万条语音,包括了来自 1330 名说话者的 1400 多小时语音记录(截至 2021 年 8 月)。

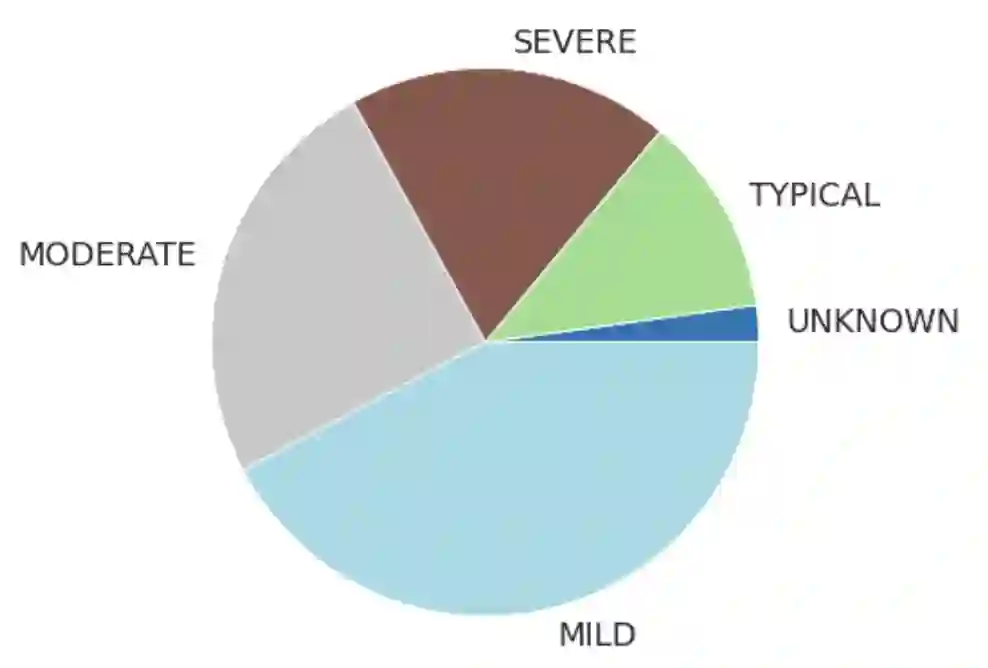

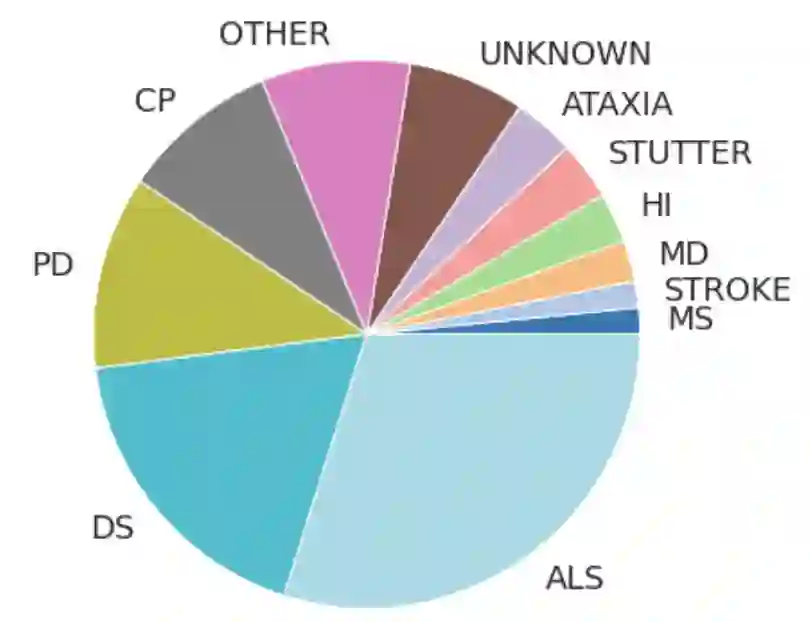

基于超过 300 条录制的语音数据,绘制出的所有说话者的语言障碍严重程度和所患病症分布图。在病症方面,仅显示患病人数超过 5 人的病症,否则统一记入“其他”以满足 k 匿名性 (k-anonymity)

ALS 代表肌萎缩性脊髓侧索硬化症;DS 代表唐氏综合症;PD 代表帕金森病;CP 代表脑瘫;HI 代表听力障碍;MD 代表肌肉萎缩症;MS 代表多发性硬化症

Euphonia 项目的研究工作

https://sites.research.google/euphonia/about/

为简化数据收集流程,参与者在笔记本电脑或者手机等个人硬件上(使用或者不使用头戴式耳机)通过家用录音系统收集语音,而不是在类似实验室这样的理想环境中收集录音棚品质的语音。

为降低转录成本,同时保持较高的转录一致性,我们优先采取了按照文本朗读的方式。参与者根据浏览器端录音工具上显示的提示语进行朗读。这些提示语涵盖家居自动化(“打开电视。”)、与看护者对话(“我饿了。”)以及非正式对话(“你好吗?你今天过得愉快吗?”)等语境。大部分参与者会朗读 1500 条提示语,其中包含 1100 个只出现一次的短语以及 100 个重复出现 4 次的短语。

语音专家在倾听每位说话者部分语音的同时,进行了全面的听觉感知和语音评估,以便根据多种为说话者分级的元数据,来判定语言障碍类型(例如口吃、构音障碍、失用症等),对如鼻音过重(Hypernasal speech)、发音失准和言语声律障碍(Dysprosody)等 24 种异常语音特征进行评定,同时对技术问题(例如信号丢失、分割问题)和声学问题(例如环境噪音、次级扬声器串扰)进行录音质量评估。

这个扩展的语音障碍数据集也是我们生成无序语音个性化 ASR 模型新方法的基础。每个定制模型都使用标准的端对端 RNN-传感器 (RNN-T) ASR 模型,该模型仅对目标说话者的数据进行微调。

RNN-传感器架构。在示例中,编码器网络由 8 层组成,而预测器网络由 2 层单向 LSTM (Long short-term memory) 单元组成

为此,我们重点调整了编码器网络,也就是模型中处理说话者特定声学数据的部分,因为语音障碍是我们语料库中最常见的现象。我们发现,只更新 8 个编码器层中最底层的 5 个,而冻结最上面的 3 个编码器层(以及连接层和解码器层),可以得到最好的结果,并能够有效避免过度拟合。为了让这些模型在处理背景噪声和其他声学效应方面更具鲁棒性,我们采用了专门针对无序语音为主要特征进行调整的 SpecAugment 配置。

SpecAugment

https://ai.googleblog.com/2019/04/specaugment-new-data-augmentation.html

我们训练了约 430 名说话者的个性化 ASR 模型,他们每人至少录制了 300 条语音。我们把其中 10% 的语音作为测试集(训练和测试间没有短语重叠),在此基础上,计算了个性化模型以及未调适的基础模型的 WER。

总的来说,无论是何种严重程度还是病症,我们提供的个性化方法都取得了显著效果。即便是存在严重语言障碍的语音,家居自动化语境短语的 WER 中位数从 89% 左右降到了 13%。在如与看护者对话等其他语境中,准确率也有显著提高。

在未调适与个性化 ASR 模型中使用居家自动化短语的 WER

为了解个性化模型何时不适用,我们对以下几个子组进行了分析:

●

HighWER 与 LowWER:将说话者按照具有基于 WER 分布的第 1 和第 5 个五分位数的高和低划分个性化模型。

●

SurpHighWER:具有超高 WER 的说话者(在 HighWER 组中典型或具有轻度语言障碍的参与者)。

不同的病症以及语言障碍表现形式对 ASR 产生的影响是不一致的。根据 HighWER 组中语言障碍类型的分布表明,由于脑瘫(Cerebral palsy)引起的构音障碍特别难以建模。不出意外,该组中语言障碍严重程度的中位数也更高。

为了识别影响 ASR 准确率的特定说话者以及技术因素,我们检查了 ASR 表现较差 (HighWER) 和优秀 (LowWER) 的参与者之间元数据的差异 (Cohen's D)。和预期一样,LowWER 组中整体语言受损程度显著低于HighWER组 (p < 0.01)。HighWER 组中最突出的非典型语音特征是清晰度以及受损程度,同时包含其他较为突出的语音特征,如异常的韵律(Prosody )、发音及发声(Phonation)。众所周知,这些语音特征也会降低语音的整体清晰度。

与 LowWER 组 (p < 0.01) 相比,SurpHighWER 组中的训练语音更少,且 SNR 更低,进而导致较大(负)的效应量,而其他因素的效应量则较小(快速性除外)。相比之下,HighWER 组在所有因素中都表现出了较大差异。

语音障碍和技术元数据效应量对比结果:HighWER 组与 LowWER 组对比;SurpHighWER 组和 LowWER 组对比。正值结果表明 HighWER 组的组值大于 LowWER 组的组值

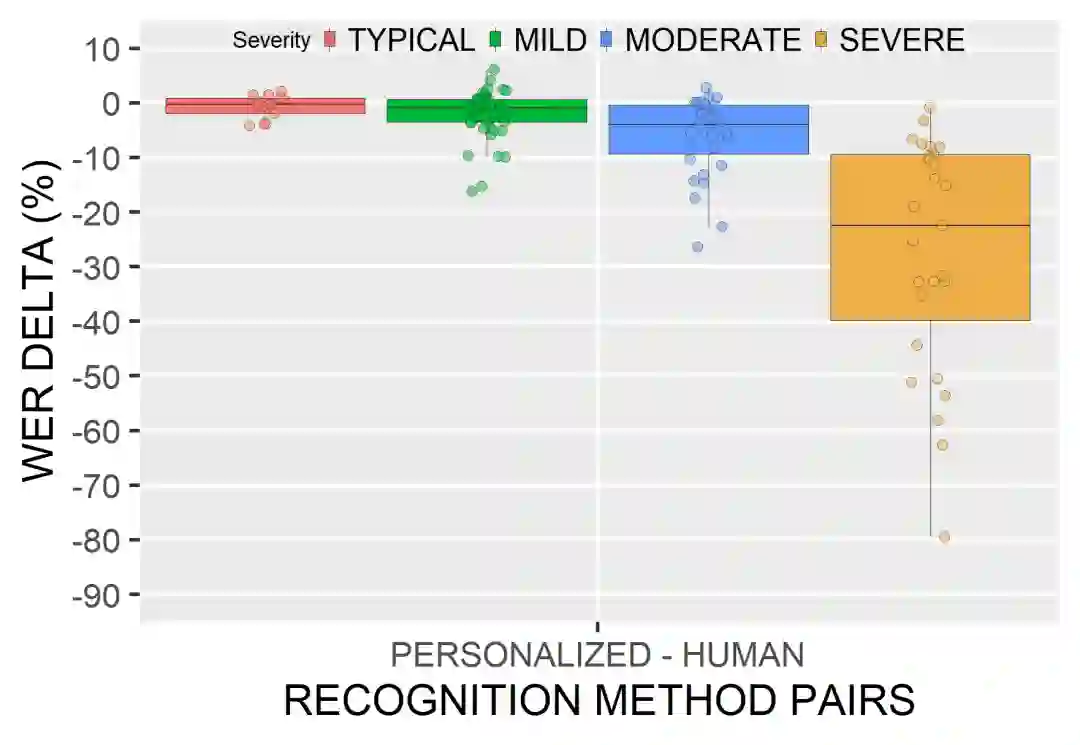

之后,我们将个性化 ASR 模型和人类听众进行了比较。三位语音专家分别为每位说话者转录了 30 条语音。我们发现,与人类听众的 WER 相比,个性化 ASR 模型的 WER 平均而言更低,并且随语言受损严重程度的增加而表现的更好。

个性化 ASR 模型 WER 与人类听众 WER 之间的增量。负值表明个性化 ASR 模型的表现优于人类(专家)听众

Euphonia 语料库拥有超过 100 万条语音,是最大、最多样的无序语音语料库之一(就无序类型与受损程度而言),这一语料库大大提升了非典型语音类型中的 ASR 准确率。我们的研究结果证明,个性化 ASR 模型在识别各种语言障碍以及受损程度方面十分有效,而且具备了让更多用户使用 ASR 的潜力。

此项目的主要贡献者包括 Michael Brenner、Julie Cattiau、Richard Cave、Jordan Green、Rus Heywood、Pan-Pan Jiang、Anton Kast、Marilyn Ladewig、Bob MacDonald、Phil Nelson、Katie Seaver、Jimmy Tobin 以及 Katrin Tomanek。我们由衷感谢 Google 多个语音研究团队的成员在 Euphonia 项目上提供的大力支持,其中包括 Françoise Beaufays、Fadi Biadsy、Dotan Emanuel、Khe Chai Sim、Pedro Moreno Mengibar、Arun Narayanan、Hasim Sak、Suzan Schwartz、Joel Shor 等成员。最重要的是,我们希望向负责记录语音样本的 1300 多名参与者表示衷心感谢,同时也非常感谢联系以上参与者的推广团体。

推荐阅读

点击“阅读原文”访问 TensorFlow 官网

不要忘记“一键三连”哦~

分享

点赞

在看