ICML2022开会了!如炼何大模型?伯克利最新《大模型训练和服务的技术和系统》教程,176页ppt阐述大模型关键技术,附视频

【导读】预训练大模型是现在关注的研究热点之一。ICML 2022 大会于 7 月 17 日 - 23 日在美国马里兰州巴尔的摩市以线上线下结合的方式举办。来自伯克利的几位学者的《大模型训练与服务》技术教程,模型并行训练和服务中的研究和实践痛点,值得关注!

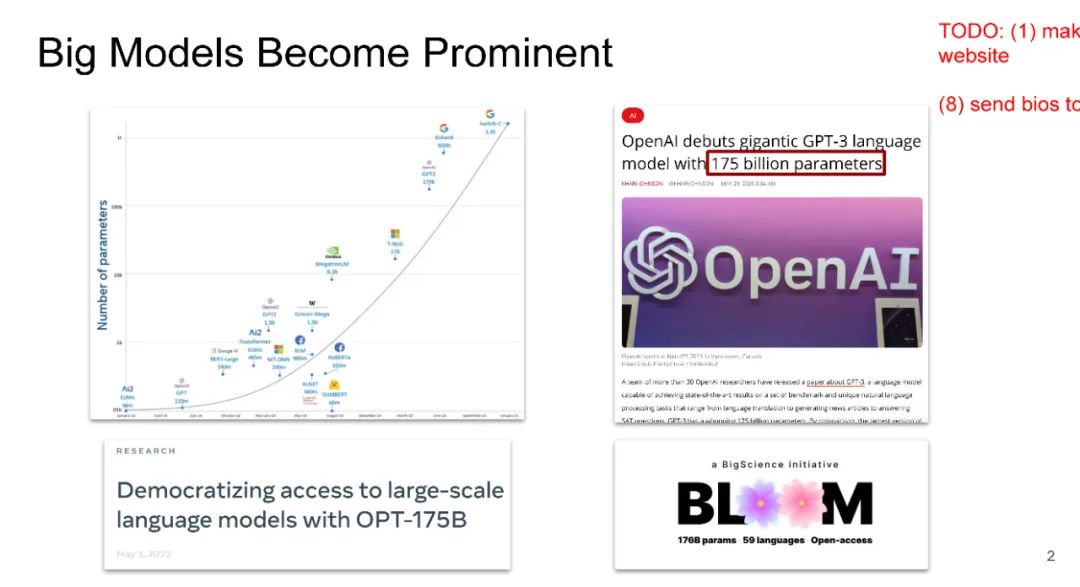

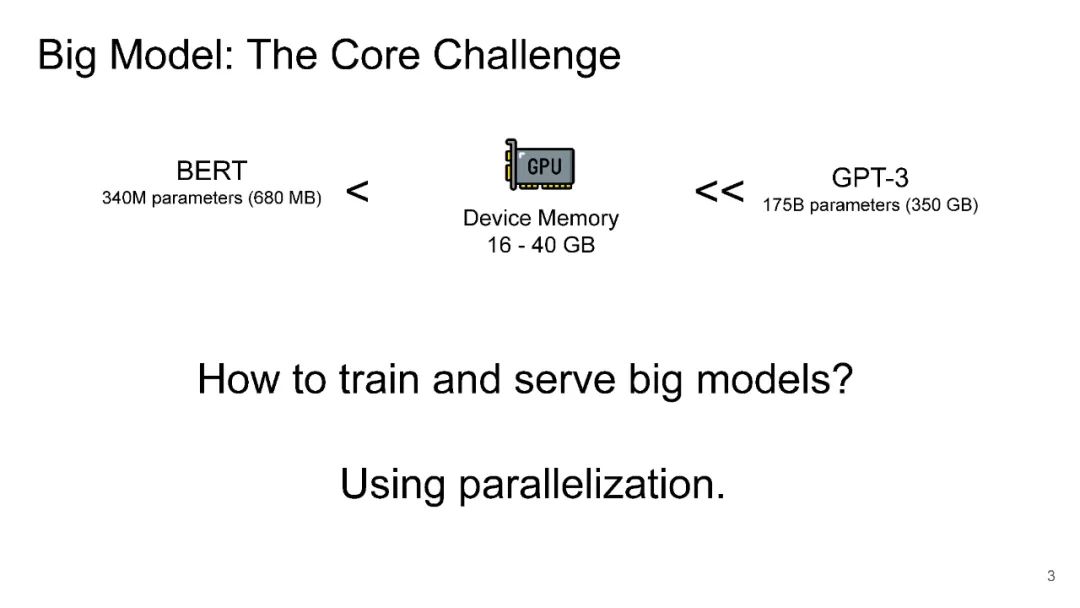

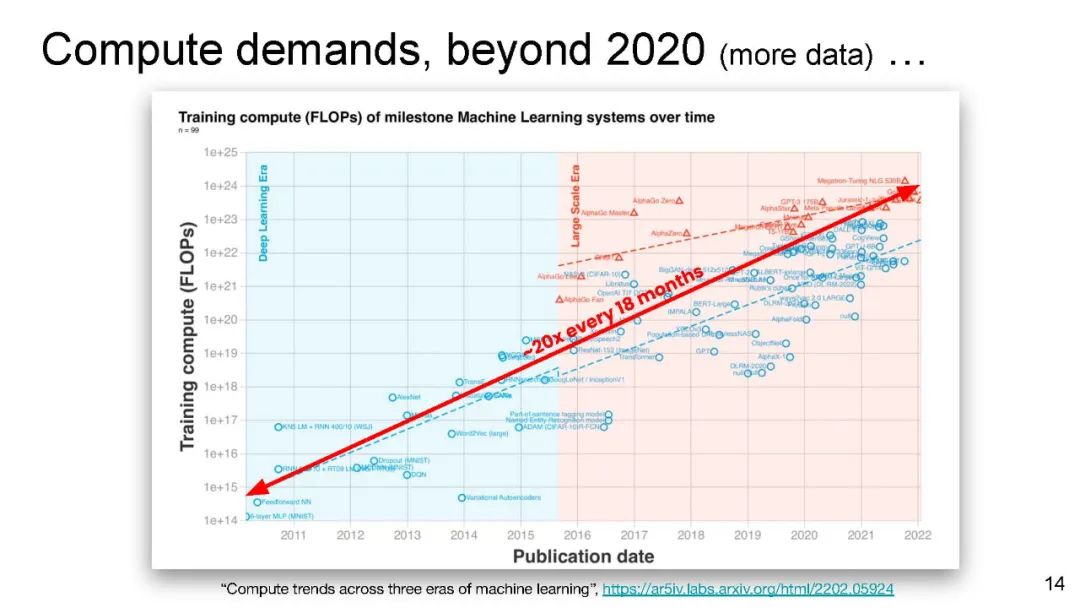

近年来,ML和系统的研究人员一直在合作,将大型模型(如带有175B参数的GPT-3)引入研究和生产。据揭示,增加模型大小可以显著提高ML的性能,甚至可以带来根本的新功能。

然而,试验和采用大模型需要新的技术和系统来支持他们对大数据和大集群的训练和推理。本教程确定了模型并行训练和服务中的研究和实践痛点。特别地,本教程介绍了新的算法技术和系统架构,用于处理流行的大模型(如GPT-3、PaLM和视觉转换器)的训练和服务。本教程还包括如何使用最新的开源系统工具集来支持大模型的训练和服务。我们希望通过这个教程,降低在ML研究中使用大模型的技术壁垒,把大模型带给大众。

https://icml.cc/Conferences/2022/Schedule?showEvent=18440

讲者介绍:

Hao Zhang目前是加州大学伯克利分校的博士后研究员,与Ion Stoica合作。他最近致力于为大规模分布式深度学习构建端到端可组合和自动化系统。

Zheng Lianmin是加州大学伯克利分校EECS系的博士生,他的导师是Ion Stoica和Joseph E. Gonzalez。他的研究兴趣在于机器学习和编程系统的交叉,特别是加速和可扩展的深度学习领域特定的编译器。

Zhuohan Li,加州大学伯克利分校计算机科学博士,导师是Ion Stoica。他的兴趣在于机器学习和分布式系统的交叉。他利用不同领域的见解来提高当前机器学习模型的性能(准确性、效率和可解释性)。

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“BM176” 就可以获取《ICML2022开会了!如炼何大模型?伯克利最新《大模型训练和服务的技术和系统》教程,176页ppt阐述大模型关键技术,附视频》专知下载链接