《PNAS》揭秘!昨晚吃了啥?为什么你大脑都记得?

点击上方“转化医学网”订阅我们!

干货 | 靠谱 | 实用

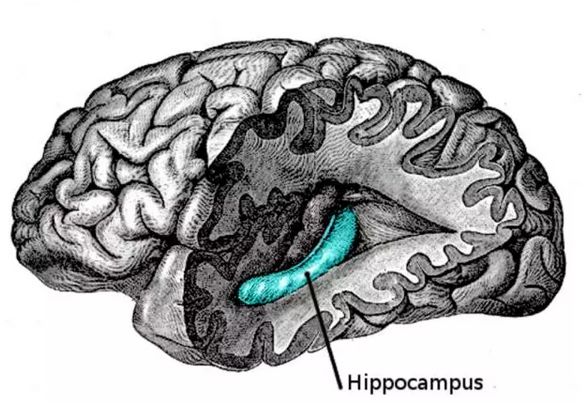

海马体

导 读

情节记忆也称为情景记忆,属于长时记忆的一种。指的是与一定的时间、地点及具体情境相联系的事件的识记、保持和再现。最近的一项研究表明,情节记忆是由人脑海马体中一套松散且迥异的神经编码的。

加州大学圣迭戈分校医学院的研究人员与他们在亚利桑那和路易斯安那的同行们报道,情节记忆是由人脑海马体中一套松散且迥异的神经编码的,证实了早前的计算机模型。

这一发现发表在一月十五号的PNAS线上先行版。

情节记忆是对过去发生在特定时空的事件的回忆,类似于经由精神上的时光回溯来回想起某次生日聚会或某次和朋友的聊天。情节记忆的编码发生在海马体——深藏于大脑中央的一对海马形状的小区域——但确切的机制和参与的神经数量均不明确。

“科学家们对这一问题感兴趣不只是因为它们可以帮助解析记忆模型,还因为一些健康方面的理由,”文章的第一作者,加州大学圣迭戈分校心理学系的杰出教授John Wixted博士说,“比方说,大脑这个区域的神经退行是阿尔茨海默症早期记忆丧失的原因之一。”

Wixted和加州大学圣迭戈分校医学院精神病、神经科学以及心理学系的杰出教授Larry Squire,以及其他同事对20个因为临床目的正在接受颅内监控的癫痫病人的脑功能进行了研究。

他们专门记录了研究参与者读一串稍有重复的连续单词时的单个神经元活动。参与者被要求在回想之前见过的单词时指出眼前的词是“新的”还是“旧的”。重复的单词,而不是崭新的单词引起的强烈海马体神经活动是公认的、与情节记忆有关的活动的证据。

科学家们发现每个单独的情节记忆是由一小组(小于2.5%)通常不互相重叠的海马体神经的强烈活动所编码和呈现的。这一发现或许有助于解释为什么过去的研究尝试没能有效地检测到这一过程。与此同时,他们注意到余下的海马体神经元(大约97.5%)的放电速率和活动都被抑制了——这种现象被称作神经元锐化。这些发现意义重大,因为它们证实了科学家们长久以来认为正确但缺少直接证据的猜想。

研究人员同时也在一个临近海马体、与情感和情感记忆相关的名为杏仁核的脑区寻找类似的神经活动。计算机模型没有预测出情节记忆可由杏仁核的松散的神经元系统,就像在海马体内那样编码而成,并且,事实上,科学家们确实没有在杏仁核找到类似的神经活动。

“如果想要开发针对记忆或影响记忆的疾病的治疗与预防方案,”Squire说,“我们对于大脑如何学习和记忆的认知就会十分重要。哪些脑结构对于记忆很关键?它们在其中扮演什么角色?在我们的研究中,如果不是早已发展出的记忆理论模型,我们可能轻易错过自己发现的东西。”

参考文献:

John T. Wixted el al., "Coding of episodic memory in the human hippocampus," PNAS (2018).

转化医学领域核心门户

识别图中二维码,点击关注

投稿、应聘医学编辑:

微信:vipmed360

商务合作

微信:zhyxkf

END

转折点——生物医药招聘第一平台