SIGIR 2021 | 基于不确定性正则化与迭代网络剪枝的终身情感分类方法

导读

终身学习能力对于情感分类器处理网络上连续的意见信息流而言至关重要。然而,执行终身学习对于深度神经网络来说是困难的,因为持续地训练可用信息会不可避免地会导致灾难性遗忘。发表在信息检索领域顶会 SIGIR2021 上的一篇论文提出了一种基于不确定性正则化与迭代网络剪枝的终身情感分类方法。通过迭代地执行带有不确定性正则化的网络剪枝,IPRLS 可以使用单个 BERT 模型处理来自多个领域的连续到达的数据,同时避免灾难性遗忘。

论文标题:

Iterative Network Pruning with Uncertainty Regularization for Lifelong Sentiment Classification

耿斌宗,中国科学技术大学;杨敏,SIAT-NLP PI;原发杰,原腾讯看点研究员,现任西湖大学表征实验室PI

中国科学技术大学;SIAT-NLP;西湖大学

https://arxiv.org/abs/2106.11197

https://github.com/siat-nlp/IPRLS

随着网络上含有丰富观点的文档被大量收集,自动预测给定文本情感极性的情感分类任务受到了越来越多的关注。近年来,深度学习取得了巨大成功,在情感分类领域几乎占据了主导地位。强大的深层神经网络必须依赖大量带注释的训练资源。然而,标记大型数据集通常是耗时且劳动密集的,在将经过训练的分类器应用于新领域时会遭受重大阻碍。

此外,无论收集多少数据训练情感分类器,都很难覆盖网络上所有可能的观点数据领域。因此,当部署到实际环境中时,训练得到的情绪分类器性能往往不能令人满意。生产环境中的情感分类器会遇到连续的信息流,因此需要将其知识扩展到新的领域。

通过掌握新知识并记住以前学到的经验而持续学习的能力被称为终身学习或持续学习。终身学习是一项神经网络长期面临的挑战。在终身学习中,很难自动平衡稳定性与可塑性。

一方面,我们期望情感分类器重用先前获得的知识,但过分关注稳定性可能会妨碍分类器快速适应新任务。另一方面,当分类器过于关注可塑性时,它可能会很快忘记以前获得的知识。一个可能的解决方案是在处理新任务时有效地重用以前获得的知识,同时避免忘记以前获得的知识。也就是说,一方面,巩固的知识被保留下来,以保持长期的持久性,并防止随着时间的推移学习新任务时发生灾难性遗忘。另一方面,在某些情况下,允许修改或替换旧知识,以提炼新知识并避免知识干扰。

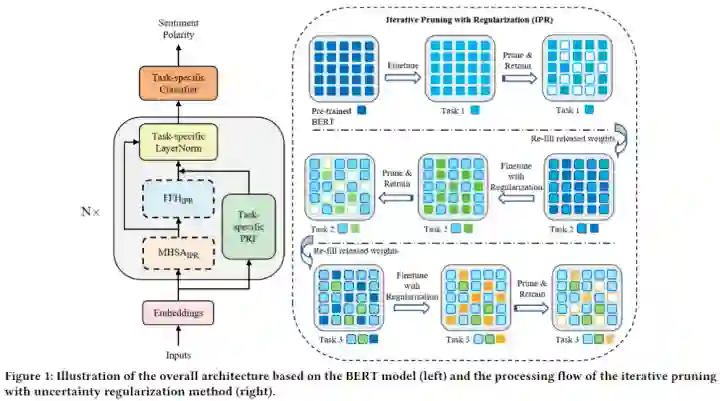

IPRLS 论文提出了一种基于不确定性正则化与迭代网络剪枝的终身情感分类方法。其采用 BERT 作为情感分类的基础模型,为解决稳定性可塑性难题,IPRLS充分利用了网络剪枝和权重正则化技术,将多个顺序到来的任务中的重要知识依次集成到单个 BERT 模型中,同时尽可能地避免模型准确度降低。

具体来说,在每一轮剪枝流程中,IPRLS 使用基于权重的剪枝技术,在对某一任务完成训练后,从 BERT 的每一层中释放出一定比例的冗余权重,并对释放的参数进行修改,以学习后续的新任务。在学习新任务时,IPRLS 不像之前的工作 [1,2] 那样保持旧任务的权重不变,而是将基于贝叶斯在线学习框架的不确定性正则化纳入迭代剪枝过程中。

3.1 任务定义

3.2 方法概述

IPRLS 使用 BERT 作为基础模型来构建情感分类器。BERT 是快速发展的预训练模型的重要代表,它在各种 NLP 任务上表现优异。一般来说,当任务按顺序依次到达,BERT 在学习新任务时,会灾难性地忘记旧任务。为了缓解灾难性遗忘问题,IPRLS 利用基于结构和基于正则化的持续学习方法,提高 BERT 终身情感分类的性能。

具体来说,IPRLS 探索了两种机制来促进 BERT 模型在学习新任务时保留对之前任务重要的知识。首先是一种带有不确定性正则化的迭代剪枝方法,将来自多个任务的重要知识整合到一个 BERT 模型中,同时确保最小的准确性下降。其次,在 BERT 的每一层上并行地添加一个特定于任务的并行残差函数,以在适应新任务的同时进一步保留新任务知识。

方法动机:为了缓解 BERT 模型的灾难性遗忘问题,一种可行的方法是保留已学习的旧任务权重,并在训练新任务时通过增加节点或权重来扩展网络。直觉上讲,有着 (i) 存在于许多领域的通用知识,以及 (ii) 高度特定于子领域的领域特性。这些通用知识可能有助于跨域进行迁移。

在大多数以前的基于体系结构的持续学习方法中,旧任务的权重往往保持不变,只有释放的权重被用于新任务的学习。由于旧任务的权重保持不变,模型得以保持所有已学习任务的性能。然而,模型固定的旧任务参数随着任务数量的增加而增加,使得深度模型难以适应新任务。

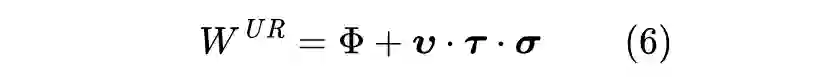

为了解决上述问题,论文提出了一种新的不确定性正则化迭代剪枝方法(IPR)。在学习新任务时,IPR 不再保持旧任务参数不变,而是将基于贝叶斯在线学习框架 [3] 的不确定性正则化 [4,5] 纳入迭代剪枝过程。不确定性正则化约束了 BERT 中旧任务线性变换层的更新,从而引导模型优雅地更新旧任务权重。

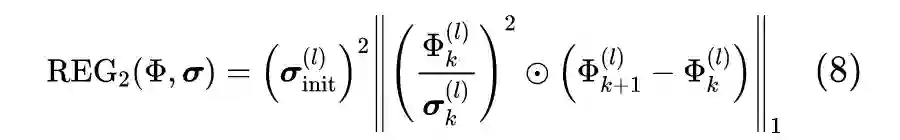

论文工作遵循持续学习的场景。情感分类器对一系列无限的任务进行学习。论文使用一个迭代的、三阶段的框架来进行终身情感分类。首先,通过对 BERT 模型的所有保留权重应用不确定性正则化来训练新任务的初始网络。第二,采用基于权重的剪枝技术用将 BERT 模型中相对不重要的参数进行释放,以使准确度下降最小。第三,在剪枝后重新训练网络,以恢复当前任务的准确度。接下来,我们将详细介绍这三个模块。

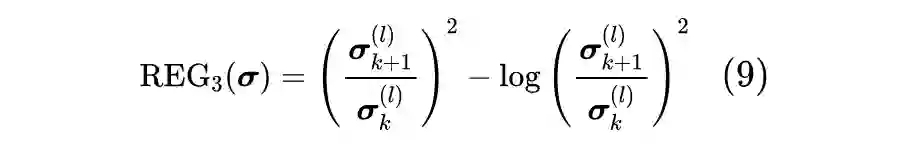

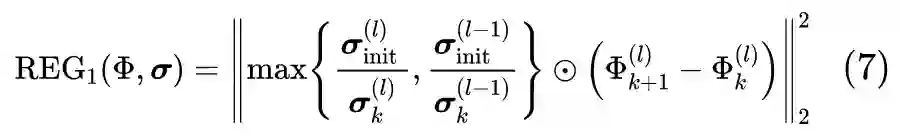

论文中采用三种正则化项来对旧任务保留参数的更新进行限制。

这一正则化项倾向于促进稀疏性。

利用不确定性正则化(三个约束),在学习新任务时,旧任务权重将谨慎而适量地进行更新。一方面,我们可以利用从旧任务中获得的知识来帮助我们学习一个更好地新任务分类器(即前向知识迁移)。另一方面,由于所有参数在学习新任务时都可以更新,旧任务也可以从新任务学习到的知识中获益(即反向知识迁移)。

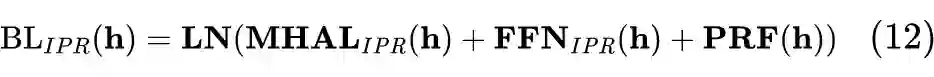

3.5 并行残差函数

在利用迭代剪枝机制后,旧任务的保留参数被一同用于学习新任务。然而,随着新任务的不断增加,保留的参数数量会越来越多。当几乎所有的参数都被同时使用时,旧任务参数就会像惯性一样,只有很少的新参数能够自由调整,从而阻碍新任务的学习。

实验

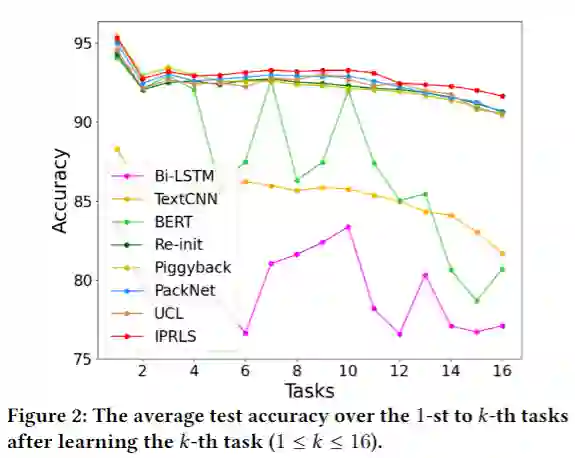

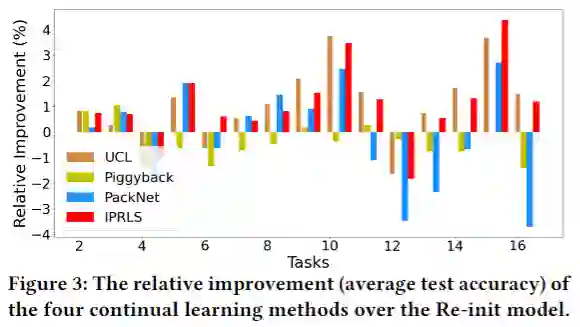

从表中可以看出,传统的深度学习模型(Bi-LSTM,TextCNN,BERT)表现远逊于持续学习方法(PackNet, Piggyback,UCL,IPRLS)。比如 BERT 在最后几个任务上表现与持续学习方法相近,但在最早的几个任务上则表现很差,这是由于传统的深度模型并没有刻意保存旧任务知识,因此会不可避免地遭受灾难性遗忘。

为分析 IPRLS 利用旧任务知识提高新任务性能的能力(正向迁移),论文中还报告了 BERT 模型在每一个任务被训练后重新初始化(为每个任务学习一个单独的模型)设置下的性能(记为 Re-init)。

持续学习方法中,Piggyback 与 Re-init表现相近,但其二进制掩码只是为单独的每个任务进行学习,虽然在某种程度上,Piggyback 可以避免遗忘问题,但同时也失去了正向迁移的能力。PackNet 在早期任务性能的保护上表现突出,但却越来越难以拟合新任务,尤其在最后一个任务 MR 上仅能达到 80.25% 的准确度,远低于 IPRLS 的 84.33%。

总结

参考文献

[1] Arun Mallya and Svetlana Lazebnik. 2018. Packnet: Adding multiple tasks to a single network by iterative pruning. In CVPR. 7765–7773.

[2] Andrei A Rusu, Neil C Rabinowitz, Guillaume Desjardins, Hubert Soyer, James Kirkpatrick, Koray Kavukcuoglu, Razvan Pascanu, and Raia Hadsell. 2016. Progressive neural networks. arXiv preprint arXiv:1606.04671(2016).

[3] Manfred Opper and Ole Winther. 1998. A Bayesian approach to on-line learning. On-line learning in neural networks(1998), 363–378.

[4] Hongjoon Ahn, Sungmin Cha, Donggyu Lee, and Taesup Moon. 2019. Uncertainty-based continual learning with adaptive regularization. InNeurIPS. 4392–4402.

[5] Charles Blundell, Julien Cornebise, Koray Kavukcuoglu, and Daan Wierstra. 2015. Weight uncertainty in neural networks. arXiv preprint arXiv:1505.05424(2015).

特别鸣谢

感谢 TCCI 天桥脑科学研究院对于 PaperWeekly 的支持。TCCI 关注大脑探知、大脑功能和大脑健康。

更多阅读

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧