【ICML2022】XAI for Transformers:通过保守传播更好的解释

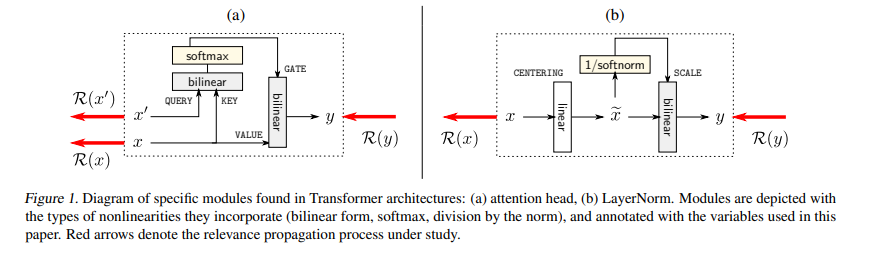

Transformers已经成为机器学习的重要主力,有着众多的应用。这就需要制定可靠的方法来增加其透明度。人们提出了多种基于梯度信息的可解释性方法。我们表明,Transformers中的梯度仅反映局部函数,因此不能可靠地识别输入特征对预测的贡献。我们认为引起这种不可靠解释的主要原因是注意力头和LayerNorm,并提出了一种通过这些层传播的更稳定的方式。我们的建议可以被视为对已建立的LRP方法的适当扩展,在理论上和经验上都证明了该方法克服了简单的基于梯度的方法的缺陷,并在广泛的Transformer模型和数据集上实现了最先进的解释性能。

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“GMC” 就可以获取《【ICML2022】XAI for Transformers:通过保守传播更好的解释》专知下载链接

登录查看更多

相关内容

Arxiv

16+阅读 · 2020年3月30日

Arxiv

15+阅读 · 2018年10月11日