朱茵和杨幂被大换脸!这个“黑科技”暗藏一个大“坑”...

来源:瞭望智库(zhczyj),作者:李瑶,已获授权转载

朱茵没想到,有朝一日杨幂的脸会“安”在自己身上;

杨幂没想到,有朝一日自己的脸会“安”在94版《射雕英雄传》中黄蓉的身上。

B站UP主“换脸哥”没想到,自己上传的AI换脸杨幂视频会引发如此巨大的关注,不到一天内,微博相关话题阅读量冲到2亿以上,甚至还有人为杨幂、朱茵演技孰优孰劣等娱乐性十足的话题争论不休。

不过,如果抛开娱乐表面细细探究,你会发现,这事一点也不娱乐。

01

杨幂“穿越”毫无违和感

成为热搜的这件事,其实也并不复杂。简单来说就是,一位名叫“换脸哥”的B站UP主,用AI技术把杨幂的脸“安”在了94版《射雕英雄传》中朱茵饰演的“黄蓉”脸上,视频效果还相当流畅自然。

不信你看,这是原版的朱茵截图:

这是换脸后的“杨幂版”截图:

有人会说,你这不过是图片PS。

那么看看这个,这是朱茵的表情截图:

标志性的灵动有神对不对?那再来看看杨幂版动态:

还有这个:

这样灵动的杨幂,是不是很久没见了?

更厉害的是,整个换脸后的视频几乎看不出破绽,相当流畅。来,欣赏一下:

原本《射雕英雄传》就是翻拍了多次的古装IP,加上角色本身的形象,以及所涉明星艺人的流量热度,引发巨大关注成了必然的结果。

发酵到如今,事件已经横跨娱乐、科技两界,成为不少人茶余饭后的谈资。

02

AI换脸技术几年间走向成熟

说起来,AI换脸并不是第一次引发关注。

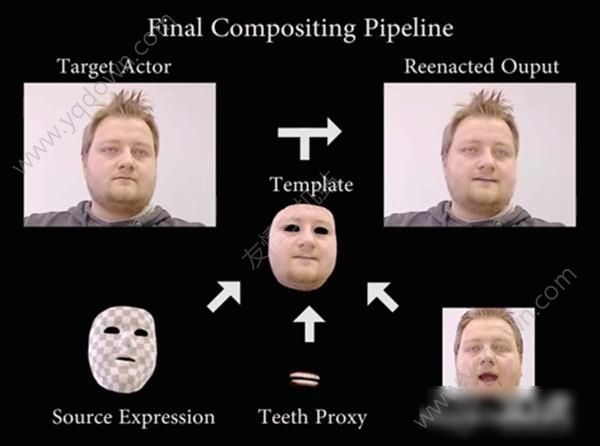

最早在2016年,德国纽伦堡大学的教授Justus Thies带着自己的团队,研发了一个能进行面部实时转换的模型,叫Face2Face,主要是通过一个真实的表演者来驱动视频中目标人物的表情,然后再输出。

操作原理上,他们先对目标人物的面部特征重构并追踪,当这个人做出某个面部表情,比如张嘴、挑眉等,模型会重新渲染此人的脸部形状及光影,并对背景进行修改。

拿上面这个图举例,图中右下是现实世界的人,亦即真实的表演者,左上是正常视频中的目标人物。在正常视频中,目标人物是没有表情没有说话的,但通过Face2Face,右下表演者的声音、表情、动作可以映射到右上人物脸上,最终输出结果就是右上的样子。

这项技术转化成变脸软件后,一度获得了不少手机用户的喜爱,使用者把自己的表情投射到视频中其他人的脸上,然后做出各种搞笑表情动图,趣味十足。

但学术界则思考起这项技术的未来。

有人提出质疑称,技术本身不具善恶,但一旦该技术的潜力被不正当使用,很可能诱导大量违法行为。

很快,这个预测应验了。

2017年12月,一个名为“Deepfakes”的Reddit用户利用人工智能技术,制作并上传了一段假视频,视频里,他将《神奇女侠》女主角盖尔·加朵(Cal Gadot)的脸换到一个成人电影女星身上,引起轰动;

不到一月后,有人将Deepfakes公开的算法加以改造,推出了一款名叫FakeAPP的Windows程序,声称技术小白都可以据此制作出假电影。

煽动之下,有网友号称只花了5个小时,就用这个程序成功复制了Deepfakes给艺人明星换脸的“杰作”。

当时就有专业人士指出,能让DeepFakes以假乱真的方法,其实就是使用深度学习模型生成式对抗网络(GAN,Generative Adversarial Network),只需把被伪造者的几张照片作为输入源,然后将其按照面部角度、头部倾斜等叠加在视频上。

很快,这项技术也传到了国内。不少网友拿明星艺人制作过换脸视频,不过大多数视频或出于素材量不足,或出于制作硬件较差等原因,视频效果参差不齐。

相比之下,此次杨幂版本的黄蓉,视频本身的流畅自然,显然意味着这一技术的进一步成熟,很难不让人惊叹。

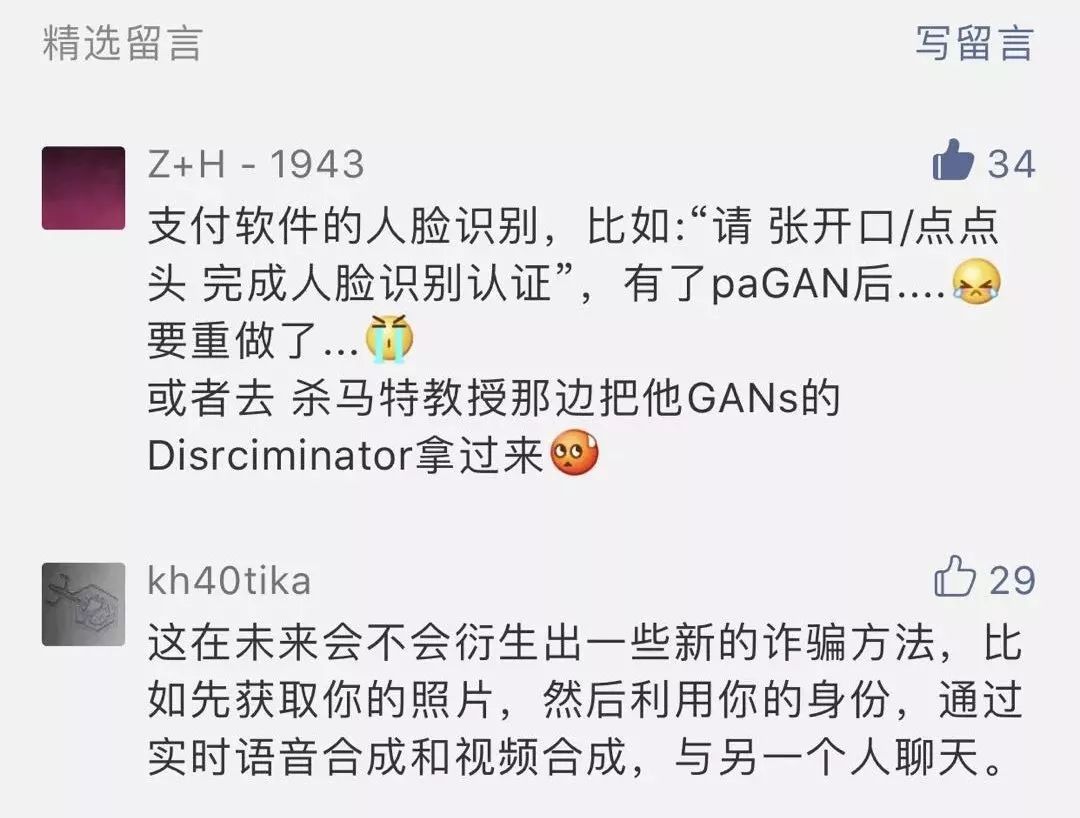

但不少网友也开始质疑,该视频可能侵犯肖像权。还有人提出,该技术可能会被制作明星虚假不雅视频。

虽然AI换脸杨幂视频制作者已经出来回应称“主要用于技术交流,并无营利行为”,但这并不能让网友信服。

03

潘多拉魔盒?

人们对技术的不信任,根本上还是源于技术背后的使用者。有句话叫,技术本身没有价值观,但利用技术的人有价值观。

有的人关注技术本身的正向价值。比如,计算机视觉创业公司Pinscreen,其paGAN技术(Photoreal Avatar Generative Adversarial Network,逼真动画人物生成对抗网络),就是利用目标人物的普通照片,实时生成高清逼真动画人脸,并将真实的表演者的动态表情生成目标人物的动态表情,从而用于电影或游戏制作。

但也有人喜欢“搞事情”。比如,2018年4月,美国制片公司“猴爪(Monkeypaw Productions)”利用日渐成熟的Deepfake技术,制作了一段虚假视频,视频中美国前总统奥巴马对现任总统特朗普进行了严厉的批评。令人瞠目结舌的是,奥巴马的表情动作竟然合成自“猴爪”公司的创始人乔丹·皮尔。

从隐晦的色情到全民的娱乐,再到严肃的政治,AI换脸技术应用场景一步步突破人们的想象力。

实际上,早在2017年7月,肯尼迪政治学院贝尔弗科学与国际事务中心就应美国情报高级研究计划局(IARPA)的要求,对此类技术进行研究分析。

他们发现,目前人工智能技术的“伪造”水平已极其强大,具有极高迷惑性,能够逼真实时修改视频中人物的面部表情和嘴唇运动,能为有足够丰富音视频资源的个人生成用真实声音合成的录音,并能自动生成逼真的音响效果,给无声视频配音。

这意味着,许多你能想到的“技术作恶”情况,都有可能慢慢变成现实。

比如,你躲过了电信诈骗,却难以躲过AI诈骗。犯罪分子可能会利用你的图片、声音冒充你,跟你的家人、朋友、同事聊天、交易,甚至直接实施暴力犯罪。

犯罪行为构成后,伪造出来的“现实”与“事实”也会给检验分析人员带来更多干扰,严重侵蚀社会信任度,激发互联网欺诈犯罪的进一步扩散和升级。

再比如,当前媒体传播介质种类繁多且发展迅速,新闻内容除了严肃事实外,还有特意生产出的“洋葱新闻”,用以适当的娱乐讽刺。但如果利用AI技术恶意展开网络攻击、虚构事件,再与社交媒体相结合,那么所有你看到的新闻,真假度就更难鉴别了。

往严重了考虑,在极端情况下,如果黑客控制了官方的新闻机构网站或社交媒体账户,大肆利用这项技术制造和散播假的文本、视频和音频,就可能制造大面积的恐慌。

例如,2013年4月23日,黑客控制了订阅人数高达200万的美联社官方推特账号,并发布了一篇标题为“白宫两次爆炸,巴拉克·奥巴马受伤”的推文,一度引发市场恐慌,股市暴跌,直到被黑客攻击这一情况被发现才停止。

04

反AI技术的“军备竞赛”

为了规避人工智能“换脸术”潜在的安全风险,欧美国家安全机构已经开始联合高校进行前瞻研究,研发相应的反制工具和技术。

2018年5月,美国国防部高级研究计划局DAPRA着手推进一项名为Media Forensics的计划,并联合纽约州立大学研究团队,于当年8月份推出了全球首款“反变脸”的AI刑侦检测工具,以AI攻AI。

DARPA Media Forensics项目负责人Matthew Turek透露,此款工具能研发成功,主要是由于他们在GAN生成的假脸中发现了一些细微的线索:使用AI技术生成的假脸(一般通称 DeepFake),极少甚至不会眨眼,因为它们都是使用睁眼的照片进行训练的,而大多数训练数据集都不包含闭眼的人脸图像。

通过有效预测眼睛的状态,这款反变脸AI刑侦工具的检测准确率已经可以达到99%。

但这也不过只是阶段性的应对成果。达特茅斯大学数字取证专家汉尼·法里德表示,机器学习系统可以接受更先进的训练,然后超越当前的反变脸工具。

上述首款反变脸工具的研发者之一——纽约州立大学奥尔巴尼分校教授Siwei Lyu也表示,现有技术并不能让人高枕无忧。除了将缺乏眨眼作为检测AI篡改的提示,还需要探索其他深度神经网络架构,比如观察动态的眨眼模式——太快或频繁眨眼这种在生理上不太可能出现的现象,也应该被视为篡改的迹象。

这意味着,现有人工智能刑侦取证工具的诞生,仅仅标志着人工智能视频伪造者和数字刑侦人员之间人工智能“军备竞赛”的开始。

而这种军备竞赛,不局限于变脸与反变脸、伪造与反伪造之间的技术竞争,更存在于人与人、企业与企业、行业与行业、地区与地区、国与国之间的技术防卫上。

纵然这一技术眼下只是作为社交娱乐,模拟度也比较低,但随着数据量的累积,深度学习能力及其模型的不断提升与完善,其逼真度和使用范围将不断扩大。

无论从何种立场出发,针对AI伪造技术的发展,必须高度警惕这一技术被恶意使用带来的风险。

你我作为普通民众,则必须时刻牢记:娱乐千万条,安全第一条,技术不守善,用者两行泪。

(本文图片均来自网络)

凤凰网财经官方微信 ID:finance_ifeng

喜欢此文,欢迎转发和点好看支持凤财君