为AI从业者/研究生/研究员专门定制的全网唯一高端AI训练营

NLP领域的现状以及AI工程师面临的严峻挑战

在过去几年时间里,NLP领域取得了飞速的发展,这也推动了NLP在产业中的持续落地,以及行业对相关人才的需求。 虽然,NLP的崛起滞后CV多年,但目前的势头还是势不可挡。

但这里我们要面对的现实是,行业上90%以上的NLP工程师是“不合格的”。在过去几个月时间里,我们其实也面试过数百名已经在从事NLP的工程师,但明显发现绝大部分对技术深度和宽度的理解是比较薄弱的,大多还是只停留在调用现有工具比如BERT、XLNet等阶段。

我们一直坚信AI人才的最大壁垒是创造力,能够持续为变化的业务带来更多的价值。但创造的前提一定是对一个领域的深度理解和广度认知,以及不断对一个事物的追问比如不断问自己为什么。

为什么在这个问题上使用Adam,而不是GD或者Adagrad? 对于特定的业务场景,我应该如何把领域知识考虑进去, 用先验,还是用限制条件? 对于拼车场景,设计了一套优化目标,但好像是离散优化问题,应该如何解决? 对于二分类,我应该选择交叉熵还是Hinge Loss?BERT模型太大了,而且效果发现不那么好比如next sentence prediction, 能不能改一改? 为什么CRF要不HMM在不少NLP问题上效果更好? 文本生成效果不太好,如何改造Beam Search让效果更好呢?训练主题模型效率太慢了,如果改造吉布斯采样在分布式环境下运行呢? 数据样本里的标签中有一些依赖关系,能不能把这些信息也加入到目标函数里呢?

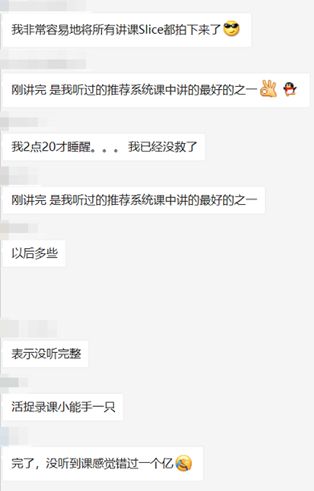

另外,有必要保持对前沿技术的敏感性,但事实上,很多人还是由于各种原因很难做到这一点。基于上述的目的,贪心学院一直坚持跑在技术的最前线,帮助大家不断地成长。

为什么选择贪心学院的高端NLP?

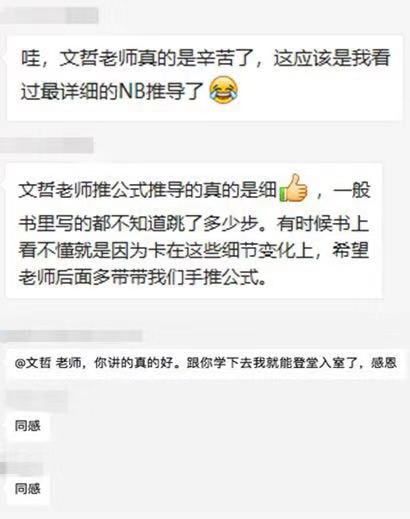

首先,全网不可能找得到另外一门系统性的训练营具备如此的深度和广度,这里包括国外的课程,所以从内容的角度来讲是非常稀缺的内容。

其次,即便网络上的资源非常多,学习是需要成本的,而且越有深度的内容越难找到好的学习资源。如果一门课程帮助你清晰地梳理知识体系,而且把有深度的知识点脉络讲清楚,这就是节省最大的成本。

另外,作为一家专注在AI领域的教育科技公司,教研团队的实力在同行业可以算是非常顶尖的,这里不乏顶会的最佳论文作者、ALBERT的作者等。

最后,我们这一期的NLP高阶训练营(第八期)在原有的基础上做了大量的升级,融合了更多前沿的内容,而且在部分内容上加深了难度。

那谁适合学习NLP高端课程呢?

已经在从事AI工作,但想持续在技术深度和广度上提升自己,塑造自己的壁垒

目前在学校从事相关的研究,但想深入下去,或者为发表顶会文章打下基础

对AI有一定的基础,而且很好的工程能力、想之后从事NLP相关的工作

之后想申请国内外AI博士/硕士

第一部分 机器学习与优化理论基础

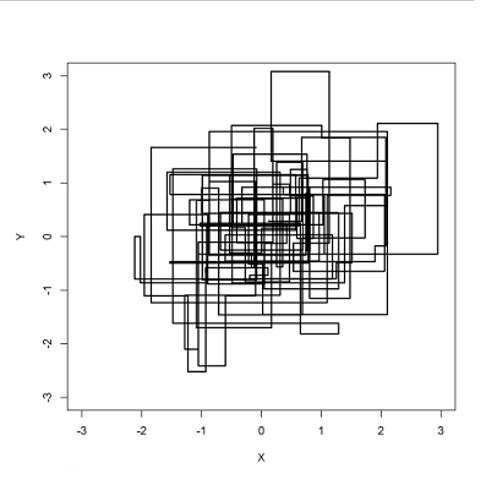

学习目标:掌握必要的凸优化理论,使得在建模过程中可以灵活修改目标函数,从而满足业务中的个性化建模需求。

另外,在本阶段也帮助学员回顾核心的机器学习算法。

凸优化基础

判定凸集,以及凸函数

线性规划与二次规划

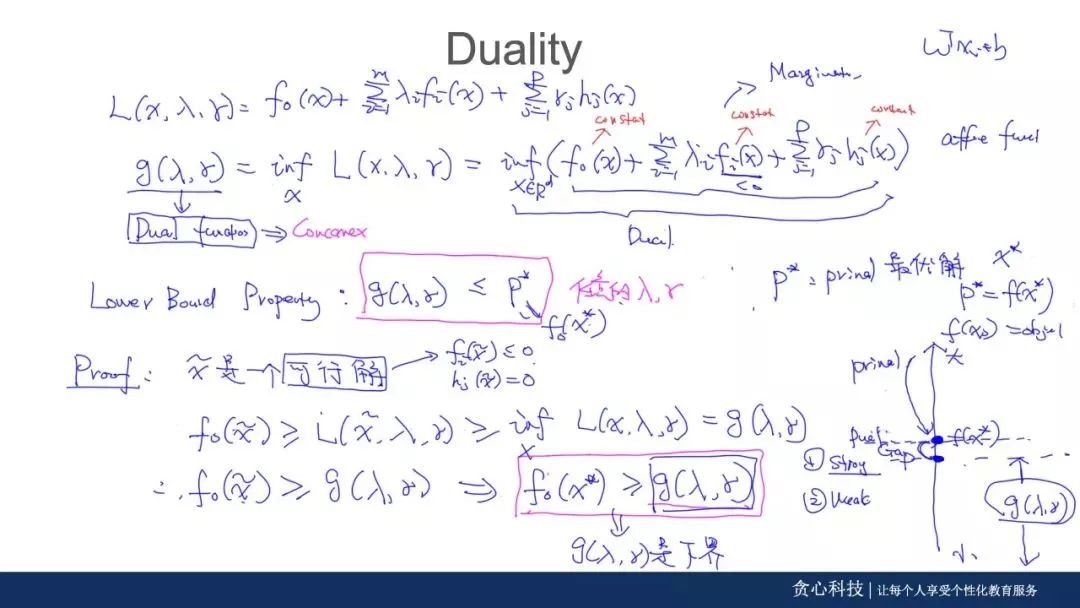

拉格朗日与对偶函数

Strong Duality与KKT条件

Non-convex优化问题

NP-Hard问题与松弛化处理

Discrete Optimization

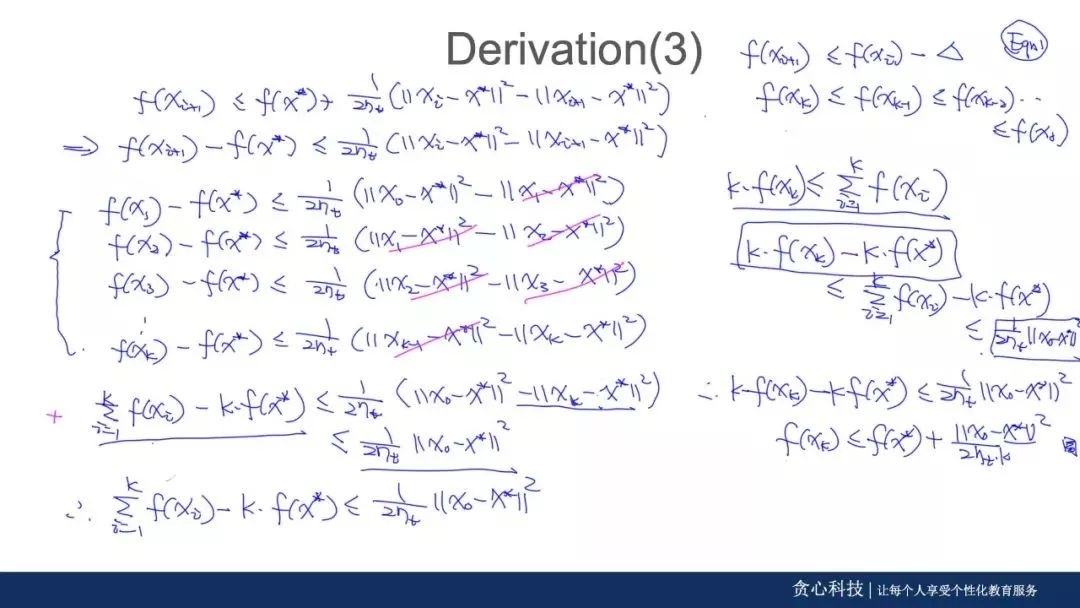

GD, SGD, Adam, Adagrad

L-BFGS, ADMM

机器学习基础

生成模型与判别模型

最大似然与最大后验估计

模型的过拟合

各类不同的正则(L1, L2, L0)

各类启发式算法(遗传算法、贝叶斯优化等)

随机森林与XGBoost

SVM与Dual SVM

Kernel Trick与设计核函数

本阶段所涉及到的案例/作业

利用WMD计算文本之间的相似度

利用Sparse QP设计资产组合策略

利用随机规划(SP)来解决库存优化

利用线性规划解决运输问题

利用松弛化解决整数问题

第二部分 语言模型与序列标注

学习目标:掌握语言模型与条件随机场(CRF),所涉及到的内容包括无向图模型、维特比算法、Partition Function, Label Bias,EM等所有核心细节。

文本处理技术与语言模型

最大匹配算法与Jieba技术剖析

SkipGram与负采样

CBOW, Glove, MF

Noisy Channel Model

N-Gram模型与各类平滑技术

NNLM

序列模型与条件随机场

EM算法与GMM

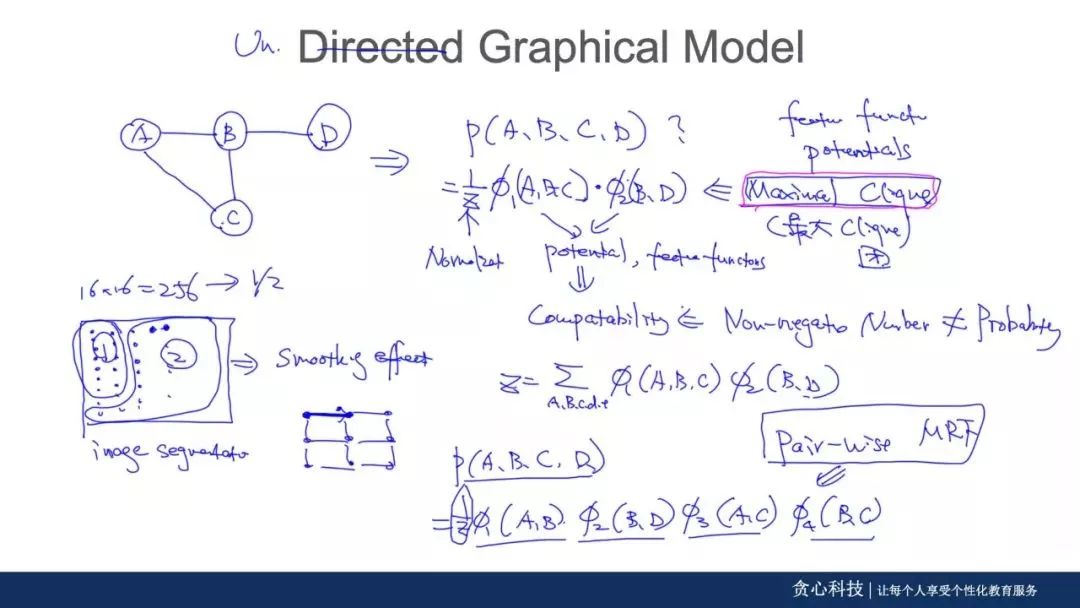

有向图与无向图

条件独立、D-separation

HMM模型、Viterbi以及参数估计

MEMM与Label Bias问题

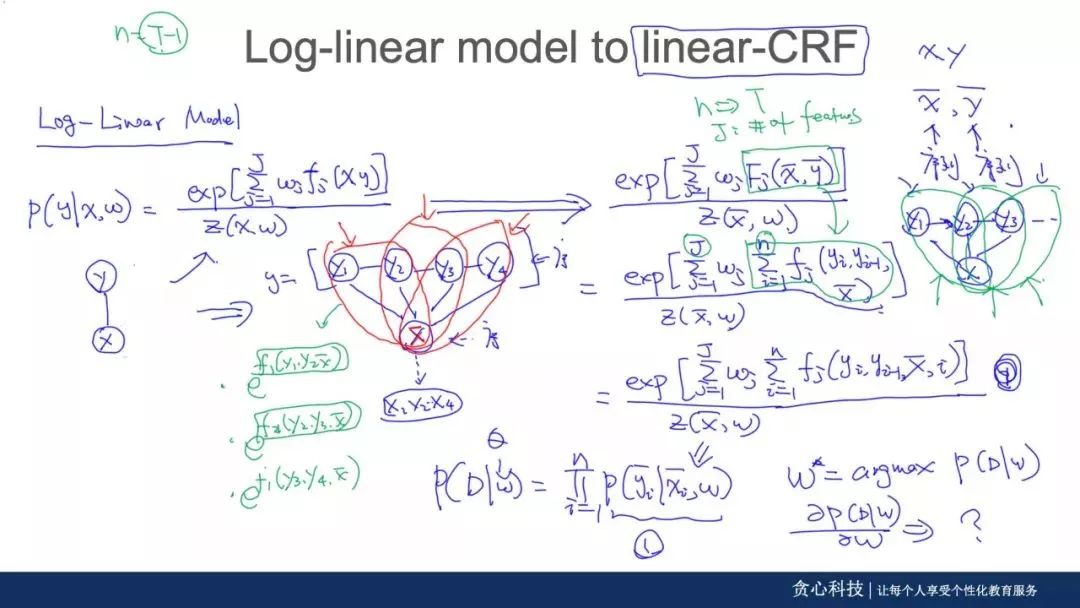

Log-Linear模型与逻辑回归

Linear-CRF与参数估计

本阶段所涉及到的案例/作业

拼写纠错系统的搭建

智能问答系统的搭建

Linear-CRF的从零实现

基于CRF, LSTM-CRF的NER识别

第三部分 预训练模型

学习目标:掌握BERT, XLNet等最新的预训练技术,能够熟练应用在自身的业务中。由于这部分的内容迭代更新速度快,所以具体内容安排会有所变化。

递归神经网络与注意力机制

分布式表示的优点

RNN与梯度问题

LSTM, GRU与BI-LSTM

Seq2Seq与注意力机制

Beam Search

BI-LSTM-CRF模型

ELMo与Transformer

上下文有关词向量的学习

NLU中的层次表示

Deep BI-LSTM与ELMo

Bottleneck问题与长依赖问题

Self-Attention,Multi-head Attention

Transformer与Transformer-XL

BERT与ALBERT

Autoencoder与DAE

MLM语言模型

BERT模型

BERT-BiLSTM-CRF

ALBERT模型

GPT2模型

XLNet与其他预训练模型

AR语言模型

Permutation语言模型

Two-Stream Attention

XLNet模型

Roberta

Q-Bert,VI-Bert

其他模型(TBD)

本阶段所涉及到的案例/作业

基于Seq2Seq+注意力机制的机器翻译系统

基于Transformer的机器翻译系

基于BERT-BiLSTM-CRF的NER识别

XLNet的从零实现

第四部分 信息抽取与图神经网络

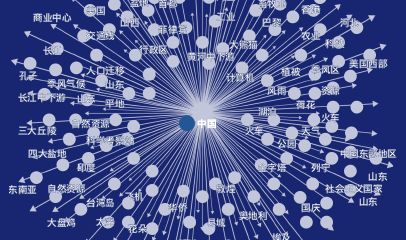

学习目标:掌握信息抽取、知识图谱、知识推理相关的内容。在这个领域需要掌握的内容,在这一阶段基本都会涉及到。

信息抽取与知识图谱

NE的抽取与识别

基于规则的关系抽取技术

基于无监督、半监督的关系抽取

实体统一、实体消歧、指代消解

知识图谱、实体与关系

知识图谱中的推理

知识浅入与图神经网络

TransE,NTN,Node2Vec模型

SDNE模型

带属性的网络嵌入

Graph Neural Network

CNN与Graph CNN

Dynamic Graph的处理

BERT与KG的结合

本阶段所涉及到的案例/作业

基于非结构化数据搭建知识图谱

基于知识图谱的大数据风控

基于医疗知识图谱的诊断

基于GNN的Combinatorial优化

基于信息抽取与DL的NL2SQL

第五部分 对话系统与文本摘要

学习目标:掌握常用的、以及前沿的对话系统和文本摘要相关的技术。目前相关技术的应用越来越普遍,本阶段内容基本覆盖所有必要的内容。

对话系统

智能问答与对话系统

基于检索的对话系统

基于生成式的对话管理

意图识别与有限状态机

基于任务式的对话系统

基于增强学习的对话系统

多轮对话的挑战

文本摘要

Abstractive vs Extractive

基于模板的文本摘要生成

基于Seq2Seq的文本摘要生成

ROUGE与Blue

Hierarhical Attention

Pointer-Generator Network

Beam Search的改造

Levenshtein Transformer

MASS

本阶段所涉及到的案例/作业

基于任务导向的订票管理

基于Pointer-Generation Network的文本生成

基于增强学习的对话系统剖析

第六部分 模型压缩与其他前沿主题

学习目标:掌握前沿的模型压缩技术,贝叶斯以及深度学习可视化等技术。

模型压缩

嵌入式设备中的模型压缩

基于Sparsity的模型压缩

基于矩阵分解的模型压缩

基于蒸馏方法的模型压缩

BERT、Transformer的压缩

贝叶斯模型

MLE、MAP、Bayesian模型区别

Dropout与Bayesian Approximation

PGM与主题模型

吉布斯采样、变分法

SGDL与SVI

分布式吉布斯采样

可视化与低资源学习

深度学习中的可视化技术

RNN、LSTM的可视化

Layer-wise Relevance Propagation

Cross-Domain语言学习

Transfer Learning

One-shot Learning

本阶段所涉及到的案例/作业

利用Laywer-wise RP可视化端到端的机器翻译系统

基于吉布斯采样的N-Gram LDA模型实现

基于Bayesian-LSTM的命名实体识别

对课程有意向的同学

添加课程顾问小姐姐微信

报名、课程咨询

👇👇👇

问答系统

情感分析系统

知识图谱系统

对话系统中的NLU

机器翻译系统

任务导向型聊天机器人

个个都立刻变身成了知乎大牛~

个个都立刻变身成了知乎大牛~

对课程有意向的同学

添加课程顾问小姐姐微信

报名、课程咨询

👇👇👇