用Transformer大一统ML模型,特斯拉AI总监Karpathy发推感叹AI融合趋势

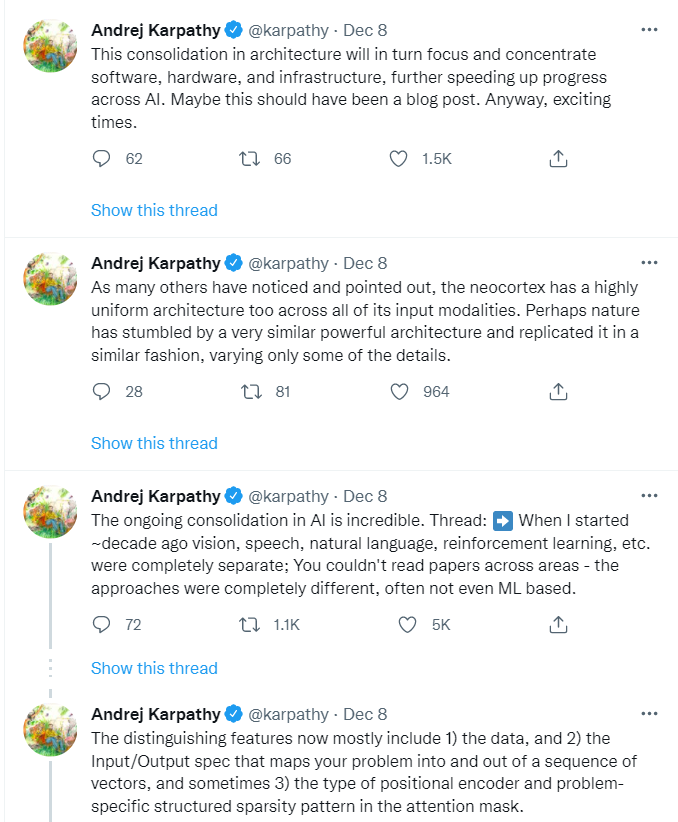

Andrej Karpathy:人工智能领域正在进行的整合令人难以置信。十年前,视觉、语音、自然语言、强化学习等,是完全独立的;一个人很难读懂跨领域的所有论文——各领域方法完全不同,甚至未必基于机器学习。到2010年,所有这些领域开始过渡到 1)机器学习,特别是2)神经网络。虽然架构多种多样,但至少论文读起来开始有点相似,都在利用大规模数据集,都在进行神经网络的优化。

最近两年,几乎所有领域的神经网络架构开始统一到Transformer,要么作为强大的基线,要么(往往)就是最先进水平。

输入可以是词语序列、图块序列、语音片段序列、强化学习的(状态、行动、奖励)序列,可以接受任意种类的Token——实在是一种极简又灵活的建模框架。即使在同一领域(如视觉),过去在分类、分割、检测、生成等不同任务也有不小的差异,如今也都转到了同一框架。例如,对检测来说,输入图块序列,输出边框序列。各种应用的差别,主要体现在:

1)数据,

2)将问题映射到向量序列中的输入/输出的定义,有时还包括

3)位置编码器类型和注意力掩码中特定问题的结构化稀疏模式。

虽然在技术上,我重点聚焦视觉领域,但所有人工智能领域的论文、人和想法都突然变得非常相关。每个人都在用基本相同的模型工作,所以大多数改进和想法,可以在所有人工智能领域迅速"复制粘贴"。正如许多人已经注意到并指出的,大脑皮层对其各种输入模式也有一个高度统一的架构。也许自然界也碰巧找到了一种类似的强大架构,并以类似的方式进行着复制,只在细节稍微做出些变化。这种架构上的整合,会反过来聚合和集成软件、硬件、基础设施,并进一步加快整个人工智能的进展。总之,这是个令人兴奋的时代。

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“人工智能” 就可以获取《人工智能专知资料》专知下载链接