今日 Paper | 虚拟试穿网络;人群计数基准;联邦元学习;目标检测等

为了帮助各位学术青年更好地学习前沿研究成果和技术,AI科技评论联合Paper 研习社(paper.yanxishe.com),推出【今日 Paper】栏目, 每天都为你精选关于人工智能的前沿学术论文供你学习参考。以下是今日的精选内容——

目录

NWPU-Crowd: A Large-Scale Benchmark for Crowd Counting

A Collaborative Learning Framework via Federated Meta-Learning

VITON: An Image-based Virtual Try-on Network

Transfer learning for time series classification

PR Product: A Substitute for Inner Product in Neural Networks

FASTER NEURAL NETWORKS STRAIGHT FROM JPEG

Object Detection in 20 Years: A Survey

Spherical Text Embedding

Mechanism Design with Predicted Task Revenue for Bike Sharing Systems

Semantics-aware BERT for Language Understanding

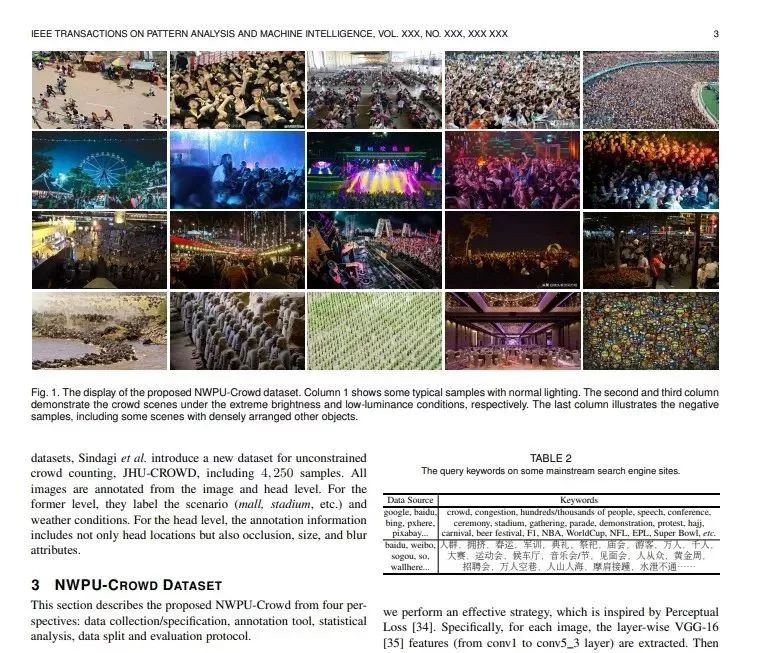

NWPU-CHAND:大规模人群计数基准

论文名称:NWPU-Crowd: A Large-Scale Benchmark for Crowd Counting

作者:Wang Qi /Gao Junyu /Lin Wei /Li Xuelong

发表时间:2020/1/10

论文链接:https://paper.yanxishe.com/review/8731

推荐原因:这篇论文考虑的是人群计数的问题。

目前公开的人群基数数据集规模都太小,不适合基于卷积神经网络的训练。这篇论文的贡献是一个一个大规模拥挤人群计数数据集NWPU-Crowd,包含了5109张图像,共标注了2133238个人。与其他数据集相比,新数据集包含各种光照场景,并具有目前该类问题的最大密度范围。除此之外,研究者还开放了一个针对该数据集的评测网站,可以在上面提交最新结果,促进大家的研究成果进行比较。

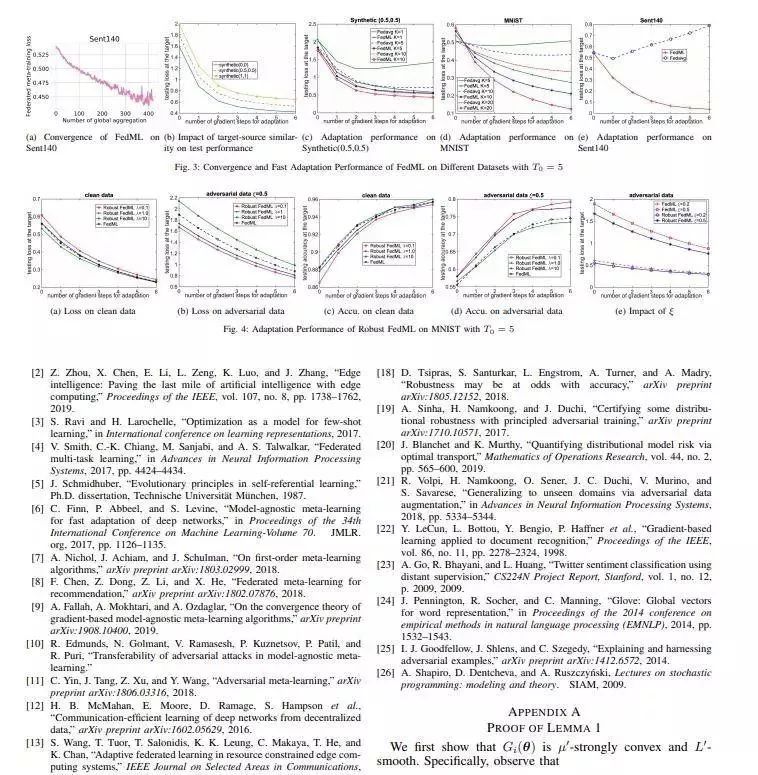

基于联邦元学习的协作学习框架

论文名称:A Collaborative Learning Framework via Federated Meta-Learning

作者:Lin Sen /Yang Guang /Zhang Junshan

发表时间:2020/1/9

论文链接:https://paper.yanxishe.com/review/8732

这篇论文考虑的是实时边缘智能的问题。

物联网中边缘设备由于其受限的计算资源和有限的本地数据,通常无法实现实时边缘智能。为此这篇论文提出了一个平台增强的协同过滤框架,首先通过联合元学习方法在一组边缘节点上训练模型,然后仅通过几个样本就可以使得模型快速适应目标边缘节点上的新任务。同时这篇论文还研究了其所提出的联合元学习算法在节点相似性和目标边缘的自适应性能上的收敛性。为了防御元学习算法可能遭受的对抗性攻击,这篇论文进一步提出了基于分布鲁棒性优化的联合元学习算法。在不同数据集上进行的实验证明了这篇论文所提出的基于联合元学习的框架的有效性。

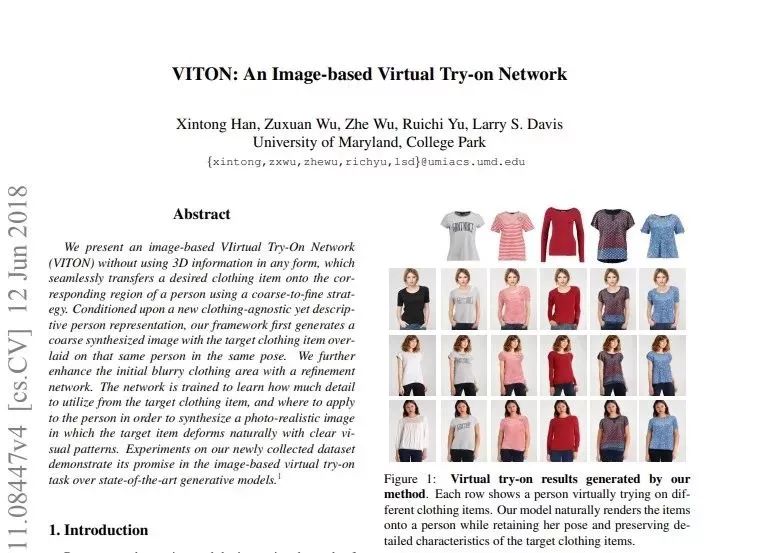

论文名称:VITON: An Image-based Virtual Try-on Network

作者:Han Xintong /Wu Zuxuan /Wu Zhe /Yu Ruichi /Davis Larry S.

发表时间:2017/11/22

论文链接:https://paper.yanxishe.com/review/8579

推荐原因

1、第一篇关于虚拟试衣的论文

2、采用TPS的 Wrap技术

3、开源代码;(目前数据源因法律风险关闭了)

4、值得入门阅读

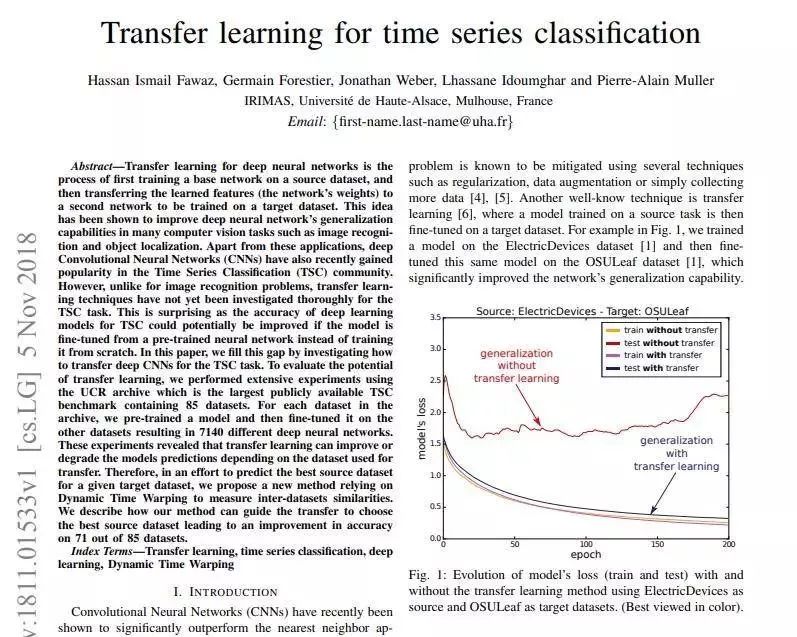

基于深度迁移学习进行时间序列分类

论文名称:Transfer learning for time series classification

作者:Fawaz Hassan Ismail /Forestier Germain /Weber Jonathan /Idoumghar Lhassane /Muller Pierre-Alain

发表时间:2018/11/5

论文链接:https://paper.yanxishe.com/review/70

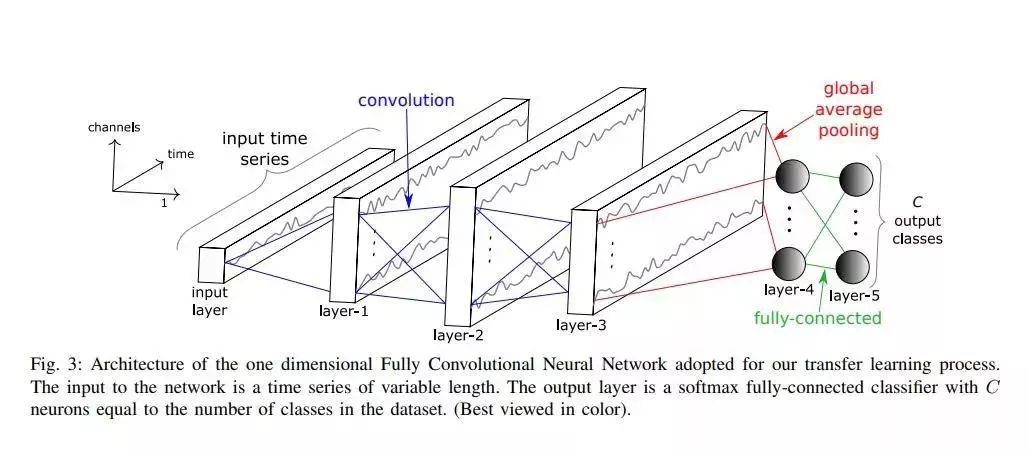

推荐理由:深度神经网络的转移学习是首先在源数据集上训练基础网络,然后将学习到的特征(网络权重)转移到第二个要在目标数据集上进行训练的网络的过程。该想法已被证明可以在许多计算机视觉任务(例如图像识别和对象定位)中提高深度神经网络的泛化能力。除了这些应用程序外,深度卷积神经网络(CNN)最近在时间序列分类(TSC)社区中也很受欢迎。但是,与图像识别问题不同,对于TSC任务,尚未对传递学习技术进行彻底研究。这令人惊讶,因为如果从预先训练的神经网络(而不是从头开始训练)对模型进行微调,则可以潜在地提高TSC深度学习模型的准确性。

在本文中,作者通过研究如何为TSC任务传输深层CNN来填补这一空白。为了评估转移学习的潜力,作者使用UCR档案进行了广泛的实验,该档案是包含85个数据集的最大的公开TSC基准。对于档案中的每个数据集,预先训练了一个模型,然后在其他数据集上进行了微调,产生了7140个不同的深度神经网络。这些实验表明,转移学习可以根据转移所使用的数据集来改善或降低模型的预测。因此,为了预测给定目标数据集的最佳源数据集,作者提出了一种依靠动态时间扭曲来测量数据集间相似性的新方法,并描述了其方法如何指导转移以选择最佳源数据集,从而提高了85个数据集中的71个数据集的准确性。

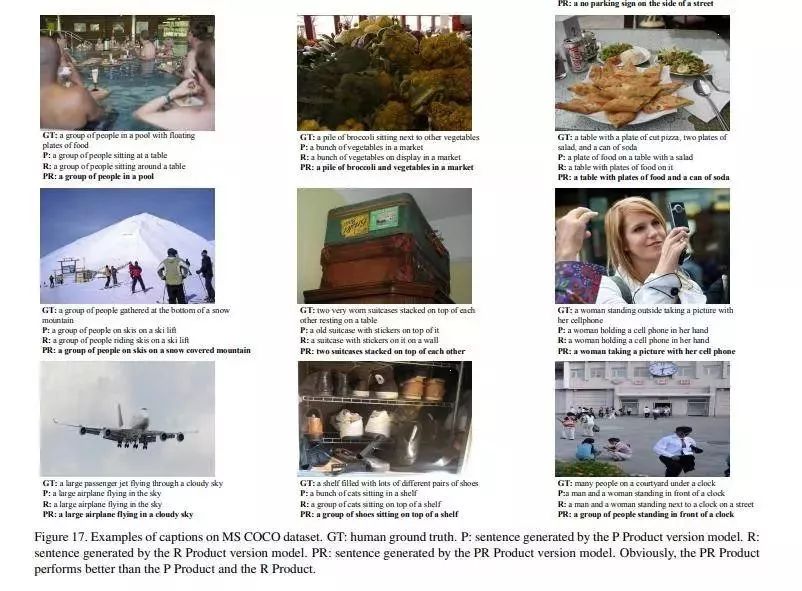

论文名称:PR Product: A Substitute for Inner Product in Neural Networks

作者:Wang Zhennan /Zou Wenbin /Xu Chen

发表时间:2019/4/30

论文链接:https://paper.yanxishe.com/review/176

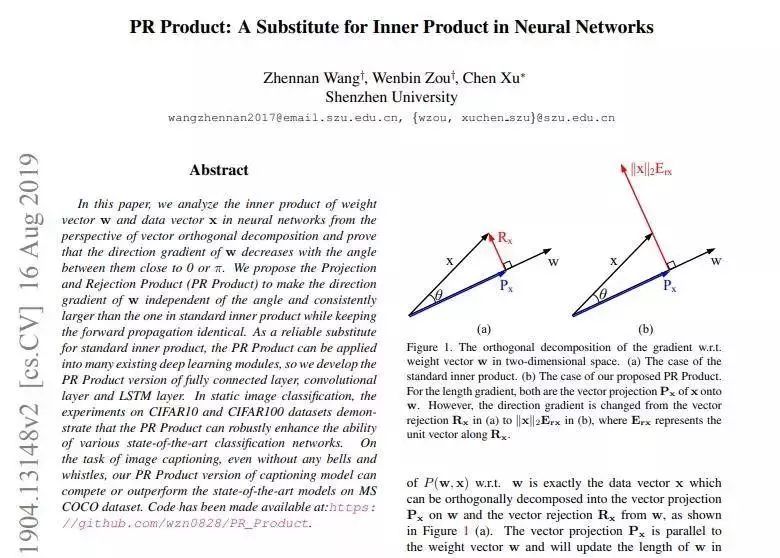

推荐理由:权重向量w与特征向量x的内积运算在神经网络中无处不在,但几乎没有人思考和研究过使用内积带来的负面影响。

本文指出了内积运算的缺点,新提出了PR乘积运算,该运算克服了内积运算的缺点,能够降低网络的训练难度。

1.研究动机:内积运算在向量夹角接近0或pi时会使反向传播的梯度变小,增大了网络训练的难度

2.创新点:提出PR乘积运算,该运算在前向传播中与内积等价,但是在反向传播中能够令参数梯度与向量夹角无关

3.实验结果:单纯的将内积运算替换成PR乘积就能够明显的提升各类网络的性能,且FC、CNN、RNN均适用。

PR乘积简单有效,即插即用,像一把趁手的瑞士军刀,该文已被ICCV 2019 接收为口头报告论文。

作者顺手提供了PR乘积版本的Dense层、卷积层和LSTM单元的PyTorch代码,即拆即用。

由于篇幅有限,剩余五篇的论文推荐精选请扫描下方二维码继续阅读——

-

偷懒有理!使用半解码的JPEG图片让网络提速1.77倍 论文名称: FASTER NEURAL NETWORKS STRAIGHT FROM JPEG -

回顾20年来的目标检测:干货 论文名称: Object Detection in 20 Years: A Survey -

球形文本嵌入 论文名称: Spherical Text Embedding -

自行车共享系统的具有预期任务收益的机制设计 论文名称: Mechanism Design with Predicted Task Revenue for Bike Sharing Systems -

用于语言理解的语义感知BERT 论文名称: Semantics-aware BERT for Language Understanding

(扫码直达,可直接跳转下载论文)

阅读原文浏览剩余五篇论文推荐

↓↓↓