2020年AI领域有哪些让人惊艳的研究?

极市导读

2020年AI领域涌现了许多优秀的研究成果和文章,本文为大家节选了transformer、自然语言处理、迁移学习等领域的一些令人眼前一亮的研究成果,回顾2020年AI科研界的足迹。 >>加入极市CV技术交流群,走在计算机视觉的最前沿

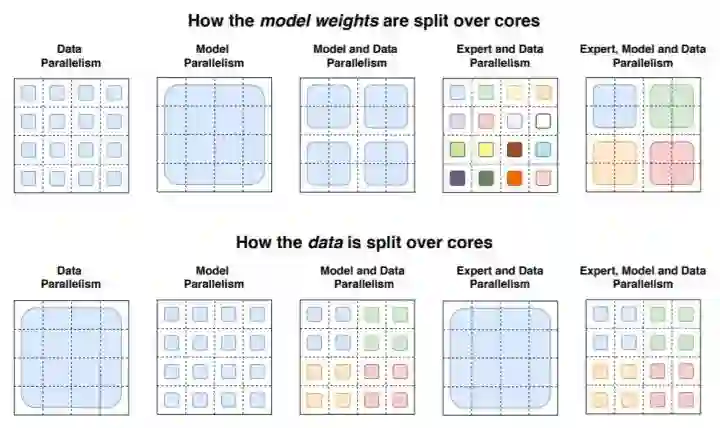

Switch Transformer

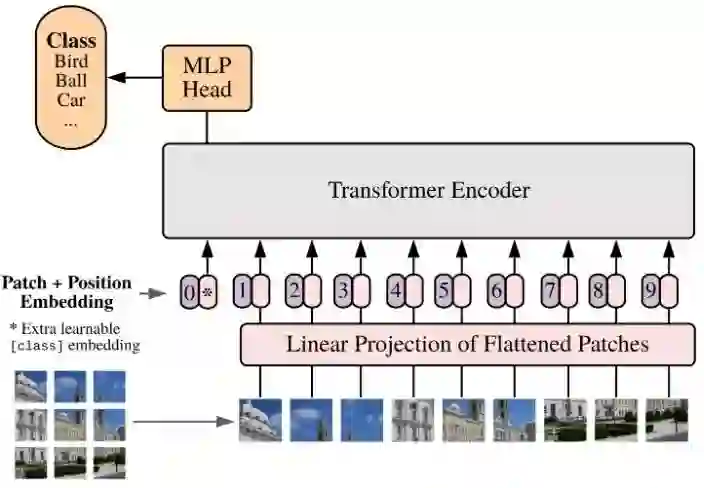

Image Transformers

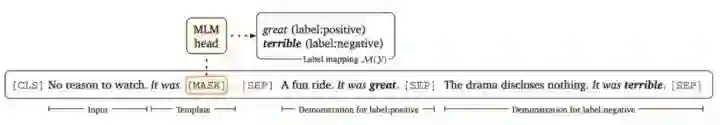

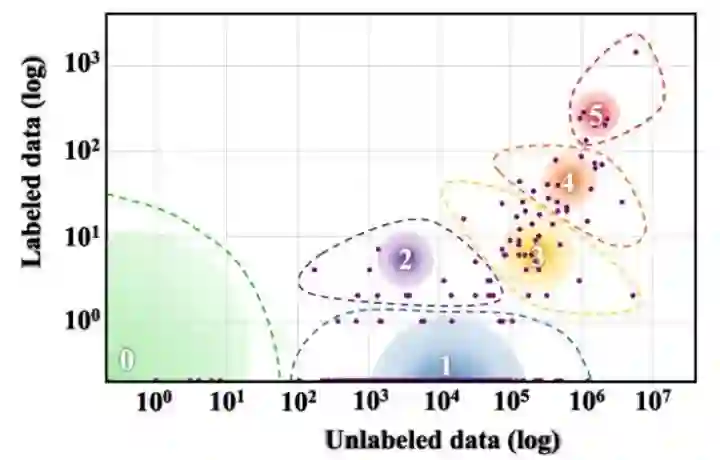

Few-shot Learning

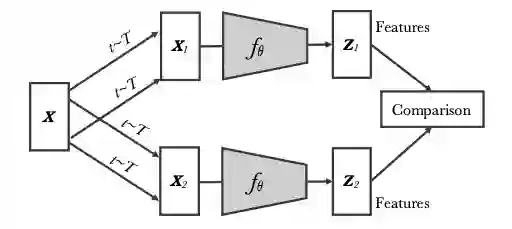

Contrastive Learning

Multilinguality

-

SQuAD: XQuAD (Artetxe et al., 2020), MLQA (Lewis et al., 2020), FQuAD (d'Hoffschmidt et al., 2020) -

Natural Questions: TyDiQA (Clark et al., 2020), MKQA (Longpre et al., 2020) -

MNLI: OCNLI (Hu et al., 2020), FarsTail (Amirkhani et al., 2020) -

the CoNLL-09 dataset: X-SRL (Daza and Frank, 2020) -

the CNN/Daily Mail dataset: MLSUM (Scialom et al., 2020)

Reinforcement Learning

参考内容

2、https://ruder.io/research-highlights-2020/

推荐阅读

登录查看更多

相关内容

Transformer是谷歌发表的论文《Attention Is All You Need》提出一种完全基于Attention的翻译架构