开学综合症有救了!17篇最新AI论文不容错过(附链接)

来源:PaperWeekly

本文多干货,建议收藏。

本文为大家准备了最新AI领域的论文。

@jingyihiter 推荐

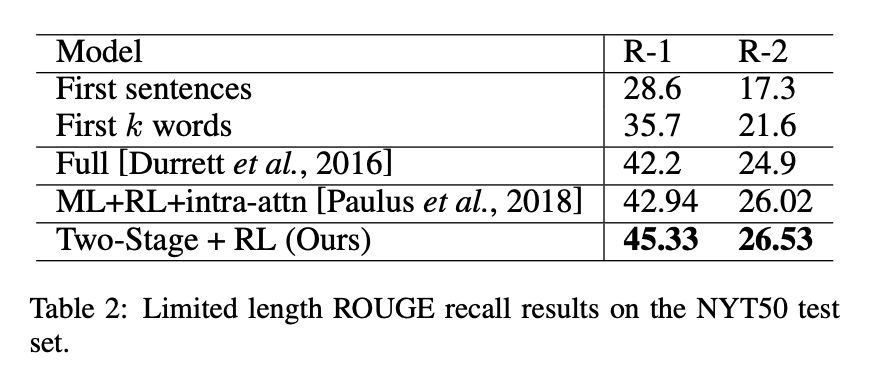

#Text Generation

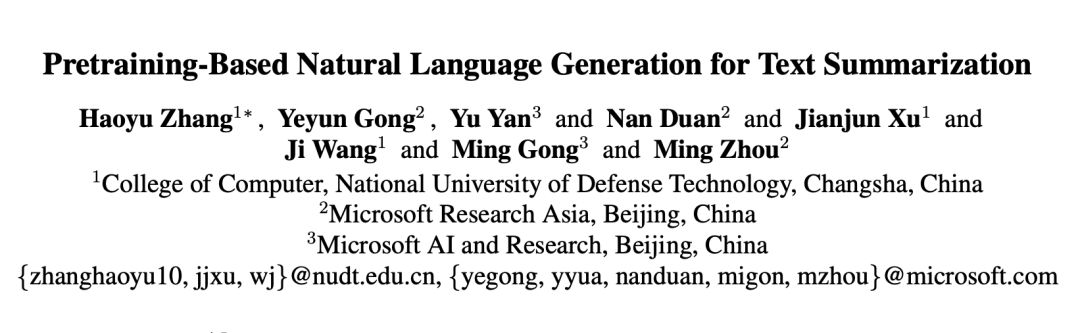

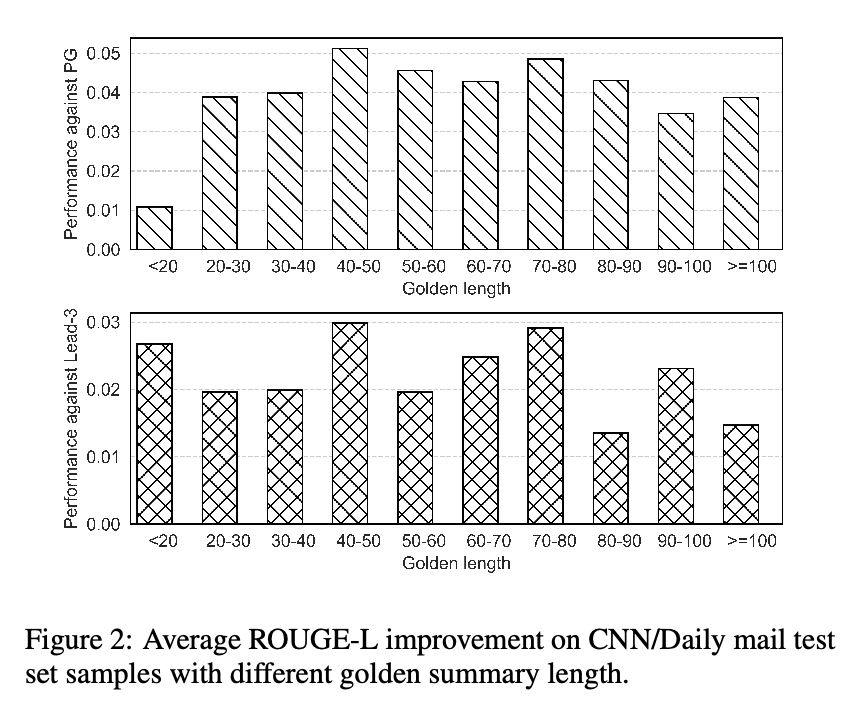

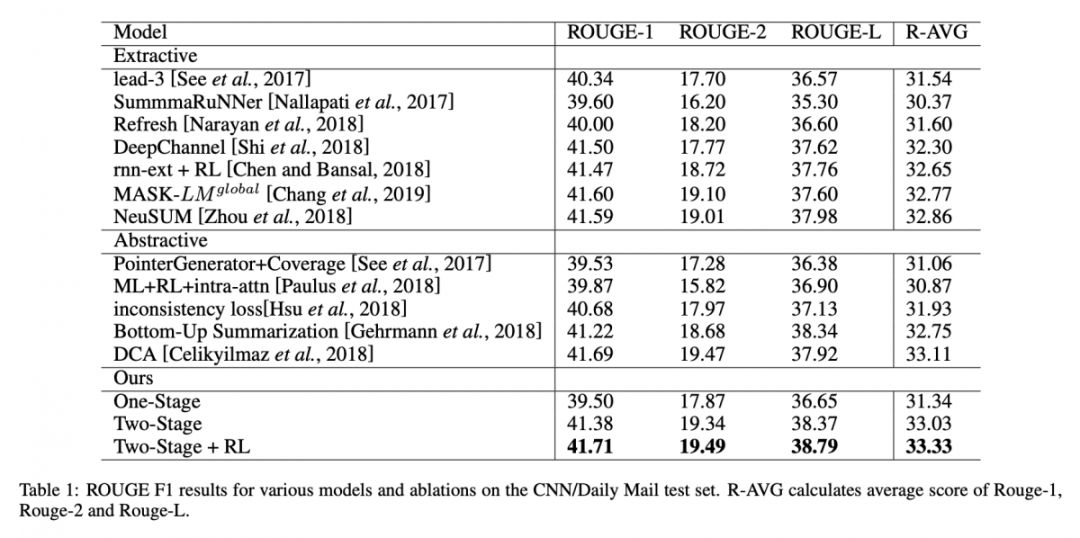

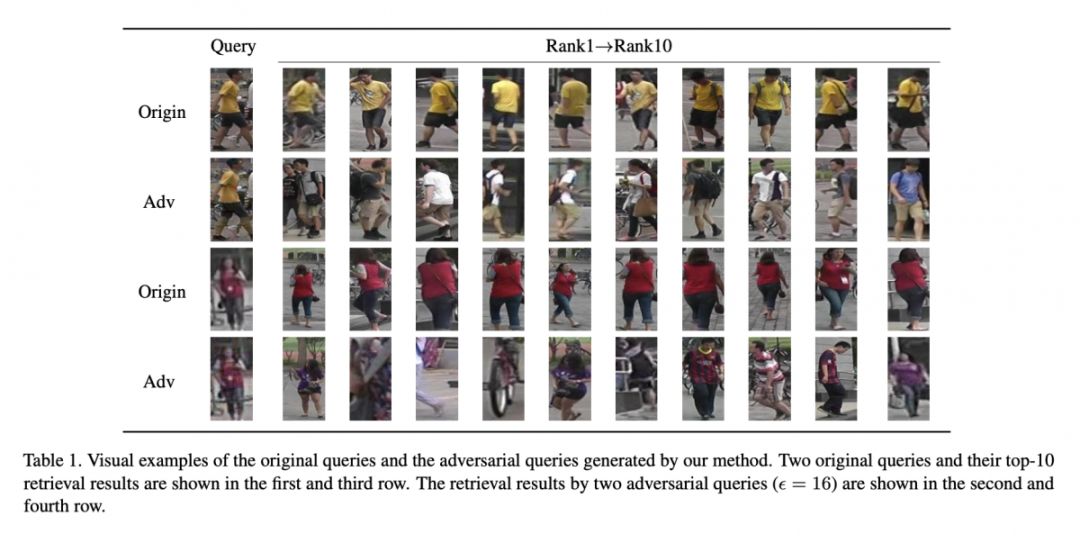

本文来自国防科大和微软亚研院,文章提出 pre-training-based 的 encoder-decoder 框架,encoder 采用 BERT 将输入序列表示为 context 向量,decoder 分为两阶段:

第一阶段采用 transformer-based 解码生成伪输出序列;

第二阶段对伪输出序列进行 mask 送入 BERT 表示,将输入序列与伪输出序列联合,解码预测输出序列。

文章首次将 BERT 应用于文本生成任务,在 CNN/Daily Mail 和 New York Times 数据集上达到 SOTA 的结果。

论文模型:点击查看大图

论文链接

https://www.paperweekly.site/papers/2855

@QAQ 推荐

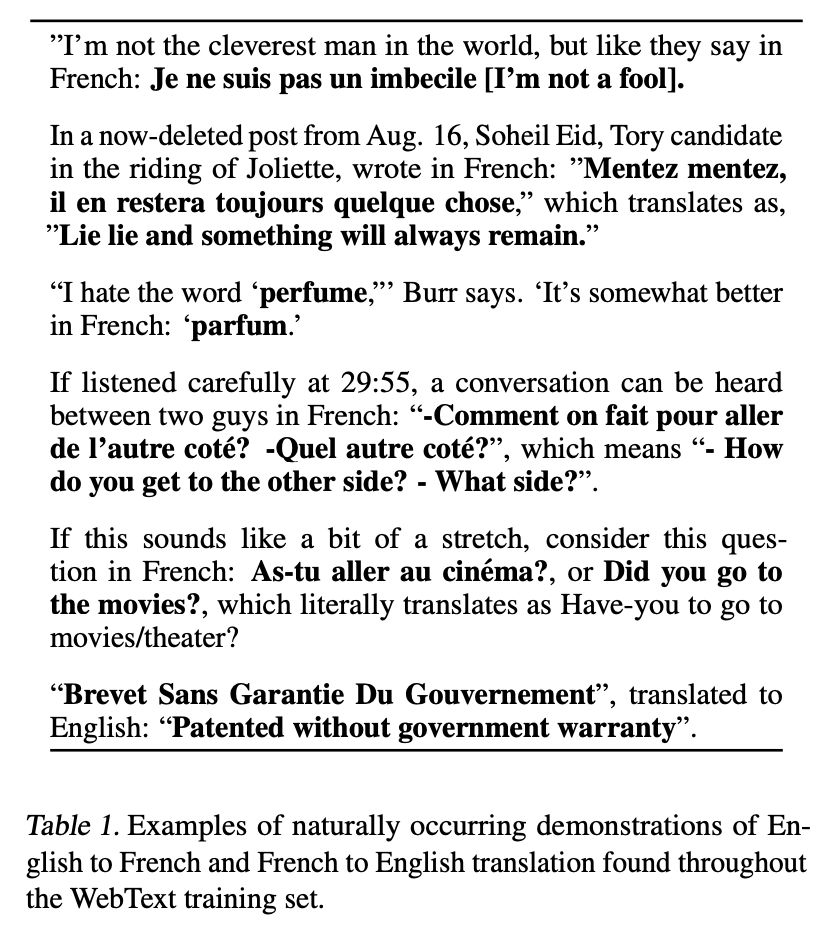

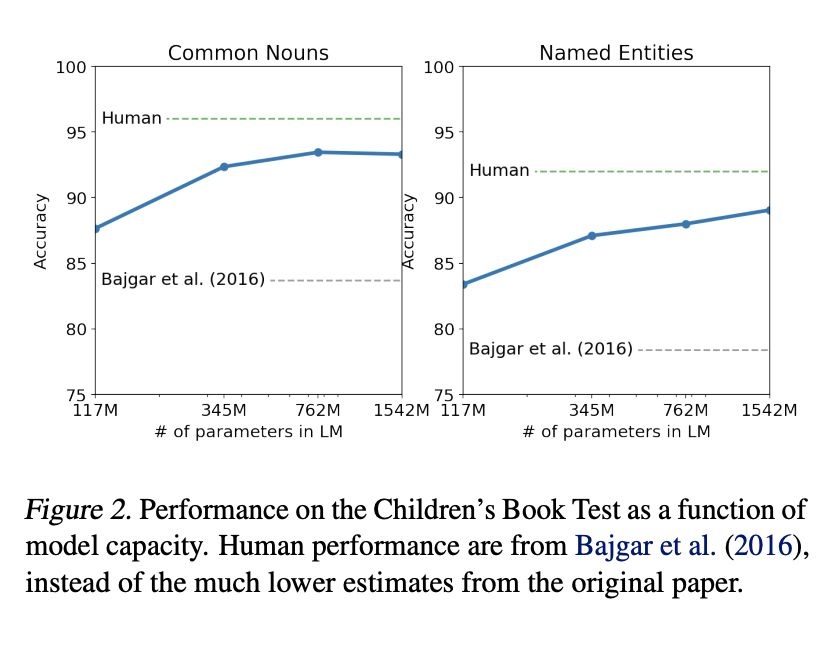

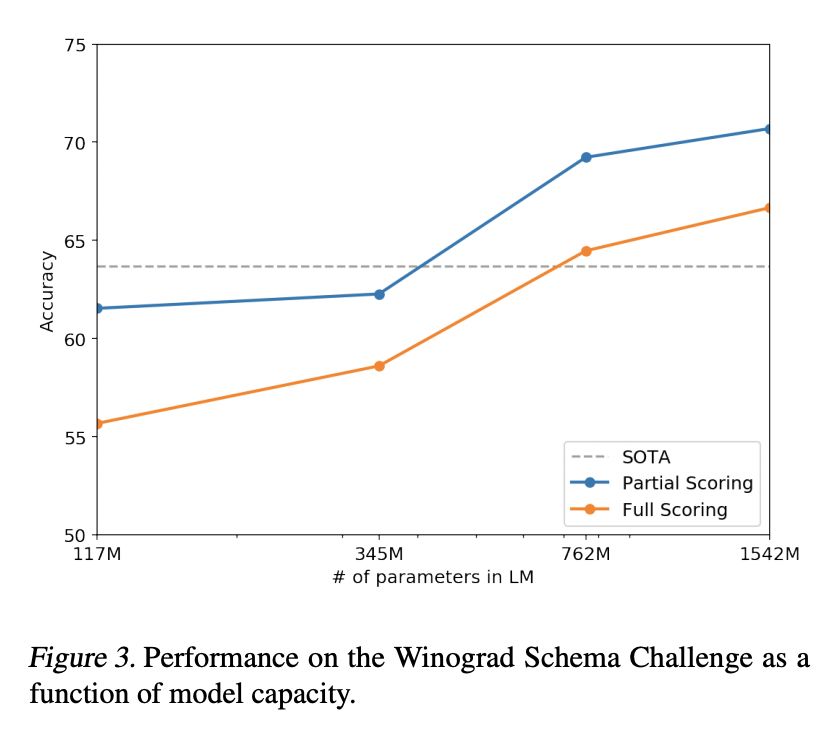

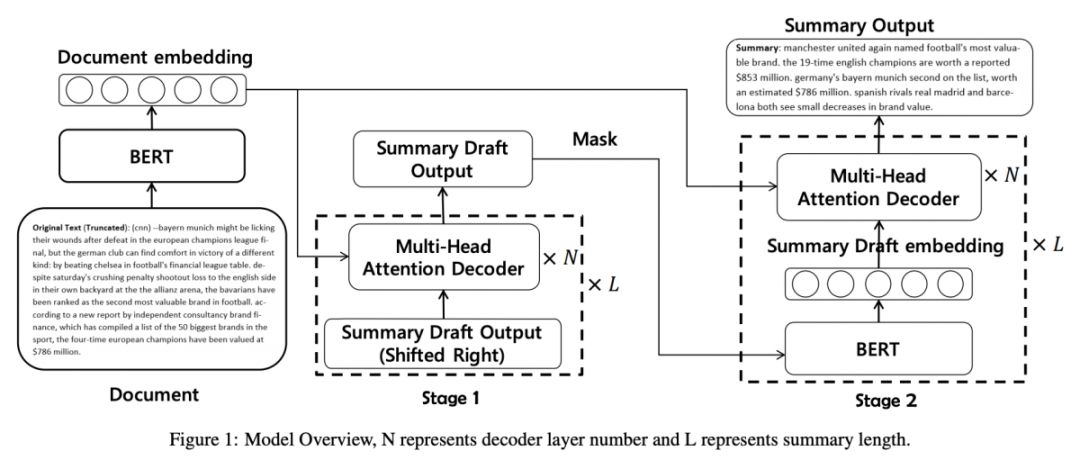

#Language Model

本文介绍了来自 OpenAI 的新语言模型 GPT-2,其在文本生成任务上达到接近人类水平,可生成论文(并编造数据与引用使论证看上去合理)、续写幻想故事。在多个数据集上碾压当前结果。在未经专门训练的情况下实现翻译与阅读理解。不足是会出现重复文本与世界建模失败(如在水下发生火灾)。

论文模型:点击查看大图

论文链接

https://www.paperweekly.site/papers/2822

源码链接

https://github.com/openai/gpt-2

@rico93 推荐

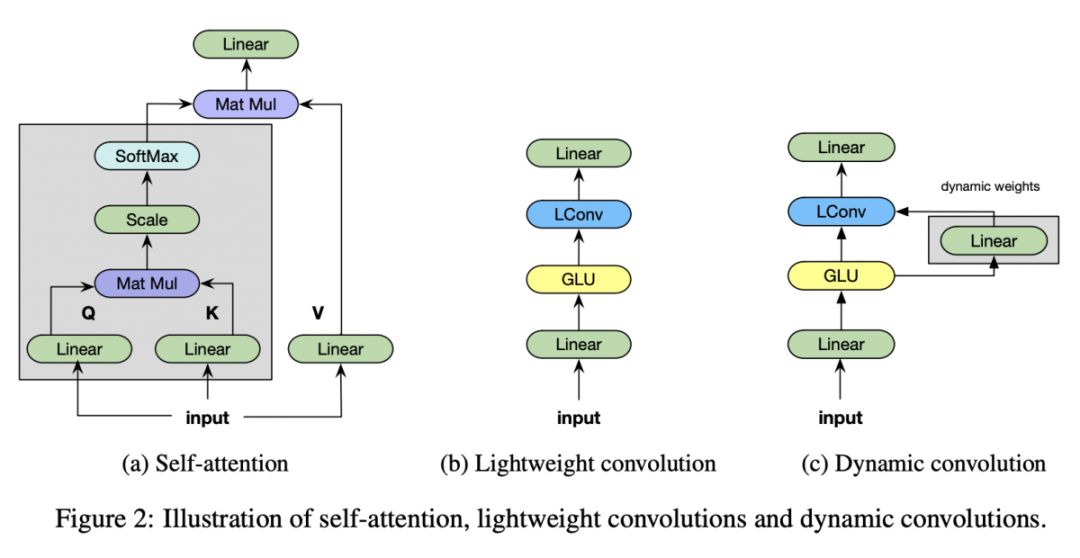

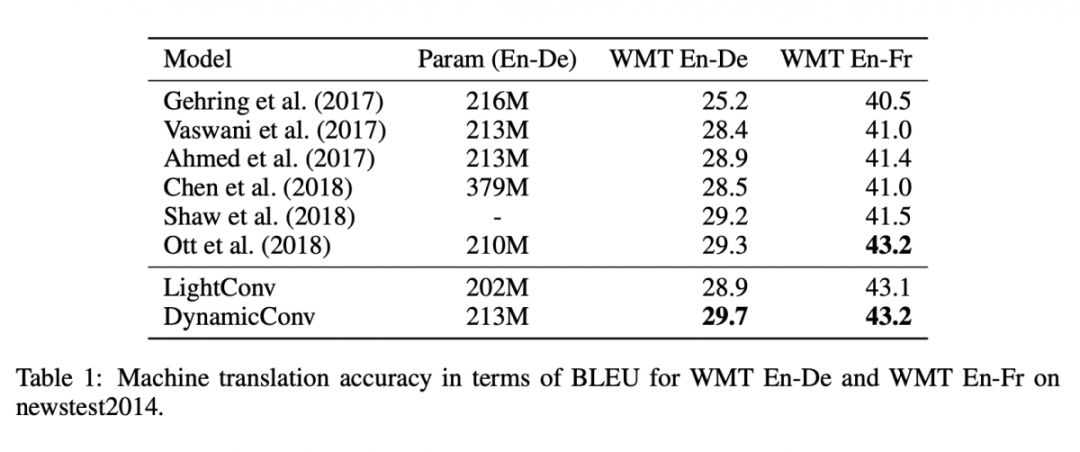

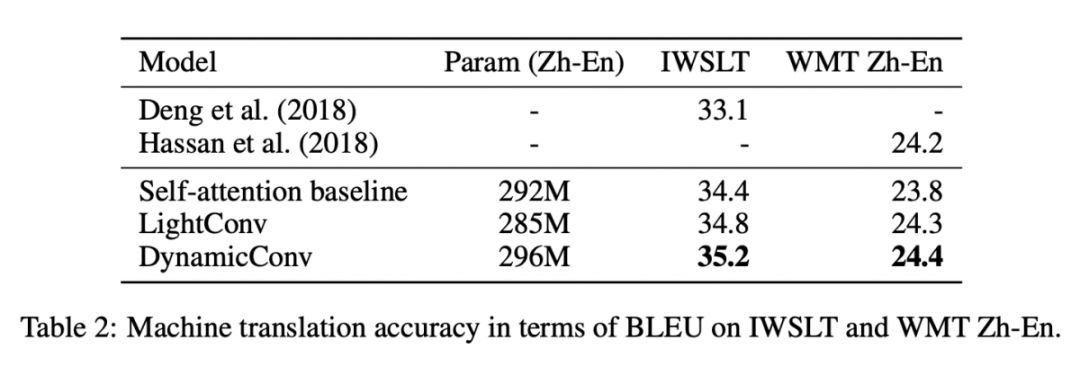

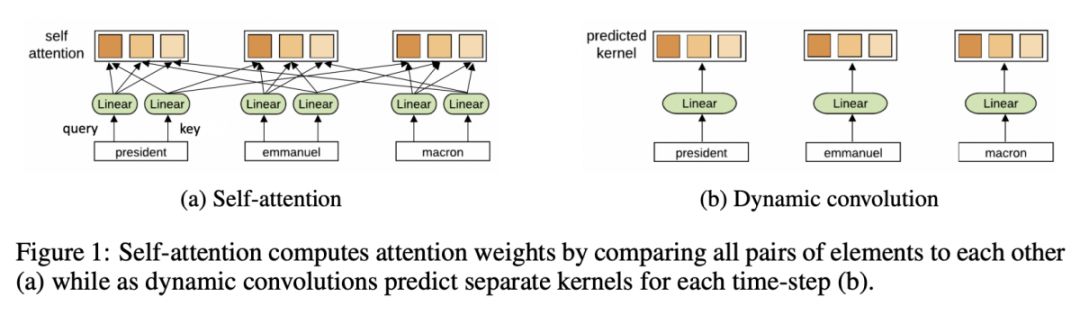

#Attention Mechanism

本文来自康奈尔大学和 Facebook AI Research,论文提出的 lightweight convolution 模型相对于 Transformer 来说能达到一致的水平,但只需要更少的操作数量,运算速度比 Transformer 快 20%。

论文模型:点击查看大图

论文链接

https://www.paperweekly.site/papers/2801

源码链接

https://github.com/pytorch/fairseq

@Ttssxuan 推荐

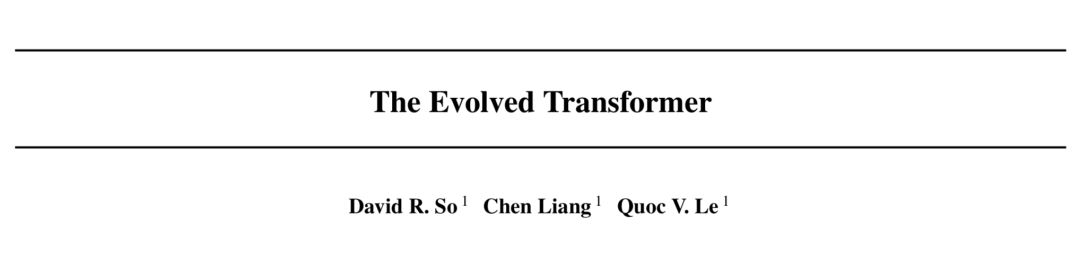

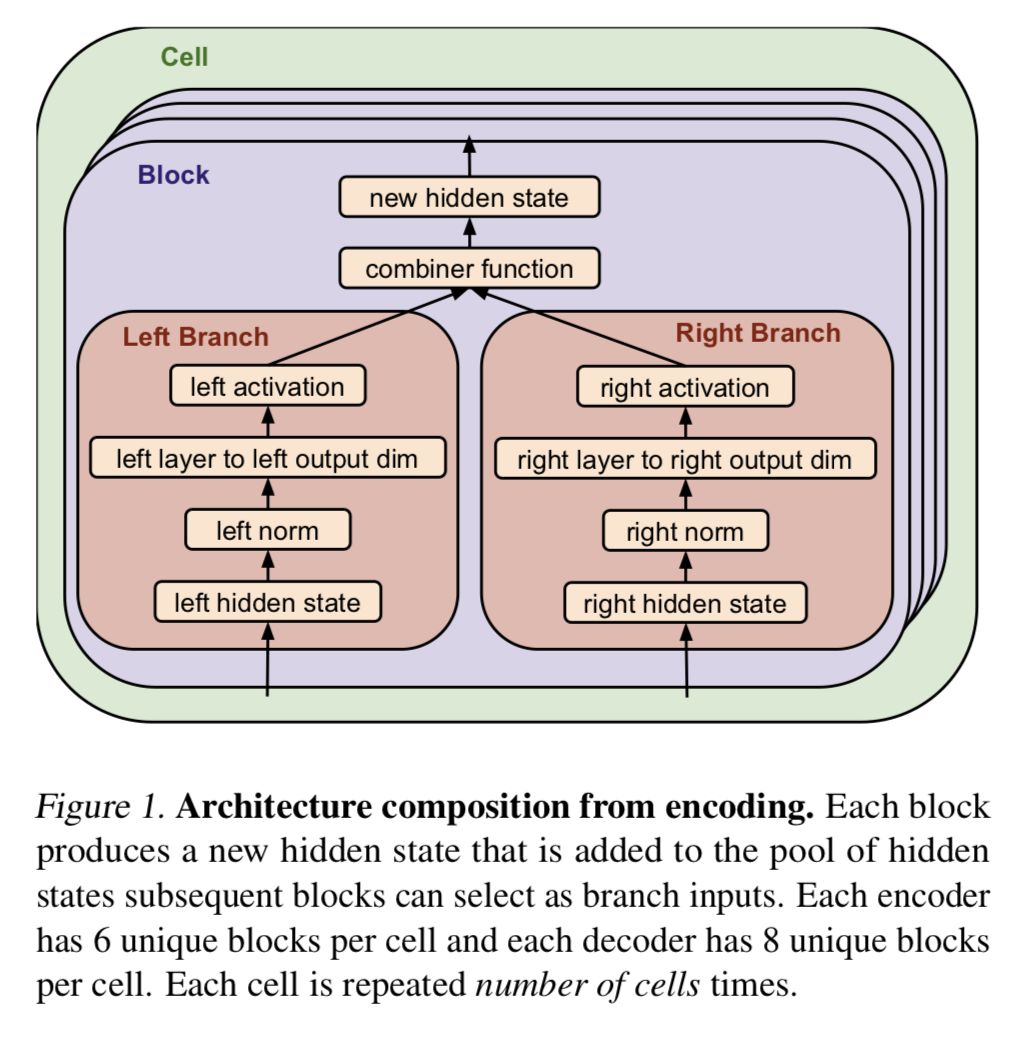

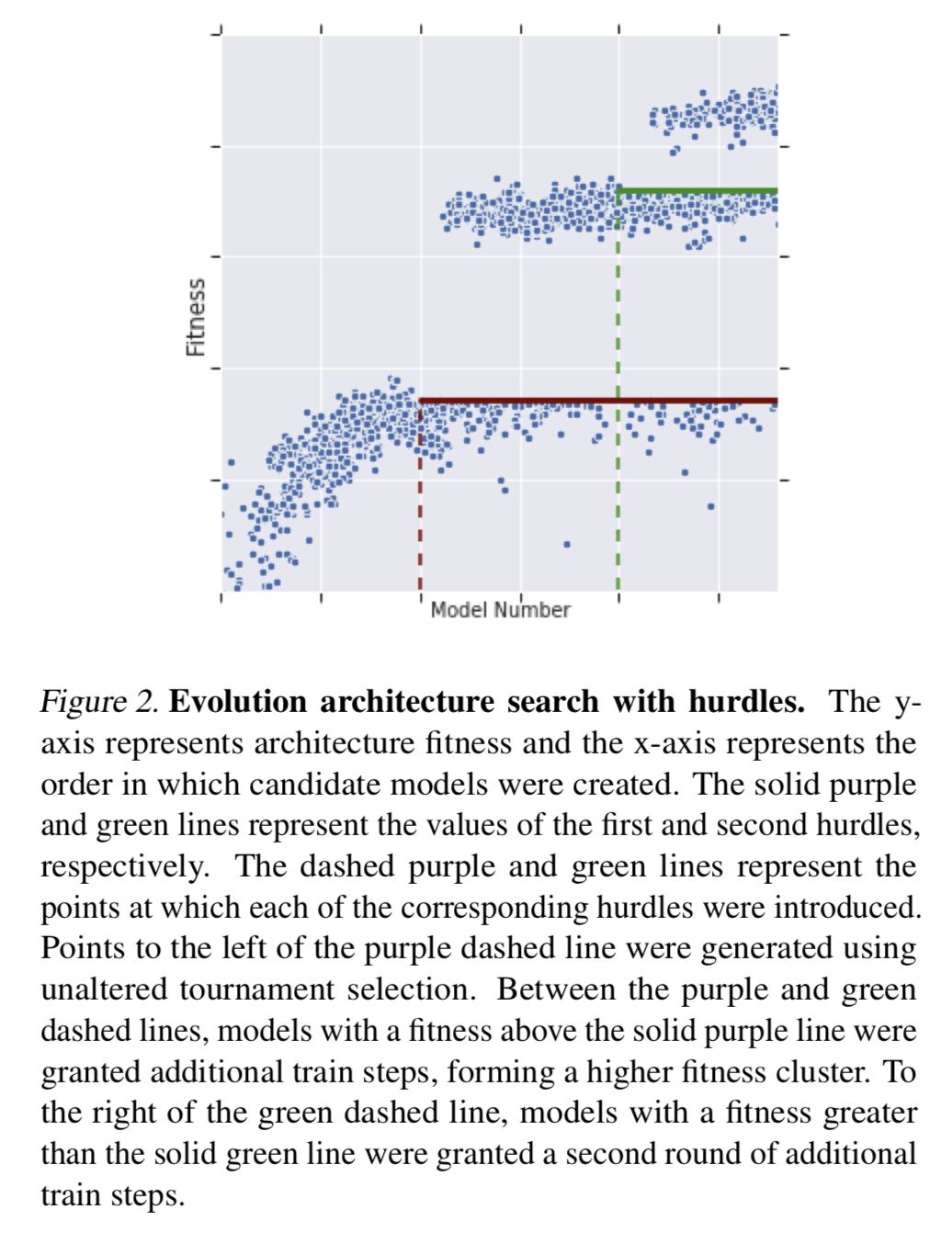

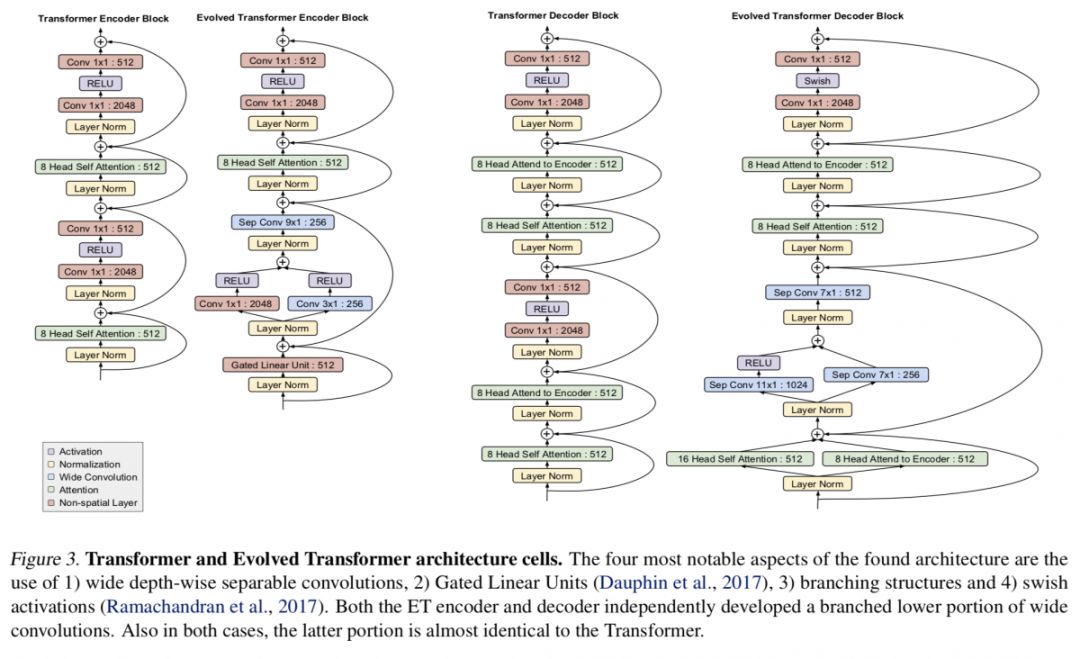

#Auto ML

本文来自 Google Brain,论文提出了 progressive dynamic hurdles (PDH) 神经网络架构搜索方法,此方法能够动态的把资源分配到相对优秀的候选者,最终得到“Evolved Transformer”,其在几个翻译任务(WMT 2014 English-German, WMT 2014 English-French, WMT 2014 English-Czech, LM1B)相对原始 Transformer 有一致的提升,并且有更高的计算效率和更少的参数量。

论文模型:点击查看大图

论文链接

https://www.paperweekly.site/papers/2817

@paperweekly 推荐

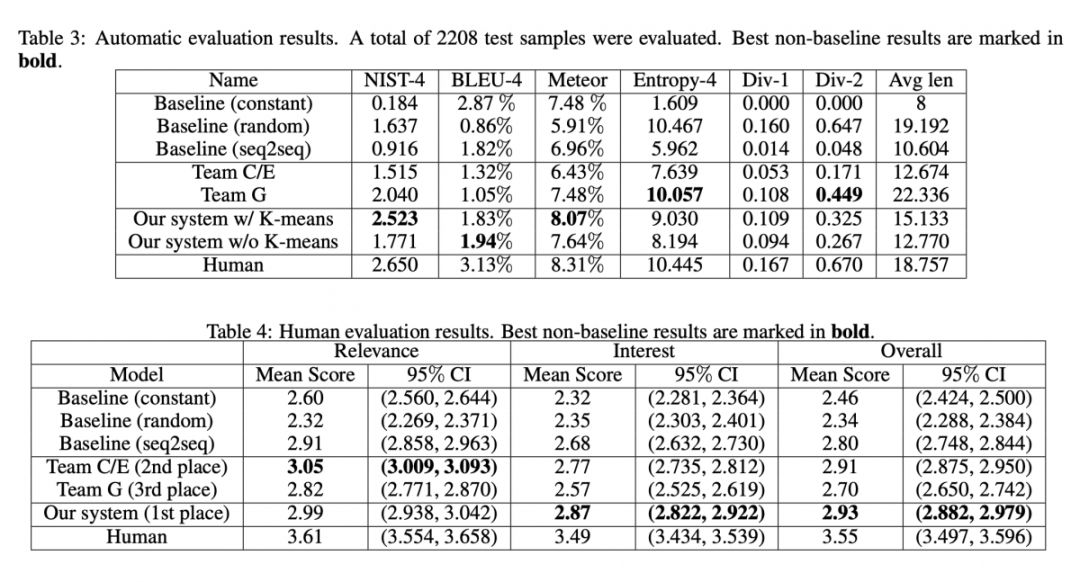

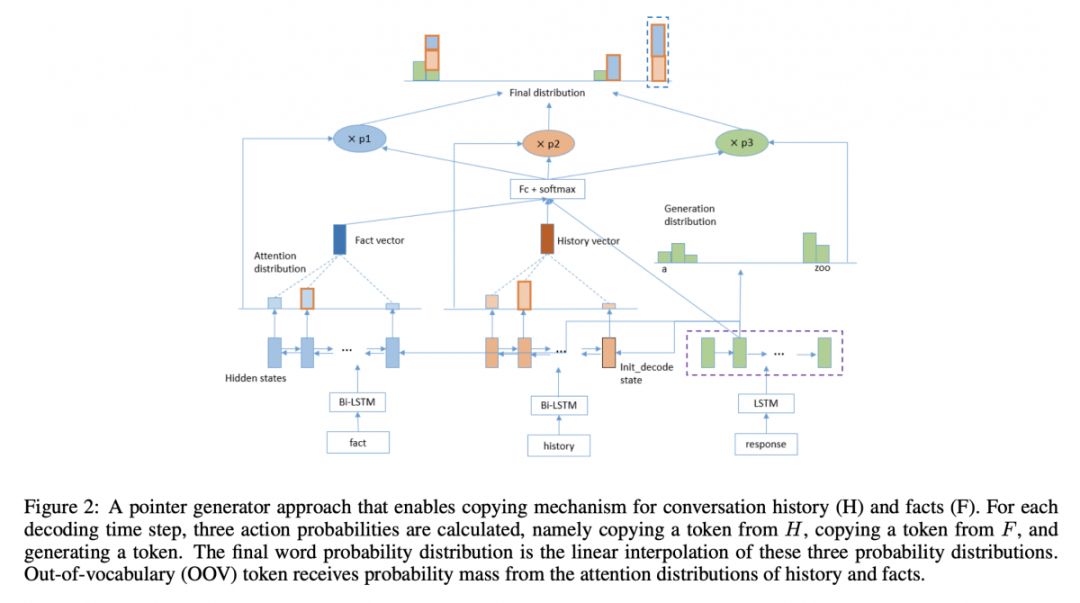

#Dialog System

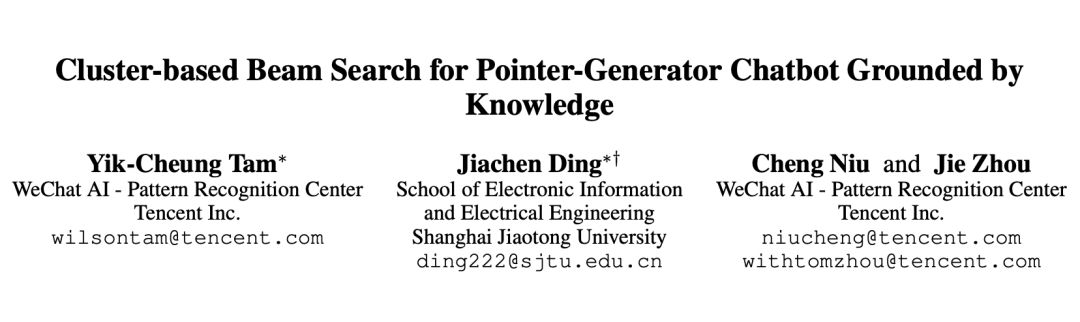

本文是微信 AI 团队和上海交大发表于 AAAI 2019 的工作,论文关注的任务是基于背景知识的对话生成,通过指针生成机制和注意力机制,基于对话历史和背景知识生成更有意义的回复。作者提出了一个泛化的指针生成机制,能同时从对话历史和外部知识中复制实体。此外,作者还提出了一种 Cluster-based Beam Search 算法,能在解码时动态地将相似语义的序列分组归类,避免生成通用回复。

论文模型:点击查看大图

论文链接

https://www.paperweekly.site/papers/2845

@VanceChen 推荐

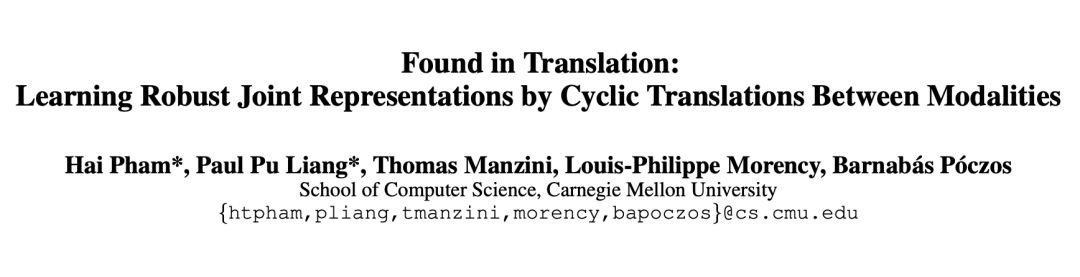

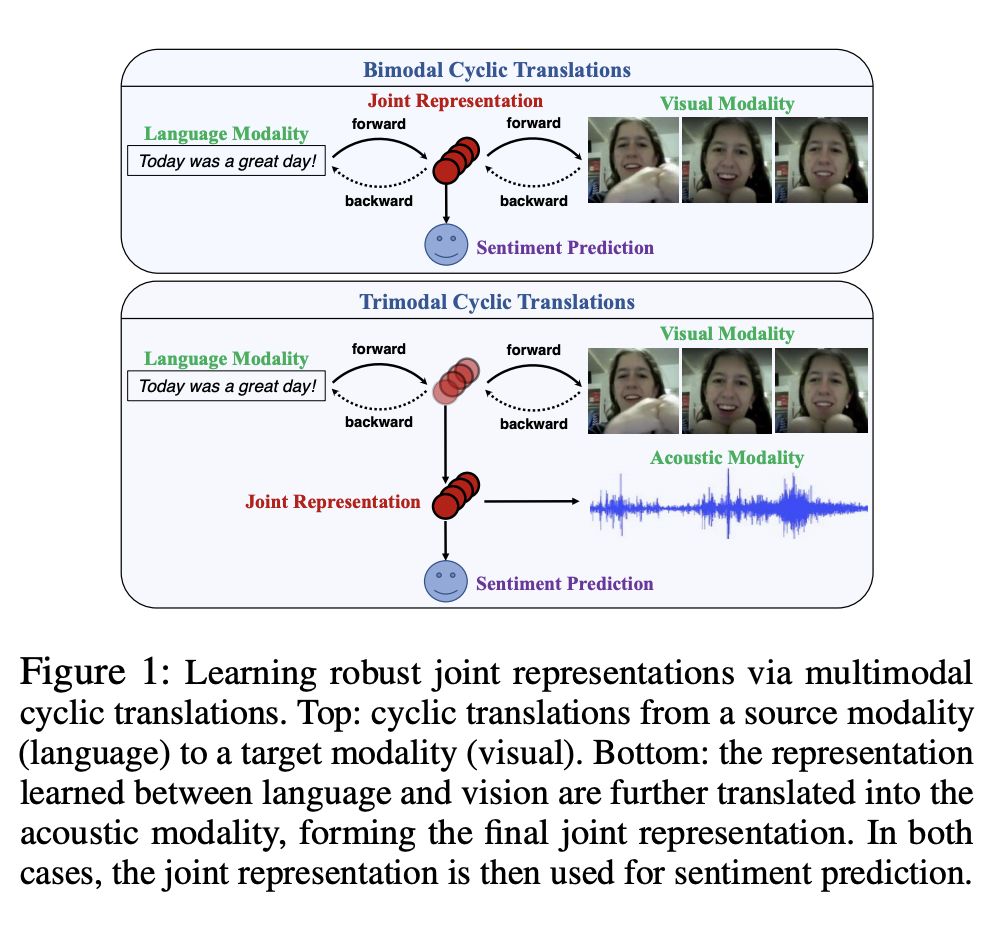

#Multimodal Sentiment Analysis

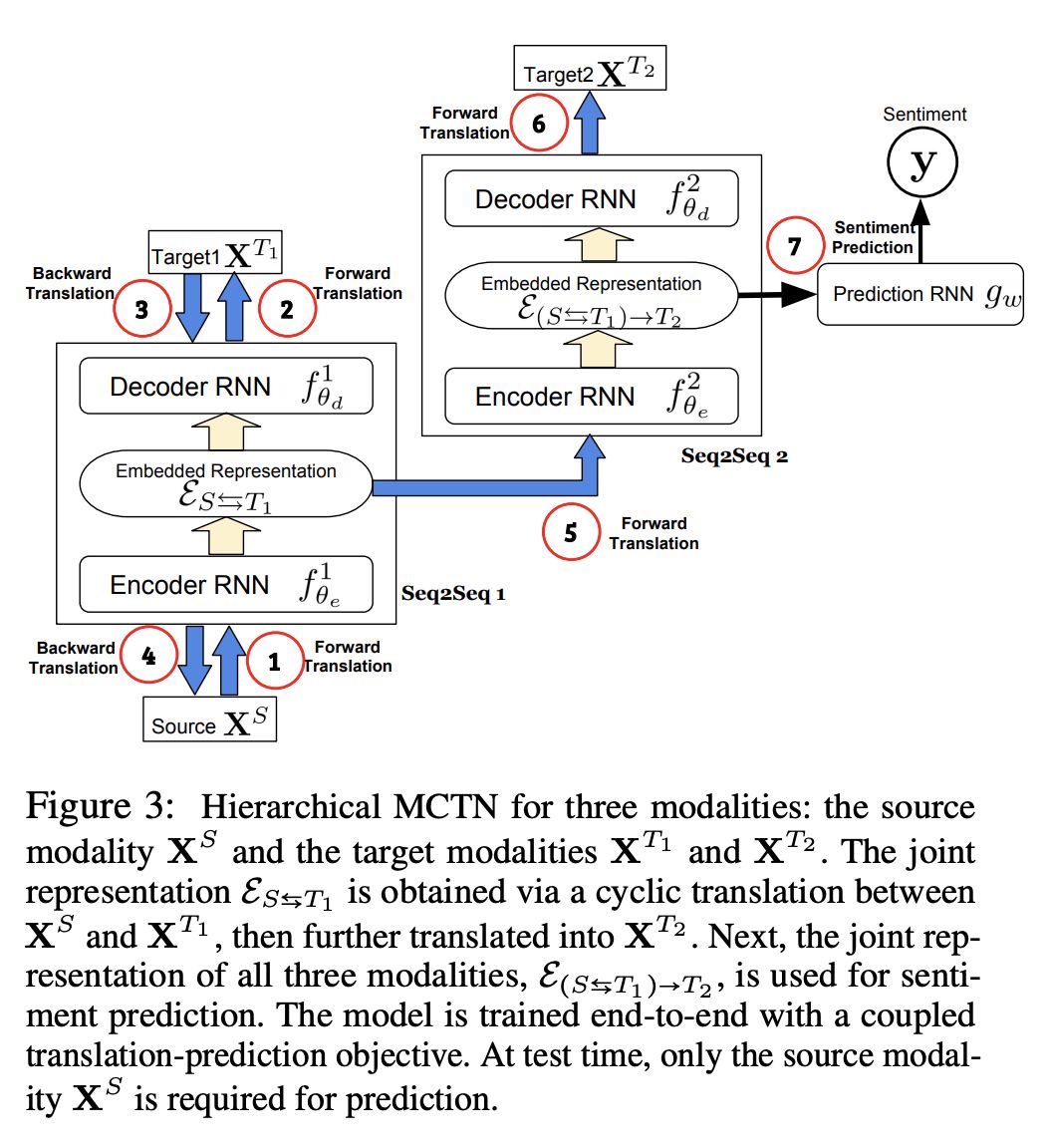

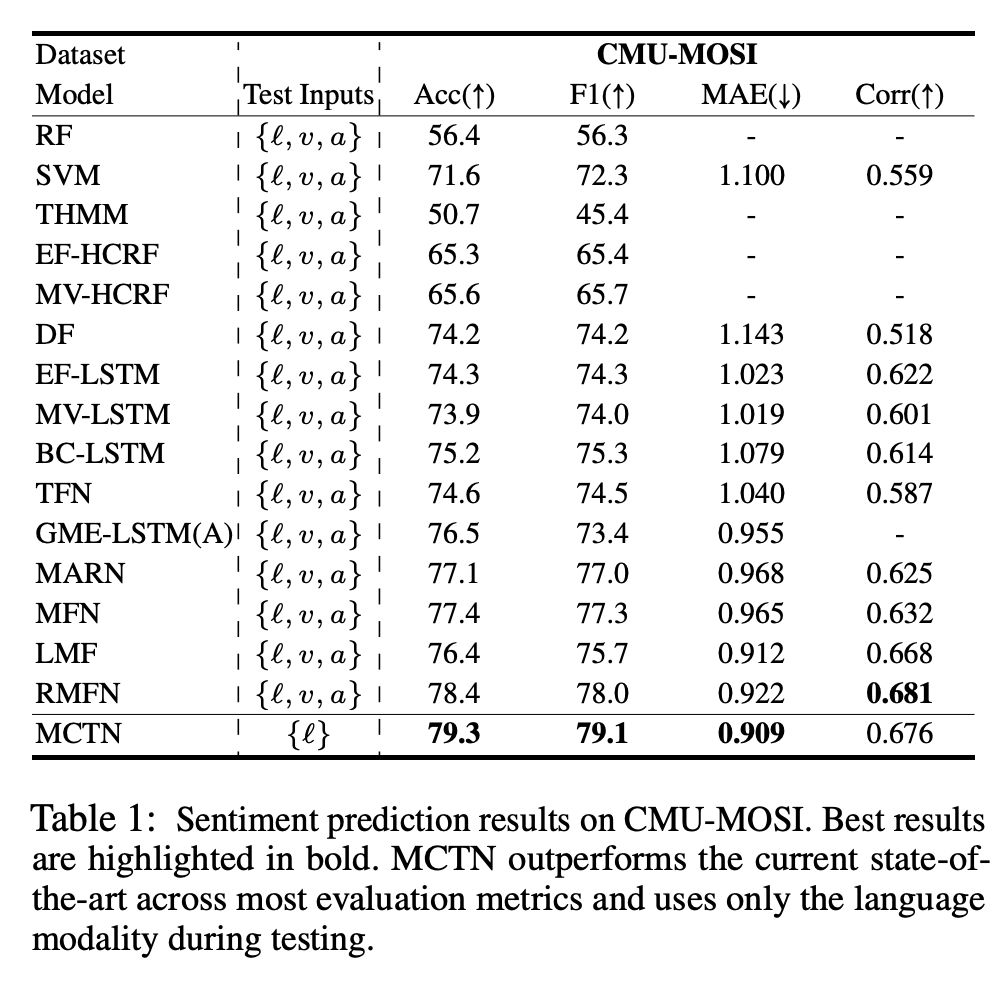

本文是 CMU 的 MultiComp Lab 发表在 AAAI 2019 上的工作。多模态情感分析是 NLP 的一个新的核心研究领域,研究从语言、视觉和声学模态表达的说话人情绪。多模式学习的核心挑战涉及可以处理和关联这些模态信息的推断联合表示。然而,现有工作通过要求所有模态作为输入来学习联合表示,因此,学习的表示可能对测试时的噪声或丢失模态敏感。

随着机器翻译中 Seq2Seq 模型的成功,有机会探索在测试时可能不需要所有输入模态的联合表示的新方法。论文提出了一种通过在模态之间进行转换来学习鲁棒联合表示的方法。论文的方法基于 Key Insight,即从源到目标模态的转换提供了仅使用源模态作为输入来学习联合表示的方法。

论文使用周期一致性损失来增加模态转换,以确保联合表示保留所有模态的最大信息。一旦翻译模型使用配对的多模态数据进行训练,我们只需要在测试时从源模态获得最终情绪预测的数据。这确保了我们的模型在其他模态中不受扰动或缺失信息的影响。

我们使用耦合的翻译预测目标训练我们的模型,并在多模态情绪分析数据集上实现新的最新结果:CMU-MOSI,ICT-MMMO 和 YouTube。 另外的实验表明,我们的模型学习越来越多的判别性联合表示,具有更多的输入模态,同时保持对丢失或扰动模态的鲁棒性。

论文模型:点击查看大图

论文链接

https://www.paperweekly.site/papers/2789

源码链接

https://github.com/hainow/MCTN

@paperweekly 推荐

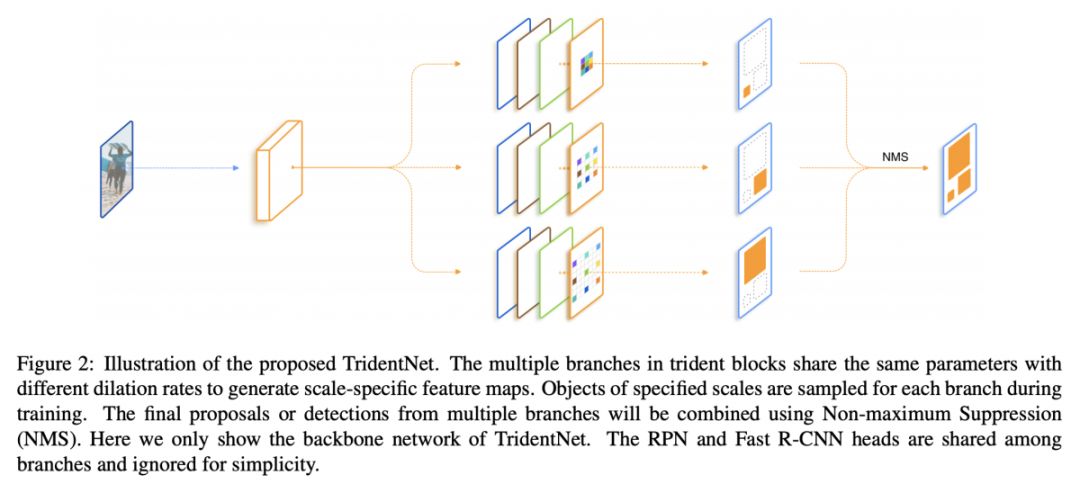

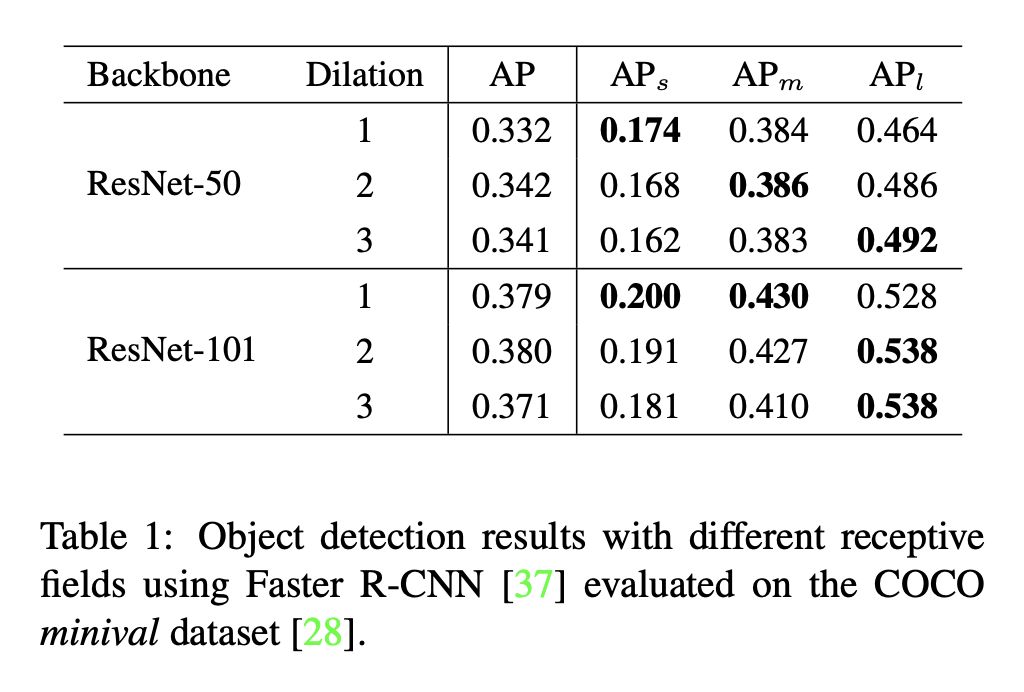

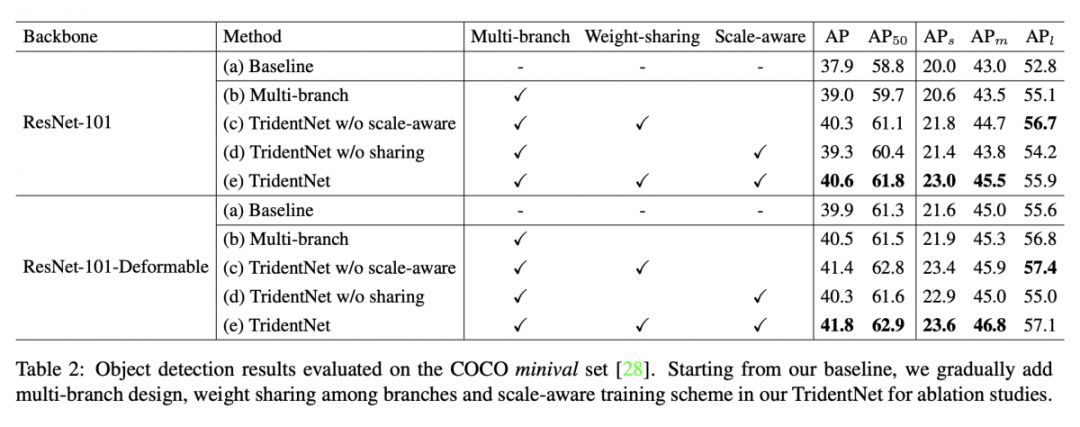

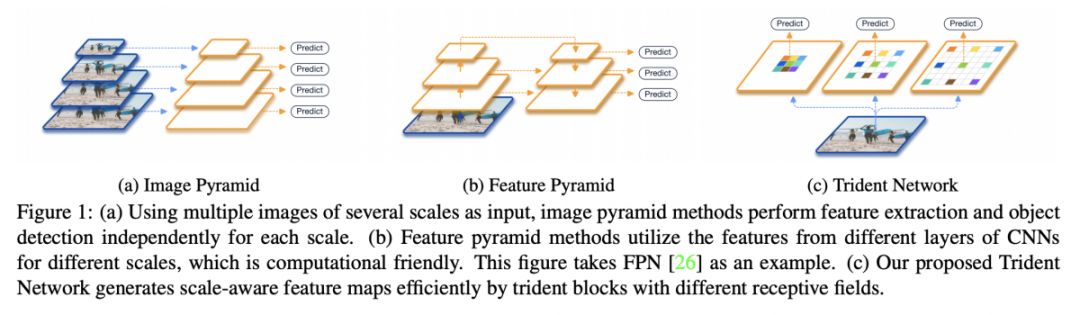

#Object Detection

本文来自中国科学院大学和图森未来。检测任务中存在目标尺寸多样化的问题,为了解决这一问题,涌现了很多包含 SSD、FPN、SNIP 等在内的经典算法。基于感受野对不同尺度目标的检测影响,作者提出了一个全新的三叉戟网络(TridentNet)。

为了使模型对不同尺寸目标的“表达能力”近似,作者借鉴了 SNIP 的特征提取网络,采用了“scale-aware”的并行结构。为了加快模型的推理速度,作者采用了 dilated convolution 得到不同感受野的特征图,从而实现检测不同尺度目标的目的,取代了 SNIP 中的特征金字塔生成不同尺度目标的做法。

论文模型:点击查看大图

论文链接

https://www.paperweekly.site/papers/2833

@paperweekly 推荐

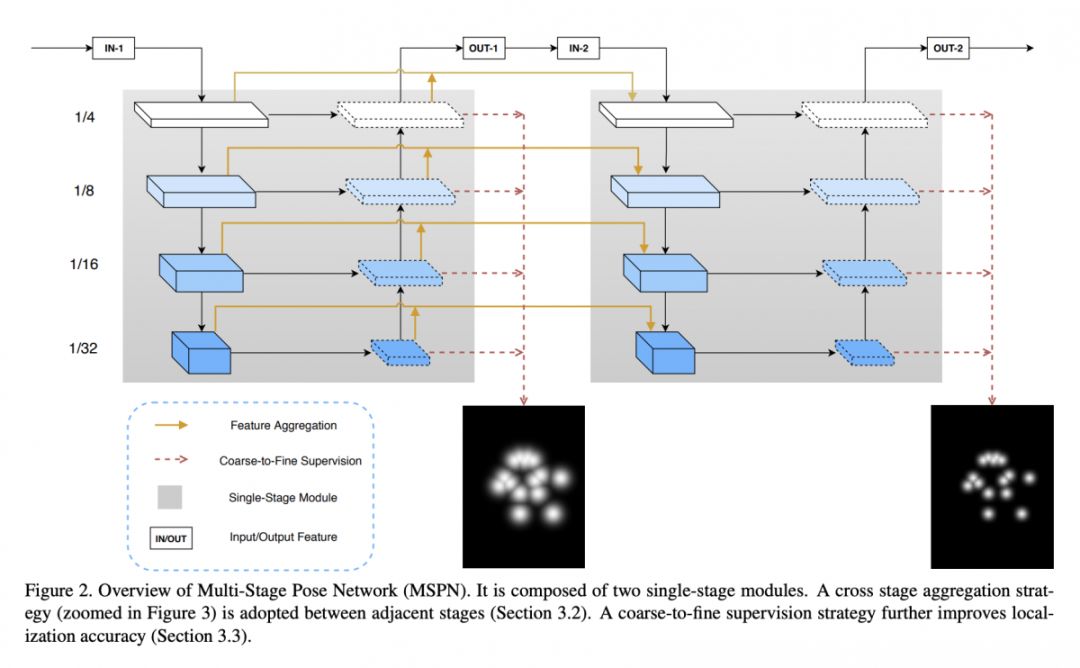

#Human Pose Estimation

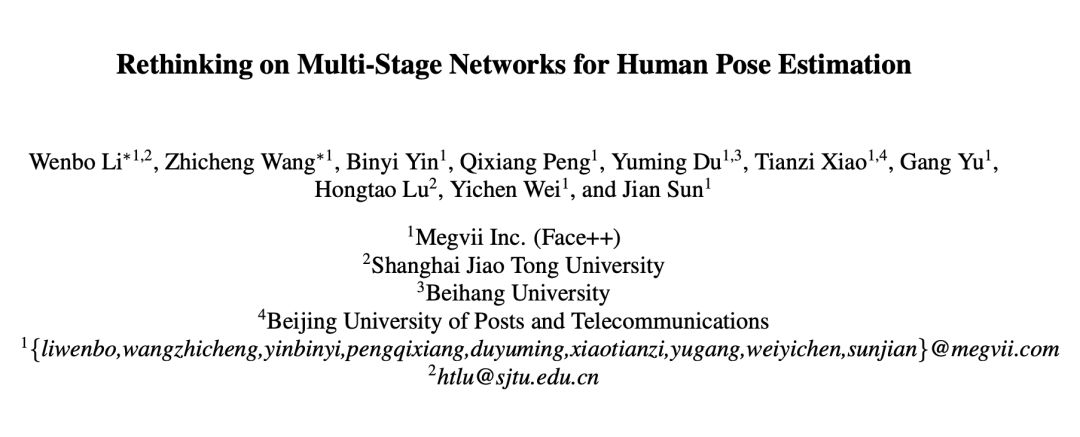

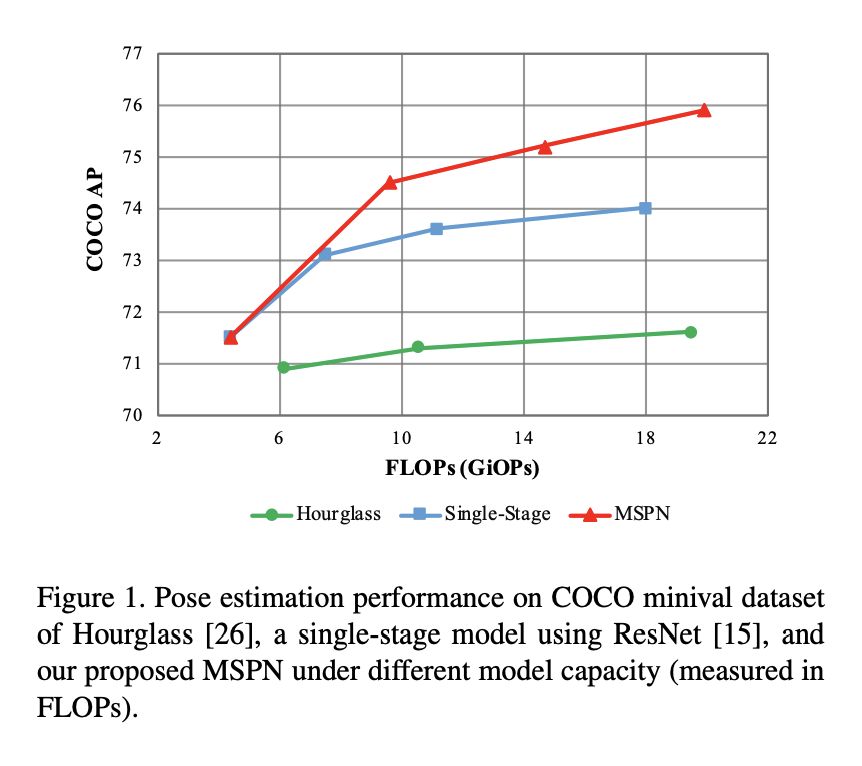

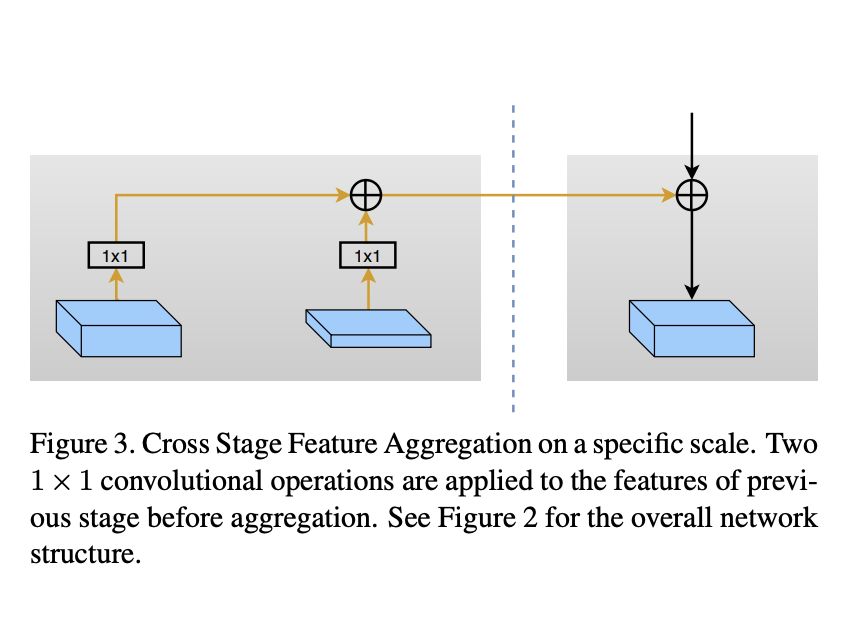

本文来自旷视科技,夺得 COCO Keypoints 2018 比赛冠军。本文旨在设计出一个好的 multi-stage 的人体姿态检测方法,随着网络 stage 数目增加,模型的预测能力能够逐步提高的网络。而不会像 Hourglass 及其它网络一样,增加 stage 数目并不会显著提高模型的预测能力。作者采用了 top-down 的解决思路,将重心放在对单人关节点的检测上。针对 multi-stage 算法存在的问题,作者分别进行了不同的探索。

论文模型:点击查看大图

论文链接

https://www.paperweekly.site/papers/2834

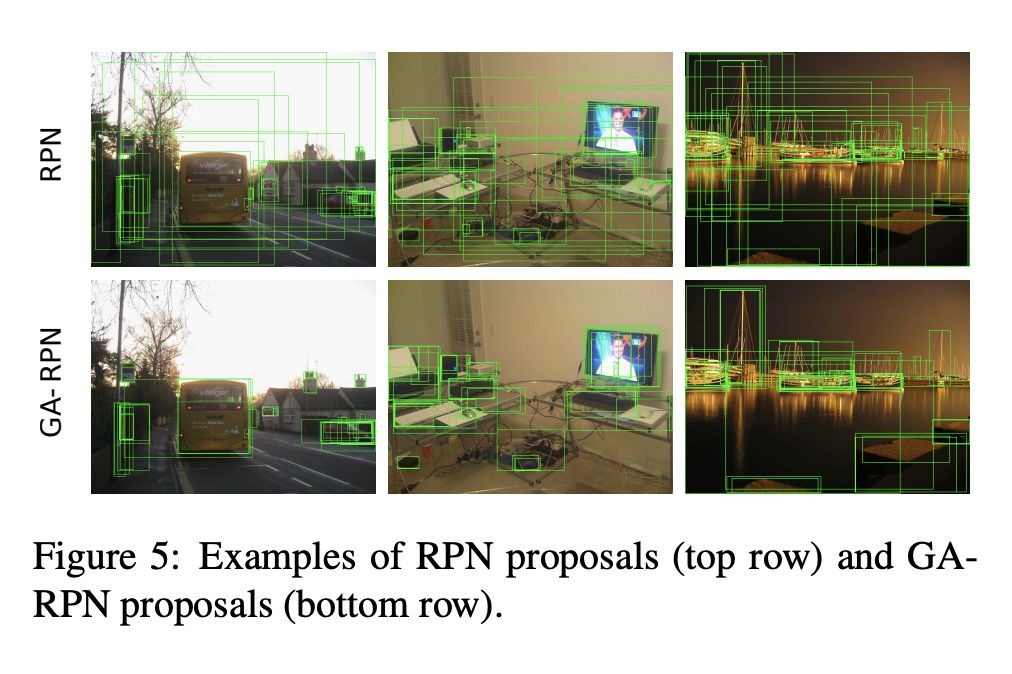

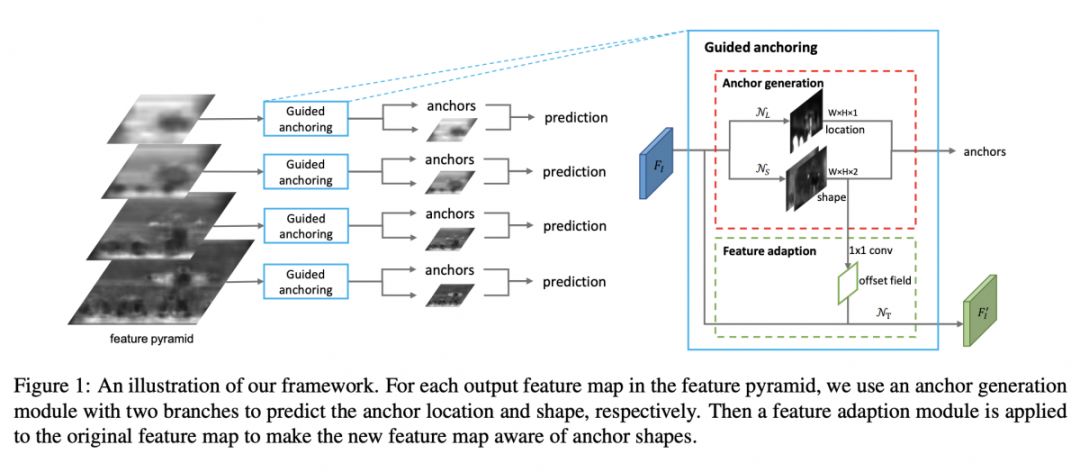

@Phil 推荐

#Object Detection

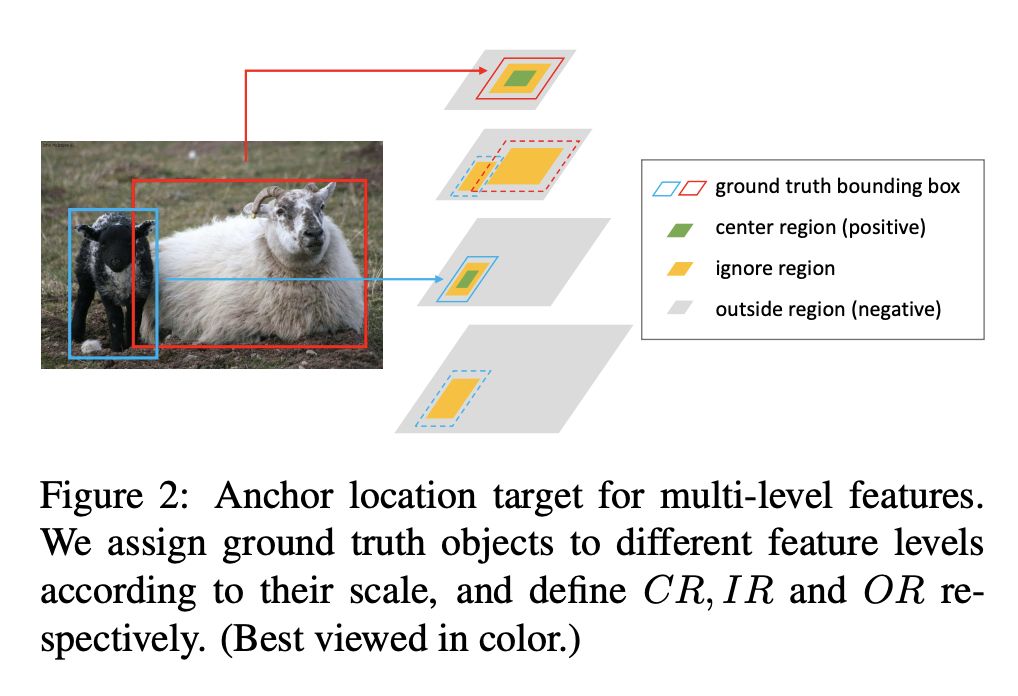

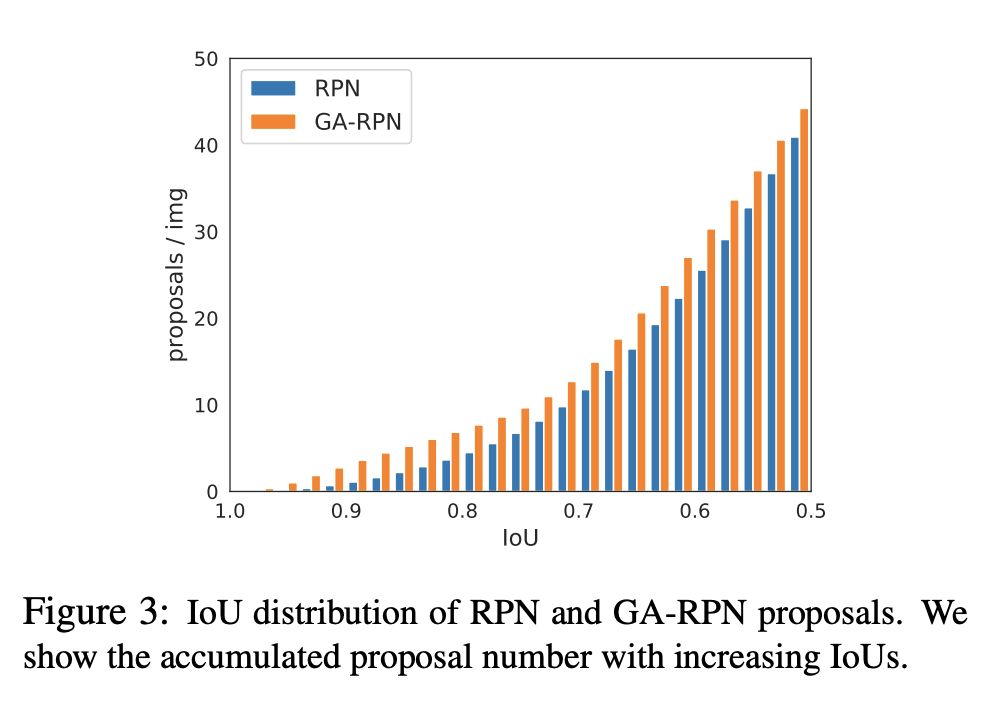

本文来自香港中文大学、商汤科技、Amazon 和南洋理工,论文提出了一种新的 anchor 生成方法——Guided Anchoring,即通过图像特征来指导 anchor 的生成。 通过预测 anchor 的位置和形状,来生成稀疏而且形状任意的 anchor,并且设计了 Feature Adaption 模块来修正特征图,使之与 anchor 形状更加匹配。

论文模型:点击查看大图

论文链接

https://www.paperweekly.site/papers/2806

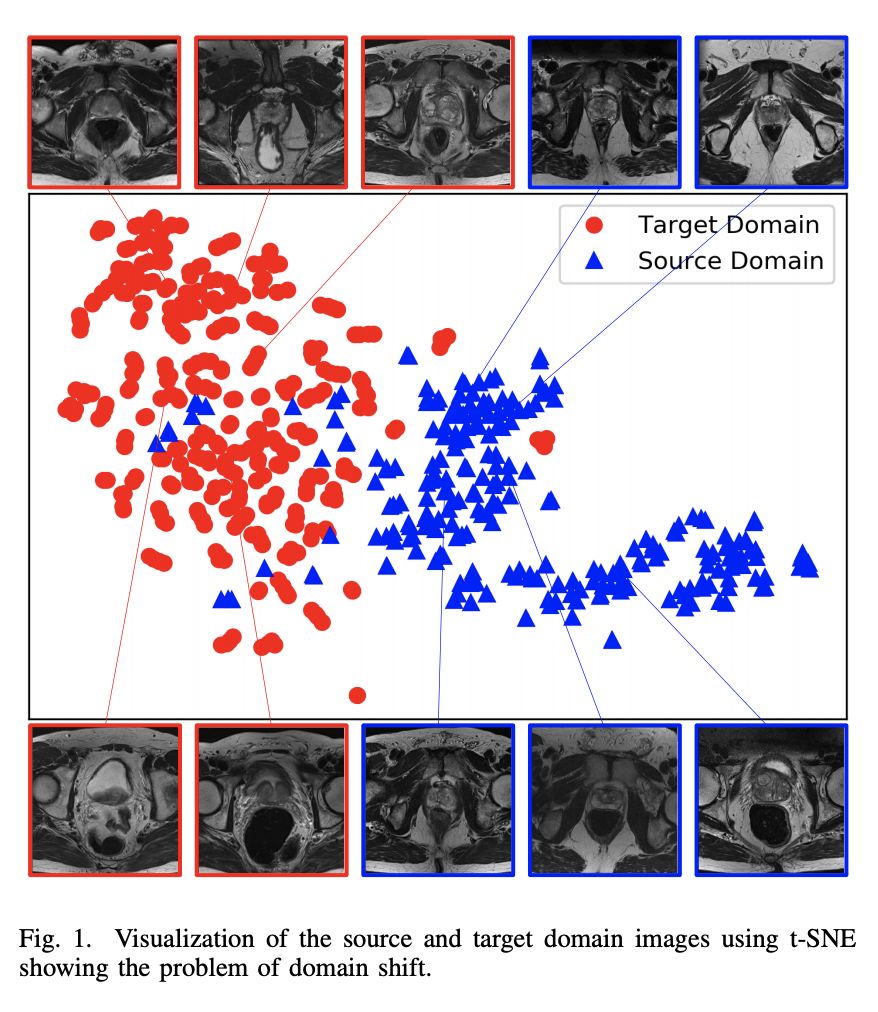

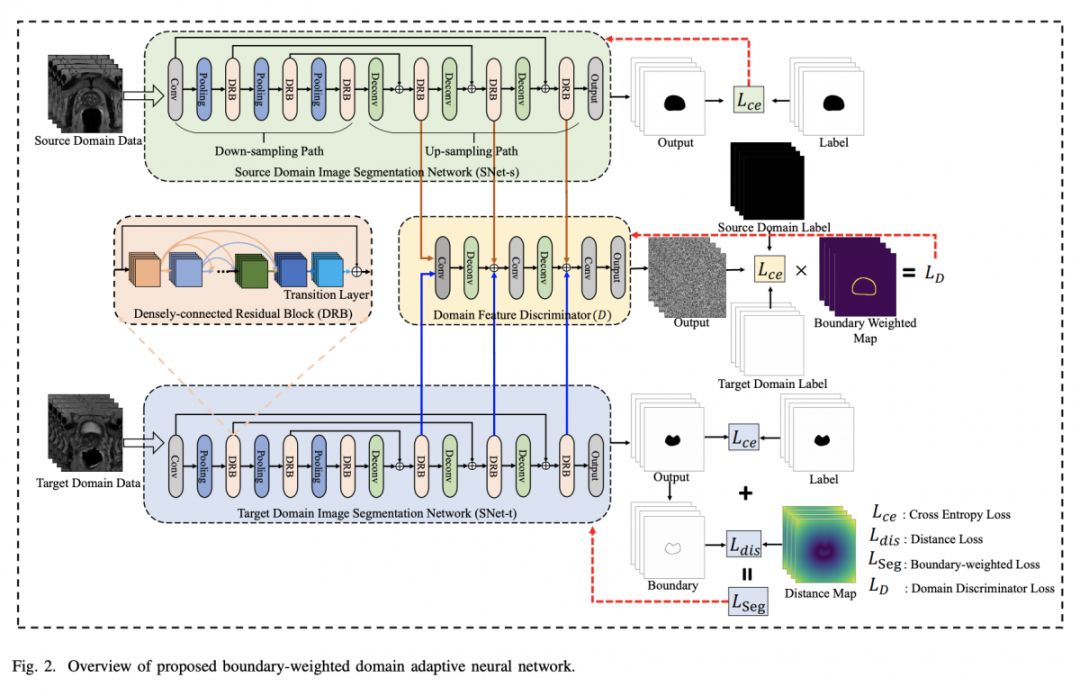

@afei 推荐

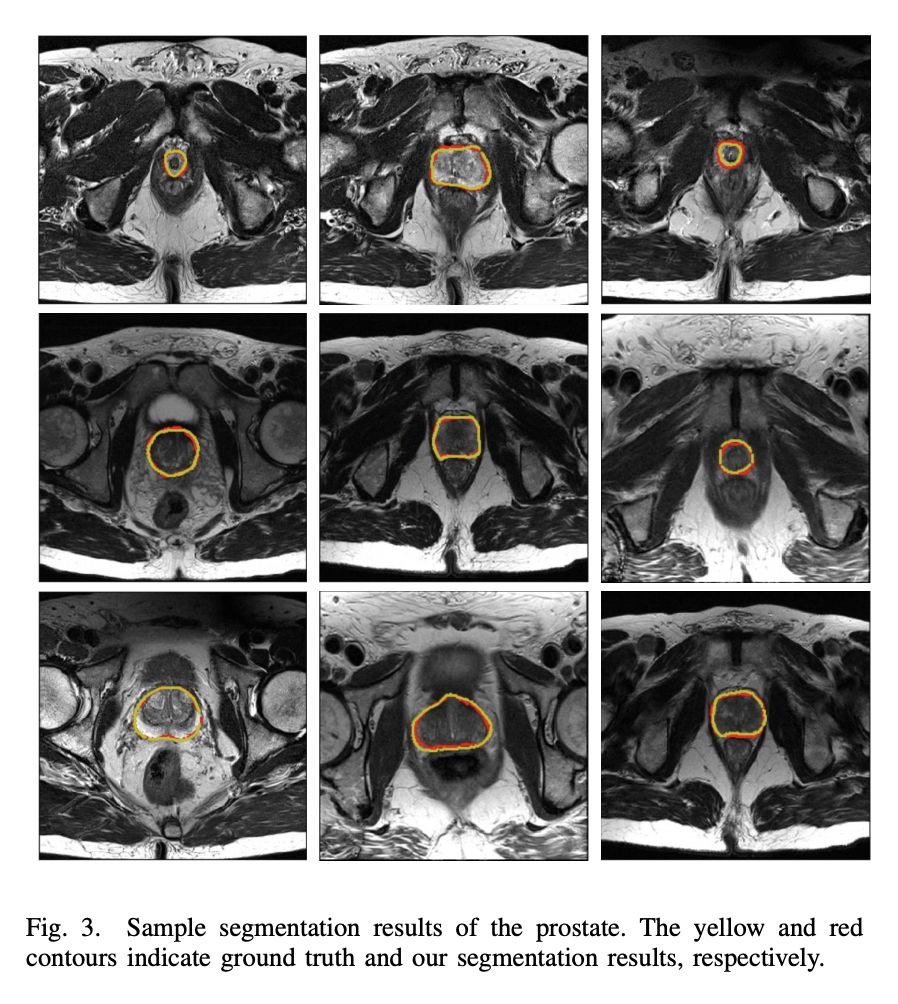

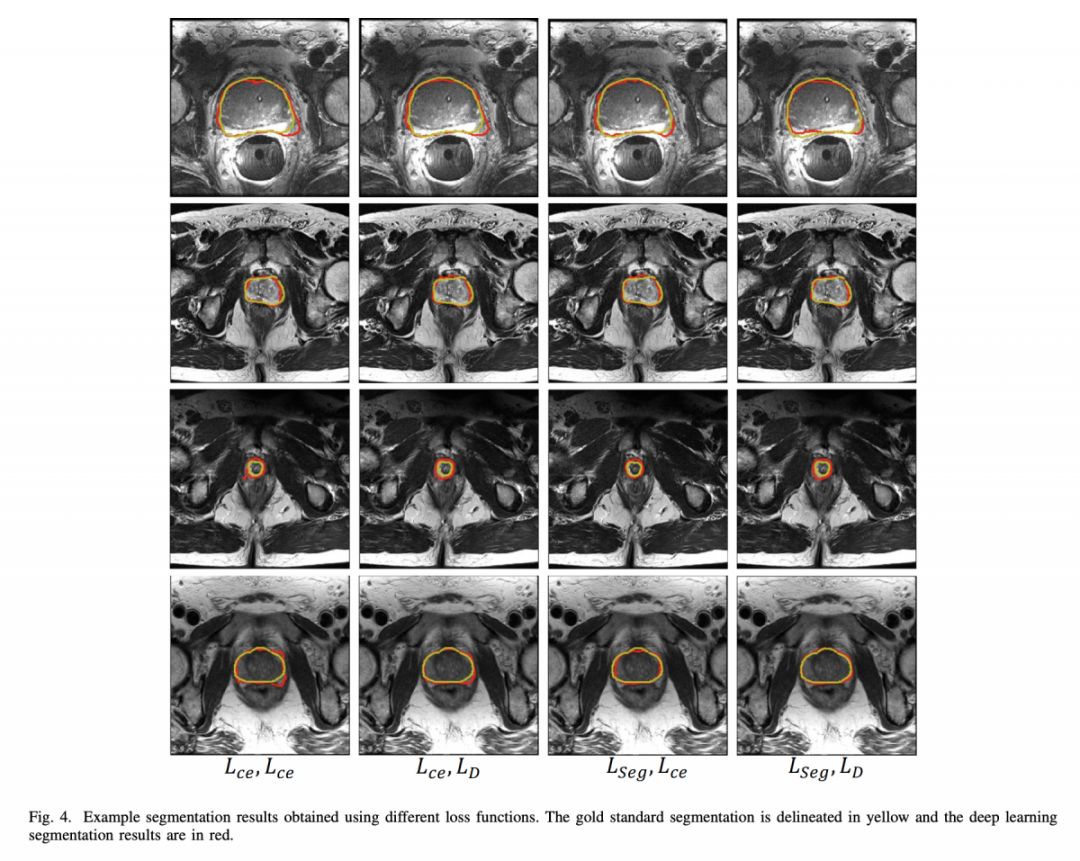

#Image Segmentation

本文提出了一种新的分割网络——BOWDA Net。基于此网络,作者在 MICCAI 2012 前列腺分割竞赛中排行第一,结果为 state of the art。创新点有两点:1)针对前列腺 MR 图像边界不清晰的问题,提出了边界加权分割 loss,平滑了边界;2)针对数据集小的问题,作者借鉴了迁移学习以及 GAN 的思想,解决了 source domain 和 target domain shift 的问题,值得阅读。

论文模型:点击查看大图

论文链接

https://www.paperweekly.site/papers/2851

@paperweekly 推荐

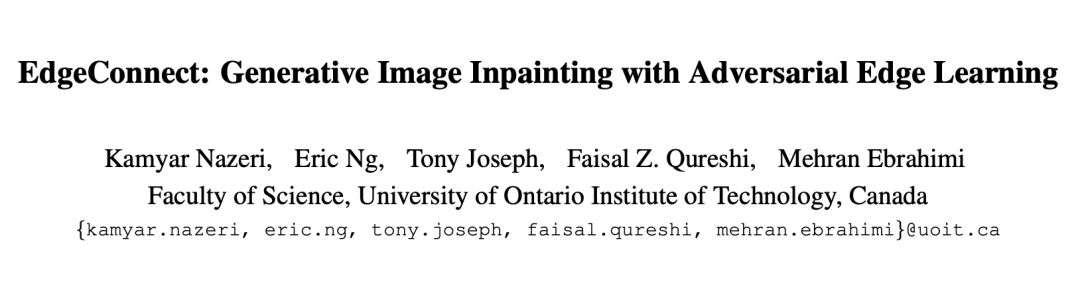

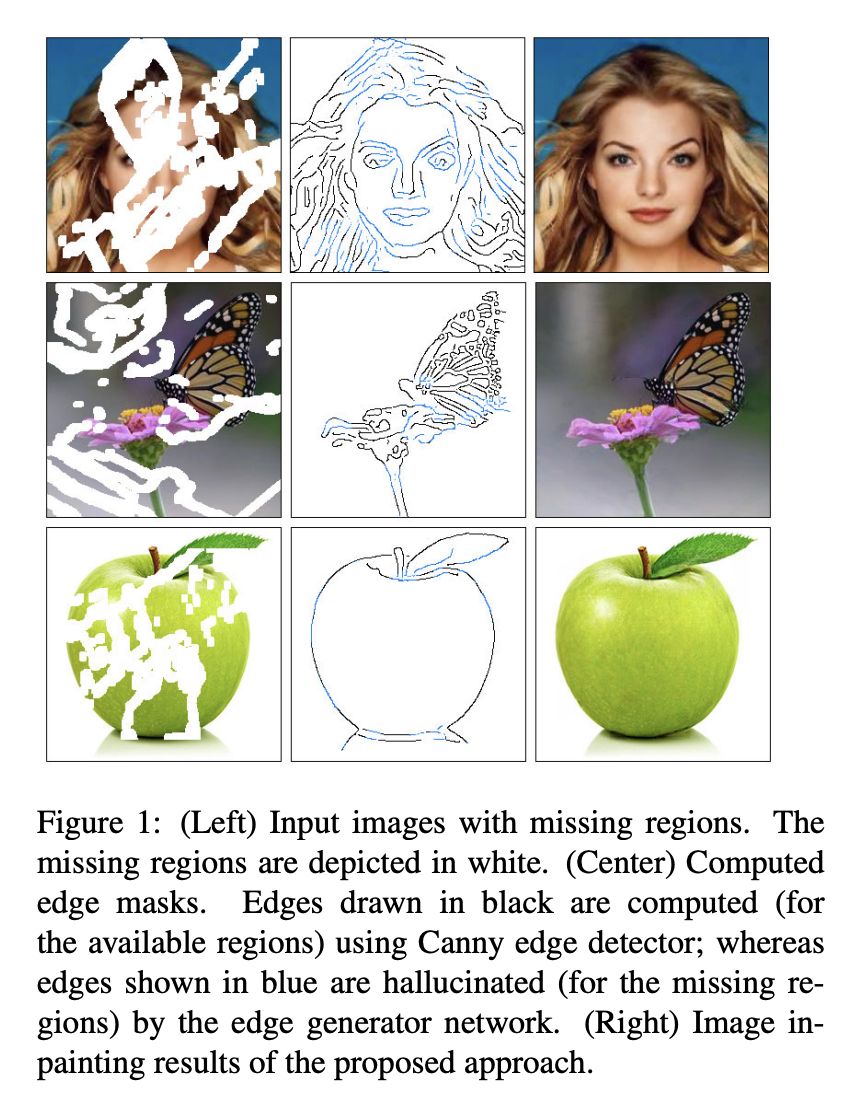

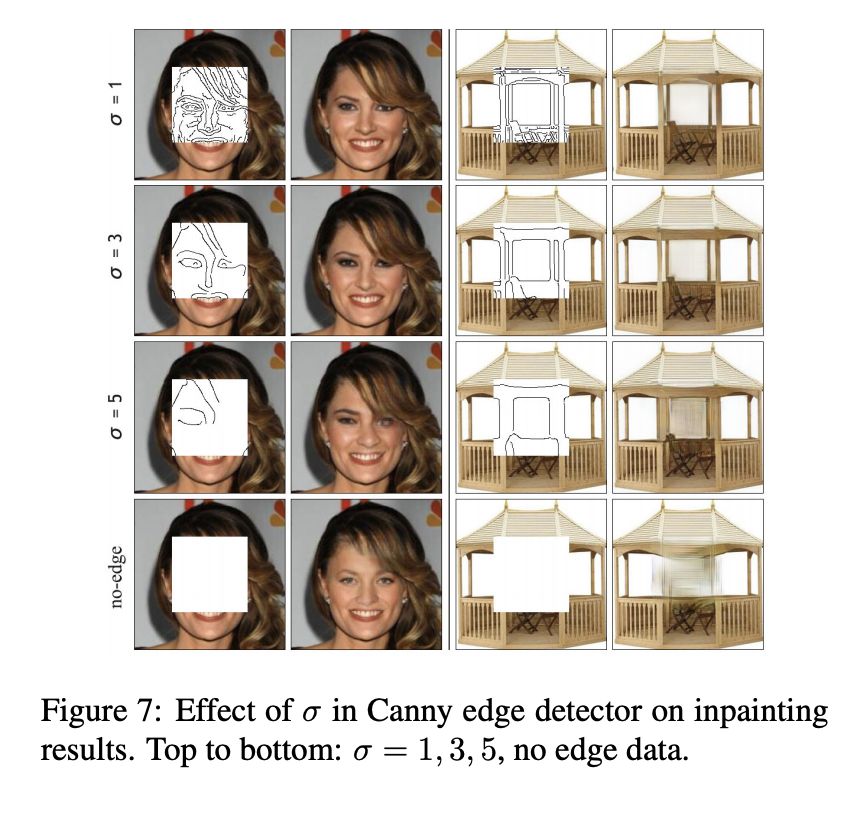

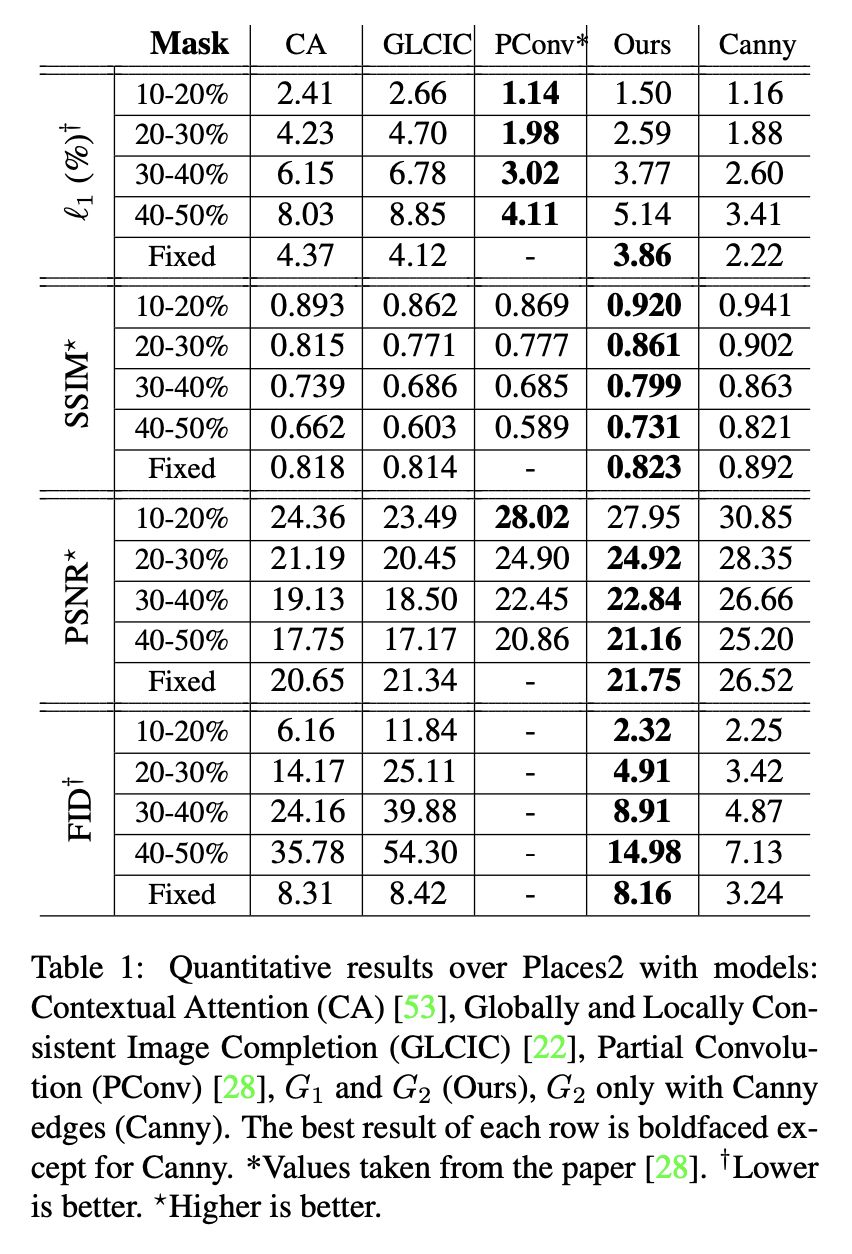

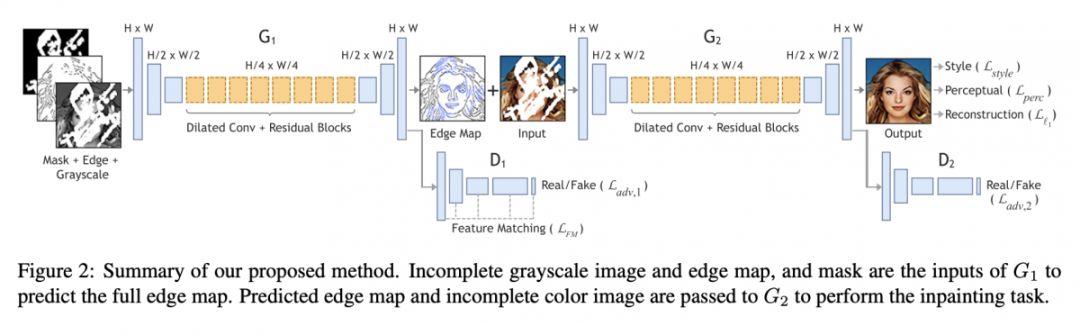

#Image Inpainting

本文来自安大略理工大学,论文提出了一种全新图像修复方法,能重构出图像的精细细节。具体而言,作者提出了一种两阶段的对抗模型 EdgeConnect,该模型由一个边生成器和一个图像补全网络组成。边生成器将图像确实区域的边生成,而后图像补全网络以边为先验填补图像。

论文模型:点击查看大图

论文链接

https://www.paperweekly.site/papers/2832

源码链接

https://github.com/knazeri/edge-connect

@JasonZHM 推荐

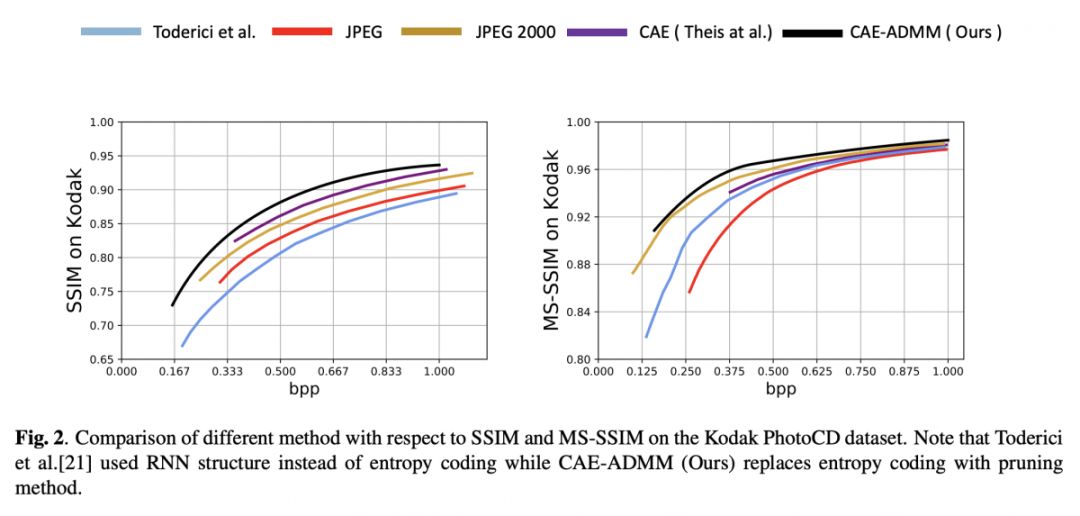

#Image Compression

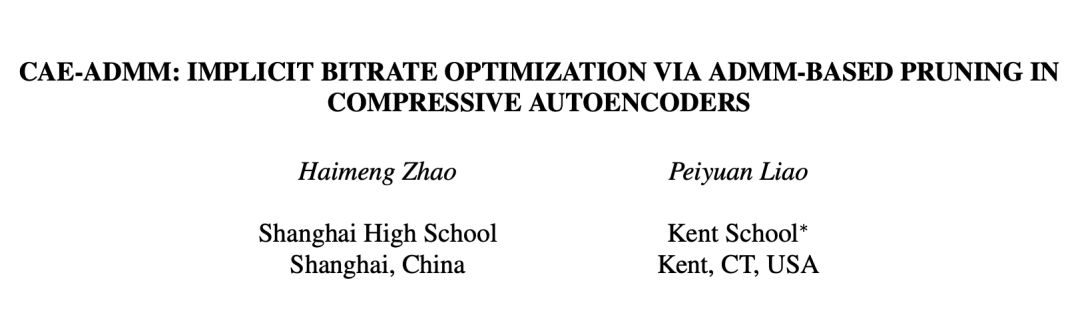

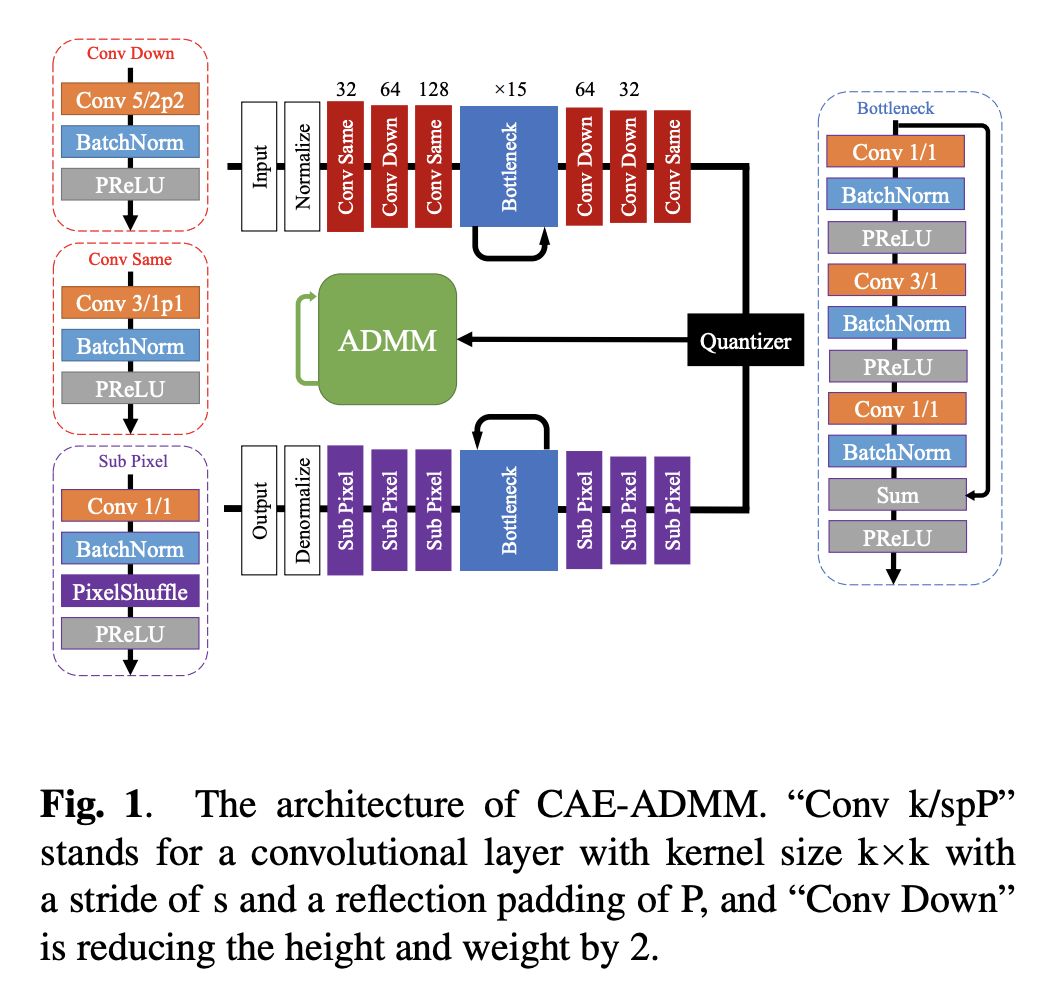

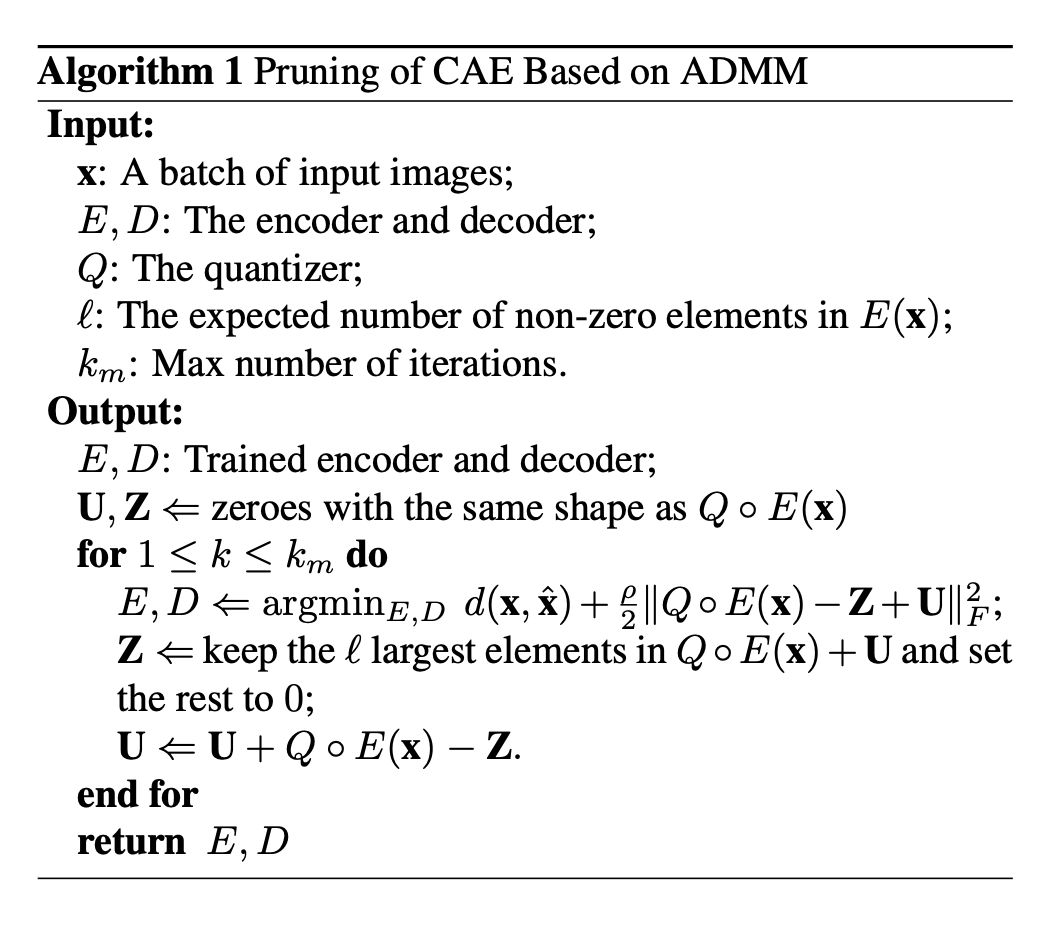

利用卷积自编码器进行图像压缩需要同时优化压缩率和重构图像质量,但由于用于表征压缩率的编码比特率不可微,因此不能直接反向传播。现有研究普遍采用额外训练熵估计器的方法解决这个问题。

该研究则引入了来自神经网络架构搜索领域的网络剪枝方法,提出了 CAE-ADMM 模型,直接对压缩后的编码进行剪枝,在保持编码速度的情况下,SSIM 及 MS-SSIM 的表现均超越了使用熵估计器的现有模型和传统编码器(JPEG、JPEG 2000 等)。该研究同时对引入的剪枝方法在模型中的效果进行了检验。

论文模型:点击查看大图

论文链接

https://www.paperweekly.site/papers/2803

源码链接

https://github.com/JasonZHM/CAE-ADMM

@zhangjun 推荐

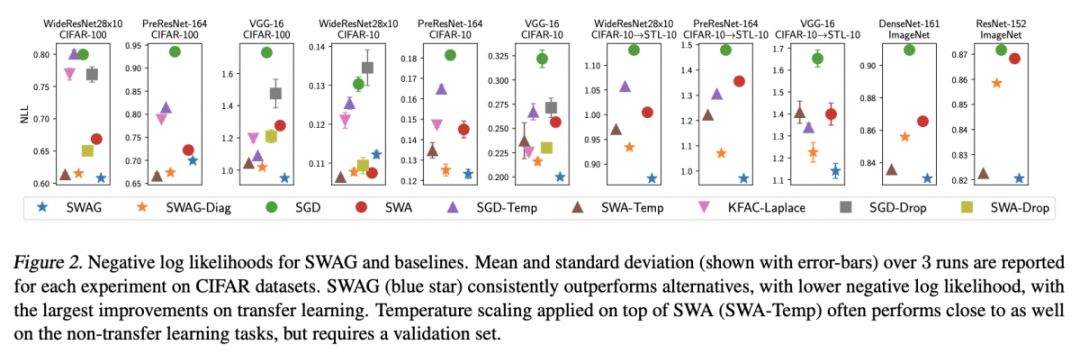

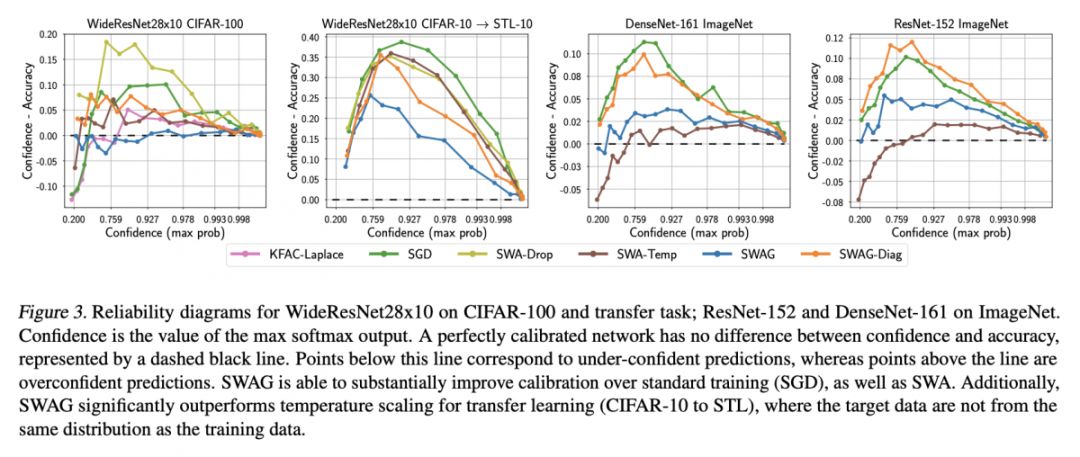

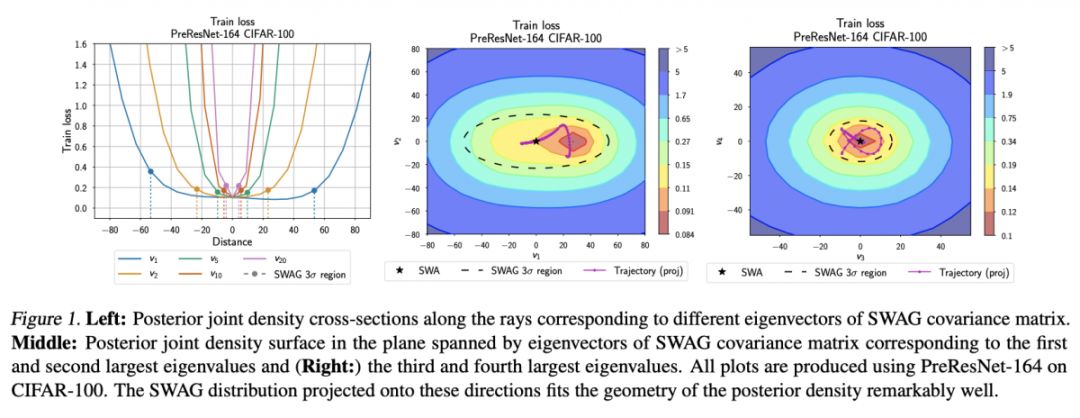

#Bayesian Deep Learning

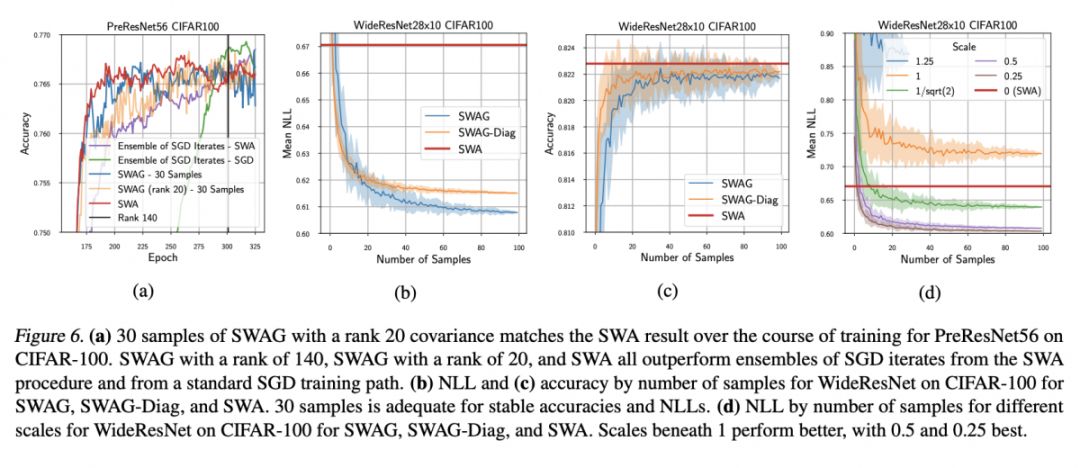

DNN 的不确定性量化是当前一大研究热点,在小数据机器学习、自动驾驶、强化学习、贝叶斯优化、主动学习等领域应用广泛。一种经典的方法是将模型参数视为随机变量,用近似推断的方法(比如:MCMC 类和 VI 类)扎实地求出每个参数的后验分布,这种方法相对准确,但计算效率较差,尤其对于参数数以亿计的复杂结构网络更加困难;另一种方法是朝着实用方向的,训练还是基于传统的 SGD + Dropout,在测试时对参数后验分布进行近似,使得模型在预测时可考虑到不确定性的影响。

本文属于第二种思路,基于一种叫做 Stochastic Weight Averaging (SWA)的方法,即将 T 个 Epoch 中的参数作为统计数据,求平均作为参数后验分布的均值,方差作为分布的方差(仅考虑后验分布为高斯的情况,也是大多数方法的假设。)。思路比较简单,相对传统的贝叶斯推断方法,计算效率非常高。这类方法中另一个典型代表是 Oxford 的 Yarin Gal 提出的 MC Dropout。

论文模型:点击查看大图

论文链接

https://www.paperweekly.site/papers/2815

源码链接

https://github.com/wjmaddox/swa_gaussian

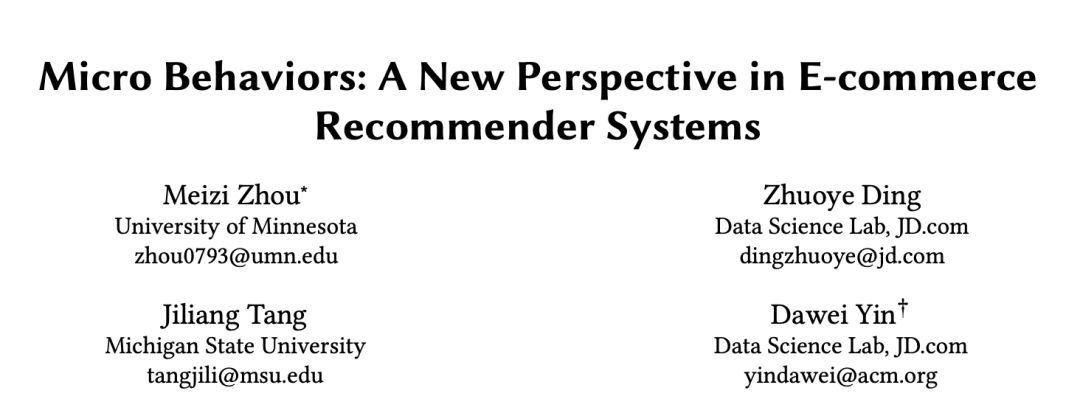

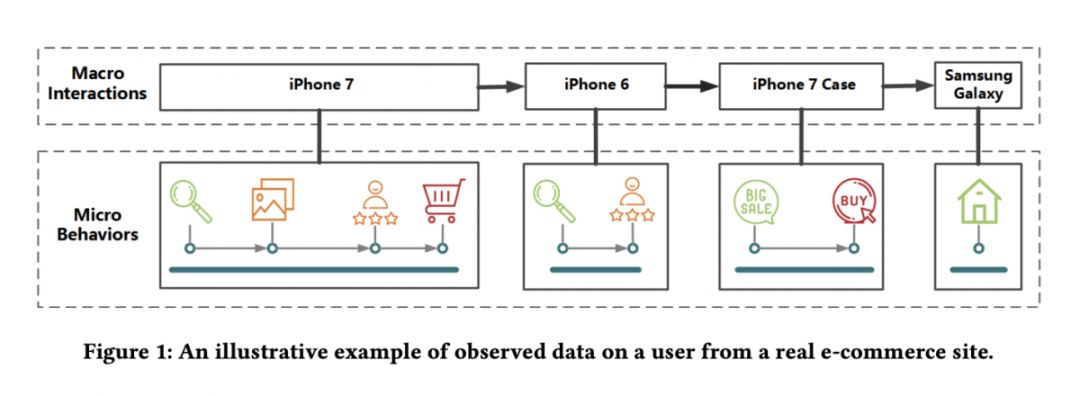

@paperweekly 推荐

#Recommender Systems

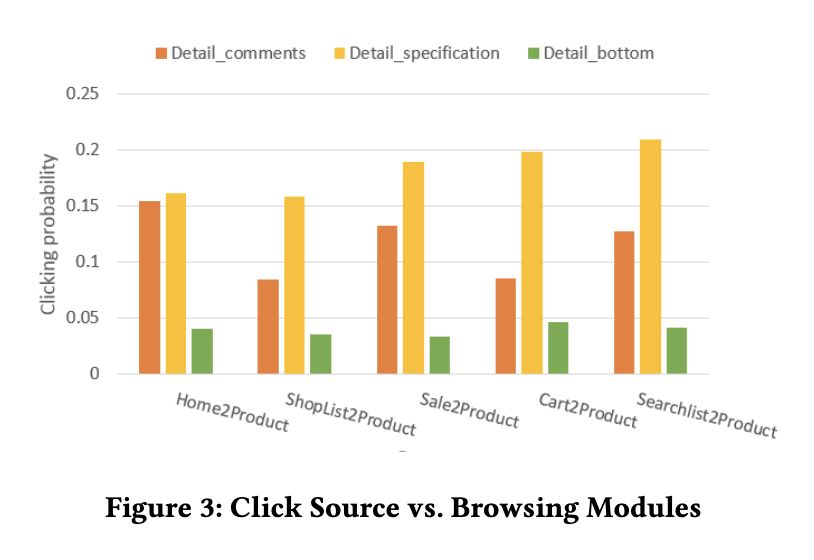

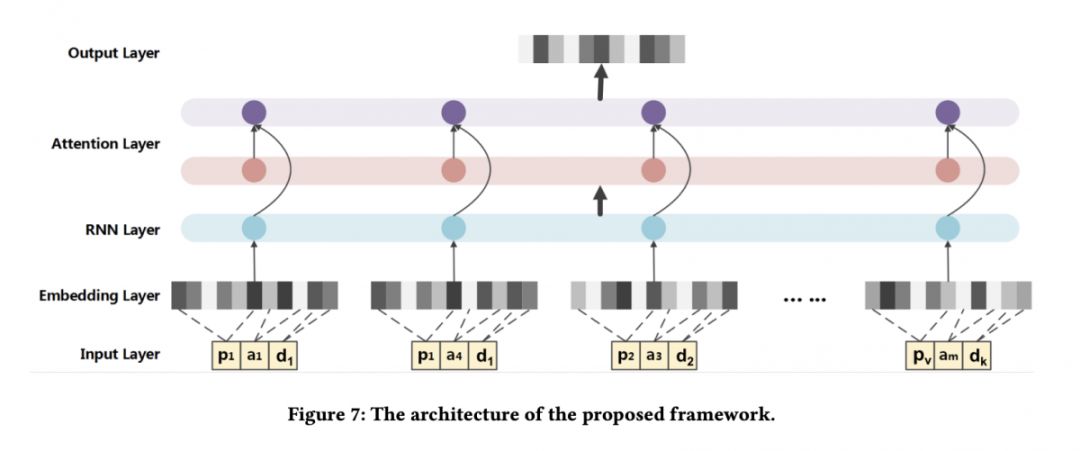

本文是明尼苏达大学和京东发表于 WSDM 2018 的工作。当前大多数推荐系统更注重用户和商品之间的宏观交互(如用户-商品评分矩阵),很少有人会结合用户的微观行为数据(如浏览商品的时长、对商品的阅读和评论)进行推荐。

本文从微观行为的角度对推荐系统进行改进,作者将用户的固有数据视为用户和商品之间的宏观交互,并保留了宏观交互的顺序信息,同时,每个宏观交互都包含一系列微观行为。具体来说,论文提出了一个全新模型——RIB,它由输入层、Embedding 层(解决数据稀疏和数据高维的问题)、RNN 层(建模时序信息)、Attention 层(捕捉各种微观行为影响)和输出层组成。

论文模型:点击查看大图

论文链接

https://www.paperweekly.site/papers/2549

@paperweekly 推荐

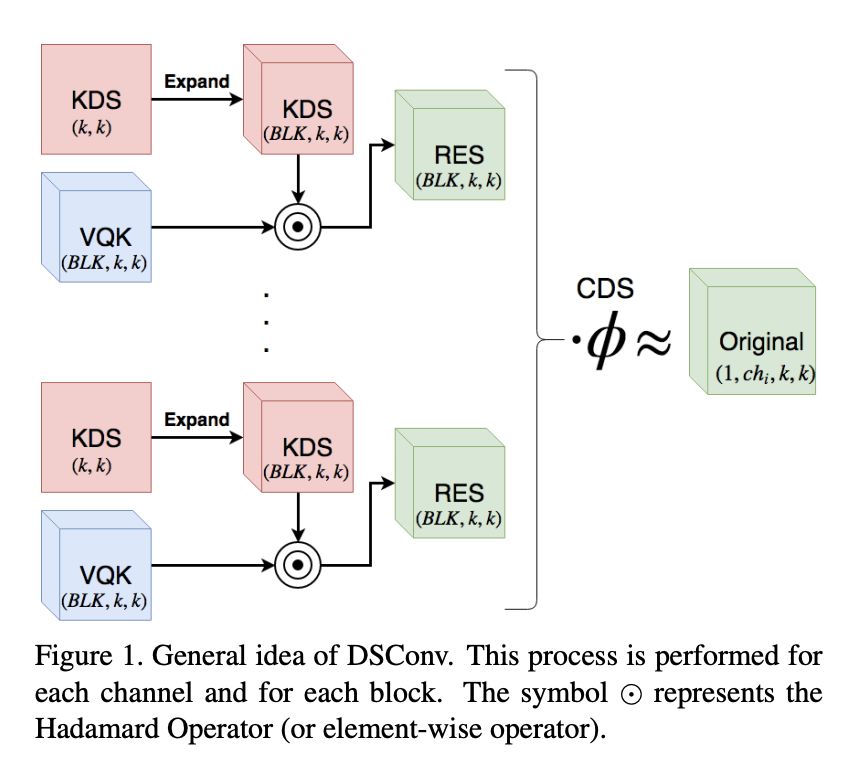

#Deformable Convolution

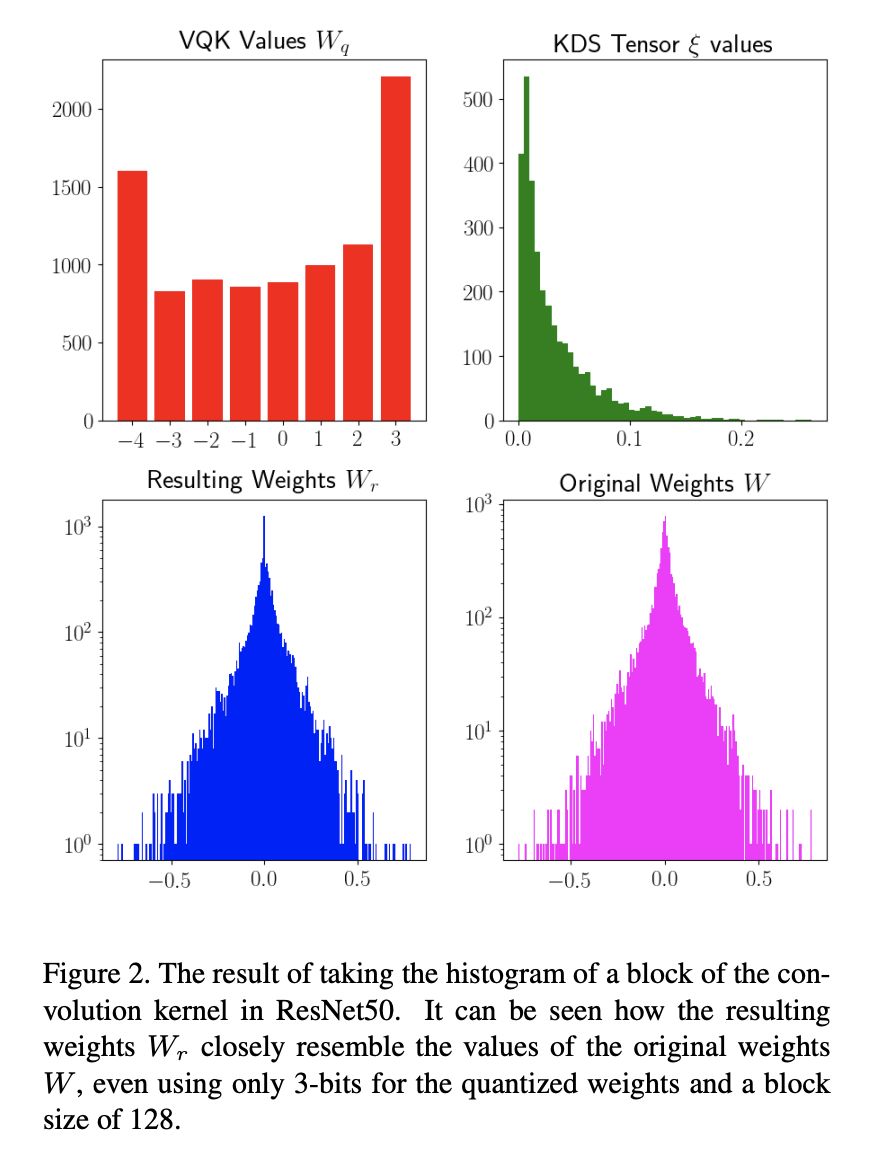

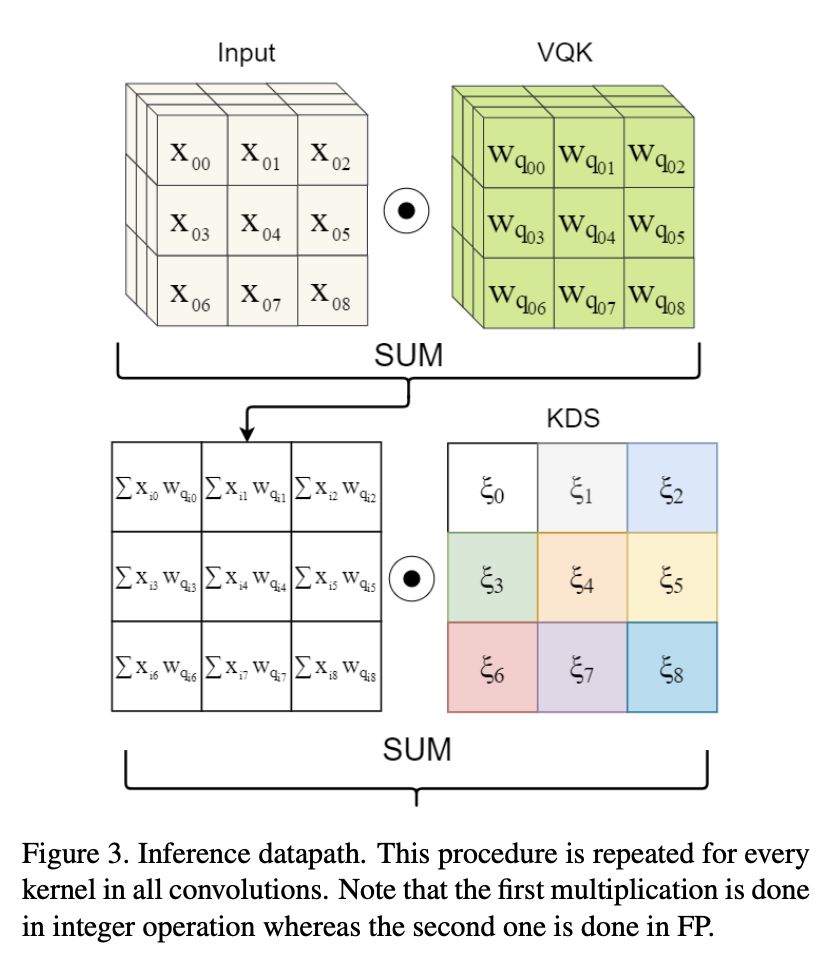

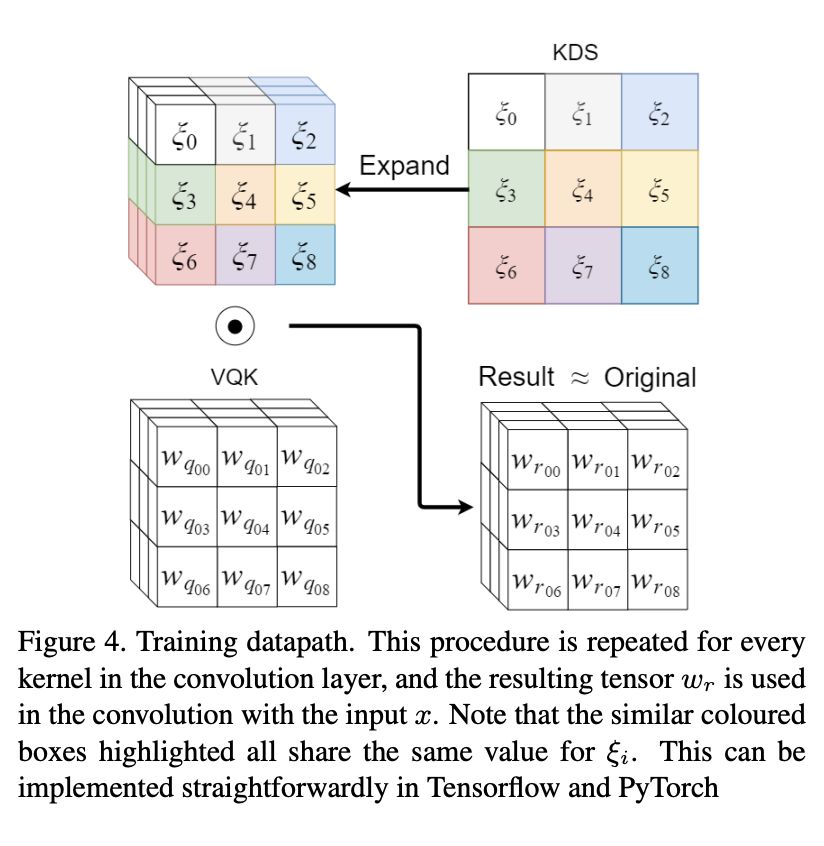

本文来自牛津大学,论文提出了一种分布偏移卷积 DSConv,可以轻松替换标准神经网络体系结构,并实现较低的存储器使用和较高的计算速度。DSConv 将传统的卷积内核分解为两个组件:可变量化内核(VQK)和分布偏移。通过在 VQK 中仅存储整数值来实现较低的存储器使用和较高的速度,同时,通过应用基于内核和基于通道的分布偏移来保持与原始卷积相同的输出。

作者在 ResNet50 和 34 以及 AlexNet 和 MobileNet 上对 ImageNet 数据集测试了 DSConv。通过将浮点运算替换为整数运算,本文方法在卷积内核中实现了高达 14x 的内存使用量减少,并将运算速度提高了 10 倍。

论文模型:点击查看大图

论文链接

https://www.paperweekly.site/papers/2835

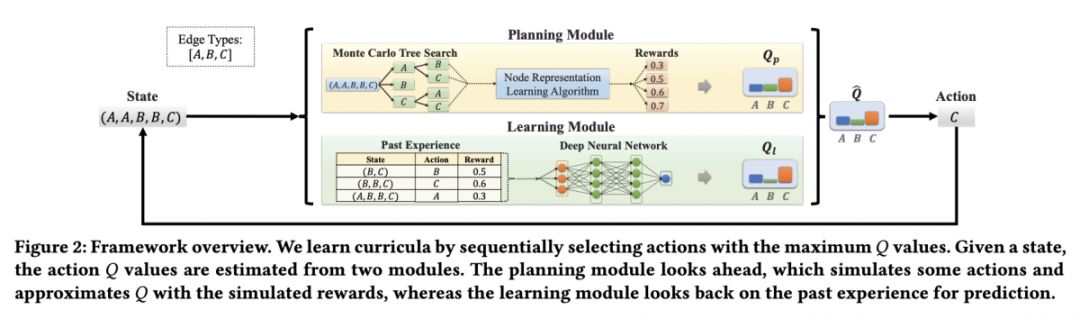

@Rcypw 推荐

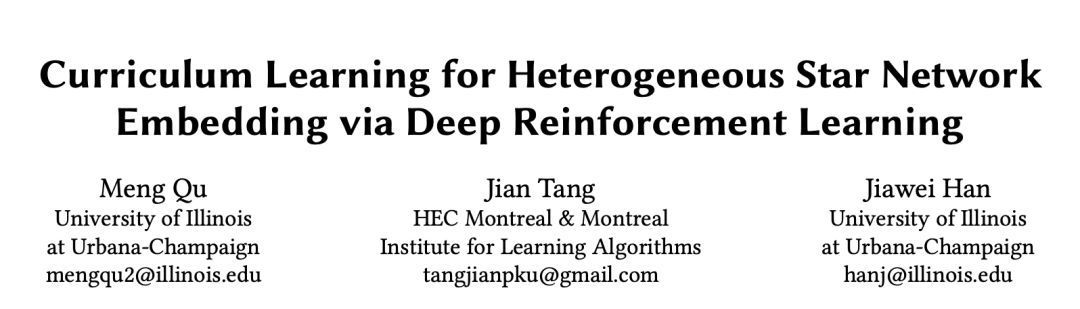

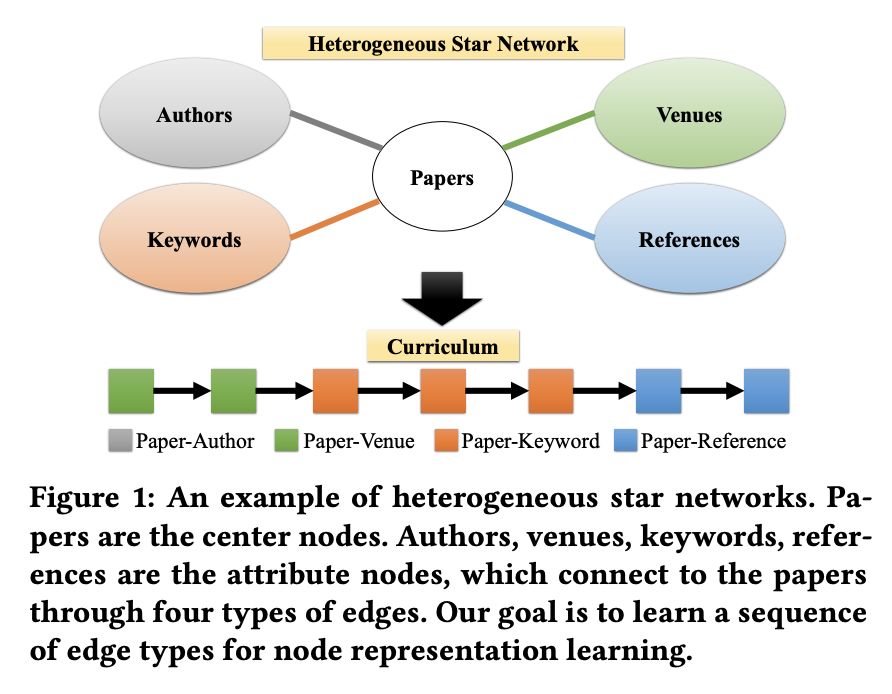

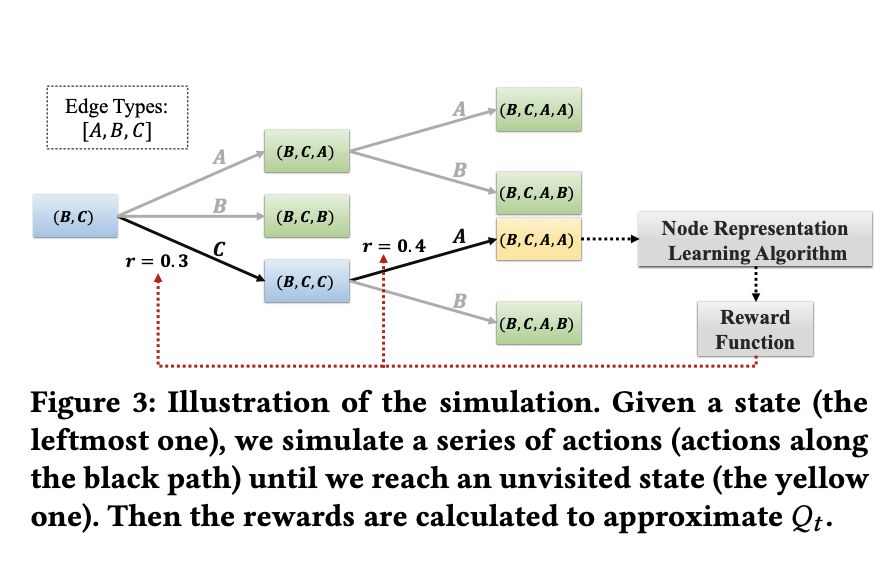

#Network Embedding

本文是 UIUC 和 HEC Montreal 发表于 WSDM 2018 的工作,论文开创性地将强化学习思想应用到星型异构网络节点表示学习当中 ,利用马尔科夫链去获取最优的节点之间边的序列。作者将奖励计算作为节点表示的外部任务的性能作为特征,目标是采取一系列行动来最大化累积奖励,基于长短记忆网络利用深度强化学习模型,完成网络表示学习。

论文模型:点击查看大图

论文链接

https://www.paperweekly.site/papers/2590

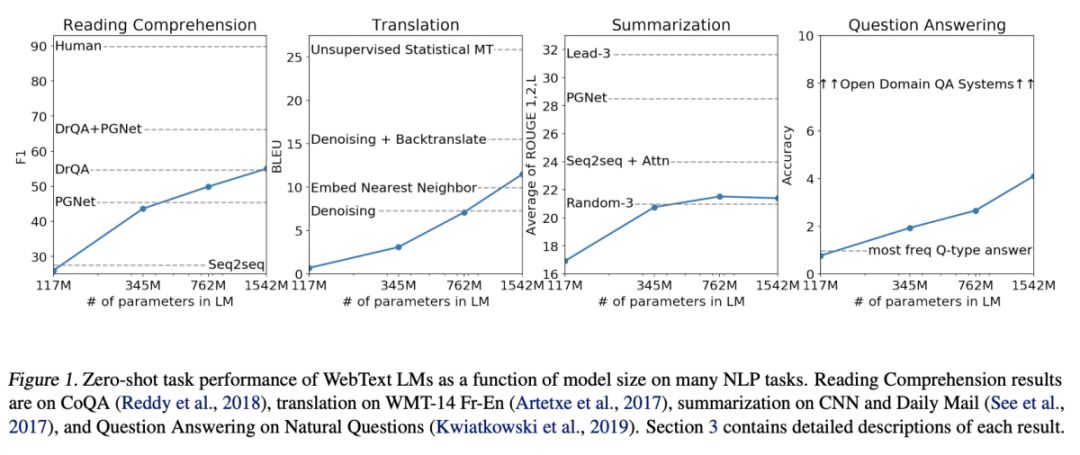

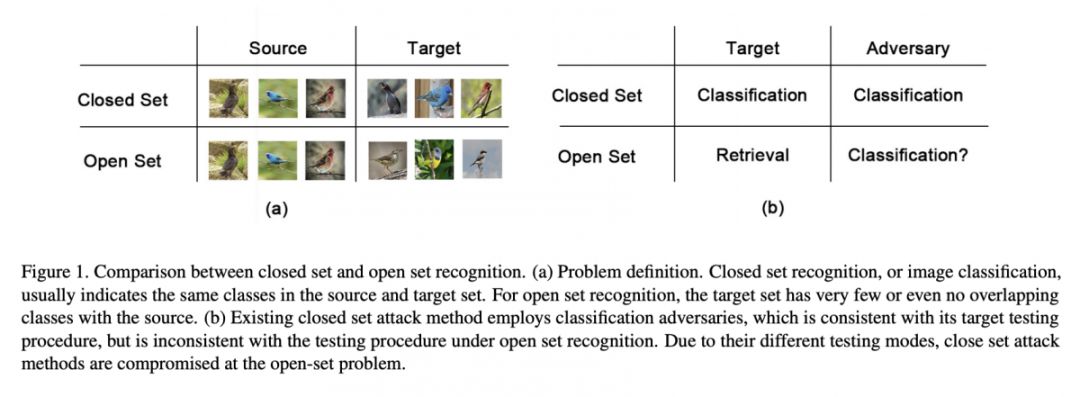

@Layumi 推荐

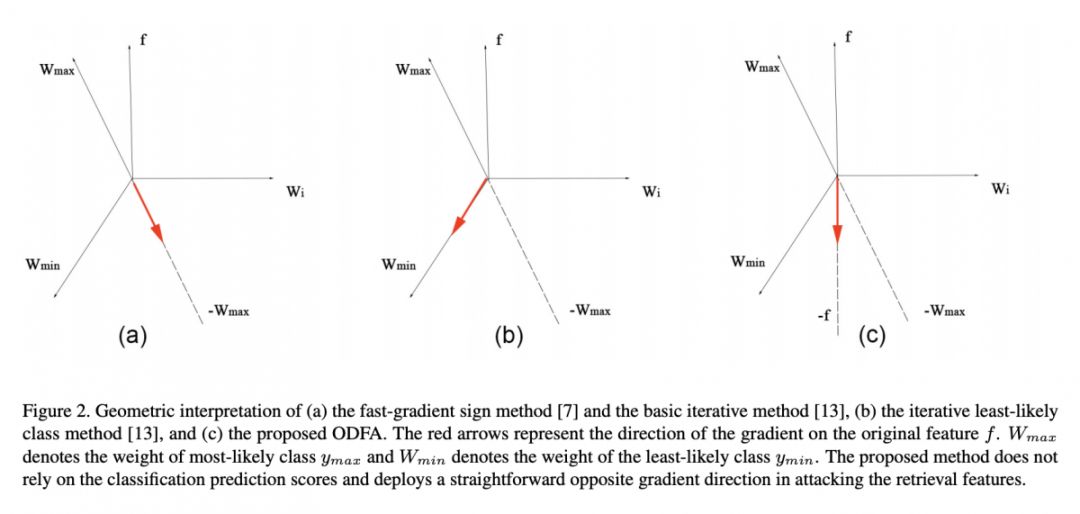

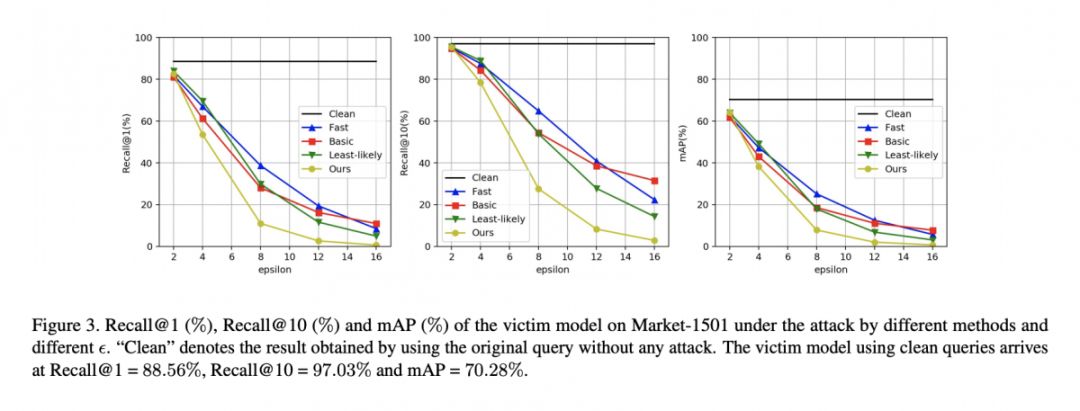

#Person Re-identification

现在行人重识别高准确率模型真的鲁棒么?是不是像传统分类问题一样容易被攻击呢?本文提出的方法,将目前行人重识别上较高的 baseline Recall@1=88.56%, mAP=70.28%(layumi/Person_reID_baseline_pytorch) 降到 Recall@1=0.68%, mAP=0.72%。

对抗样本存在于很多任务中,但如何在不同任务中构造对抗样本是一个问题。对于 reID 来说,攻击的方式与正常的分类不同。因为 reID 在测试的时候的类别与训练时类别不同,没有相同的类别(也就是测试的人和训练的人不是同一批,Open-set)。那么在构造对抗样本时,传统的降低预测概率回传梯度方法就受限。在实验中也有相应结果。文章提出了一种新的方法来攻击图像检索(reID 是图像检索的一个子问题)。

论文模型:点击查看大图

论文链接

https://www.paperweekly.site/papers/2799

编辑:王菁

校对:林亦霖