ECCV 2020 | 打破度量学习传统认知!清华与MSRA提出基于负间隔损失的少样本学习方法

点击上方“CVer”,选择加"星标"置顶

重磅干货,第一时间送达

注:本文系CVer粉丝投稿,欢迎大家分享优质工作。本论文已收录于ECCV 2020 Spotlight

针对少样本学习方法,来自清华大学和微软亚研院的研究者们在度量学习中引入了“负间隔”损失函数,打破了度量学习中“间隔”应该为正的传统认知。研究者通过理论和统计分析证明负间隔损失降低了特征在base classes上的可分性,但增强了在novel classes上的泛化性。由此,这种负间隔损失函数在小样本学习的任务中显著地优于基于“正间隔”的损失函数,并在多个标准数据集上取得了state-of-the-art的效果。

论文地址:https://arxiv.org/abs/2003.12060

代码地址:https://github.com/bl0/negative-margin.few-shot

目前众多视觉识别任务的成功都依赖于大量有标注的训练数据,相反,人类却可以依靠少量样本学习到新的概念。因此,少样本学习吸引了许多人的关注。该问题的关键是如何将base classes(带有充足标注数据)中的知识推广到novel classes(只有少量数据)。近期的研究表明,简单地在base classes上应用softmax或cosine softmax进行训练,再在novel classes上训练新的线性分类器层的方法可以取得很不错的效果。

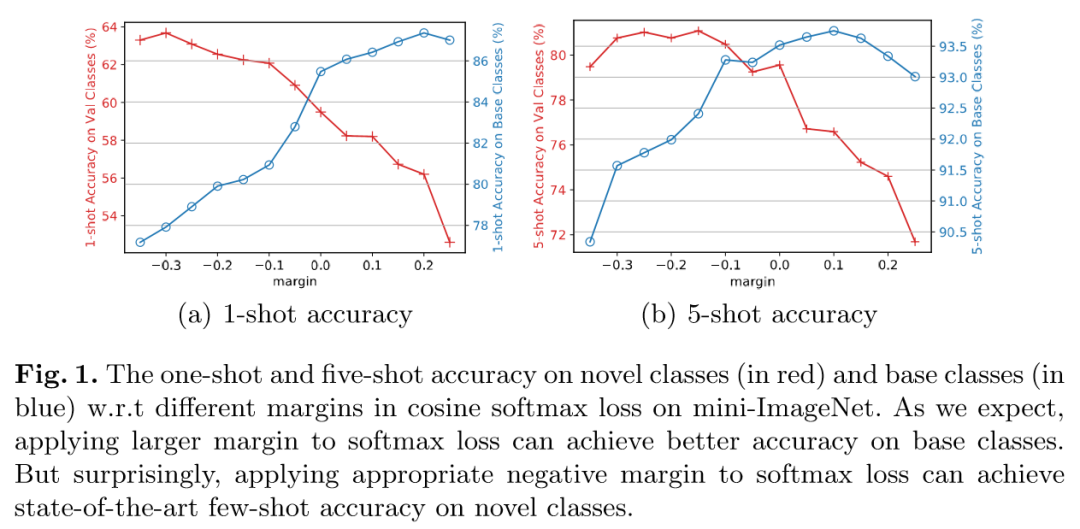

在本文中,清华大学和微软亚研院的研究者们在softmax函数中引入了“负间隔”。与以前度量学习中基于“间隔”的方法不同,这里的“间隔”是负值,而不是常规的0或者正值。如图1所示,“正间隔”的使用可以提高base classes的分类准确率(蓝线),但与之前的认识不同的是,随着“间隔”由负到正逐渐增大,novel classes的分类准确率(红线)反而降低了。研究者认为,虽然“正间隔”可以增强base classes上特征的可分性,但会导致novel classes中同一类的样本被映射到不同base classes对应的流形空间上,从而损害了在novel classes上的泛化性。

方法介绍

整体框架 本文采用标准的迁移学习范式,分两阶段进行训练。预训练阶段在base classes上进行,训练得到骨干网络;微调阶段在novel classes上进行,在骨干网络的基础上训练一个新的线性分类器。本文主要对这一框架中的损失函数进行研究。

“负间隔”softmax损失函数 在softmax函数中引入“正间隔”的方法已经在度量学习领域被广泛接受,本文直接将“间隔”引入到softmax损失函数中,得到的形式如公式1所示。

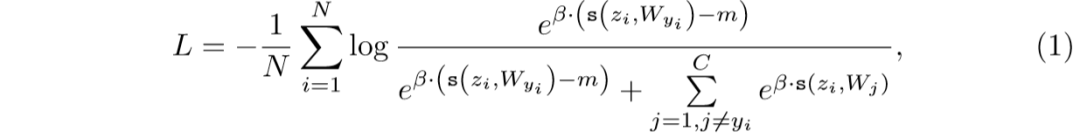

公式1中m代表间隔,s(·,·)用于度量两个输入向量的相似性。当s(·,·)分别取内积或余弦相似性时,公式(1)对应为负间隔softmax损失函数(Neg-Softmax)和负间隔cosine softmax损失函数(Neg-Cosine)。

值得注意的是,先前的工作中往往限制“间隔”为正数,这是因为他们的工作主要关注于close-set的应用场景,在这种场景下训练类别和目标类别相同,“正间隔”可以减小类内距且增大类间距,有利于相同类别的分类。然而,在open-set的场景下,base classes和novel classes有明显差异,特征在base classes上的过强的可分性可能会损害它们到novel classes的可迁移性,而恰当的“负间隔”可以有效平衡base classes上的可分性与novel classes上的泛化性。

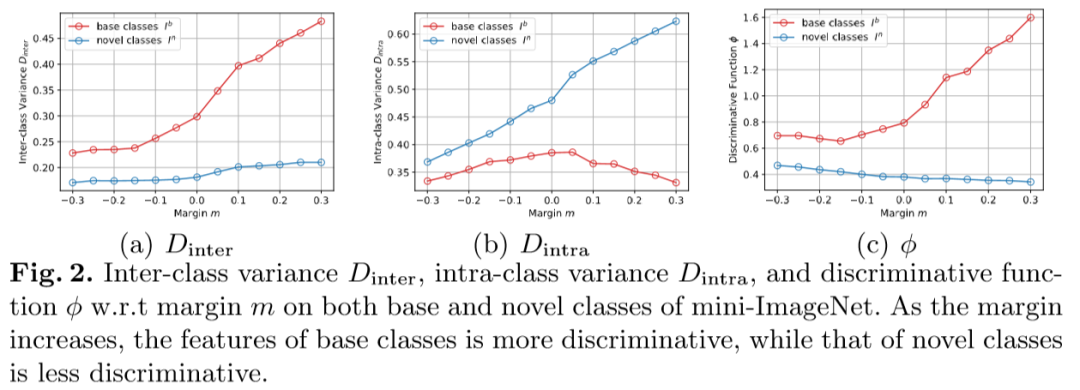

特征可分性与“间隔”的关系 为了理解为什么“负间隔”在novel classes上有效,我们分析了不同“间隔”训练得到的特征的可分性。我们分别定义类间距(D_inter)为类别中心之间距离的均值,类内距(D_intra)为数据点到类别中心的均值,并定义可分性(phi)为类间距与类内距的比值。

如图2所示,对于base classes(红线),随着间隔增大,类间距显著增大而类内距变化不大,因此正间隔增大了base classes特征的可分性。而对于novel classes(蓝线),情况正好相反,间隔增大使得类内距增大而类间距变化不明显,导致特征可分性下降。

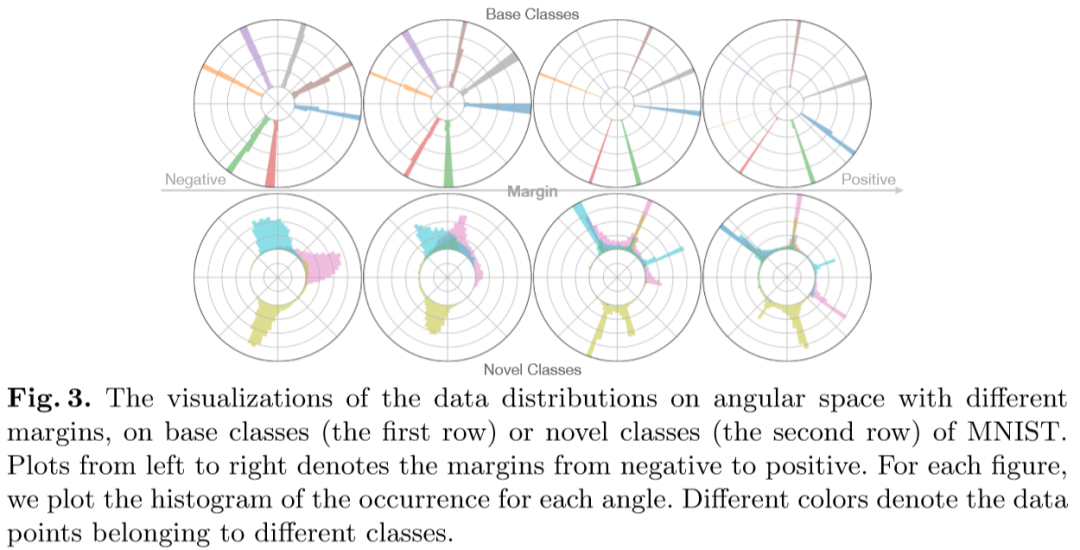

可视化分析 为了更好地理解“间隔”的影响,我们在MNIST上进行了数据分布的可视化。我们选择7个类作为base classes,3个类作为novel classes,绘制了图像特征在角度空间上的分布。

如图3的第一行所示,随着“间隔”由负到正,每个base classes的分布都变得更细更高,同时不同类别之间的角度差异增大。在第二行中,随着“间隔”的增大偏离簇中心的数据点减少,因为base classes和novel classes存在分布差异,所以novel classes中同一类的样本可能被映射到不同的峰/类簇中,导致分类困难;而恰当的“负间隔”使得novel classes的特征不会集中于base classes类别中心,从而可能缓解多峰问题并提高novel classes上的分类准确率。

实验结果

与其他方法的对比

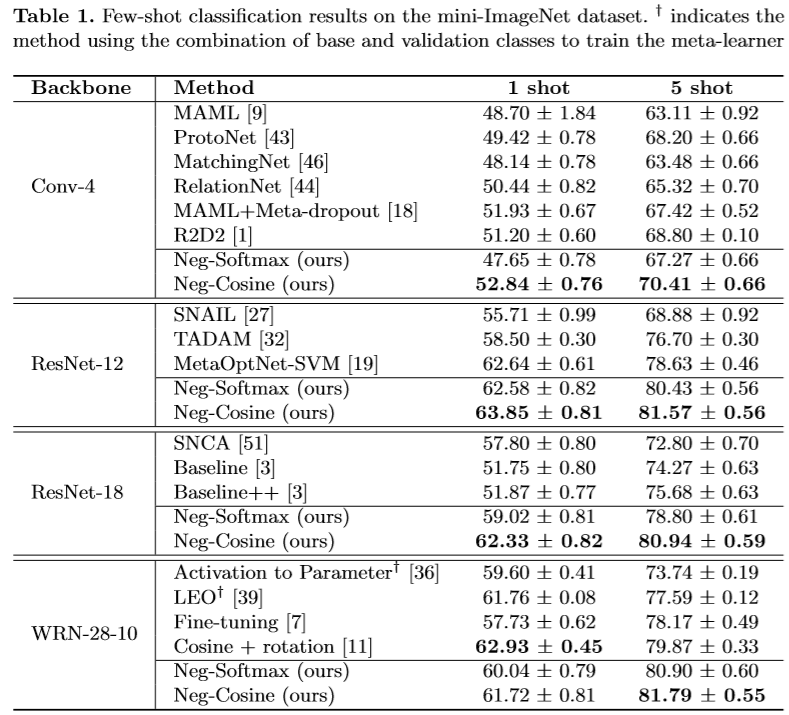

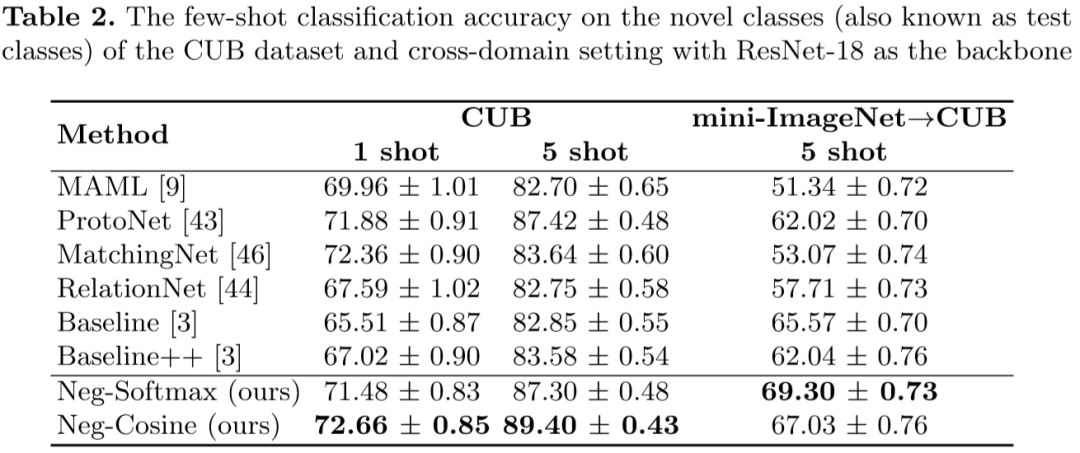

表1,表2列出了Neg-Softmax和Neg-Cosine在mini-ImageNet, CUB, mini-ImageNet->CUB三种场景下的结果。在不同的骨干网络和不同的数据集上,“负间隔”的引入都明显地提高了分类的准确率,并取得了state-of-the-art的结果。

分析

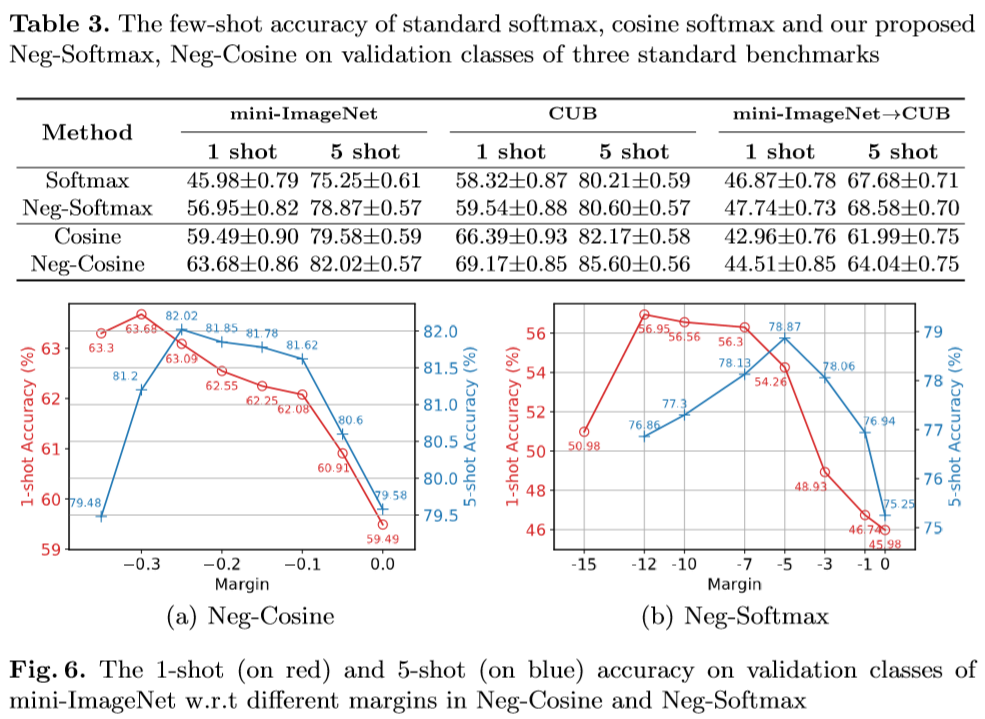

“负间隔”的影响:表3在三个数据集上对标准的softmax, cosine softmax和Neg-Softmax, Neg-Cosine的结果进行了对比,“负间隔”的引入大幅提高了分类性能。

不同“间隔”对准确率的影响:图6绘制了Neg-Cosine, Neg-Softmax在不同“间隔”下的mini-ImageNet 1-shot和5-shot的准确率。随着“间隔”越来越小,准确率先增后降,呈现出钟形曲线,表明恰当的“负间隔”可以有效提升准确率。

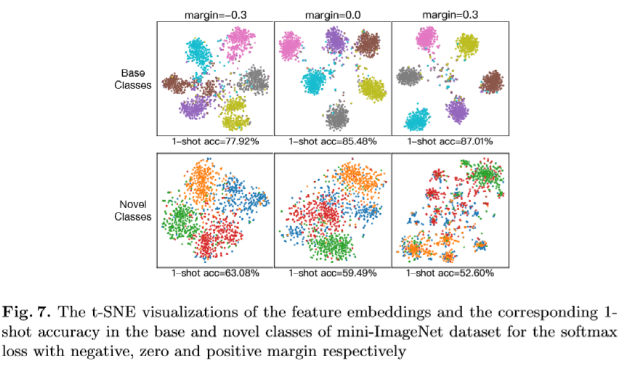

T-SNE可视化 图7展示了不同“间隔”在base classes与novel classes上的1-shot准确率和t-SNE可视化结果。在base classes上,“正间隔”比“负间隔”形成了更清晰的类簇结构并取得了更高的准确率;然而在novel classes上,正的“间隔”破坏了特征的类簇结构,使得分类变难,而恰当的“负间隔”在特征的可分性和可迁移性之间取得了好的权衡。

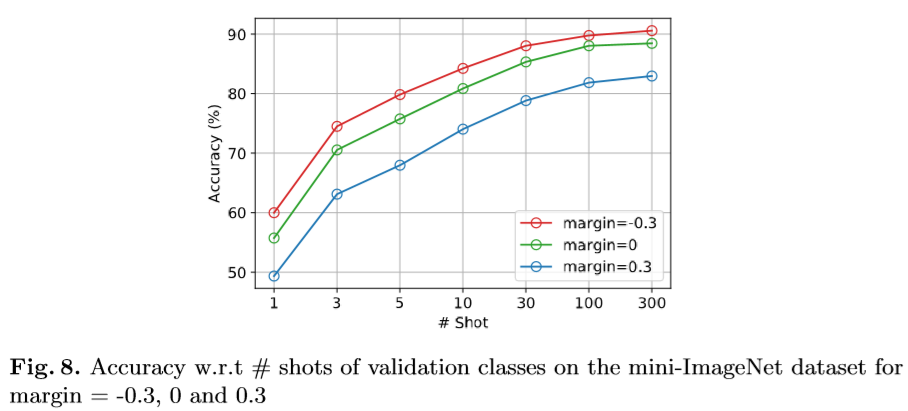

更多的shot数 图8展示了不同“间隔”下,分类准确率随shot数量变化的情况。从1-shot到300-shot,margin=-0.3的准确率一直高于margin=0与margin=-0.3,证明了在shot数增加的情况下,“负间隔”也有效。不过不可忽视的是,margin=-0.3与margin=0的差距随着shot数增加而减小,表明“间隔”的作用在逐渐减小。

总结

本文针对少样本分类问题提出了在softmax函数中采用恰当“负间隔”的方法,这一方法意外地在少样本分类的open-set场景中取得了很好的结果。为了理解为何“负间隔”有效,本文提供了直观解释和理论证明,并通过充分的实验加以验证。采用带“负间隔”的softmax函数,本文方法达到了state-of-the-art的结果。我们希望在未来的研究中,“负间隔”可以被应用到更多的open-set场景中。

下载

本文已打包好并上传,在CVer公众号后台回复:0818,即可下载访问

推荐阅读

下载1

在CVer公众号后台回复:PRML,即可下载758页《模式识别和机器学习》PRML电子书和源码。该书是机器学习领域中的第一本教科书,全面涵盖了该领域重要的知识点。本书适用于机器学习、计算机视觉、自然语言处理、统计学、计算机科学、信号处理等方向。

PRML

下载2

在CVer公众号后台回复:CVPR2020,即可下载CVPR 2020代码开源的论文合集

在CVer公众号后台回复:ECCV2020,即可下载ECCV 2020代码开源的论文合集

重磅!CVer-论文写作与投稿交流群成立

扫码添加CVer助手,可申请加入CVer-论文写作与投稿 微信交流群,目前已满2000+人,旨在交流顶会(CVPR/ICCV/ECCV/ICML/ICLR/AAAI等)、顶刊(IJCV/TPAMI等)、SCI、EI等写作与投稿事宜。

同时也可申请加入CVer大群和细分方向技术群,细分方向已涵盖:目标检测、图像分割、目标跟踪、人脸检测&识别、OCR、姿态估计、超分辨率、SLAM、医疗影像、Re-ID、GAN、NAS、深度估计、自动驾驶、强化学习、车道线检测、模型剪枝&压缩、去噪、去雾、去雨、风格迁移、遥感图像、行为识别、视频理解、图像融合、图像检索、论文投稿&交流、PyTorch和TensorFlow等群。

一定要备注:研究方向+地点+学校/公司+昵称(如论文写作+上海+上交+卡卡),根据格式备注,可更快被通过且邀请进群

▲长按加微信群

▲长按关注CVer公众号

整理不易,请给CVer点赞和在看!