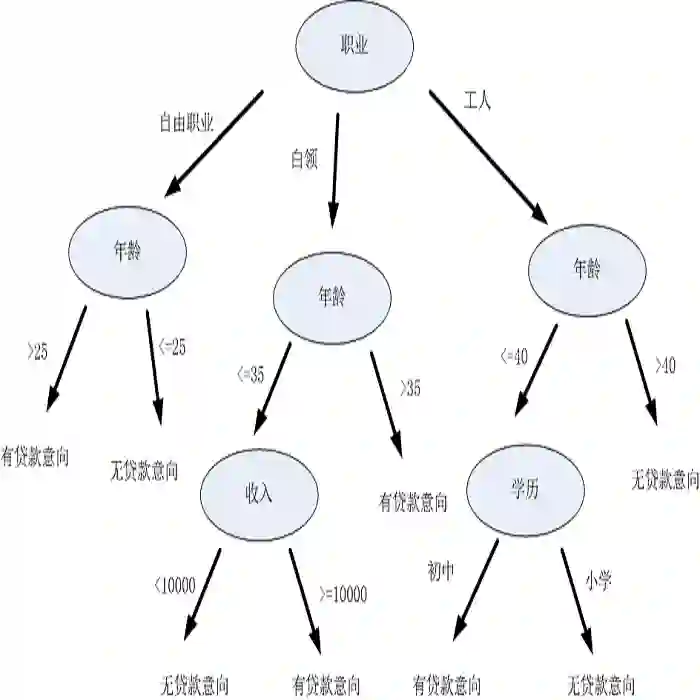

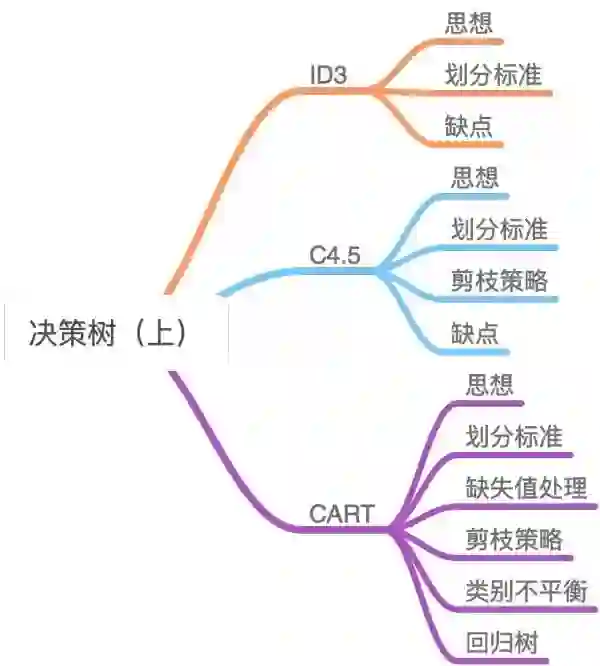

最全!两万字带你完整掌握八大决策树!

ID3

1、思想

1)初始化特征集合和数据集合;

2)计算数据集合信息熵和所有特征的条件熵,选择信息增益最大的特征作为当前决策节点;

3)更新数据集合和特征集合(删除上一步使用的特征,并按照特征值来划分不同分支的数据集合);

4)重复 2),3 )两步,若子集值包含单一特征,则为分支叶子节点。

2、划分标准

表示集合 D 中属于第 k 类样本的样本子集。

表示集合 D 中属于第 k 类样本的样本子集。

为:

为:

表示 D 中特征 A 取第 i 个值的样本子集,

表示 D 中特征 A 取第 i 个值的样本子集,

表示

表示

中属于第 k 类的样本子集。

中属于第 k 类的样本子集。

3、缺点

-

ID3 没有剪枝策略,容易过拟合; -

信息增益准则对可取值数目较多的特征有所偏好,类似“编号”的特征其信息增益接近于 1; -

只能用于处理离散分布的特征; -

没有考虑缺失值。

C4.5

1、思想

-

引入悲观剪枝策略进行后剪枝; -

引入信息增益率作为划分标准; -

将连续特征离散化,假设 n 个样本的连续特征 A 有 m 个取值,C4.5 将其排序并取相邻两样本值的平均数共 m-1 个划分点,分别计算以该划分点作为二元分类点时的信息增益,并选择信息增益最大的点作为该连续特征的二元离散分类点; 对于缺失值的处理可以分为两个子问题: -

问题一:在特征值缺失的情况下进行划分特征的选择?(即如何计算特征的信息增益率) -

问题二:选定该划分特征,对于缺失该特征值的样本如何处理?(即到底把这个样本划分到哪个结点里) 针对问题一,C4.5 的做法是:对于具有缺失值特征,用没有缺失的样本子集所占比重来折算; 针对问题二,C4.5 的做法是:将样本同时划分到所有子节点,不过要调整样本的权重值,其实也就是以不同概率划分到不同节点中。

2、划分标准

称为特征 A 的固有值。

称为特征 A 的固有值。

3、剪枝策略

-

节点内数据样本低于某一阈值; -

所有节点特征都已分裂; -

节点划分前准确率比划分后准确率高。

4、缺点

-

剪枝策略可以再优化; -

C4.5 用的是多叉树,用二叉树效率更高; -

C4.5 只能用于分类; -

C4.5 使用的熵模型拥有大量耗时的对数运算,连续值还有排序运算; -

C4.5 在构造树的过程中,对数值属性值需要按照其大小进行排序,从中选择一个分割点,所以只适合于能够驻留于内存的数据集,当训练集大得无法在内存容纳时,程序无法运行。

CART

1、思想

-

分裂:分裂过程是一个二叉递归划分过程,其输入和预测特征既可以是连续型的也可以是离散型的,CART 没有停止准则,会一直生长下去; -

剪枝:采用代价复杂度剪枝,从最大树开始,每次选择训练数据熵对整体性能贡献最小的那个分裂节点作为下一个剪枝对象,直到只剩下根节点。CART 会产生一系列嵌套的剪枝树,需要从中选出一颗最优的决策树; -

树选择:用单独的测试集评估每棵剪枝树的预测性能(也可以用交叉验证)。

-

C4.5 为多叉树,运算速度慢,CART 为二叉树,运算速度快; -

C4.5 只能分类,CART 既可以分类也可以回归; -

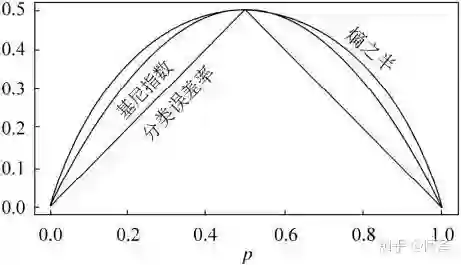

CART 使用 Gini 系数作为变量的不纯度量,减少了大量的对数运算; -

CART 采用代理测试来估计缺失值,而 C4.5 以不同概率划分到不同节点中; -

CART 采用“基于代价复杂度剪枝”方法进行剪枝,而 C4.5 采用悲观剪枝方法。

2、划分标准

,所以

,所以

3、缺失值处理

如何在特征值缺失的情况下进行划分特征的选择?

选定该划分特征,模型对于缺失该特征值的样本该进行怎样处理?

4、剪枝策略

,我们希望减少树的大小来防止过拟合,但又担心去掉节点后预测误差会增大,所以我们定义了一个损失函数来达到这两个变量之间的平衡。损失函数定义如下:

,我们希望减少树的大小来防止过拟合,但又担心去掉节点后预测误差会增大,所以我们定义了一个损失函数来达到这两个变量之间的平衡。损失函数定义如下:

为任意子树,

为任意子树,

为预测误差,

为预测误差,

为子树

为子树

的叶子节点个数,

的叶子节点个数,

是参数,

是参数,

衡量训练数据的拟合程度,

衡量训练数据的拟合程度,

衡量树的复杂度,

衡量树的复杂度,

权衡拟合程度与树的复杂度。

权衡拟合程度与树的复杂度。

来使得复杂度和拟合度达到最好的平衡点呢,最好的办法就是另

来使得复杂度和拟合度达到最好的平衡点呢,最好的办法就是另

从 0 取到正无穷,对于每一个固定的

从 0 取到正无穷,对于每一个固定的

,我们都可以找到使得

,我们都可以找到使得

最小的最优子树

最小的最优子树

。当

。当

很小的时候,

很小的时候,

是最优子树;当

是最优子树;当

最大时,单独的根节点是这样的最优子树。随着

最大时,单独的根节点是这样的最优子树。随着

增大,我们可以得到一个这样的子树序列:

增大,我们可以得到一个这样的子树序列:

,这里的子树

,这里的子树

生成是根据前一个子树

生成是根据前一个子树

剪掉某一个内部节点生成的。

剪掉某一个内部节点生成的。

从小增大,

从小增大,

,在每个区间

,在每个区间

中,子树

中,子树

是这个区间里最优的。

是这个区间里最优的。

个叶子节点,预测误差是

个叶子节点,预测误差是

;剪枝后的状态:只有本身一个叶子节点,预测误差是

;剪枝后的状态:只有本身一个叶子节点,预测误差是

。

。

使得

使得

,使得这个值为:

,使得这个值为:

的意义在于,

的意义在于,

中,子树

中,子树

是这个区间里最优的。当

是这个区间里最优的。当

大于这个值是,一定有

大于这个值是,一定有

,也就是剪掉这个节点后都比不剪掉要更优。所以每个最优子树对应的是一个区间,在这个区间内都是最优的。

,也就是剪掉这个节点后都比不剪掉要更优。所以每个最优子树对应的是一个区间,在这个区间内都是最优的。

中的每个内部节点 t 都计算:

中的每个内部节点 t 都计算:

表示阈值,故我们每次都会减去最小的

表示阈值,故我们每次都会减去最小的

。

。

5、类别不平衡

6、回归树

和

和

,求出使

,求出使

和

和

各自集合的均方差最小,同时

各自集合的均方差最小,同时

和

和

的均方差之和最小所对应的特征和特征值划分点。表达式为:

的均方差之和最小所对应的特征和特征值划分点。表达式为:

为

为

数据集的样本输出均值,

数据集的样本输出均值,

为

为

数据集的样本输出均值。

数据集的样本输出均值。

总结

-

划分标准的差异:ID3 使用信息增益偏向特征值多的特征,C4.5 使用信息增益率克服信息增益的缺点,偏向于特征值小的特征,CART 使用基尼指数克服 C4.5 需要求 log 的巨大计算量,偏向于特征值较多的特征。 -

使用场景的差异:ID3 和 C4.5 都只能用于分类问题,CART 可以用于分类和回归问题;ID3 和 C4.5 是多叉树,速度较慢,CART 是二叉树,计算速度很快; -

样本数据的差异:ID3 只能处理离散数据且缺失值敏感,C4.5 和 CART 可以处理连续性数据且有多种方式处理缺失值;从样本量考虑的话,小样本建议 C4.5、大样本建议 CART。C4.5 处理过程中需对数据集进行多次扫描排序,处理成本耗时较高,而 CART 本身是一种大样本的统计方法,小样本处理下泛化误差较大 ; -

样本特征的差异:ID3 和 C4.5 层级之间只使用一次特征,CART 可多次重复使用特征; -

剪枝策略的差异:ID3 没有剪枝策略,C4.5 是通过悲观剪枝策略来修正树的准确性,而 CART 是通过代价复杂度剪枝。

第二篇:基于集成学习的决策树

集成学习

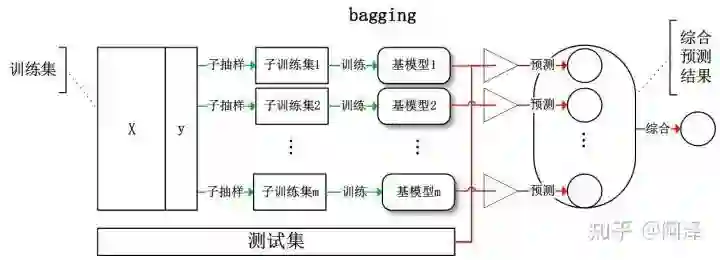

1、Bagging

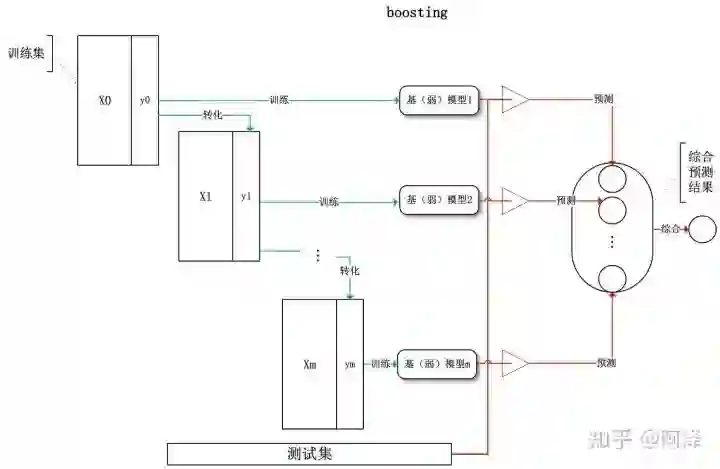

2、Boosting

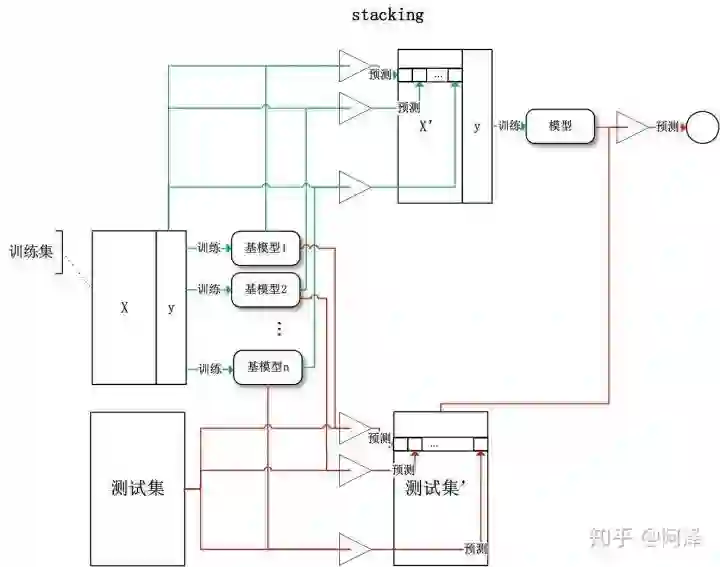

3、Stacking

偏差与方差

1、集成学习的偏差与方差

-

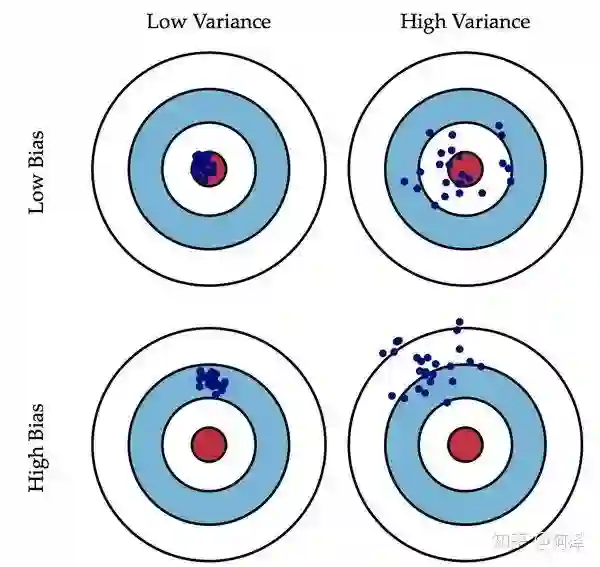

偏差:描述样本拟合出的模型的预测结果的期望与样本真实结果的差距,要想偏差表现的好,就需要复杂化模型,增加模型的参数,但这样容易过拟合,过拟合对应上图的 High Variance,点会很分散。低偏差对应的点都打在靶心附近,所以喵的很准,但不一定很稳; -

方差:描述样本上训练出来的模型在测试集上的表现,要想方差表现的好,需要简化模型,减少模型的复杂度,但这样容易欠拟合,欠拟合对应上图 High Bias,点偏离中心。低方差对应就是点都打的很集中,但不一定是靶心附近,手很稳,但不一定瞄的准。

,方差

,方差

,模型的权重为

,模型的权重为

,两两模型间的相关系数

,两两模型间的相关系数

相等。由于 Bagging 和 Boosting 的基模型都是线性组成的,那么有:

相等。由于 Bagging 和 Boosting 的基模型都是线性组成的,那么有:

2、Bagging 的偏差与方差

-

整体模型的期望等于基模型的期望,这也就意味着整体模型的偏差和基模型的偏差近似。 -

整体模型的方差小于等于基模型的方差,当且仅当相关性为 1 时取等号,随着基模型数量增多,整体模型的方差减少,从而防止过拟合的能力增强,模型的准确度得到提高。但是,模型的准确度一定会无限逼近于 1 吗?并不一定,当基模型数增加到一定程度时,方差公式第一项的改变对整体方差的作用很小,防止过拟合的能力达到极限,这便是准确度的极限了。

3、Boosting 的偏差与方差

-

整体模型的方差等于基模型的方差,如果基模型不是弱模型,其方差相对较大,这将导致整体模型的方差很大,即无法达到防止过拟合的效果。因此,Boosting 框架中的基模型必须为弱模型。 -

此外 Boosting 框架中采用基于贪心策略的前向加法,整体模型的期望由基模型的期望累加而成,所以随着基模型数的增多,整体模型的期望值增加,整体模型的准确度提高。

4、小结

-

我们可以使用模型的偏差和方差来近似描述模型的准确度; -

对于 Bagging 来说,整体模型的偏差与基模型近似,而随着模型的增加可以降低整体模型的方差,故其基模型需要为强模型; -

对于 Boosting 来说,整体模型的方差近似等于基模型的方差,而整体模型的偏差由基模型累加而成,故基模型需要为弱模型。

Random Forest

1、思想

随机选择样本(放回抽样);

随机选择特征;

构建决策树;

随机森林投票(平均)。

2、优缺点

在数据集上表现良好,相对于其他算法有较大的优势

易于并行化,在大数据集上有很大的优势;

能够处理高维度数据,不用做特征选择。

Adaboost

1、思想

初始化训练样本的权值分布,每个样本具有相同权重;

训练弱分类器,如果样本分类正确,则在构造下一个训练集中,它的权值就会被降低;反之提高。用更新过的样本集去训练下一个分类器;

将所有弱分类组合成强分类器,各个弱分类器的训练过程结束后,加大分类误差率小的弱分类器的权重,降低分类误差率大的弱分类器的权重。

2、细节

已知,所以令

已知,所以令

,随着每一轮迭代而将这个式子带入损失函数,损失函数转化为:

,随着每一轮迭代而将这个式子带入损失函数,损失函数转化为:

,可以得到:

,可以得到:

带入损失函数,并对

带入损失函数,并对

求导,使其等于 0,则就得到了:

求导,使其等于 0,则就得到了:

即为我们前面的分类误差率。

即为我们前面的分类误差率。

和

和

,即可得:

,即可得:

我们有:

我们有:

的取值范围为

的取值范围为

。对于同样的训练集学习效果,较小的

。对于同样的训练集学习效果,较小的

意味着我们需要更多的弱学习器的迭代次数。通常我们用步长和迭代最大次数一起来决定算法的拟合效果。

意味着我们需要更多的弱学习器的迭代次数。通常我们用步长和迭代最大次数一起来决定算法的拟合效果。

3、优缺点

分类精度高;

可以用各种回归分类模型来构建弱学习器,非常灵活;

不容易发生过拟合。

对异常点敏感,异常点会获得较高权重。

GBDT

1、思想

为基模型与其权重的乘积,模型的训练目标是使预测值

为基模型与其权重的乘积,模型的训练目标是使预测值

逼近真实值 y,也就是说要让每个基模型的预测值逼近各自要预测的部分真实值。由于要同时考虑所有基模型,导致了整体模型的训练变成了一个非常复杂的问题。所以研究者们想到了一个贪心的解决手段:每次只训练一个基模型。那么,现在改写整体模型为迭代式:

逼近真实值 y,也就是说要让每个基模型的预测值逼近各自要预测的部分真实值。由于要同时考虑所有基模型,导致了整体模型的训练变成了一个非常复杂的问题。所以研究者们想到了一个贪心的解决手段:每次只训练一个基模型。那么,现在改写整体模型为迭代式:

逼近真实值

逼近真实值

。

。

2、优缺点

可以自动进行特征组合,拟合非线性数据;

可以灵活处理各种类型的数据。

对异常点敏感。

3、与 Adaboost 的对比

都是 Boosting 家族成员,使用弱分类器;

都使用前向分布算法;

迭代思路不同:Adaboost 是通过提升错分数据点的权重来弥补模型的不足(利用错分样本),而 GBDT 是通过算梯度来弥补模型的不足(利用残差);

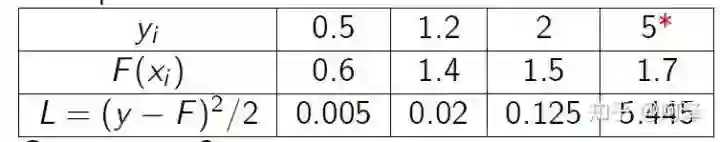

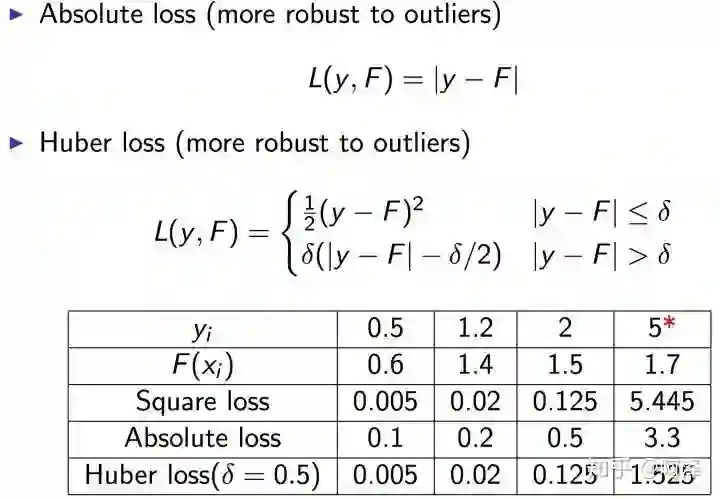

损失函数不同:AdaBoost 采用的是指数损失,GBDT 使用的是绝对损失或者 Huber 损失函数;

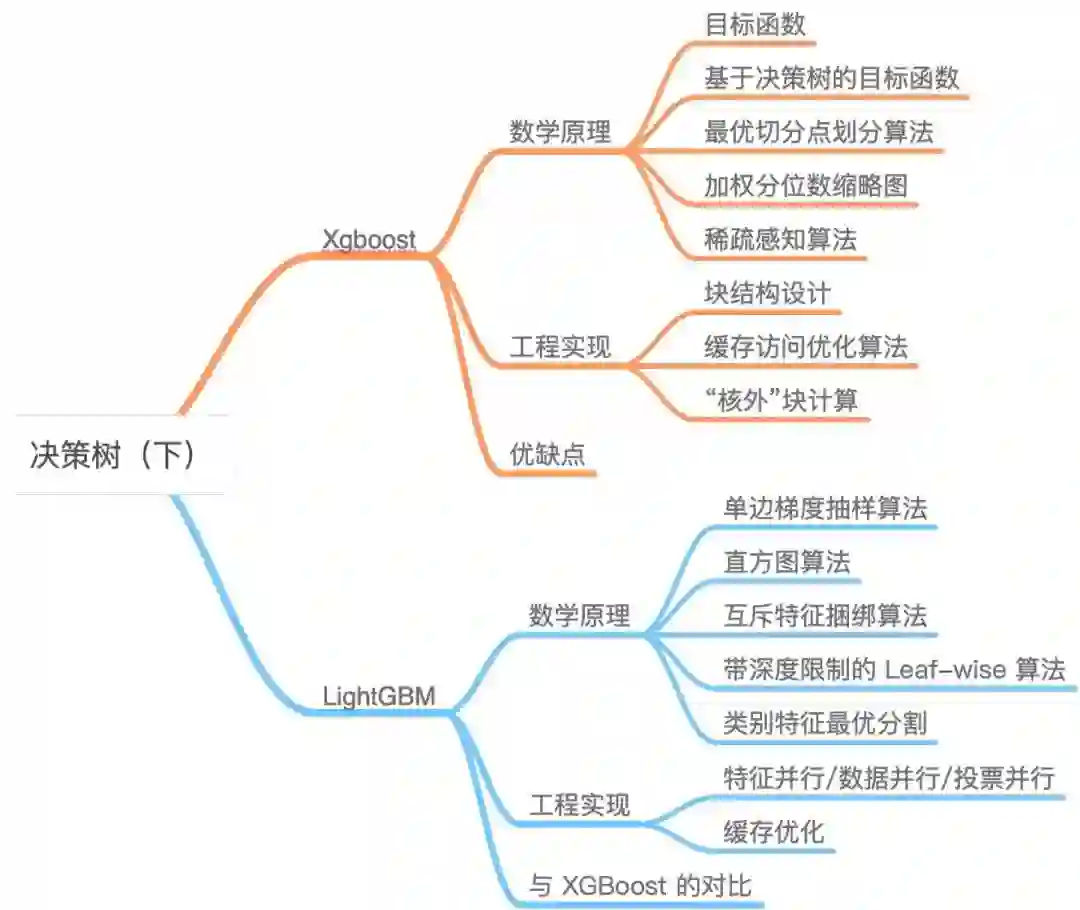

XGBoost

1、数学原理

个基模型组成的一个加法运算式:

个基模型组成的一个加法运算式:

为第

为第

个基模型,

个基模型,

为第

为第

个样本的预测值。

个样本的预测值。

与真实值

与真实值

进行表示:

进行表示:

为样本数量。

为样本数量。

与抑制模型复杂度的正则项

与抑制模型复杂度的正则项

组成,所以我们有:

组成,所以我们有:

为模型的正则项,由于 XGBoost 支持决策树也支持线性模型,所以这里再不展开描述。

为模型的正则项,由于 XGBoost 支持决策树也支持线性模型,所以这里再不展开描述。

步的模型为例,模型对第

步的模型为例,模型对第

个样本

个样本

的预测为:

的预测为:

由第

由第

步的模型给出的预测值,是已知常数,

步的模型给出的预测值,是已知常数,

是我们这次需要加入的新模型的预测值,此时,目标函数就可以写成:

是我们这次需要加入的新模型的预测值,此时,目标函数就可以写成:

。

。

处具有

处具有

阶导数的函数

阶导数的函数

利用关于

利用关于

的

的

次多项式来逼近函数的方法,若函数

次多项式来逼近函数的方法,若函数

在包含

在包含

的某个闭区间

的某个闭区间

上具有

上具有

阶导数,且在开区间

阶导数,且在开区间

上具有

上具有

阶导数,则对闭区间

阶导数,则对闭区间

上任意一点

上任意一点

有

有

,其中的多项式称为函数在

,其中的多项式称为函数在

处的泰勒展开式,

处的泰勒展开式,

是泰勒公式的余项且是

是泰勒公式的余项且是

的高阶无穷小。

的高阶无穷小。

在点

在点

处进行泰勒的二阶展开,可得到如下等式:

处进行泰勒的二阶展开,可得到如下等式:

视为

视为

,

,

视为

视为

,故可以将目标函数写为:

,故可以将目标函数写为:

为损失函数的一阶导,

为损失函数的一阶导,

为损失函数的二阶导,注意这里的导是对

为损失函数的二阶导,注意这里的导是对

求导。

求导。

步时

步时

其实是一个已知的值,所以

其实是一个已知的值,所以

是一个常数,其对函数的优化不会产生影响,因此目标函数可以写成:

是一个常数,其对函数的优化不会产生影响,因此目标函数可以写成:

是已知的,所以这两个值就是常数),然后最优化目标函数,就可以得到每一步的

是已知的,所以这两个值就是常数),然后最优化目标函数,就可以得到每一步的

,最后根据加法模型得到一个整体模型。

,最后根据加法模型得到一个整体模型。

,

,

为某一样本,这里的

为某一样本,这里的

代表了该样本在哪个叶子结点上,而

代表了该样本在哪个叶子结点上,而

则代表了叶子结点取值

则代表了叶子结点取值

,所以

,所以

就代表了每个样本的取值

就代表了每个样本的取值

(即预测值)。

(即预测值)。

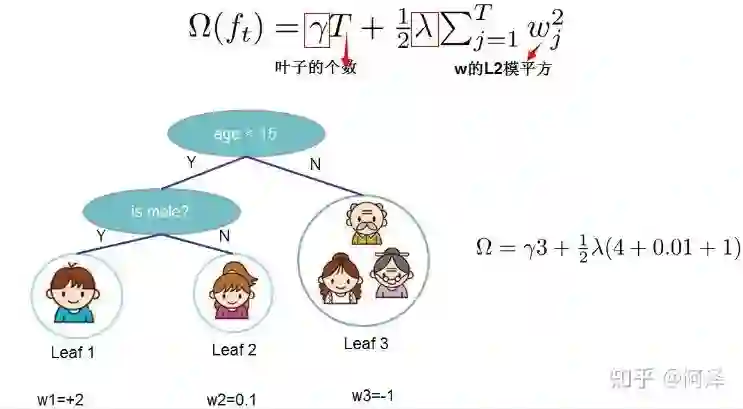

组成,叶子节点越少模型越简单,此外叶子节点也不应该含有过高的权重

组成,叶子节点越少模型越简单,此外叶子节点也不应该含有过高的权重

(类比 LR 的每个变量的权重),所以目标函数的正则项可以定义为:

(类比 LR 的每个变量的权重),所以目标函数的正则项可以定义为:

范式共同决定。

范式共同决定。

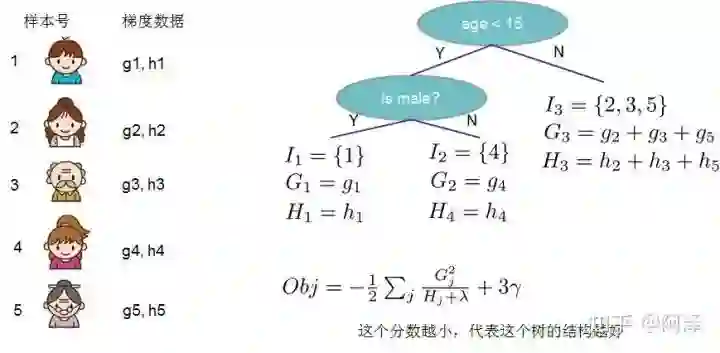

为第

为第

个叶子节点的样本集合,故我们的目标函数可以写成:

个叶子节点的样本集合,故我们的目标函数可以写成:

和

和

这两项,

这两项,

为第

为第

个叶子节点取值。

个叶子节点取值。

,

,

,则目标函数为:

,则目标函数为:

和

和

是前

是前

步得到的结果,其值已知可视为常数,只有最后一棵树的叶子节点

步得到的结果,其值已知可视为常数,只有最后一棵树的叶子节点

不确定,那么将目标函数对

不确定,那么将目标函数对

求一阶导,并令其等于

求一阶导,并令其等于

,则可以求得叶子结点

,则可以求得叶子结点

对应的权值:

对应的权值:

和二阶导数

和二阶导数

,然后针对每个节点对所含样本求和得到的

,然后针对每个节点对所含样本求和得到的

和

和

,最后遍历决策树的节点即可得到目标函数。

,最后遍历决策树的节点即可得到目标函数。

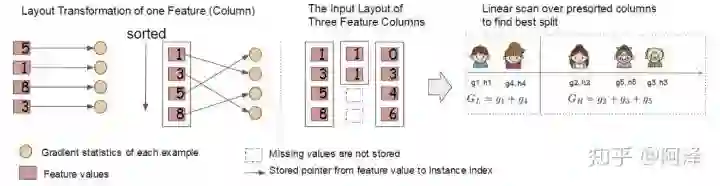

从深度为

的树开始,对每个叶节点枚举所有的可用特征;

针对每个特征,把属于该节点的训练样本根据该特征值进行升序排列,通过线性扫描的方式来决定该特征的最佳分裂点,并记录该特征的分裂收益;

选择收益最大的特征作为分裂特征,用该特征的最佳分裂点作为分裂位置,在该节点上分裂出左右两个新的叶节点,并为每个新节点关联对应的样本集

回到第 1 步,递归执行到满足特定条件为止

这样的条件,对于某个特定的分割点

这样的条件,对于某个特定的分割点

我们要计算

我们要计算

左边和右边的导数和。

左边和右边的导数和。

,我们只要做一遍从左到右的扫描就可以枚举出所有分割的梯度和

,我们只要做一遍从左到右的扫描就可以枚举出所有分割的梯度和

和

和

。然后用上面的公式计算每个分割方案的分数就可以了。

。然后用上面的公式计算每个分割方案的分数就可以了。

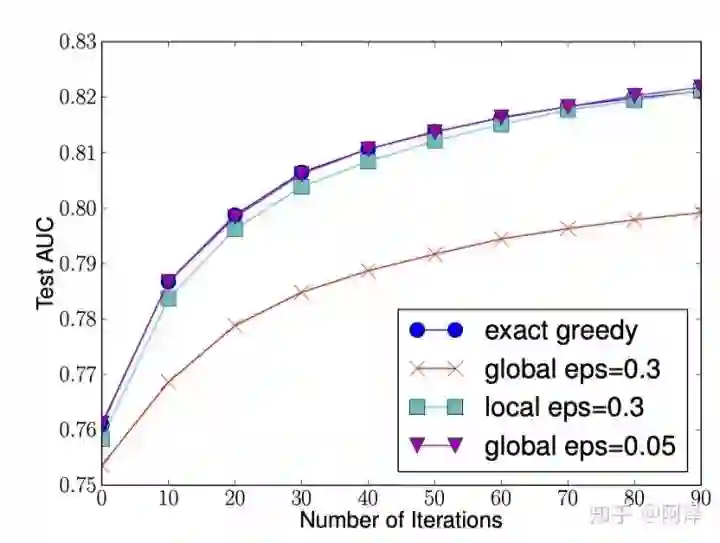

-

Global:学习每棵树前就提出候选切分点,并在每次分裂时都采用这种分割; -

Local:每次分裂前将重新提出候选切分点。

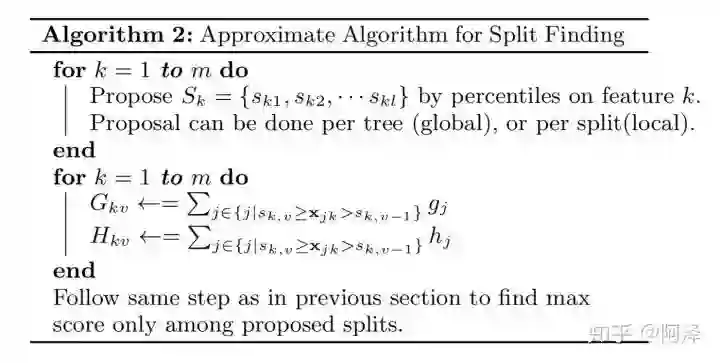

-

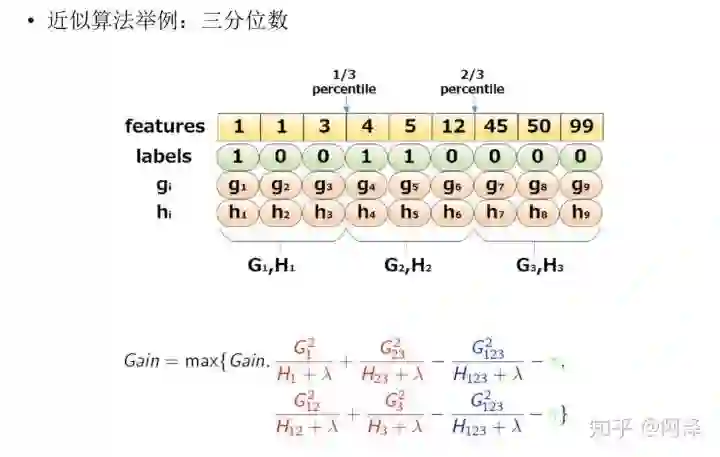

第一个 for 循环:对特征 k 根据该特征分布的分位数找到切割点的候选集合 。XGBoost 支持 Global 策略和 Local 策略。

-

第二个 for 循环:针对每个特征的候选集合,将样本映射到由该特征对应的候选点集构成的分桶区间中,即 ,对每个桶统计

值,最后在这些统计量上寻找最佳分裂点。

值,最终求解节点划分的增益。

值,最终求解节点划分的增益。

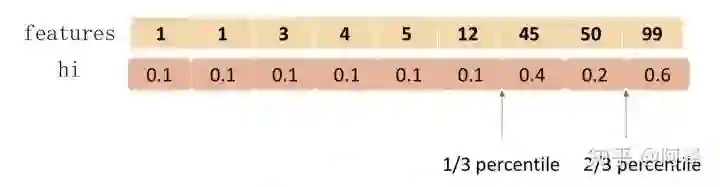

作为样本的权重进行划分,如下:

作为样本的权重进行划分,如下:

进行样本加权?

进行样本加权?

有对 loss 加权的作用。

有对 loss 加权的作用。

与

与

皆为常数。我们可以看到

皆为常数。我们可以看到

就是平方损失函数中样本的权重。

就是平方损失函数中样本的权重。

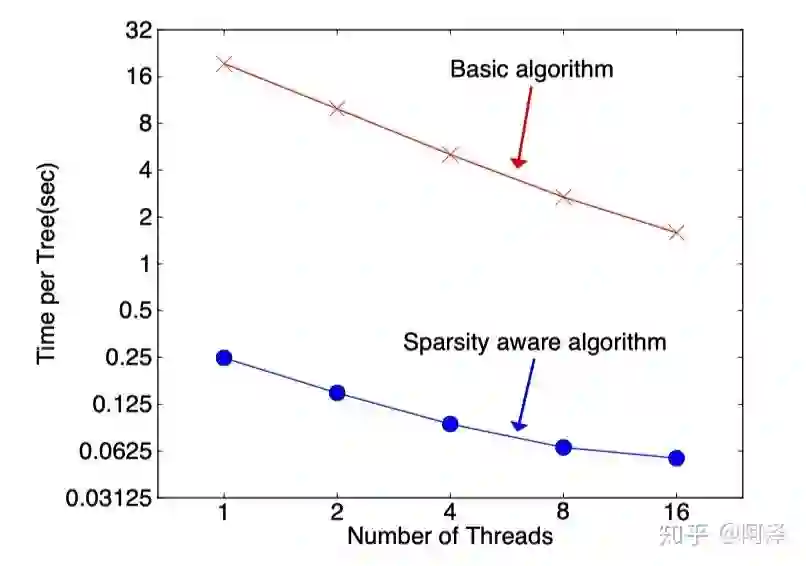

2、工程实现

-

每一个块结构包括一个或多个已经排序好的特征; -

缺失特征值将不进行排序; -

每个特征会存储指向样本梯度统计值的索引,方便计算一阶导和二阶导数值;

-

块压缩:对 Block 进行按列压缩,并在读取时进行解压; -

块拆分:将每个块存储到不同的磁盘中,从多个磁盘读取可以增加吞吐量。

3、优缺点

精度更高:GBDT 只用到一阶泰勒展开,而 XGBoost 对损失函数进行了二阶泰勒展开。XGBoost 引入二阶导一方面是为了增加精度,另一方面也是为了能够自定义损失函数,二阶泰勒展开可以近似大量损失函数;

灵活性更强:GBDT 以 CART 作为基分类器,XGBoost 不仅支持 CART 还支持线性分类器,(使用线性分类器的 XGBoost 相当于带 L1 和 L2 正则化项的逻辑斯蒂回归(分类问题)或者线性回归(回归问题))。此外,XGBoost 工具支持自定义损失函数,只需函数支持一阶和二阶求导;

正则化:XGBoost 在目标函数中加入了正则项,用于控制模型的复杂度。正则项里包含了树的叶子节点个数、叶子节点权重的 L2 范式。正则项降低了模型的方差,使学习出来的模型更加简单,有助于防止过拟合;

Shrinkage(缩减):相当于学习速率。XGBoost 在进行完一次迭代后,会将叶子节点的权重乘上该系数,主要是为了削弱每棵树的影响,让后面有更大的学习空间;

列抽样:XGBoost 借鉴了随机森林的做法,支持列抽样,不仅能降低过拟合,还能减少计算;

缺失值处理:XGBoost 采用的稀疏感知算法极大的加快了节点分裂的速度;

可以并行化操作:块结构可以很好的支持并行计算。

虽然利用预排序和近似算法可以降低寻找最佳分裂点的计算量,但在节点分裂过程中仍需要遍历数据集;

预排序过程的空间复杂度过高,不仅需要存储特征值,还需要存储特征对应样本的梯度统计值的索引,相当于消耗了两倍的内存。

LightGBM

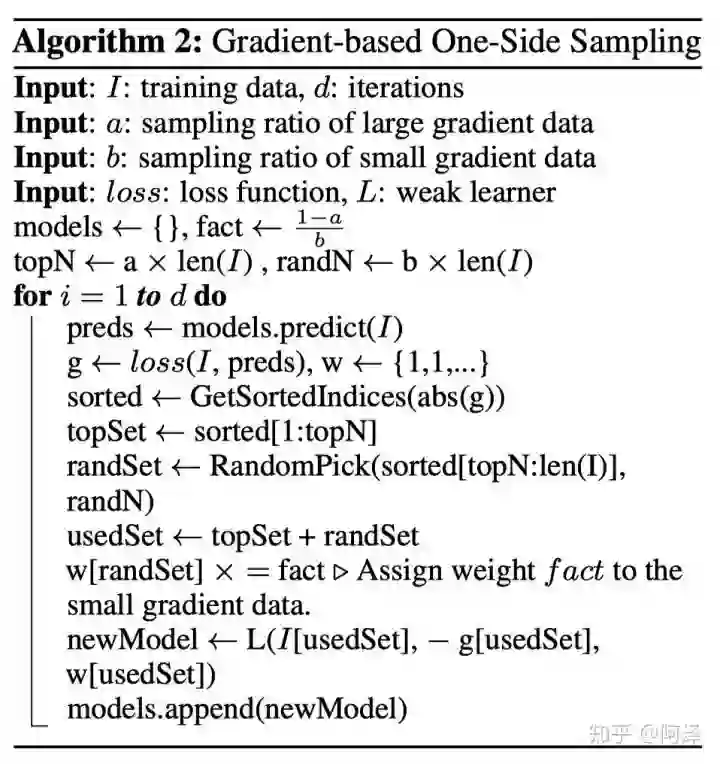

单边梯度抽样算法;

直方图算法;

互斥特征捆绑算法;

基于最大深度的 Leaf-wise 的垂直生长算法;

类别特征最优分割;

特征并行和数据并行;

缓存优化。

1、数学原理

来放大梯度小的样本的权重。一方面算法将更多的注意力放在训练不足的样本上,另一方面通过乘上权重来防止采样对原始数据分布造成太大的影响。

来放大梯度小的样本的权重。一方面算法将更多的注意力放在训练不足的样本上,另一方面通过乘上权重来防止采样对原始数据分布造成太大的影响。

-

内存占用更小:XGBoost 需要用 32 位的浮点数去存储特征值,并用 32 位的整形去存储索引,而 LightGBM 只需要用 8 位去存储直方图,相当于减少了 1/8; -

计算代价更小:计算特征分裂增益时,XGBoost 需要遍历一次数据找到最佳分裂点,而 LightGBM 只需要遍历一次 k 次,直接将时间复杂度从 降低到

,而我们知道

。

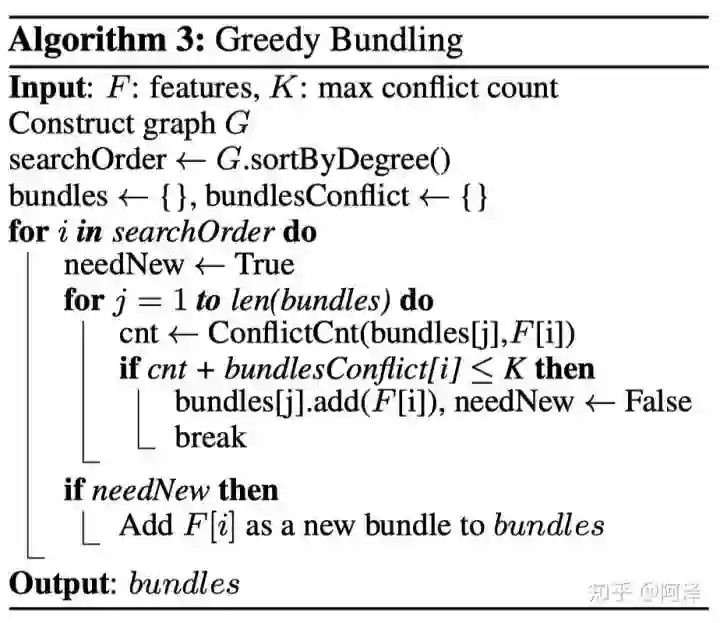

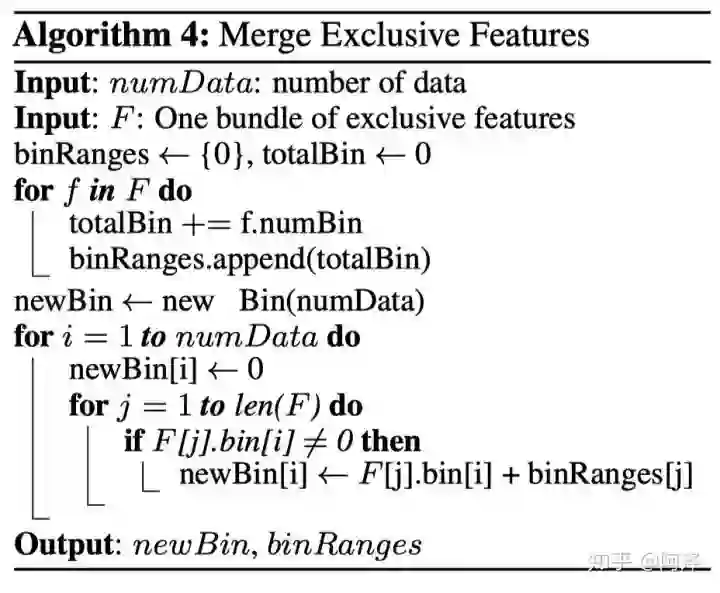

哪些特征可以一起绑定?

特征绑定后,特征值如何确定?

构造一个加权无向图,顶点是特征,边是两个特征间互斥程度;

根据节点的度进行降序排序,度越大,与其他特征的冲突越大;

遍历每个特征,将它分配给现有特征包,或者新建一个特征包,是的总体冲突最小。

来平衡算法的精度和效率。EFB 算法的伪代码如下所示:

来平衡算法的精度和效率。EFB 算法的伪代码如下所示:

,在特征不多的情况下可以应付,但如果特征维度达到百万级别,计算量则会非常大,为了改善效率,我们提出了一个更快的解决方案:将 EFB 算法中通过构建图,根据节点度来排序的策略改成了根据非零值的技术排序,因为非零值越多,互斥的概率会越大。

,在特征不多的情况下可以应付,但如果特征维度达到百万级别,计算量则会非常大,为了改善效率,我们提出了一个更快的解决方案:将 EFB 算法中通过构建图,根据节点度来排序的策略改成了根据非零值的技术排序,因为非零值越多,互斥的概率会越大。

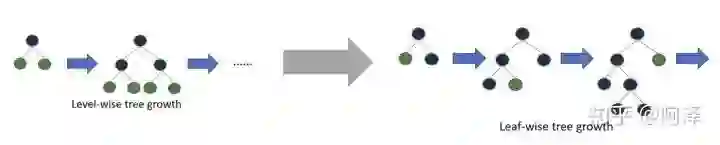

4)带深度限制的 Leaf-wise 算法

-

Level-wise:基于层进行生长,直到达到停止条件; -

Leaf-wise:每次分裂增益最大的叶子节点,直到达到停止条件。

-

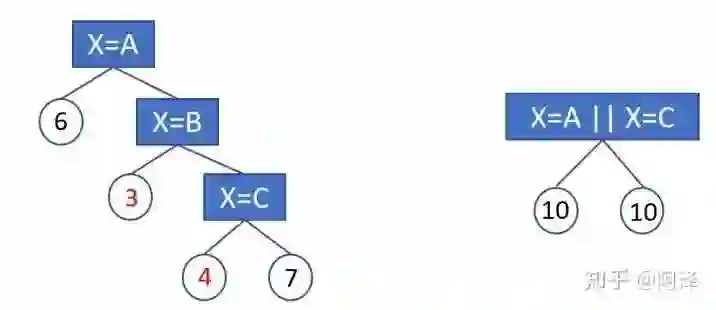

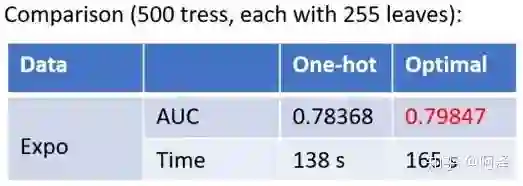

会产生样本切分不平衡问题,切分增益会非常小。如,国籍切分后,会产生是否中国,是否美国等一系列特征,这一系列特征上只有少量样本为 1,大量样本为 0。这种划分的增益非常小:较小的那个拆分样本集,它占总样本的比例太小。无论增益多大,乘以该比例之后几乎可以忽略;较大的那个拆分样本集,它几乎就是原始的样本集,增益几乎为零; -

影响决策树学习:决策树依赖的是数据的统计信息,而独热码编码会把数据切分到零散的小空间上。在这些零散的小空间上统计信息不准确的,学习效果变差。本质是因为独热码编码之后的特征的表达能力较差的,特征的预测能力被人为的拆分成多份,每一份与其他特征竞争最优划分点都失败,最终该特征得到的重要性会比实际值低。

中可能,时间复杂度为

中可能,时间复杂度为

,LightGBM 基于 Fisher 大佬的 《On Grouping For Maximum Homogeneity》实现了

,LightGBM 基于 Fisher 大佬的 《On Grouping For Maximum Homogeneity》实现了

的时间复杂度。

的时间复杂度。

对直方图进行排序,然后在排序的直方图上找到最佳分割。此外,LightGBM 还加了约束条件正则化,防止过拟合。

对直方图进行排序,然后在排序的直方图上找到最佳分割。此外,LightGBM 还加了约束条件正则化,防止过拟合。

2、工程实现

;如果使用集成的通信,则通讯开销为

;如果使用集成的通信,则通讯开销为

,

,

本地找出 Top K 特征,并基于投票筛选出可能是最优分割点的特征;

合并时只合并每个机器选出来的特征。

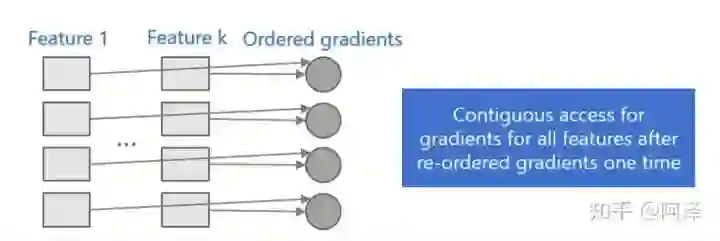

首先,所有的特征都采用相同的方法获得梯度(区别于不同特征通过不同的索引获得梯度),只需要对梯度进行排序并可实现连续访问,大大提高了缓存命中;

其次,因为不需要存储特征到样本的索引,降低了存储消耗,而且也不存在 Cache Miss的问题。

3、与 XGBoost 的对比

XGBoost 使用预排序后需要记录特征值及其对应样本的统计值的索引,而 LightGBM 使用了直方图算法将特征值转变为 bin 值,且不需要记录特征到样本的索引,将空间复杂度从

降低为

,极大的减少了内存消耗;

LightGBM 采用了直方图算法将存储特征值转变为存储 bin 值,降低了内存消耗;

LightGBM 在训练过程中采用互斥特征捆绑算法减少了特征数量,降低了内存消耗。

LightGBM 采用了直方图算法将遍历样本转变为遍历直方图,极大的降低了时间复杂度;

LightGBM 在训练过程中采用单边梯度算法过滤掉梯度小的样本,减少了大量的计算;

LightGBM 采用了基于 Leaf-wise 算法的增长策略构建树,减少了很多不必要的计算量;

LightGBM 采用优化后的特征并行、数据并行方法加速计算,当数据量非常大的时候还可以采用投票并行的策略;

-

LightGBM 对缓存也进行了优化,增加了 Cache hit 的命中率。

参考文献:

《机器学习》周志华,

《数据挖掘十大算法》吴信东

CART 树怎么进行剪枝?,zhihu.com/question/22697086

机器学习算法中 GBDT 与 Adaboost 的区别与联系是什么?- Frankenstein 的回答 - 知乎,https://www.zhihu.com/question/54626685/answer/140610056

为什么说bagging是减少variance,而boosting是减少bias,https://www.zhihu.com/question/26760839

Ensemble Learning - 周志华,https://cs.nju.edu.cn/zhouzh/zhouzh.files/publication/springerEBR09.pdf

使用sklearn进行集成学习——理论,https://www.cnblogs.com/jasonfreak/p/5657196.html

《XGBoost: A Scalable Tree Boosting System》,https://arxiv.org/pdf/1603.02754.pdf

陈天奇论文演讲 PPT,https://homes.cs.washington.edu/~tqchen/pdf/BoostedTree.pdf

LightGBM: A Highly Efficient Gradient Boosting Decision Tree,https://papers.nips.cc/paper/6907-lightgbm-a-highly-efficient-gradient-boosting-decision-tree.pdf

LightGBM 文档,https://lightgbm.readthedocs.io/en/latest/

论文阅读——LightGBM 原理,https://www.biaodianfu.com/lightgbm.html

机器学习算法之 LightGBM,https://blog.csdn.net/shine19930820/article/details/79123216

关于sklearn中的决策树是否应该用one-hot编码?- 柯国霖的回答 - 知乎,https://www.zhihu.com/question/266195966/answer/306104444

如何玩转LightGBM,https://v.qq.com/x/page/k0362z6lqix.html

-

A Communication-Efficient Parallel Algorithm for Decision Tree, http://papers.nips.cc/paper/6381-a-communication-efficient-parallel-algorithm-for-decision-tree

【机器学习】决策树(上)——ID3、C4.5、CART(非常详细),https://zhuanlan.zhihu.com/p/85731206

【机器学习】决策树(中)——Random Forest、Adaboost、GBDT (非常详细),https://zhuanlan.zhihu.com/p/86263786

【机器学习】决策树(下)——XGBoost、LightGBM(非常详细),https://zhuanlan.zhihu.com/p/87885678

ACL 2020原定于2020年7月5日至10日在美国华盛顿西雅图举行,因新冠肺炎疫情改为线上会议。为促进学术交流,方便国内师生提早了解自然语言处理(NLP)前沿研究,AI 科技评论将推出「ACL 实验室系列论文解读」内容,同时欢迎更多实验室参与分享,敬请期待!

![]()

点击"阅读原文",直达“ACL 交流小组”了解更多会议信息。