每日论文 | 用循环世界模型改良策略进化;轻量级CNN:ChannelNets;强化学习知识点总结

Recurrent World Models Facilitate Policy Evolution

本文来自谷歌的David Ha,并将会在NIPS 2018上进行口头展示。这篇论文讲述了生成循环神经网络在无监督模式下快速得到训练,之后通过压缩后的时空表示建立了多种常见的强化学习环境模型。作者将World model提取出的特征输入到策略中,在多种环境下达到了领先的结果。

地址:https://arxiv.org/abs/1809.01999

ChannelNets: Compact and Efficient Convolutional Neural Networks via Channel-Wise Convolutions

卷积神经网络可以解决多种AI任务,但是模型体积越来越大,在很多资源有限的应用上都难以应用。在这篇文章中,我们提出用通道式的卷积对深度模型进行压缩,将特征映射中的密集连接换成CNN中稀疏的连接。基于此,我们创建了轻量级的CNN,成为ChannelNets。

地址:https://arxiv.org/abs/1809.01330

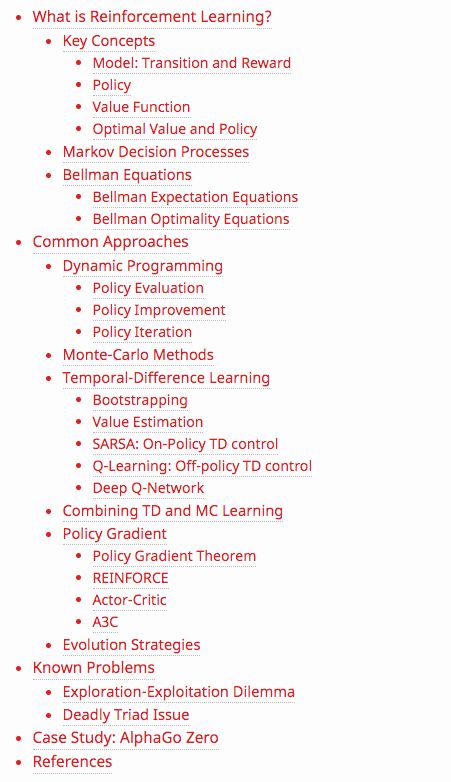

A (Long) Peek into Reinforcement Learning

这并不是一篇论文,而是作者Lilian Weng总结的有关强化学习的基础概念和经典算法,对新手来说是一份很详细的指南。文章非常长,建议收藏。

地址:https://lilianweng.github.io/lil-log/2018/02/19/a-long-peek-into-reinforcement-learning.html

登录查看更多

相关内容

Arxiv

3+阅读 · 2018年5月1日