凭“颜值”拒稿,误判率仅0.4%?这篇计算机视觉论文让AI学界炸了锅

晓查 夏乙 发自 凹非寺

量子位 出品 | 公众号 QbitAI

这两天,一项“看脸”审核计算机视觉论文的研究让AI学者们一片红红火火恍恍惚惚。

不少人哈哈哈哈怀疑作者在搞笑,当然也有很多人严肃读论文,辩论数据、结论的不合理之处。甚至有人说,研究揭示了论文评审中本就存在的人类偏见。

△ Jia-Bin Huang

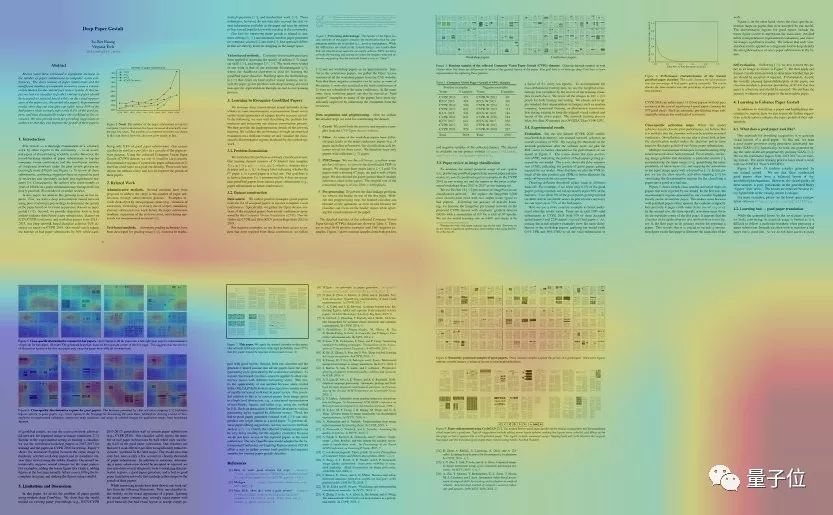

这项火遍国外AI界的论文,就是弗吉尼亚理工大学助理教授Jia-Bin Huang的Deep Paper Gestalt。

顶会领域主席的烦恼

Jia-Bin Huang(我们还是叫他黄老师吧)是计算机视觉顶会CVPR 2019和ICCV 2019的领域主席(Area Chair),当然深知学术会议投稿现状。

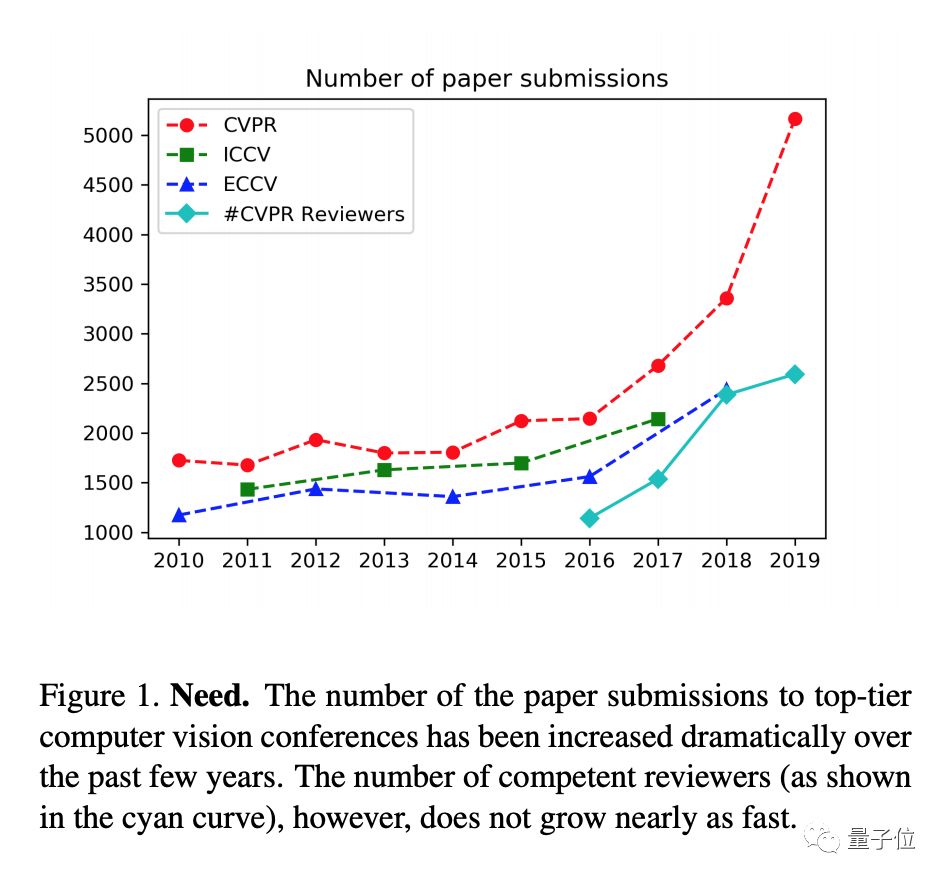

要问现在学术界的主要矛盾是什么?

那必须是:日益增长的论文投递数量,和捉襟见肘的同行评审数量之间的矛盾。

所以评审们也是压力山大啊,每天有那么大的工作量。黄老师在论文一开头就一本正经义正辞严地指出:这为目前的同行评审系统带来了相当大的负担。

谷歌研究员David Ha对此深表同情,他说:

今年CVPR就收到了5000多篇投稿,如果我是程序主席,要说没想过训练个鉴别器减轻评审工作量那肯定是在说谎。

不知道黄老师这项研究,是不是看着2019年的投稿情况,有感而发。

任性“丑拒”,误判率仅0.4%

怎么判别论文怎么样?CV行业的事情就让CV工具来解决吧!

黄老师这项爆红的研究,就是设计了一种分类器,根据论文的视觉外观来预测会不会被接收。

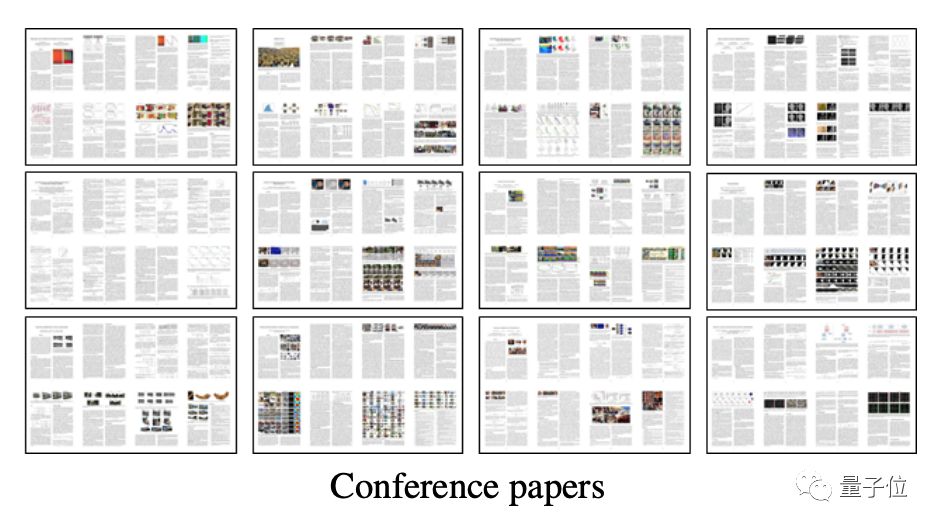

要训练算法识别一篇论文能不能中顶会,自然要用中了和没中的论文来训练它。

于是,黄老师收集了近5年的CVPR和ICCV主会和workshop论文。其中,主会论文自然是被接收的样本,被拒的论文从哪来呢?在这项研究里,这部分样本用了workshop论文,因为“近似”。

这些论文都被转成图片,再去掉首页的作者和标题。

然后,用ResNet-18分类网络,使用好坏两种输出替换ImageNet的1000个分类。根据迁移学习学习,作者使用了随机梯度下降(SGD)方法对训练数据集上的ImageNet预训练网络进行微调。

实验结果表明,文章提出的分类器可以安全地拒绝50%的不良论文,而错误地拒绝好论文的概率只有0.4%。

看似随意的“丑拒”,误判率低得惊人。这也吓到了不少网友,他们各吐心声,比如:

真是吓到了根据排版样式来评判一个想法也太肤浅了吧,历史上有多少关键论文倒在了这一关?

还有人联想到了颜值之外的歧视:

如果你加上作者性别信息,你会发现,对于女性第一作者/最后一名作者也有偏见。

虽说大多数声音都在表示担忧,但大家都对一个小彩蛋喜闻乐见:这个算法,把这篇论文自己,给毙掉了……

黄老师说,从热力图来看,算法主要是嫌弃这篇论文连8页都没写满。 于是就自杀了

他也指出,这个“自杀了”的研究有它的局限性。

首先,这种方法只看论文颜值而不管内容。如果你写的是一篇好文章,只是排版比较糟心,那么很可能被“误杀”。

其次,他用的都是CV行业大会的论文,评审的偏好会影响分类器最终的结果,所以如果你要投其他方向的论文,分类器筛选的结果也不可信。

好论文长什么样?

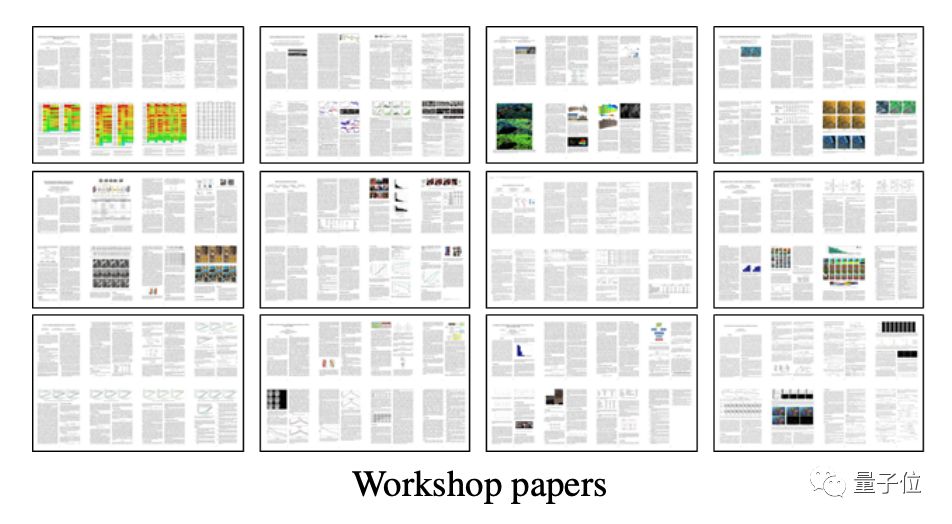

网友们吐槽之外,还提出了一个普遍关心的问题:究竟长什么样的论文才能中顶会?

这在论文中就有答案。

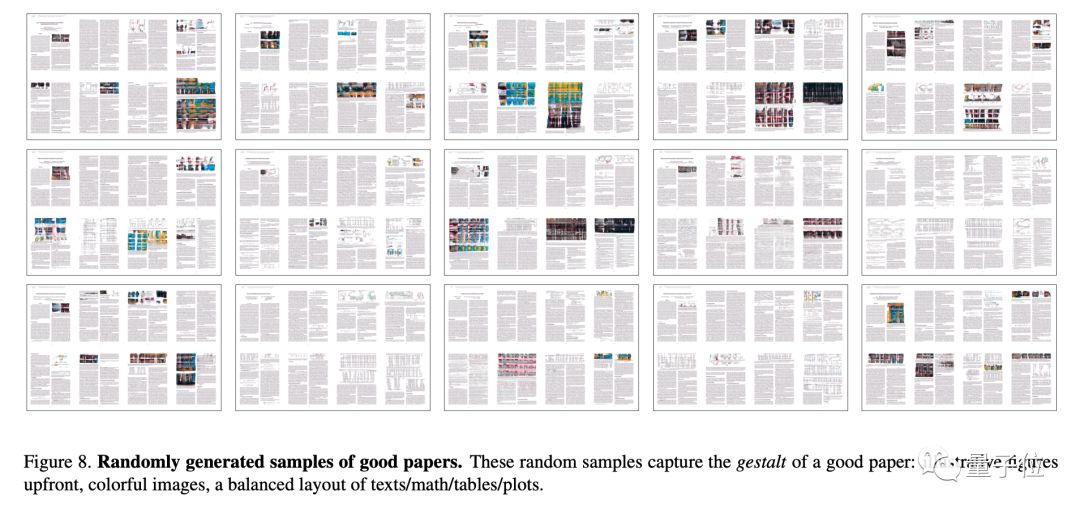

黄老师把前面数据集里的主会论文喂给了GAN,做了一个优质论文生成器,让GAN来生成论文版式。

上面这些,就都是算法自动生成的“好”论文样式。它们通常靠前安排了说明性图表,图文并茂还是彩色的,文字、数学公式、表格、图解分布均衡。

传送门

作者已经在GitHub上列出了这项研究的一大堆相关地址,包括论文、数据集、预训练模型权重、潜在空间的可视化视频等等。

地址在这里:

https://github.com/vt-vl-lab/paper-gestalt

一篇论文的命运竟然和颜值息息相关,这事儿你怎么看?

作者系网易新闻·网易号“各有态度”签约作者

— 完 —

加入社群

量子位AI社群开始招募啦,欢迎对AI感兴趣的同学,在量子位公众号(QbitAI)对话界面回复关键字“交流群”,获取入群方式;

此外,量子位专业细分群(自动驾驶、CV、NLP、机器学习等)正在招募,面向正在从事相关领域的工程师及研究人员。

进专业群请在量子位公众号(QbitAI)对话界面回复关键字“专业群”,获取入群方式。(专业群审核较严,敬请谅解)

诚挚招聘

量子位正在招募编辑/记者,工作地点在北京中关村。期待有才气、有热情的同学加入我们!相关细节,请在量子位公众号(QbitAI)对话界面,回复“招聘”两个字。

量子位 QbitAI · 头条号签约作者

վ'ᴗ' ի 追踪AI技术和产品新动态

好看吗?↘↘↘