清华作者排名第一,多人中稿超十篇:NeurIPS 2022统计数据出炉

来源:机器之心

本文为约1036字,建议阅读2分钟

本文介绍

了全球最负盛名的 AI 学术会议之一NeurIPS统计结果,本届大会清华大学成绩亮眼。

NeurIPS 已经成为名副其实的万人大会——不仅观众数量上万,投稿数量也上万。

作为当前全球最负盛名的 AI 学术会议之一,NeurIPS 是每年学界的重要事件,通常在每年 12 月举办。大会讨论的内容包含深度学习、计算机视觉、大规模机器学习、学习理论、优化、稀疏理论等众多细分领域。

今年 NeurIPS 已是第 36 届,将于 11 月 28 日至 12 月 9 日举行,为期两周。第一周将在美国新奥尔良 Ernest N. Morial 会议中心举行现场会议,第二周改为线上会议。

9 月下旬,NeurIPS 公布了今年的论文接收情况,今年各界一共提交了 10411 篇论文,2672 篇获接收,最终接收率为 25.6%,相比去年,投稿数量继续增加。

昨日,苏黎世联邦理工学院数据科学博士 Sanagno 汇总了 NeurIPS 2022 相关的信息,包括个人中稿量排行、机构中稿量排行以及论文标题和摘要中出现最多的词汇。

项目地址:https://github.com/sanagno/neurips_2022_statistics

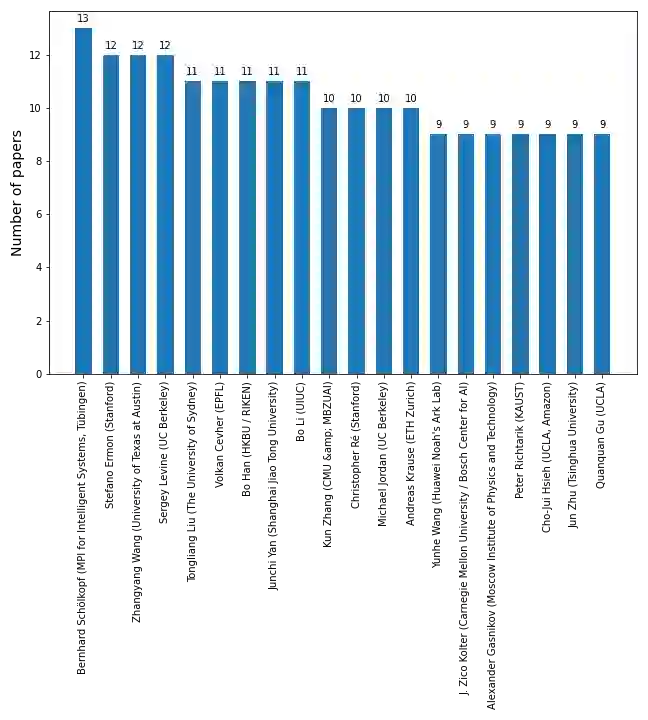

首先是个人中稿量排行,其中排名第一的是马克斯 · 普朗克智能系统研究所所长 Bernhard Schölkopf,接收了 13 篇;

并列第二的分别有斯坦福大学计算机科学系副教授 Stefano Ermon、德克萨斯州大学奥斯汀分校助理教授 Zhangyang Wang 和加州大学伯克利分校副教授 Sergey Levine,接收了 12 篇。

并列第三的分别有悉尼大学人工智能中心主任刘同亮(Tongliang Liu)、洛桑联邦理工学院 LIONS 实验室副教授 Volkan Cevher、香港浸会大学计算机科学助理教授韩波(Bo Han)、上海交通大学副教授严骏驰(Junchi Yan)和伊利诺伊大学厄巴纳 - 香槟分校助理教授 Bo Li,接收了 11 篇。

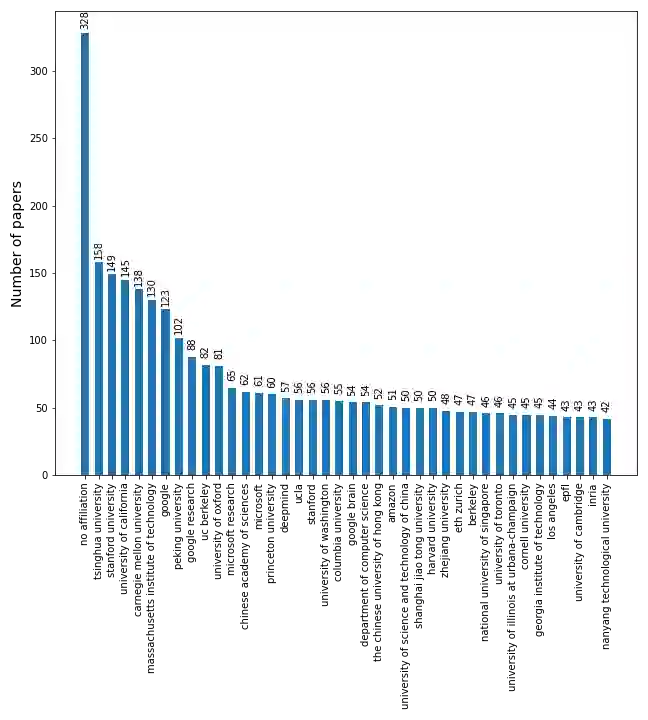

其次是机构中稿量排行,除了无归属机构(no affiliation)之外,排名前三的依次为清华、斯坦福和加州大学。

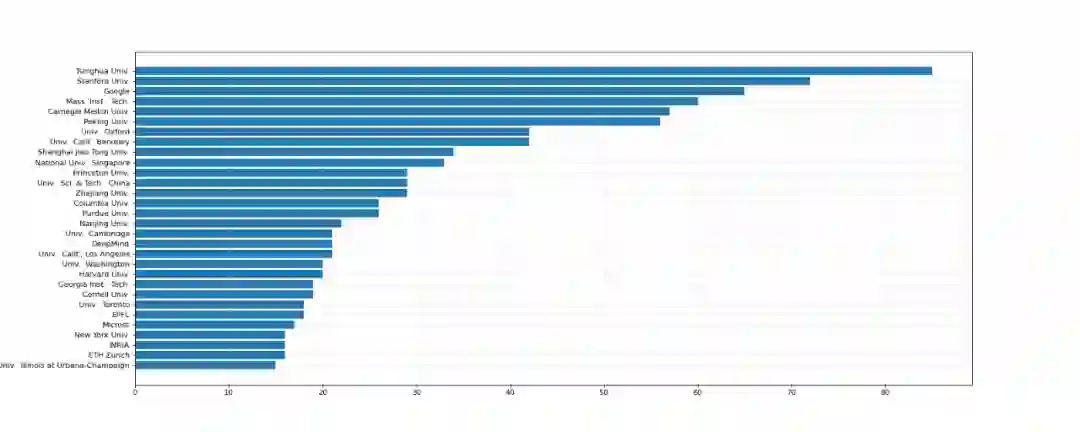

另有一个统计结果显示,如果仅看第一作者,则清华大学有 85 篇是排名第一的机构,斯坦福大学和谷歌位居二三位。

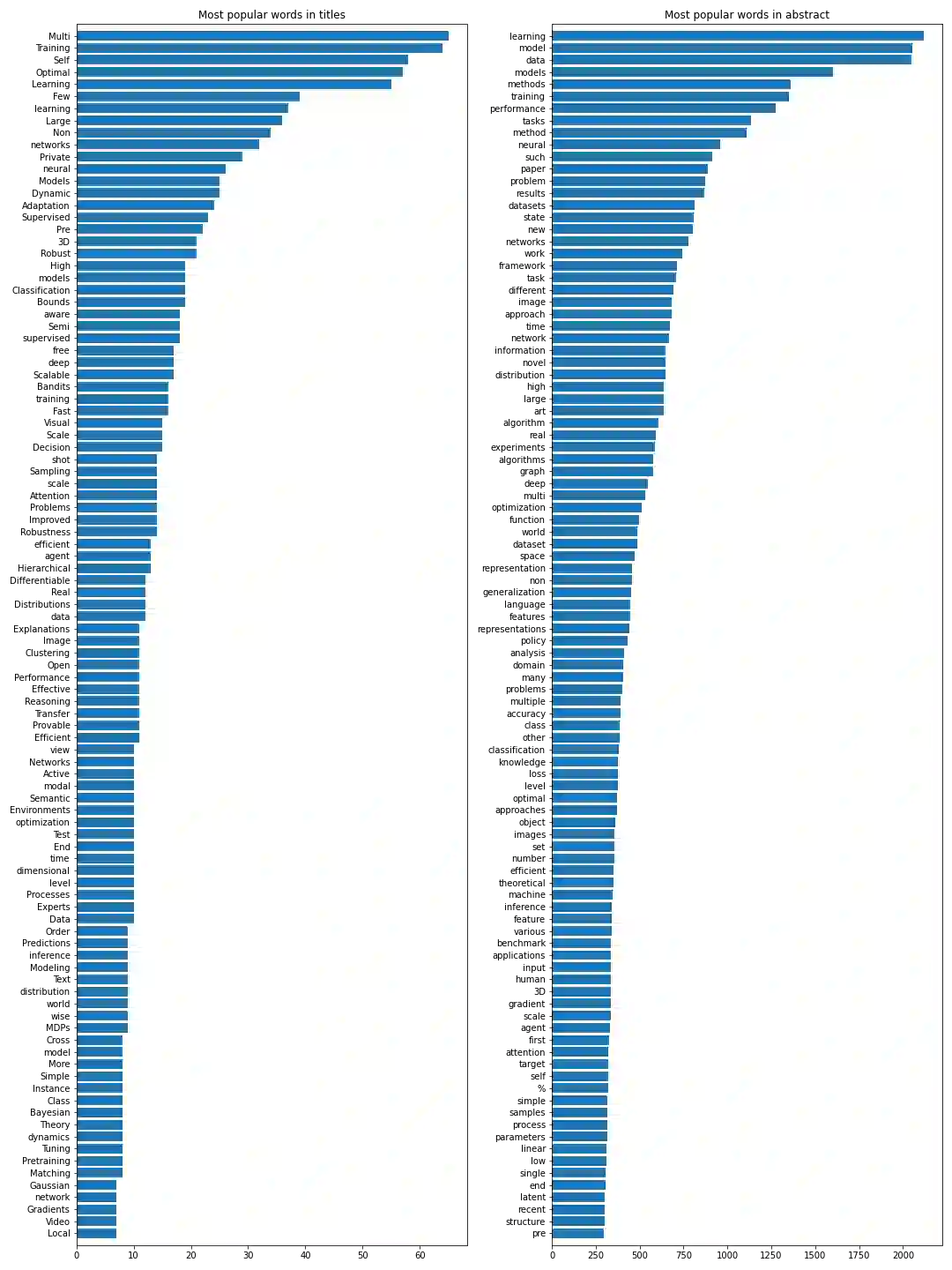

最后,标题中出现词汇最多的前五名依次为 Multi、Training、Self、Optimal 和 Learning,摘要中依次为 learning、model、data、models 和 methods。