AI自动生成维基百科,智能组合互联网信息

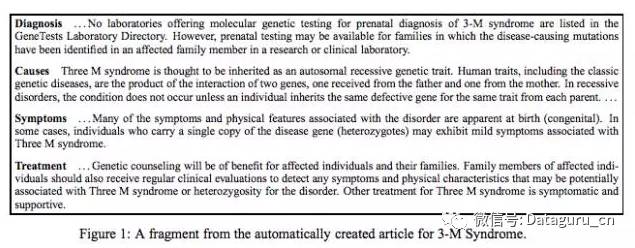

MIT Computer Science and Artificial Intelligence Laboratory 的研究人员对自动创建多段落概述文章、提供某个主题的全面总结的任务进行了研究。这些概述指的是——举例来说——IMDB 上的明星传记和维基百科的疾病概要。人工制作这些文本是一项劳动密集型工作,特别是当相关信息散布在各种互联网来源时。研究者的目标是使这个过程自动化,通过智能地组合来自互联网的相关摘录来创建一个主题(例如3-M综合征,如下图)的概述。

作为起点,研究人员可以采用多文档摘要所使用的方法。 但是,这一任务在内容规划方面存在更多的技术挑战。生成一个全面的概述文章需要积极的策略来收集相关资料,例如搜索互联网。此外,在创建讨论多个主题的较长文档时,维护产出可读性的挑战也被放大了。

在研究人员所采用的方法中,探讨了如何将人工撰写的文献的高级结构用于制作具有良好形式的综合性文章。研究者使用特定领域的自动生成的内容模板为文章选择相关资料。例如,关于疾病的文章的模板可能包含诊断、病因、症状和治疗。研究人员的系统通过分析某个领域人类撰写文献的结构的模式来引入这些模板。 然后,它通过从互联网为该模板的每个部分选择内容来生成新文章。

这种关注结构的方法的主要特征有两个方面:

自动创建模板:模板可以从由人类撰写的文档中自动生成,因其内容来源于互联网上广泛而多样的语料资源,确保了该概述所涉及内容的广度。

内容选择的联合参数估计:模板中涉及的所有主题的参数都被同时学习,该过程优化了每个主题自身信息的相关性以及整篇文章的全局一致性。

研究人员通过在两个领域创建文章来评估该方法:演员及疾病。研究人员使用的数据库是维基百科,其所包含文章的篇幅及内容的广度与研究人员希望生成的文章近似。该数据库的优点之一是,维基百科的文章相近列出了主题章节,这可以辅助结构分析。他们的评估结果证实了关注结构的方法在内容选择方面优于其他未能根据主题结构建模的方法。

研究人员的算法创新是一种在整个模板中由特定主题提取器共同学习进行内容选择的方法。在标准分类框架下可以轻松实现学习单个特定主题提取器。然而,模板中不同主题的选择是相互依赖的; 例如,在多主题文章中,主题交叉的内容有可能出现重复。同时学习所有主题的内容选择,使研究人员能够清晰地建立这些主题间的联系。

研究人员将这个任务作为结构化分类问题来设计。他们使用增强了整数线性规划(ILP)公式的感知器算法来预估模型的参数,并在特定领域中的一组训练用范文中运行该算法。

摘要:

我们研究了一种方法,该方法可以创建某个主题的综合文本性概述(comprehensive textual overview),这个概述由提取自互联网的信息组成。我们使用了人类所创作文本的高级别结构,为新概述的主题架构自动引入一个特定领域模板。我们工作的算法创新是一种学习特定主题提取器的方法,用于整个模板的内容选择。我们使用全局整数线性规划公式(a global integer linear programming formulation)来增强标准感知器算法(standard perceptron algorithm),以优化信息在每个主题中的局部匹配以及整个概述中的全局协同。我们的评估结果证实了将结构信息纳入内容选择过程的好处。

文章来源:新智元

《MATLAB计算机视觉与深度学习实战》详细讲解了多个 MATLAB 计算机视觉与深度学习案例,提供源码及在线支持。几乎涵盖了数字图像处理中几乎所有的基本模块,并延伸到了深度学习的理论及其应用方面。点击下方二维码报名课程