为什么MobileNet及其变体如此之快?

点击上方“CVer”,选择"星标"和“置顶”

重磅干货,第一时间送达

本文经机器之心(almosthuman2014)

授权转载,禁止二次转载

作者:Yusuke Uchida 参与:Nurhachu Null、王淑婷

在本文中,作者对高效 CNN 模型(如 MobileNet 及其变体)中常用的组成模块进行了概述,并且解释了它们如此高效的原因。另外,作者还对如何在空间和通道中做卷积进行了直观阐述。

高效模型中使用的组成模块

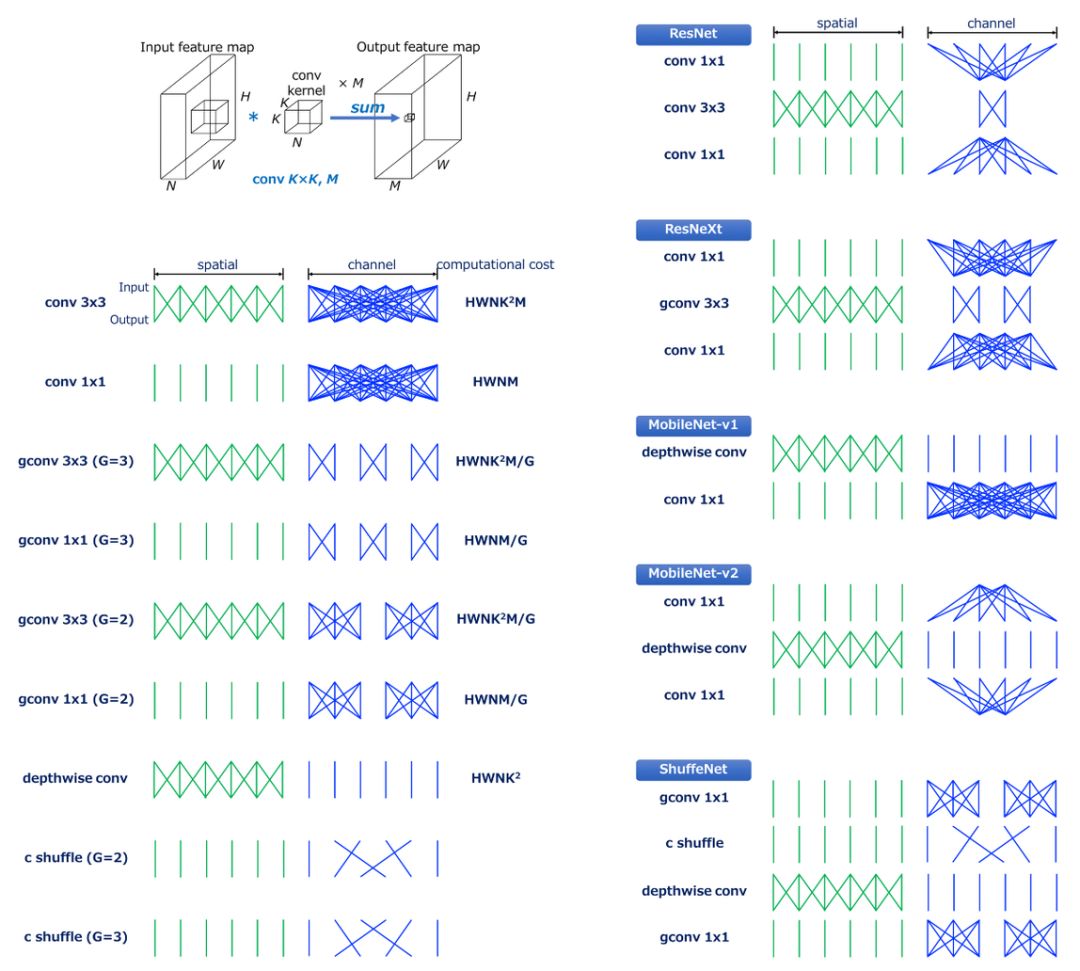

在解释特定的高效 CNN 模型之前,我们先检查一下高效 CNN 模型中组成模块的计算成本,然后看一下卷积是如何在空间和通道中执行的。

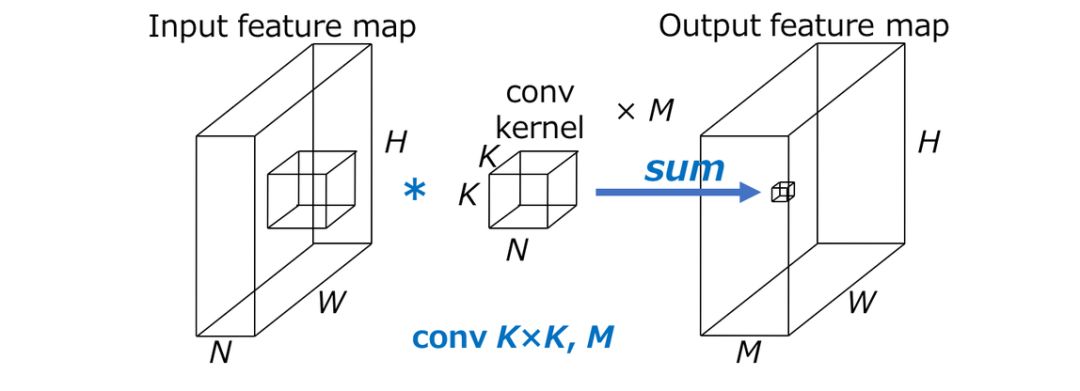

HxW 表示输出特征图的空间大小,N 代表输入通道数,KxK 代表卷积核的大小,M 代表输出通道数,那么,标准卷积的计算成本变成了 HWNK²M。

这里重要的一点就是,标准卷积的计算成本与以下因素成比例:(1)输出特征图的空间大小 HxW,(2)卷积核的大小 K²,(3)输入通道和输出通道的数量 NxM。

当在空间和通道上执行卷积时,上述计算成本是必需的。CNN 可以通过分解卷积来加速,如下所示。

卷积

首先,作者直观地解释了如何在空间和通道上执行标准卷积,其计算成本是 HWNK²M。

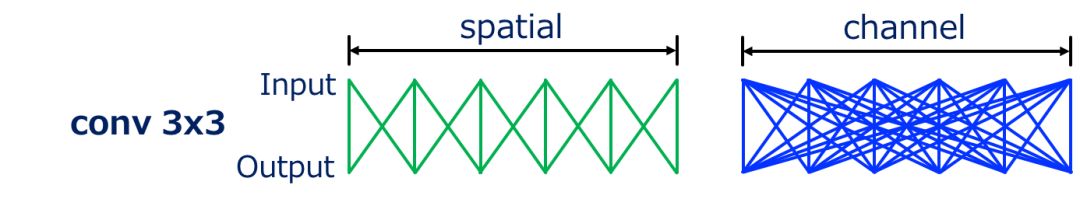

作者将输入和输出用线连接起来,以可视化它们之间的依赖关系。线条的数量分别粗略地表示在空间和通道上执行卷积的计算成本。

例如,最常用的 3x3 的卷积,可以通过上图进行可视化。我们可以看到,在空间中,输入和输出是局部连接的,而在通道中则是全连接。

下一个例子,conv1x1 或用于改变通道大小的逐点卷积,如上图所示。这种卷积的计算成本是 HWNM,因为其卷积核大小为 1x1,所以其计算成本是 3x3 卷积的 1/9。这种卷积被用来「融合」各个通道的信息。

分组卷积

分组卷积是卷积的一种变体,其中输入特征图的通道被分组,然后卷积在每组通道上独立进行。

G 代表分组数量,分组卷积的计算成本是 HWNK²M/G,与标准卷积相比,分组卷积的计算成本变成了 1/G。

G=2 的分组 conv3x3 的例子。我们可以看到,与标准卷积相比,分组卷积通道中的连接数更少,这意味着更小的计算成本。

G=3 的分组 conv3x3 的例子。连接变得更加稀疏了。

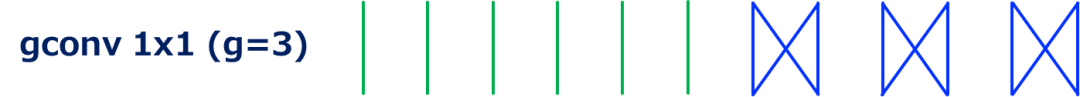

G=2 的分组 conv1x1 的例子。因此,conv1x1 也可以分组。这种卷积被用在 ShuffleNet 中。

G=3 的分组 conv1x1 的例子。

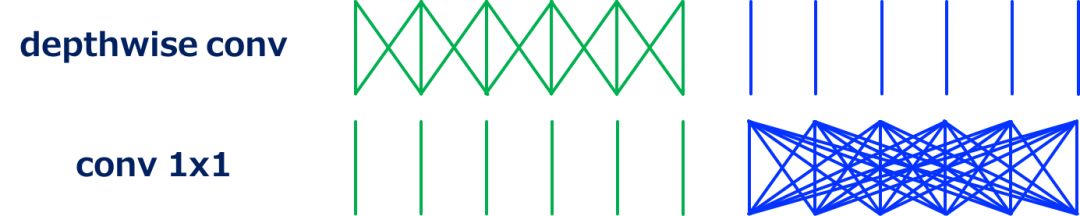

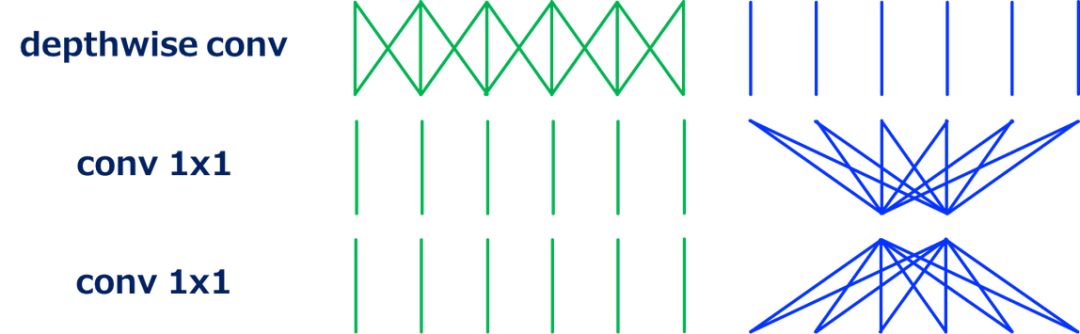

Depthwise 卷积

在 Depthwise 卷积 [2,3,4] 中,卷积是在每个输入通道上独立执行的。这也可以定义为分组卷积的特殊情况:输入和输出的通道数相同,G 等于通道数。

如上图所示,通过省略通道中的卷积,depthwise 卷积大大减少了计算成本。

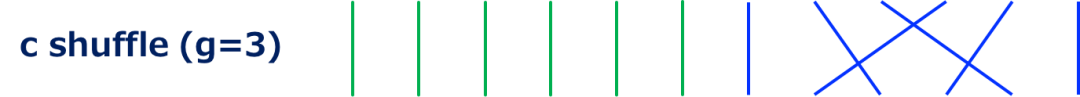

通道混洗(Channel shuffle)

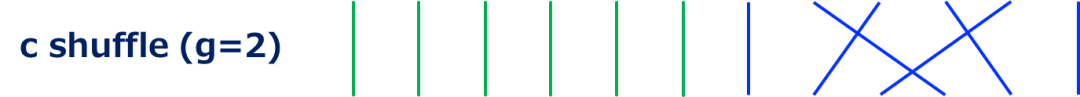

通道混洗是改变 ShuffleNet[5] 中所用通道顺序的操作(层)。这种操作是通过张量整形和转置来实现的。

更具体来说,比如 GN' (=N) 代表输入通道数,输入通道的维度首先被整形为 (G, N'),然后将 (G, N') 转置为 (N', G),最后将它拉平到与输入相同的形状。这里,G 代表的是分组卷积中分组的数目,分组卷积通常与 ShuffleNet 中的通道混洗一起使用。

虽然不能用乘-加运算次数(MACs)来定义通道混洗的计算成本,但是这些计算应该是需要一些开销的。

G=2 的通道混洗的例子。没有进行卷积,只改变了通道顺序。

G=3 的通道混洗的例子。

高效模型

下面,针对高效模型,作者给出了一些直观描述:为什么它们是高效的,以及空间和通道中的卷积是如何完成的。

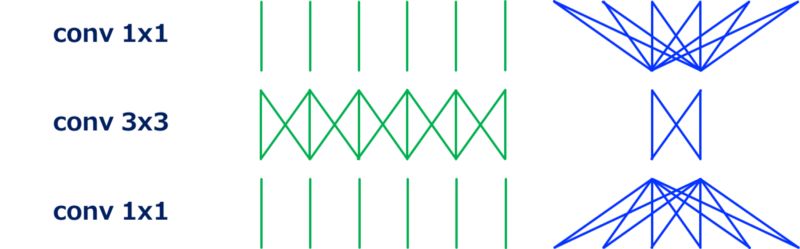

ResNet (Bottleneck 版本)

先说一下 ResNet [6] 中使用的具有瓶颈结构的残差单元。

如上所示,一个具有瓶颈结构的残差单元由 conv1x1、conv3x3 和 conv1x1 组成。第一个 conv1x1 减少输入通道的维度,这降低了后续 conv3x3 相对高昂的计算成本。最后的 con1x1 恢复输出通道的维度。

ResNeXt

ResNeXt[7] 是一种高效的 CNN 模型,可被视为 ResNet 的特例,其中分组 conv3x3 代替了 conv3x3。通过使用高效的分组卷积,与 ResNet 相比,conv1x1 中的通道减少率变得相对适中,这导致了在相同的计算成本下更好的准确率。

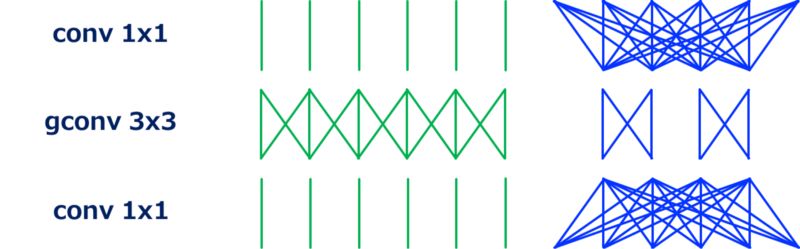

MobileNet (可分离卷积)

MobileNets[8] 是可分离卷积模块的堆叠,可分离卷积模块包含 depthwise 卷积和 conv1x1(逐点卷积,pointwise conv)。

可分离卷积在空间和通道中独立地执行卷积。这种卷积分解显著地降低了计算成本——从 HWNK²M 到 HWNK² (depthwise 卷积) + HWNM (逐点卷积),,总共是 HWN(K² + M)。通常,M>>K²(例如,K=3,而且 M ≥ 32),所以,计算成本大概减少到原来的 1/8—1/9 之间。

这里的重点是,计算成本的 bottleneck 现在是 conv1x1!

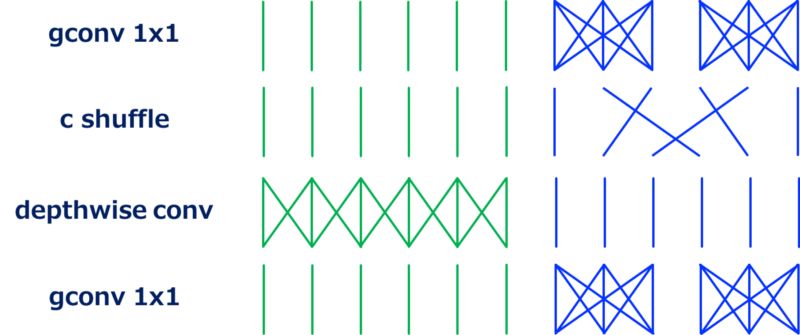

ShuffleNet

ShuffleNet 的出发点在于:conv1x1 是可分离卷积的瓶颈。尽管 conv1x1 已经很有效了,而且貌似已经没有可提升的空间了,但是分组 conv1x1 可以用来提升它!

上图描述了 ShuffleNet 的模块。这里的重要组成模块是通道混洗层,它「混洗」了分组卷积中的通道顺序。如果没有通道混洗,分组卷积的输出就无法在分组中利用,这会导致准确率的降低。

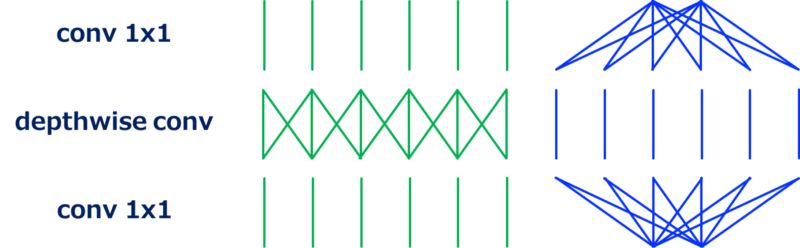

MobileNet-v2

MobileNet-v2[9] 使用的是与 ResNet 中具有瓶颈结构的残差单元相似的模块结构:改进版的残差单元,其中 conv3x3 被 depthwise 卷积代替了。

如上图所示,与标准的瓶颈结构相反,第一个 conv1x1 增加了通道维度,然后执行了 depthwise 卷积,最后一个 conv1x1 减少了通道维度。

如上图所示,通过对组成模块重新排序,并且与 MobileNet-v1 (可分离) 相比,我们可以看见这个结构是如何运作的(这个重新排序并不会改变总体的模型结构,因为 MobileNet-v2 是这个模块的堆叠)。

也就是说,上述模块可被视为可分离卷积的改进版,其中可分离卷积中单个的 conv1x1 被分解成两个 conv1x1。让 T 代表通道维度的扩展因子,两个 conv1x1 的计算成本是 2HWN²/,而可分离卷积中 conv1x1 的计算成本是 HWN²,在 [5] 中,使用了 T=6,将 conv1x1 的计算成本降低了 3 倍(通常是 T/2)。

FD-MobileNet

最后,作者将介绍一下快速下采样 MobileNet(FD-MobileNet)[10]。与 FD-MobileNet 相比,这个模型中的下采样在较浅层执行。这个简单的技巧可以减少总体的计算成本。原因在于传统的下采样策略和可分离卷积的计算成本。

从 VGGNet 开始,很多模型都采用了同样的下采样策略:执行下采样,然后将后续层的通道数翻倍。对于标准卷积而言,下采样之后的计算成本不会改变,因为它是由 HWNK²M 定义的。但是,对于可分离卷积而言,它的计算成本在下采样之后变得更小了:从 HWN(K² + M) 减少到了 H/2 W/2 2N(K² + 2M) = HWN(K²/2 + M)。当 M 不是很大(即更早的层)的时候,这是相对占优势。

最后,作者用下图结束本文。

原文链接:https://medium.com/@yu4u/why-mobilenet-and-its-variants-e-g-shufflenet-are-fast-1c7048b9618d

想要了解最新/最快/最好的论文速递、开源项目和干货资料,欢迎加入CVer学术交流知识星球。目前已有450+同学加入,涉及图像分类、目标检测、图像分割、人脸检测&识别、目标跟踪、GANs、学术竞赛交流、Re-ID、风格迁移、医学影像分析、姿态估计、OCR、SLAM、场景文字检测&识别和超分辨率等方向。

扫码进群

这么硬的总结,麻烦给我一个在看

▲长按关注我们

麻烦给我一个在看!