NLP面试宝典:38个最常见NLP问题答案一文get

新智元报道

新智元报道

来源:greatlearning

编辑:向学

【新智元导读】自然语言处理对社会的影响越来越广泛,但它又是人工智能中最难的子领域之一;因此现在很多公司都在四处寻找大量专业人才!为了帮助应聘者更加从容应对自然语言处理面试,我们特别推荐了面试中最常见的38个问题与答案。戳右边链接上 新智元小程序 了解更多!

自然语言处理(Natural Language Processing,NLP)是指帮助机器理解和分析自然语言;它是利用机器学习算法从数据中提取所需信息的一个自动化的过程。

自然语言处理虽然只是人工智能的一个子领域,但它对我们日常生活与学习的影响日渐深远。自然语言处理也是人工智能中难度最大的子领域之一,也正是这样的挑战给我们带来了更多机会;目前很多公司都在自然语言处理上发力,行业急需大量专业人才!

在申请与自然语言处理相关的工作职位时,应聘者往往不清楚面试官可能会问什么样的问题。应聘者除了学习NLP的基础知识外,专门为面试做准备也是很重要的。以下是NLP面试中常见的问题和答案的列表,并对其作了解释,希望能对应聘者成功拿到好的offer起到帮助。

1.下列哪些技术能被用于关键词归一化(keyword normalization),即把关键词转化为其基本形式?

A. 词形还原(Lemmatization)

B. 探测法(Soundex)

C. 余弦相似度(Cosine Similarity)

D. N-grams

答案:A

词形还原有助于得到一个词的基本形式,例如:playing -> play, eating -> eat等;其他选项的技术都有其他使用目的。

2.下列哪些技术能被用于计算两个词向量之间的距离?

A. 词形还原(Lemmatization)

B. 欧氏距离(Euclidean Distance)

C. 余弦相似度(Cosine Similarity)

D. N-grams

答案:B与C

两个词向量之间的距离可以用余弦相似度和欧氏距离来计算。余弦相似度在两个词的向量之间建立一个余弦角,两个词向量之间的余弦角接近表示词相似,反之亦然。例如,与“Football”、“NewDelhi”这2个词相比,“Football”、“Cricket” 这两个词之间的余弦角将更接近于1。通常,文档相似度是通过文档中的内容(或单词)在语义上的接近程度来衡量的;当它们接近时,相似度指数接近于1,否则接近于0。两点之间的欧氏距离是连接这两点的最短路径的长度。通常用毕达哥拉斯定理计算三角形。

3.文本语料库的可能特征是什么?

A. 文本中词计数

B. 词的向量标注

C. 词性标注(Part of Speech Tag)

D. 基本依存语法

E. 以上所有

答案:E

以上所有这些都可以作为文本语料库的特征。

4.你在20K文档的输入数据上为机器学习模型创建了文档-词矩阵(document-term matrix)。以下哪项可用于减少数据维度?

(1)关键词归一化(Keyword Normalization)

(2)潜在语义索引(Latent Semantic Indexing)

(3)隐狄利克雷分布(Latent Dirichlet Allocation)

A. 只有(1)

B. (2)、(3)

C. (1)、(3)

D. (1)、(2)、(3)

答案:D

5.哪些文本分析技术可被用于名词短语检测、动词短语检测、主语检测和宾语检测?

A. 词性标注(Part of Speech Tagging)

B. Skip Gram 和N-Gram 提取

C. 连续性词袋(Bag of Words)

D. 依存句法分析(Dependency Parsing)和成分句法分析(Constituency Parsing)

答案:D

6.用余弦相似度表示的词之间的差异将显著高于0.5

A. 正确

B. 错误

答案:A

7.下列哪项是关键词归一化技术?

A. 词干提取(Stemming)

B. 词性标注(Part of Speech)

C. 命名实体识别(Named Entity Recognition)

D. 词形还原(Lemmatization)

答案:A与 D

词性标注(POS)与命名实体识别(NER)不是关键词归一化技术。

8.下面哪个是NLP用例?

-

从图像中检测物体 -

面部识别 -

语音生物识别 -

文本摘要

答案:D

A和B是计算机视觉应用案例,C是语音应用案例。

B. T * Log(3) / K

C. K * Log(3) / T

D. Log(3) / KT

答案:C

b. 词形还原(Lemmatization)

C. 停用词(Stop Words)

C. SpaCy

D. BERT

答案:D

除了BERT是一个词嵌入方法以外,其它 都是NLP库。

B. 词形还原(Lemmatization)

C. 停用词消除(Stop Word Removal)

D. 命名实体识别(Named Entity Recognition)

答案:D

-

正确 -

错误

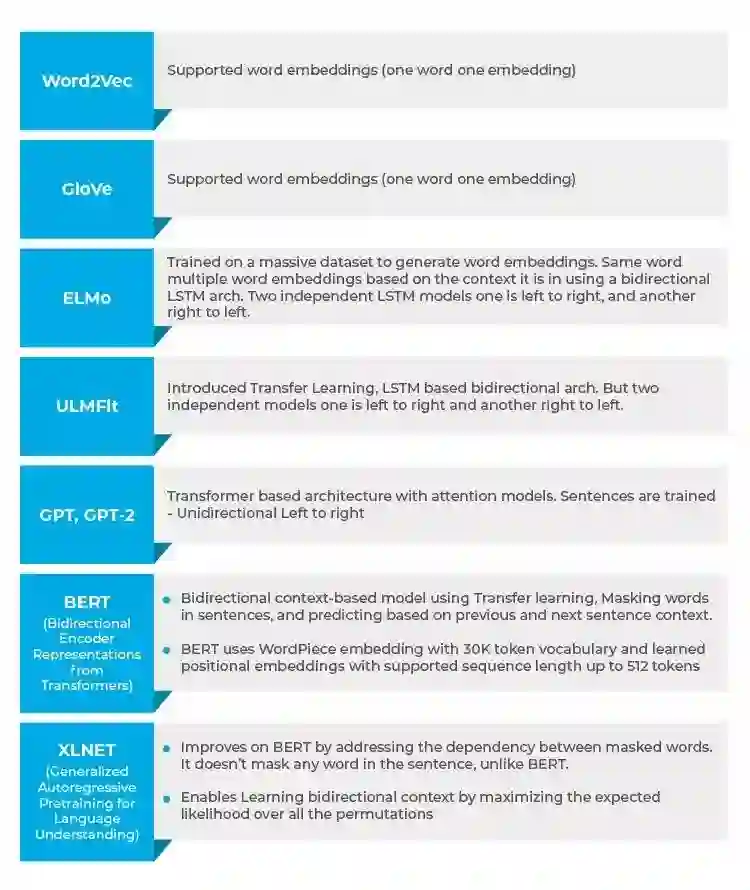

只有BERT(Bidirectional Encoder Representations from Transformer)支持上下文建模。

-

Word2Vec -

BERT -

GloVe -

以上所有

只有BERT支持双向上下文。Word2Vec和GloVe是词嵌入,它们不提供任何上下文。

D. 以上所有

-

正确 -

错误

-

正确 -

错误

-

新德里之于印度,北京之于中国 -

男人之于电脑,女人之于家庭主妇

B. Open AI’s GPT

C. ULMFit

答案:B

B. BERT

C. Open AI’s GPT

D. ULMFit

答案:C

-

GloVe -

Word2Vec -

ELMo -

Nltk

30. 对于一个给定的token,其输入表示为它的token嵌入、段嵌入(Segment Embedding)、位置嵌入(Position Embedding)的总和

B. GPT

C. BERT

D. ULMFit

答案:C

BERT使用token嵌入、段嵌入(Segment Embedding)、位置嵌入(Position Embedding)。

B. BERT

C. ULMFit

D. ELMo

答案:D

-

BERT -

GPT -

ELMo -

Word2Vec

B. ELMo

C. BERT

D. ULMFit

答案:C

B. XLNET

C. GPT-2

D. ELMo

答案:B. XLNET

XLNET在所有模型中都给出了最好的准确性。它在20个任务上都优于BERT,在情感分析、问答、自然语言推理等18个任务上都取得了顶尖的结果。

B. EMMo

C. GPT

D. XLNET

答案:D

XLNET提供了基于排列的语言模型,这是与BERT的一个关键区别。