语言偏见不是唯一的捷径:视觉问答的捷径学习数据集

论文标题:

Language Prior Is Not the Only Shortcut: A Benchmark for Shortcut Learning in VQA

Findings of EMNLP 2022

https://arxiv.org/abs/2210.04692

https://github.com/PhoebusSi/VQA-VS

https://phoebussi.github.io/VQA-VS-homepage/

为了更好地评测 VQA 模型克服语言偏见(debiasing)的能力,VQA-CP v2 [4] 重新组织了 VQA v2 数据集使得同一问题词下的答案分布在训练集和测试集中是完全相反的,即符合分布外(Out-of-distribution, OOD)设定。如此一来,在训练集中学到的虚假关联和捷径将在测试集中失效,在 VQA v2 上表现不错的模型在 VQA-CP v2 上的性能大幅度下降。

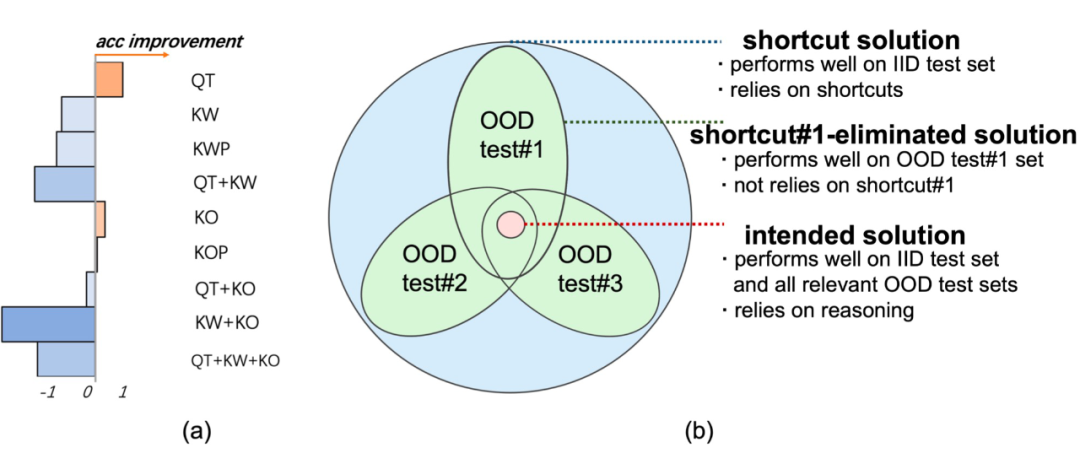

1. VQA-CP v2 仅引入了一种特定的分布变换(distribution shift)来构造 OOD 测试集,因此仅能评估 VQA 模型克服该分布变换对应的捷径的能力,依然无法评估真实的鲁棒 VQA 能力(intended solution)。如图 1(a)所示,在 VQA-CP v2 上表现卓越的 LMH [5] 仅能在我们提出的 VQA-VS 少数 OOD 测试集上提高其 backbone 的性能,而在其他 OOD 测试集上性能却明显下降。

这说明 VQA-CP v2 无法识别模型是否依赖于其他捷径(如,视觉对象和答案之间的虚假关联),易被这类 dataset-specific 方法欺骗。因此,如图 1(b)所示,一个模型只有在更多的不同类型 OOD 测试集上同时提升性能,才更有把握认定该模型学到了鲁棒的 VQA 能力。我们在文中 2.1 节从因果(Causal)角度详细解释了这个动机。

2. Damien Teney [6] 收录在 NeurIPS 2020 的论文曾指出当前的 OOD 评测基准中存在着三个令人不安的操作(troubling issues),即:

issue 1:在 VQA-CP v2 中,训练集和测试集在同一问题词下的答案分布是完全相反。这一特点容易被当前的 debiasing 方法利用。比如,当训练集中的高频答案是 “no” 时直接回答 “yes” 即可得到不错的精度。这种 dataset-specifc 方法在现实场景中几乎没有任何用处;

issue 2:由于 VQA-CP v2 验证集的缺失,几乎现有所有的 debiasing 方法都直接用测试集来选择模型 checkpoint。这不符合机器学习的最佳实践;

issue 3:现有工作通常需要在 VQA v2 上单独重训一个模型来评测 IID 性能,然后和 VQA-CP v2 上训练和评测出的 OOD 表现进行对比。这种为每种分布场景单独地训练一个模型不符合现实场景,并且使得 IID 和 OOD 的性能对比不具有参考价值。

值得一提的是,Damien Teney 是 VQA 任务的先驱研究者,曾获得 the 2017 VQA Challenge 的第一名,并提出 VQA 最广泛使用的 backbone 模型 UpDn [7]。在 Damien Teney 指出这些 issues 的前后几年间,已经有数十篇论文在 VQA-CP 上研究 VQA 的 debiasing 方法,并得以在顶级期刊或会议中发表。在 VQA-CP 上的 SOTA 不断被声明又不断被打败,一遍又一遍,却无人关注该评测基准是否健康。

考虑了不同捷径的VQA评测基准VQA-VS

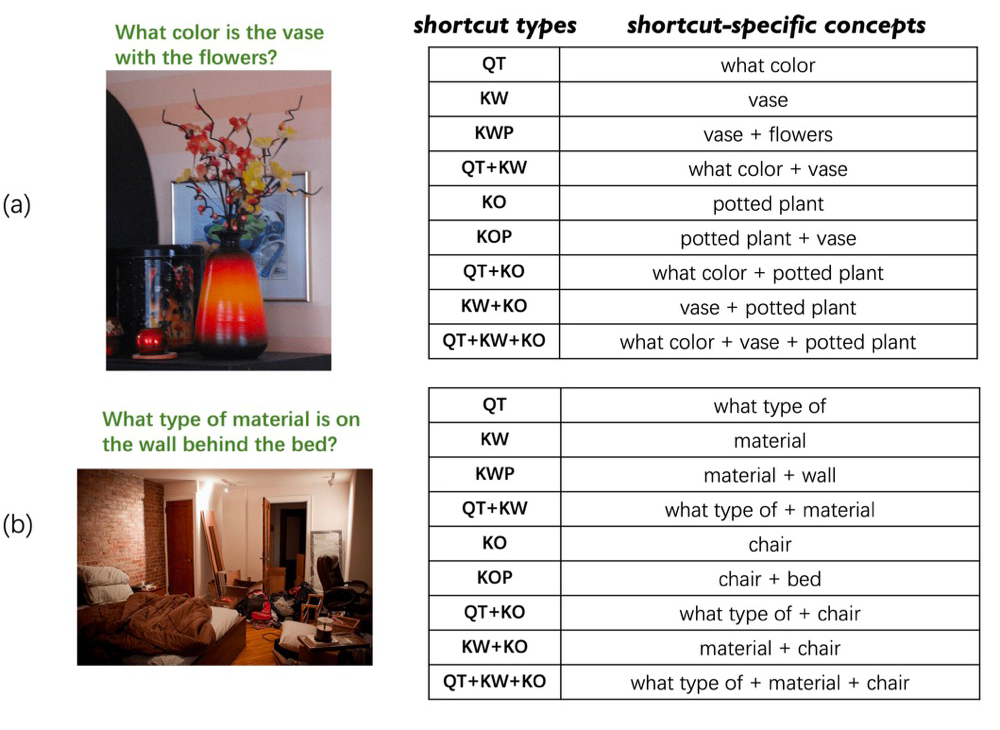

为了解决上述的两点限制,我们考虑了不同的捷径(Varying Shortcuts),构造并发布了一个新的 VQA 基准 VQA-VS,并且进一步规范了 OOD 评测流程。具体地,我们选择了包含基于语言的、基于视觉的和基于多模态的九种捷径来尽可能地包含不同类型的虚假关联。

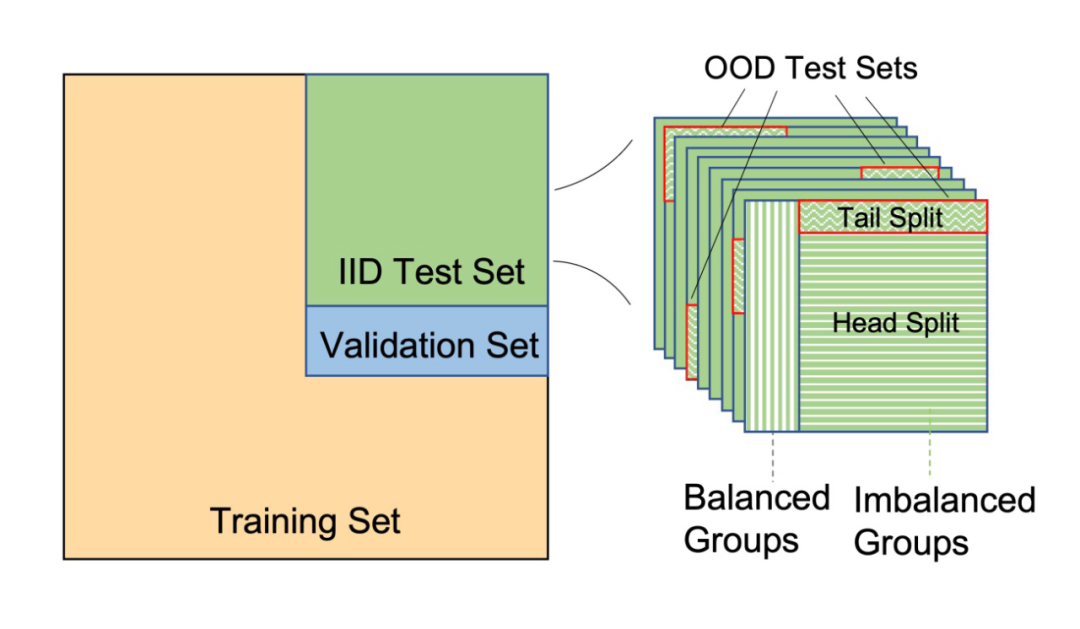

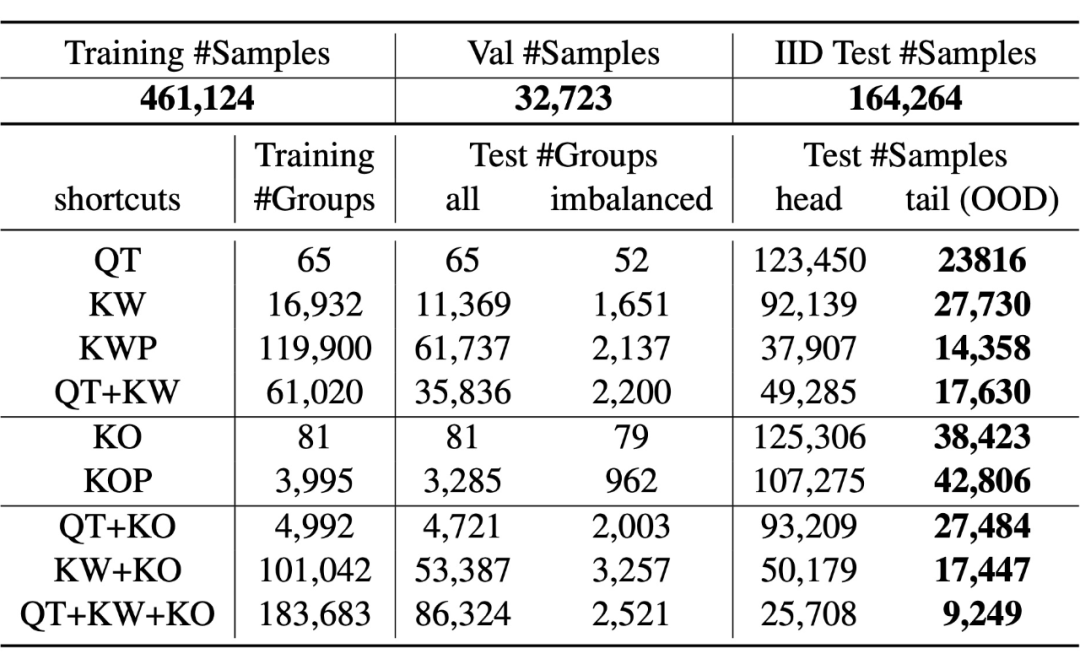

2.1 合并和切分数据

图 2 展示了 VQA-VS 的数据划分。我们首先将 VQA v2 的训练集和验证集合并在一起,然后随机采样出其中的 70% 和 5% 的数据分别作为 VQA-VS 的训练集和验证集,剩下的 25% 数据作为 IID 测试集。随机采样的操作可以保证验证集和 IID 测试集遵循了和训练集相同的分布。

2.2 捷径的选择

-

关于基于语言模态的 QT 捷径,答案 “black” 在训练集中总能正确回答问题词为 “what color” 的问题;关于 KW 捷径,关键词 “grass” 和答案 “green” 总是高频共现; -

关于基于视觉模态的 KO 捷径,图片中的 “grass” 区域和答案 “green” 也有着频繁的共现; -

而关于基于跨模态的 QT+KO 捷径,当问题词为 “what sport” 和图像中的 “rocket” 共同出现时,答案 “tennis” 总是正确的。

关于每种捷径更多的例子和解释可以参考文中 3.2 节。

QT:直接使用原始 VQA 数据集中的问题词前缀作为 QT 特定概念。

-

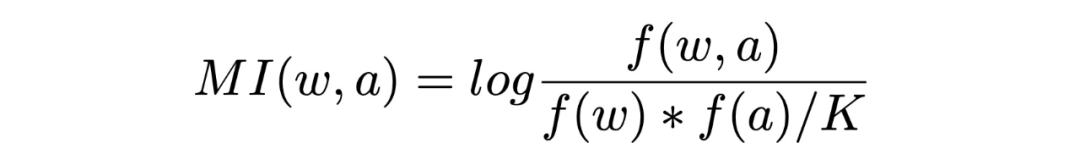

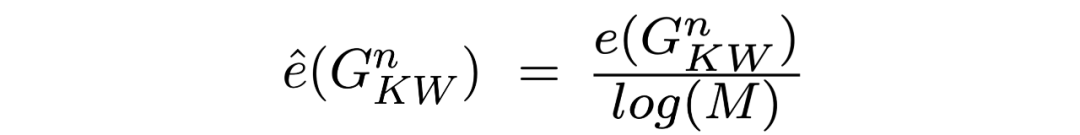

KW:给定一个 VQA 样本( ),我们通过以下公式测量答案 和问题 中每一个词 的(问题词除外)相互依赖程度:

-

KWP:我们选择互信息最高的两个词作为 KWP 特定概念。 -

QT+KW:我们将 QT 和 KW 概念按顺序组合在一起,以获得给定样本的 QT+KW 特点概念。 -

KO/KOP/QT+KO:这些概念的确定方式和 KW/KWP/QT+KW 类似,不再赘述。 KW+KO/QT+KW+KO:通过组合一个样本相应的(QT、)KW 和 KO 概念,可获得其(QT+)KW+KO 特定概念。

2.4 OOD测试集的构建

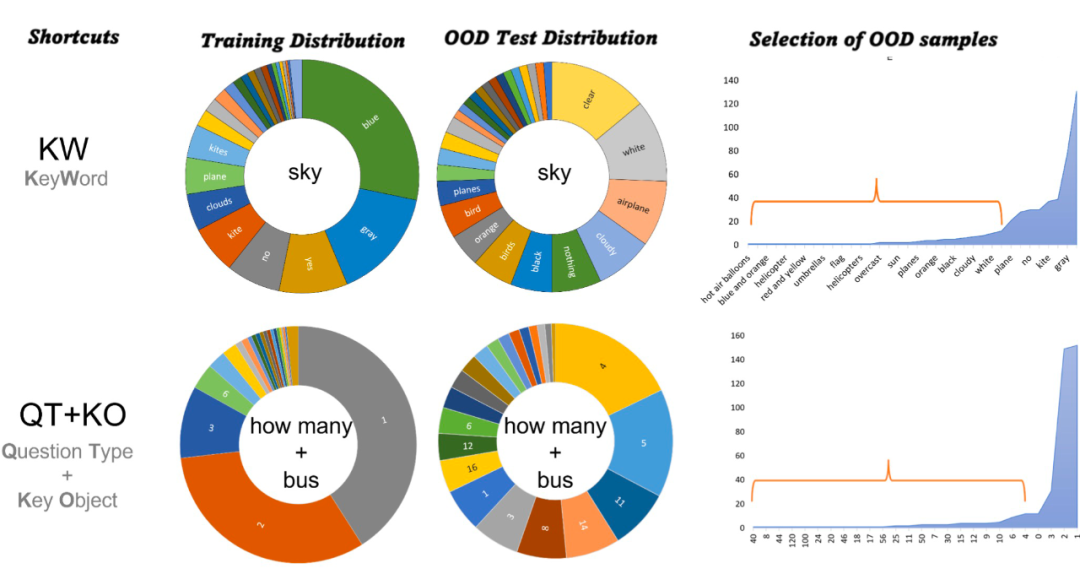

Kervadec 等人 [8] 等人通过实验验证了稀有的(rare)VQA 样本是 OOD 样本,它们更适合评估 VQA 模型的鲁棒性。遵循他们,对于每种捷径,我们首先根据捷径特定概念将所有样本分组,然后从最不平衡的组中选出尾部样本作为 OOD 样本,最后合并所有选出来的 OOD 样本构成该捷径对应的 OOD 测试集。具体来说,共分为以下三步:

-

对样本进行分组。如图 2 所示,我们首先将 IID 测试集复制 9 份,每一份对应一种捷径,然后我们将每份中所有的 IID 样本根据该捷径特定的概念分组。

-

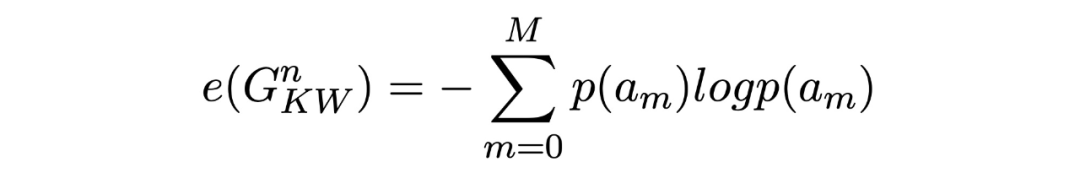

测量分组不平衡程度。当一个分组答案分布的熵越低,该分组越不平衡。首先,以 KW 捷径中第 n 个分组为例,我们按照以下公式计算其熵:

其中, 表示答案为 的样本在该分组中所占的比例。 表示答案类别的数量。由于熵高度依赖于答案类别的数量,我们将其归一化: 归一化后的熵表示该分组的答案分布和同维度的均匀分布( )有多接近。我们将归一化熵小于 0.9 的分组视为不平衡组。 -

每一个不平衡的分组都呈长尾分布,我们将样本数少于所有答案类别平均样本数的 1.2 倍的答案类别视为稀有的,即这些答案类别下的所有样本为尾部样本。最后我们将所有不平衡分组中的尾部样本合并在一起得到该捷径对应的 OOD 测试集。最终,我们可以得到 9 个 OOD 测试集。

数据集分析

3.2 答案分布的可视化

▲ 图4(左):训练集和OOD测试集的答案分布的对比;(右):不同分组下不同的OOD答案比例

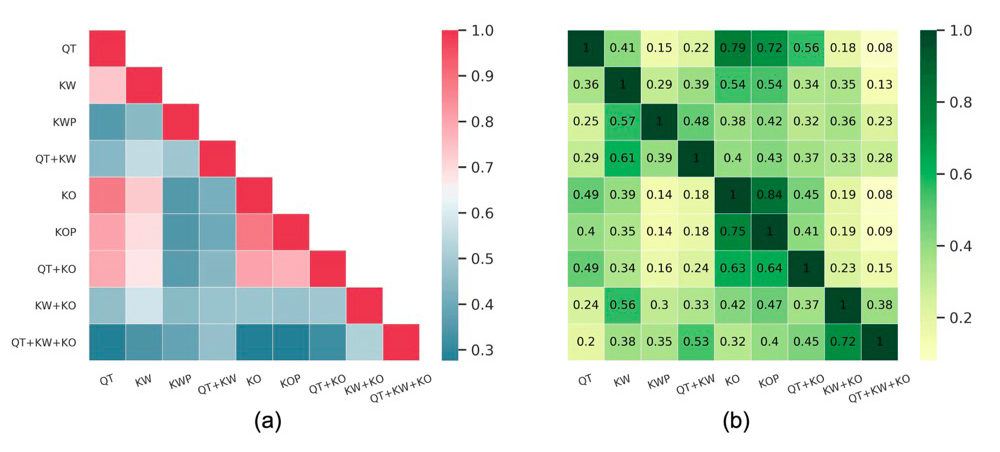

3.3 捷径的相关性

3.4 OOD测试集之间重叠

实验和分析

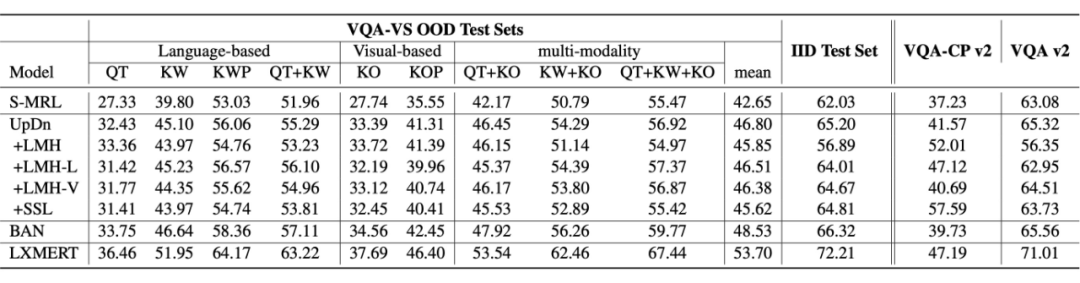

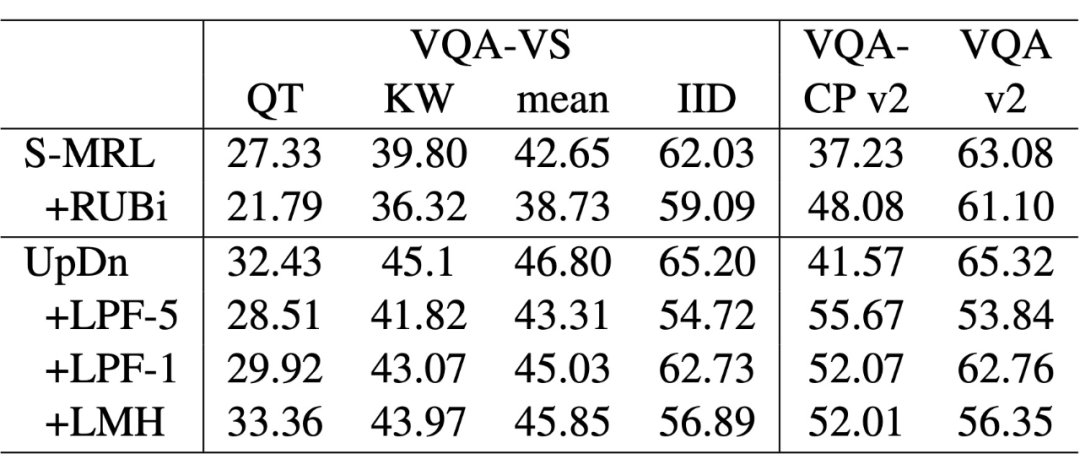

▲ 表2 VQA-VS和VQA-CP v2的对比

4.1 VQA-VS和VQA-CP v2的对比

这表明我们的 OOD 场景设置比 VQA-CP v2 更困难。特别地,LMH 和 SSL 在 VQA-CP v2 上能明显提升其主干模型 UpDn 的性能,但它们在 VQA-VS 的 OOD 测试集上却不起作用。这是因为它们严重依赖于对 VQA-CP v2 构造特点的利用(issue 1),而不是真正提高了模型的泛化能力和鲁棒性。

4.2 VQA-VS上的模型表现

从表 2 中可以看出,所有模型在 IID 测试集上的精度均优于所有 OOD 测试集,且有较大的性能差异(6.46∼31.82)。这表明九种捷径都被模型从训练集中学到,说明语言优先不是唯一的捷径。此外,经典 debiasing 方法 LMH 及其变体均不能同时推广到所有 OOD 测试集。这说明基于集成的方法是脆弱的,依赖于对偏见特征的精心设计,是捷径特定的方案。

现有的 debiasing 方法会在克服语言偏见和正确回答问题之间进行权衡,即通过牺牲 IID 性能来提高 OOD 性能(表 2 和表 3 的右侧部分)。这是因为它们是为使用已知的 OOD 构造特点(issue 1)而精心设计的,这会损害跨模态表示。

最近的研究人员受到 VQA-CP v2 的鼓励,朝着这样的方向研究,这与真正的模型鲁棒性背道而驰。在 VQA-VS 上,正如预期的那样,跨模态预训练模型 LXMERT 以令人印象深刻的优势优于其他基础模型,因为它经过在大规模跨模态数据中的预训练,可以将文本和图像编码成更好的表示。

而在 VQA-CP v2 上却是相反的现象,即基于小模型 UpDn 的一系列 debiaisng 方法可以以绝对优势击败跨模态预训练模型。这是因为模型对 issue 1 的利用在 VQA-CP v2 上带来的收益要远大于更鲁棒的跨模态表示带来的收益。这一现象使得预训练模型在 VQA-CP v2 上毫无优势,也使得 VQA-CP v2 上的 SOTA 相较于被预训练模型霸榜的数据集更容易被刷新。然而,遗憾的是,VQA-CP v2 并不能验证模型的真实的鲁棒能力。

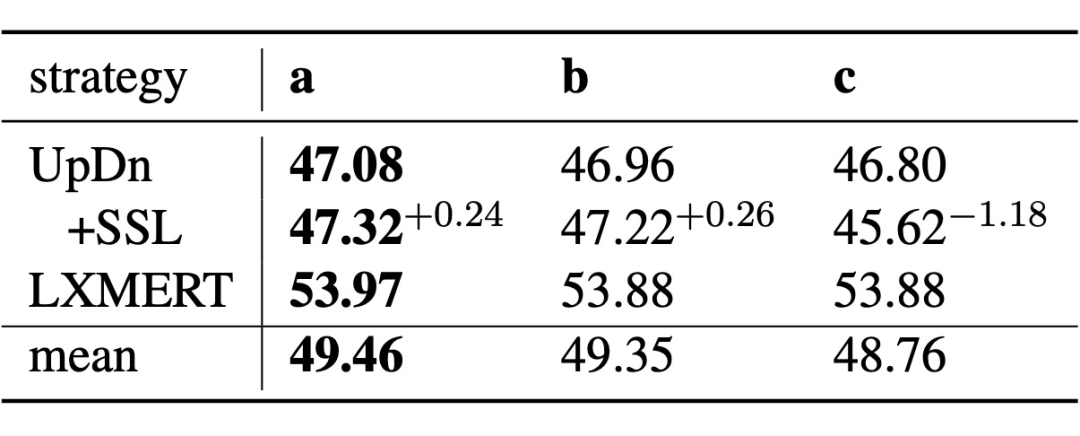

▲ 表3 当前 SOTA debiasing 方法的表现

▲ 表3 当前 SOTA debiasing 方法的表现

4.4 阻止模型学习频繁的样本可能会损害模型泛化能力

为了进一步分析,我们评估了两个具有不同 Gamma 的 LPF 模型,即 LPF-1 和 LPF-5。Gamma 是一个超参数,用于控制多大程度上阻止频繁样本的学习(请参阅它们在 VQA-CP v2 和 VQA v2 上的性能)。在 VQAVS 上,阻止程度更大的 LPF-5 的 IID 性能和 OOD 性能均严重落后于 LPF-1。这说明,阻止模型学习频繁的样本的去偏思路只是 fit 于 issue 1 的数据集特定方案。

4.5 模型选择策略的影响

相比之下,IID 验证集选择的模型表现相对较差。特别地,只有使用 OOD 测试集或 OOD 验证集进行模型选择,SSL 才能在 OOD 测试集上超越其主干模型 UpDn。这表明 SSL 并不鲁棒,并且证实了 SSL 对性能的提升来自于自适应过拟合。

总结

视觉问答(VQA)模型倾向于学习由数据集偏差形成的捷径解决方案,而不是预期解决方案。为了评估 VQA 模型在捷径学习之外的泛化能力,VQA-CP v2 数据集在给定问题类型的训练集和测试集之间引入了答案分布变换(distribution shift)。这样,模型无法使用训练集中的捷径在测试集上表现良好。

然而,VQA-CP v2 只考虑一种类型的捷径(从问题类型到答案),因此仍然不能保证模型依赖于预期方案,而不是特定于此捷径的解决方案。为了克服这一限制,我们提出了一个新的数据集,通过在多个 OOD 测试集中构造不同的 distribution shift 来考虑不同类型的捷径。

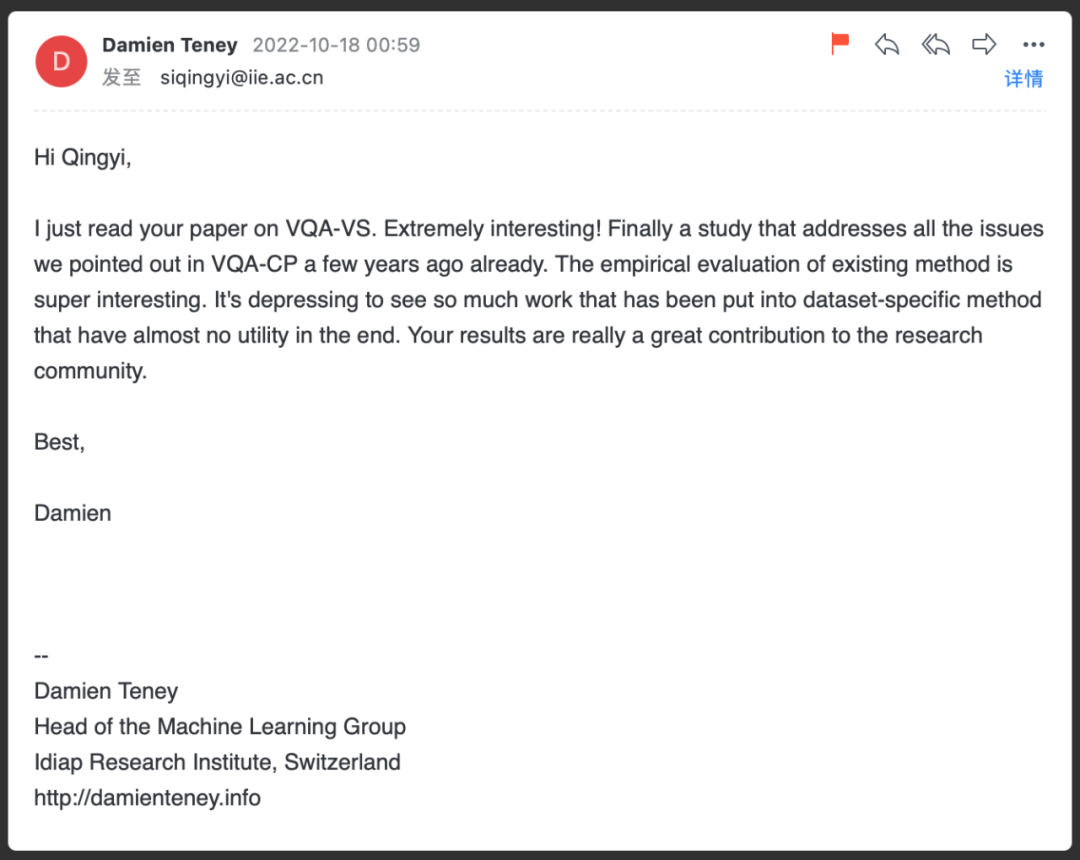

同行评价

▲ 图6 Damien Teney的来信

该论文放在 arxiv 后一周左右,笔者收到了 Damien Teney 的来信,如图 6 所示,Damien Teney 肯定了我们的贡献,并认为我们很好地解决了他在 [6] 中指出的这些问题。同时,如图 7 所示,他在 Twitter 上对我们的工作进行了转发,并对这个社区范围内的自适应过拟合现象(community-wide adaptive overfitting)为研究者们总结了几点建议。

▲ 图7 Damien Teney在Twitter上对我们工作的转发和讨论

相关赛事

参考文献

更多阅读

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧