韩国研发AI武器遭抵制事件落幕:AI杀人机器,是你无法正视的恐怖存在!

综合整理 | 黑智

韩国大学研发AI武器,遭受多国专家抵制的事儿,终于有了结果。

几天前,据路透社报道,韩国科学技术院(KAIST)正在研发人工智能武器。这家学院和韩国十大财团之一的韩华集团旗下韩华系统公司合作,开设了人工智能研发中心,研发适用于作战指挥、目标追踪和无人水下交通等领域的人工智能技术,希望在今年年底前研发出基于人工智能的导弹、潜艇和四轴飞行器。

这事让包括澳大利亚、美国、日本等30多个国家和地区的研究人员坐立难安,心生担忧。4月4日,已有50多名世界知名的AI和机器人研究人员宣布,将联合抵制韩国科学技术院。他们在4日签署的公开信中,敦促韩国科学技术院停止对AI武器的研发,并且表示,如果该大学不承诺停止研发,将与之断绝关系,而且将拒绝访问韩国科学技术院、接待对方访客或与对方合作研究项目,直至这所韩国顶尖大学承诺放弃研发缺少“有效人工控制”的武器。

公开信的发起人、澳大利亚新南威尔士大学人工智能教授托比·沃尔什在路透社的采访中表示,人工智能技术和机器人固然能够在军事领域发挥强大的作用,但是,“我们不能将决定生死的权力交给机器,这就越过道德底线。”

公开信中也担忧,一旦机器人武器开发竞争加速,未来的战争规模将达到“前所未有”的地步。而且,这种人工智能技术,一旦被恐怖分子利用,后果不堪设想。

后来,这事儿还惊动了联合国。

4月9日,联合国《特定常规武器公约》政府专家小组在瑞士日内瓦召开会议,预定讨论致命自主武器系统研发,也就是常说的“杀手机器人”可能带来的影响。

日前,KAIST的院长Sung-chul Shin终于对此做出了回应。他给每位抗议专家写信,表示:“我需要重申 KAIST 无意参与致命性自主武器系统‘机器人杀手’的研发。作为一个学术机构,我们高度重视人权和伦理标准。我重申 ,KAIST 没有进行任何有违人类尊严的研究,包括研发缺少有效控制的自主武器。”

KAIST表示,得到了保证后,参与抵制的研究人员们,已经同意撤回和其断绝关系的计划,将恢复对其的访问和合作。

托比·沃尔什似乎还有些不够满意,他在采访中表示“仍然对他们研发这些打算做什么有一些疑问”,但总体来说,他也承认,KAIST也算做出了“适当的回应”。

基于人工智能技术的自动武器,为什么会让联合国都为之动容?

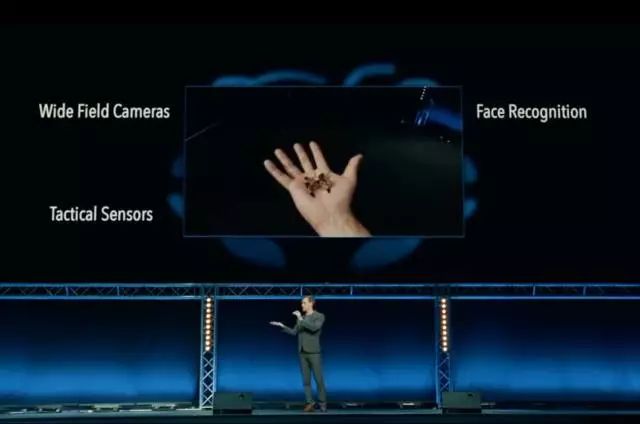

让我们来回顾下去年11月,在日内瓦举办的联合国特定常规武器公约会议上,展示的一段视频:一群神似《黑镜 III》中机器杀人蜂的小型机器人,通过人脸定位,瞬间便杀死了正在上课的一众学生。

这个体型娇小的机器人中,包含了大量的黑科技:传感器、摄像头,可进行人脸识别,可以基于AI技术躲避狙击,更可怕的是,在它的中部,还有3克炸药,完全可以做到一击致命。

在视频结尾,伯克利大学教授Stuart Russell提醒所有人,这种杀人机器人并非真实,但是其中的科技手段都已经在现实中存在。而可以想象,一旦这些技术被恐怖分子所掌握,可以造成何等可怕的后果。

因此,专家和研发人员们,才一力要避免视频中的悲剧在未来发生。

会后,超过200名来自学界和业界的加拿大科学家和100名澳大利亚科学家联名写了公开信给本国总理,呼吁通过限制相关研究。

《黑镜》只是一部科幻作品,但基于AI技术的攻击性武器,却并非虚幻。

2018年初,据外媒报道,Google正与美国国防部合作,开发无人家软件。应用了Google的机器学习技术后,军方的无人机识别效果也将更为精准。

根据美国国防部发布的报道表示,这个名为“Maven”de 项目,旨在帮助处理军方收集的“数百万个小时的无人机拍摄视频”,可以为其提供精准识别个人的能力。

在韩国科学技术院的研发受到抵制的同时,一封公开信已在Google内部流传。超过3100名Google员工在上面签名,要求公司退出五角大楼的军事计划,并同意“永不开发战争技术”。

因此,你可以理解,当韩国科学技术院将AI武器研发提上日程时,为何会引发如此大的反应。

尤其是,和其合作的韩华集团,曾是韩国最大的武器生产商之一。它所生产的集束炸弹,根据《集束弹药》公约,被120个签署国禁止使用。

在各个领域内,AI应用都将发挥巨大的作用。但是,将其用于“杀人”,却违背了一切研发它的科研人员的初衷。

而另外,还有一个存在的担忧是,AI的内心,也仍然由我们所不理解的“黑暗”的一面,那就是人工智能尤其是深度学习和神经网络的“黑箱”——你能解释清楚一个AI系统是如何得出结论的码?

深度学习在近年来,已经被证明是非常强大的解决问题的方式,并已经被广泛应用,比如在图像识别、语音识别和语言翻译中。但是,人类首先需要能找到方法,证明深度学习技术能够更理解它们创造者的意图,以及向用户负责。

美国军方正投入数十亿美元,使用机器学习来引导车辆和飞机识别目标,并帮助分析人员筛选出大量的情报数据。不同于其他领域,甚至是医学领域,国防部已经将证明机器学习的“可解释性”看做一个关键的“绊脚石”。

David Gunning,美国国防高级研究计划局的项目负责人,负责一项名为Explainable Artificial Intelligence program的人工智能“可解释性”项目。这位满头银发的老兵,曾监督DARPA项目,最终导致Siri的成立。情报分析人员正在测试机器学习,作为识别大量监控数据模式的一种方法;许多自主地面车辆和飞机正在开发和测试。但如果一个机器坦克不能解释自己的行为,士兵可能感到不舒服,分析师也将不愿意对没有理由的命令采取行动。Gunning说:“这些机器学习系统的本质往往是产生大量的假警报,所以分析师真的需要额外的帮助来理解它为什么要做一个推荐。”

所以,一向支持“AI威胁论”的马斯克又在近期秀了一把存在感。美国电影导演克里斯·潘恩(Chris Paine)制作了一部纪录片中,调查了一些人工智能的应用实例,包括自动武器、华尔街的技术算法等。马斯克则警告说,人工智能“不需要作恶,就可能摧毁人类。”

这次韩国大学研发AI武器的风波似乎已经过去。令人欣慰的是,我们也看到了,全球AI研发人员的道德界线。但是,对于AI“杀人武器”的担忧和讨论,却仍将继续。

无论“作恶”的是AI本身,还是人类,我们是否能够一直将之处于控制之中呢?