周志华、Hinton等50多名学者联名抵制韩国研发“杀人机器人”

精彩回顾

2018 新智元产业跃迁 AI 技术峰会圆满结束,点击链接回顾大会盛况:

爱奇艺 http://www.iqiyi.com/l_19rr3aqz3z.html

腾讯新闻 http://v.qq.com/live/p/topic/49737/preview.html

新浪科技 http://video.sina.com.cn/l/p/1722511.html

云栖社区 https://yq.aliyun.com/webinar/play/419

斗鱼直播 https://www.douyu.com/432849

天池直播间 http://t.cn/RnQPhuY

IT 大咖说 http://www.itdks.com/eventlist/detail/1992

新智元原创

作者:克雷格、肖琴

【新智元导读】最近,韩国科学技术院因为与军工企业“韩华 Systems”合作研发自主武器,遭到来自全球20多个国家的50多名AI学者联名抵制,其中包括Yoshua Bengio、Geoffrey Hinton以及南大计算机系教授周志华。研发自主武器将会加速AI军备竞赛,像这样的技术可能导致更大规模的战争加速到来。科学不应该成为战争的帮凶和附庸工具,向这些学者们致敬!

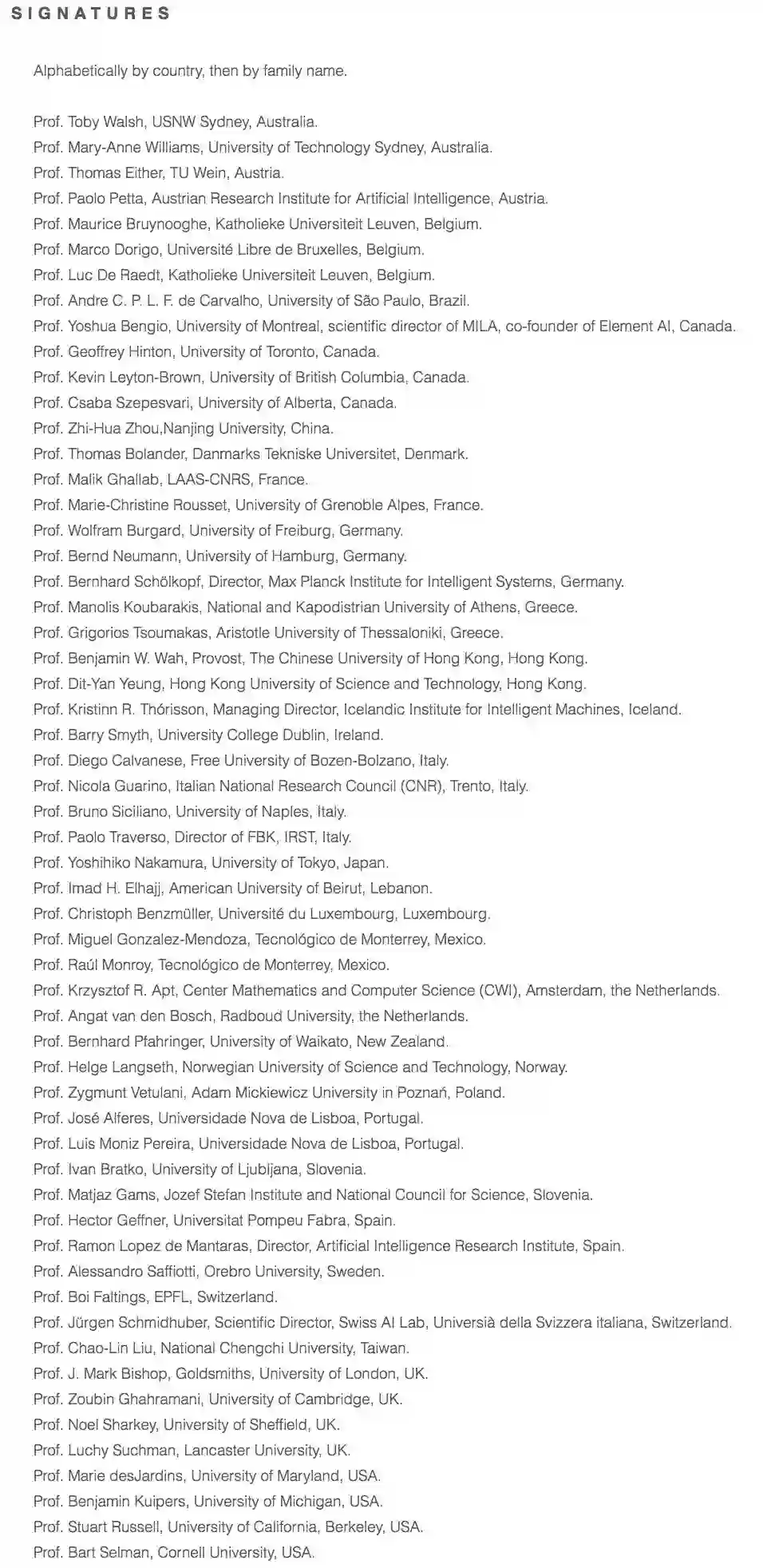

最近,韩国科学技术院大学(KAIST)遭到了全球20多个国家、50多名高校顶尖AI学者的集体抵制。

来自蒙特利尔大学Yoshua Bengio、多伦多大学Geoffrey Hinton、瑞士人工智能实验室Jürgen Schmidhuber、加州大学伯克利分校Stuart Russell、香港中文大学的华云生教授、香港科技大学的杨瓞仁教授、南京大学的周志华教授等人,通过新南威尔士大学官网,向KAIST发出一封公开信:

停止研发自主武器!

KAIST是韩国“清华北大”级名校,以擅长理工技术著称,为何遭到这些学者们的反对?

据英国《金融时报》报道,今年2月以来,KAIST一直在“国防和人工智能融合研究中心”进行四项实验,分别是:

基于人工智能的指挥和决策系统;

水下无人机导航算法;

基于AI的智能飞行器训练系统;

基于AI的对象跟踪和识别技术。

就学术界来说,这些实验看上去很正常。但不正常的地方在于,“国防和人工智能融合研究中心”是KAIST与韩国军工企业“韩华 Systems”合作成立,而韩华Systems的母公司韩华集团(Hanwhua)因为制造集束弹药被联合国列入黑名单。

Hanwha官网

这50多名学者们担心,KAIST研发自主武器将会加速AI军备竞赛,像这样的技术可能导致更大规模的战争加速到来。他们在信中警告,如果成功研制自主武器,战争速度之快、战争规模之大,将是前所未见的,也有可能成为恐怖分子的武器。

在对KAIST的公开信中表示,他们将抵制与KAIST的任何合作,也不会接待KAIST 派出的访客,以及停止所有与 KAIST 的接触,直到KAIST的院长承诺该中心不会研发无需人类操纵的自主武器。

签署联名抗议信的学者来自英国剑桥大学、美国康奈尔大学、加州大学伯克利分校、香港中文大学、香港科技大学、南京大学等五十二所学府,这些学者在人工智能和机器人技术研究方面具领导地位,包括蒙特利尔大学Yoshua Bengio、多伦多大学Geoffrey Hinton、瑞士人工智能实验室Jürgen Schmidhuber、加州大学伯克利分校Stuart Russell、香港中文大学的华云生教授、香港科技大学的杨瓞仁教授、南京大学的周志华教授等。

公开信发出后,KAIST的总裁Sung-Chul Shin表示,听到抵制的消息他感到很难过。“我想重申,KAIST没有任何意图参与开发致命的自主武器系统和杀手机器人。”Shin在一份声明中说。

“作为一个学术机构,我们非常重视人权和道德标准,”他补充说。“我再次重申,KAIST不会进行任何与人类尊严相反的研究活动,包括自主武器。”

“你可以用人工智能做很多伟大的事情来挽救生命,包括在军事中。” 公开信的发起者、新南威尔士大学教授Toby Walsh说,例如军事方面,AI可代替人类执行诸如清除地雷的危险任务,但公开宣布研究目的是为了开发自主武器,却引起极大忧虑。

“这是一个非常受人尊敬的大学与一个道德上可疑的合作伙伴进行的合作,这种合作将继续违反国际规范。”

KAIST是韩国顶级名校,在2016年QS世界大学排名中居亚洲第6、世界第43位。

KAIST官网

早在2014年,KAIST就研发出名为Raptor的双腿机器人,当时它的速度可以达到46公里/小时,甚至为其配备了一条类似于爬行动物的尾巴以达到平衡。

强大的科研能力,如果被用到军事领域,自然会引起社会关注和质疑,更何况,Hanwha Systems被Toby Walsh认为是一家“道德上可疑”的公司。

而早被联合国列入黑名单的韩华集团,曾制造集束弹药。根据维基百科,集束炸弹是将小型炸弹集合成一般空用炸弹的型态,利用数量的特性增加涵盖面积和杀伤范围。在叙利亚战争、利比亚内战期间都出现过使用集束炸弹的情况,杀伤力极大。

韩华集团同时也是韩国最大武器生产商之一,根据《集束弹药公约》(CCM),韩华生产的集束炸弹,被一百二十个签署国禁止使用,不过韩国、美国、俄罗斯和某些国家并没有签署该项国际条约。

集束炸弹(图据stopclustermunitions.org)

另据英国卫报报道,韩国的Dodaam Systems公司已经生产出一种完全自主的“作战机器人”,它是一种静止的炮塔,能够自主探测3公里外的目标。客户包括阿拉伯联合酋长国和卡塔尔,并且已经在朝韩边界上进行了测试。

Toby Walsh教授认为,从更宏观的角度来看,KAIST与韩华合作发展自主武器,也会使朝鲜半岛的安全局势更加恶化。

人工智能在世界各地的军队中的使用引发了人们对类似“终结者”的担忧,并提出了关于这种武器的准确性以及区分朋友和敌人的能力的问题。在下周,联合国将在日内瓦举行关于自主武器的会议,这些来自20多个国家的50多名学者,希望能够彻底禁止杀手机器人。

在50多名署名公开信中,南京大学人工智能学院院长、计算机系教授周志华是唯一一名内地学者,此外公开信的签署人还包括香港中文大学的华云生教授、香港科技大学的杨瓞仁教授等。

周志华教授

新智元向周志华教授询问关于参与KAIST公开信一事,截止发稿时,周教授尚未回复。不过,去年5月,National Science Review (《国家科学评论》)发表了一篇周志华教授采访美国俄勒冈州立大学计算机科学荣誉教授、AAAI前主席、国际机器学习学会 IMLS 创始会长 Thomas Dietterich 的采访,其中提及了自主武器系统的观点。

当时周志华向Thomas Dietterich提问:随着机器学习快速发展,人类的工作会受到机器的威胁吗?你可以谈一下“奇点论”和高级AI的威胁的观点吗?

在回答“高级AI的威胁”的部分,Thomas Dietterich不认为AI技术本质上是安全的、我们没有什么可担心的。相反,随着计算机变得更加智能,我们把驾驶车辆,管理电网或打击战争(自主武器系统)等高风险的决策交给了计算机。但是“今天的机器学习技术还不够可靠,也不够强大,不足以被交付这样危险的决策。我非常担心,只要机器学习组件中存在一点错误,AI技术的过早部署都可能导致重大的生命损失。”

而在今年初,周志华曾在“知识分子”上撰文称,“严肃的研究者就不该去触碰强人工智能”的观点,也同样值得再次关注。

周志华教授认为,图像识别、语音识别等方面,机器已经达到甚至超越了人类水平,但它们都是在考虑某种特定类型的智能行为,而不是“完全智能”行为,而“如果目标是制造“工具”,那么考虑特定类型的智能行为就已足够,自主心智、独立意识、甚至情感之类的东西,根本无须考虑。”

除了周志华外,“AI大神”Geoffrey Hinton也曾发表过“比起智能机器人来,更担心自主武器”的观点。

Geoffrey Hinton

对Geoffrey Hinton来说,机器智能已经具备了“制造自主武器的能力,而且它们是真正的危险”。他认为,如果像希特勒这样的人负责大型小型无人驾驶飞机,“那将是多么可怕的事情,我们需要像日内瓦公约这样的条约来限制自主武器的使用。”

2015年7月,来自世界各地的数千名的人工智能研究人员签署了一封公开信,呼吁联合国禁止超出人类控制的攻击性自主武器。2017年8月,有超过100位AI和机器人公司的创始人为此签署了类似的公开信,要求联合国就此问题采取行动。

迄今为止,已有22个国家要求禁止自主武器。

明里暗里,人工智能研究正越来越多地被世界各地的军队用于国防应用。

昨天,纽约时报刊登了由数千名谷歌员工签署的内部抗议联名信,反对谷歌公司参与美国五角大楼的一项名为Project Maven项目,即利用人工智能解读视频图像。该技术有可能被用于提高无人机打击的准确度。

这封目前正在谷歌内部流传的信件获得了超过 3100 份签名,曾经以“不作恶”为口号的谷歌,也正面临尴尬的处境,反映出硅谷和美国联邦政府之间的文化冲突。

随着尖端人工智能技术被越来越多的用于军事目的,这种冲突未来可能进一步加剧。

事实上,人们没有办法阻止AI能力进入攻击性武器。即使世界上最优秀的研究人员拒绝研究攻击性武器的技术,其他人也可以轻易地将这些已被验证的模型“现拿现用”,将其直接应用于新的应用程序。这并不是说武器方面的应用没有其他需要解决的问题,但开发核心的AI能力是开启这些应用的关键。

人工智能是“军民两用”( dual-use)的一个特别棘手的问题。一个很好的例子是核理论,它可以用于核磁共振成像,从而大规模改善人类医疗保健,或者用于为我们的社会提供核反应堆的动力,但它也可以被用于制造大规模致命性的炸弹,杀死无数的人。

AI具有挑战性,因为它不像核武器那样需要独特的硬件来向其他力量表明其发展。今天,我们可以使用消费级无人机、机器枪触发器和从GitHub下载的计算机视觉算法来制造自主杀人无人机。

除非彻底停止开发AI能力,否则AI技术还将继续发展。

换句话说,AI研究人员会杀人,不管他们喜欢与否。但涉及到战争伦理问题时,需要人类文明共同推动。

参考链接:

https://www.engadget.com/2014/05/30/velociraptor-robot-kaist/

http://www.stopclustermunitions.org/en-gb/cluster-bombs/use-of-cluster-bombs/a-timeline-of-cluster-bomb-use.aspx

https://www.bbva.com/en/geoff-hinton-im-concerned-autonomous-weapons-intelligent-machines/

https://techcrunch.com/2018/04/05/should-ai-researchers-kill-people/

https://zhuanlan.zhihu.com/p/33340973

https://www.theguardian.com/technology/2018/apr/05/killer-robots-south-korea-university-boycott-artifical-intelligence-hanwha

https://techcrunch.com/2018/04/05/should-ai-researchers-kill-people/

https://www.cse.unsw.edu.au/~tw/ciair//kaist.html

精彩回顾

2018新智元产业跃迁AI技术峰会圆满结束,点击链接回顾大会盛况:

爱奇艺 http://www.iqiyi.com/l_19rr3aqz3z.html

腾讯新闻 http://v.qq.com/live/p/topic/49737/preview.html

新浪科技 http://video.sina.com.cn/l/p/1722511.html

云栖社区 https://yq.aliyun.com/webinar/play/419

斗鱼直播 https://www.douyu.com/432849

天池直播间 http://t.cn/RnQPhuY

IT大咖说 http://www.itdks.com/eventlist/detail/1992