EMNLP 2021 | 基于证据检索和图神经验证网络的表格事实验证模型

论文名称:Logic-level Evidence Retrieval and Graph-based Verification Network for Table-based Fact Verification

论文作者:施琦,张宇,尹庆宇,刘挺

原创作者:施琦

论文链接:https://aclanthology.org/2021.emnlp-main.16.pdf

转载须标注出处:哈工大SCIR

1. 简介

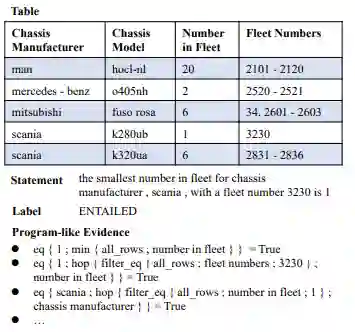

面向表格的事实验证任务的主要目的是根据给定的表格来判断自然语言输入的正确性。如图1所示,不同于其他形式的事实验证系统,表格事实验证任务需要对表格中单元格之间的逻辑关系进行推理,例如“机队数量(number in fleet)最小的所对应的底盘制造商(chassis manufacturer)是斯堪尼亚(scania)”,带有逻辑操作(如“argmax”、”count”)的符号推理在这一任务中起到了非常重要的作用。现有的方法多采用从表格数据中派生出的可执行的逻辑表达式来加强对表格数据的理解。具体来说,这些方法利用弱监督语义解析器为每个候选的逻辑表达式打分,然后选择其中的一个或几个来加强事实验证过程。然而,对于一个逻辑表达式来说,我们只能知道其执行结果和自然语言输入是否一致(label-consistent),而无法判断二者之间是否语义一致(semantic-consistent),故语义解析器中缺少带有有监督标签的逻辑表达式(弱监督语义解析器),从而倾向于选择标签一致的逻辑表达式而不是语义一致的逻辑表达式(伪程序,具有正确返回标签的错误程序),从而不利于对自然语言正确性的验证。理想状态下,利用逻辑表达式的一种相对自然的方式是将它们视为表格的补充证据。换句话说,一些逻辑表达式中包含着必要的逻辑操作,从而可以对表格中观测到的事实进行总结与描述,利用逻辑表达式传达的信息可以更好的理解表格,从而提升表格事实验证任务的性能。本文提出了一种简单有效的范式,利用自动化的方式获取表格中的证据来加强对表格数据的理解,并通过基于图神经网络的方法来对获取到的证据进行建模,在大规模数据集TabFact的实验结果证明了我们提出的方法的有效性。

图1 任务示例

2. 方法

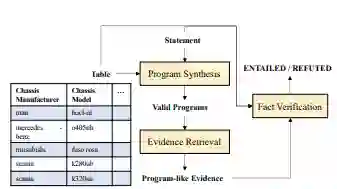

我们的工作将表格事实验证任务定义为了一个证据检索-推理的过程,图2展示了方法的框架,包括程序合成、证据检索以及事实验证三个部分。给定表格和自然语言输入,程序合成模块首先合成具有有效组合的若干逻辑表达式,然后证据检索模块来对这些逻辑表达式进行选择、分解以及过滤,以获取有价值的逻辑表达式作为原始表格数据的补充证据,最后事实验证模型通过表格、自然语言输入以及获取到的逻辑表达式利用基于图神经网络的方法来预测表格与自然语言输入的蕴含关系。程序合成模块我们使用LPA算法[1]来合成,其主要流程是根据表格和自然语言语句进行实体链接,检测语句中所有实体并将其链接到表格中,然后通过在表格上执行子程序并递归存储生成的中间变量的方法来收集一组逻辑表达式。下面我们将主要介绍证据检索以及事实验证模块。

2.1 证据检索

在获得逻辑表达式集合后,我们利用一些简单的规则来获取一些高质量的逻辑表达式作为表格的补充证据:

-

选择所有返回值为“True”的逻辑表达式,从而确保这些逻辑表达式所传达的语义信息是可以从表格中正确观测到的信息。 -

拆分一些过于复杂的证据来简化一些过长的逻辑表达式。 -

对于收集到过多逻辑表达式的例子,去掉其中带有否定含义的逻辑表达式,从而获取语义更相关的证据(例如,队伍的数量是3 vs 队伍的数量不是5)。

通过对表格中包含的信息进行聚合、分解和过滤,我们可以使用这些包含逻辑运算的逻辑表达式来作为表格的补充证据来加强对表格数据的理解。

图2 方法架构

2.2 事实验证

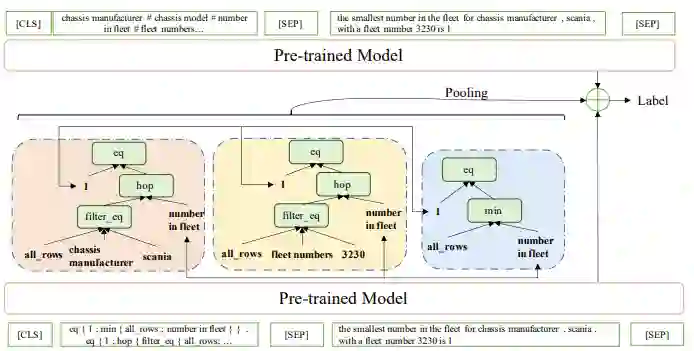

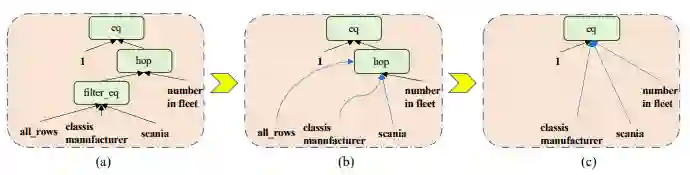

在获取到这些证据后,我们构建一个图来捕捉证据中实体和逻辑函数之间的关系。具体来说,我们保留每个逻辑表达式的结构,自底向上的添加边来学习证据的语义合成性,此外,我们在整个证据集合中具有相同内容的实体节点之间添加边,来将其变为连通图以实现在多个证据之间推理的目的,如图3所示。

图3 模型结构图

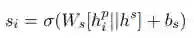

之后,我们利用图神经网络来建模图中的节点来学习不同类型节点的重要性并融合邻居节点的信息,从而进行基于图的推理过程,具体方法如下:

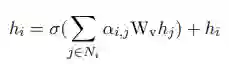

不同节点的类型信息按如下方法建模:

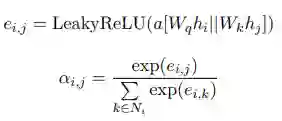

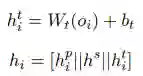

此外,观察到,逻辑表达式中有些节点是“工具”节点,其被设计用来在表格上执行,但其本身与输入的自然语言语句之间是语义不相关的(例如, “filter_eq”, “hop”等等),为了更好的利用证据信息,我们设计了一个动态剪枝的方法来自动移除这些节点,如图4所示。具体来说,我们为图中的每个节点打分,然后根据分数以概率θ来移除分数最低的节点,分数的计算方法如下:

最后,如图4所示,我们整合来自原始表格数据以及来自获取的证据的信息,拼接他们的隐层向量,然后利用常规的分类方法来预测其最终的蕴含关系来验证自然语言语句的正确性。

图4 剪枝方法示意图

3. 实验

3.1 数据集

我们在大规模数据集TabFact[1]上进行了实验,其训练集、验证集、测试集大小分别为92283、12792、12779,测试集包含简单与困难两种模式,大小分别为4171和8608,此外还包含一个大小为2K的人工评价集。

3.2 实验结果

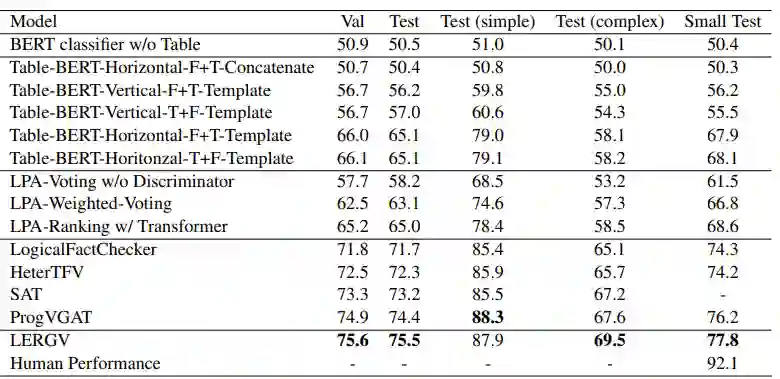

实验结果如表1所示,LERGV为我们的模型,其中,Baseline系统分别为:Table-BERT[1]、LPA[1]、LogicalFactChecker[2]、HeterTFV[3]、SAT[4]、ProgVGAT[5]。

表1 实验结果

3.3 消融实验

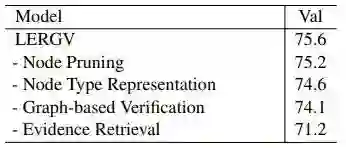

我们对模型的各组成部分进行了有效性分析,其结果如表2所示。

表2 消融实验

4. 结论

在这项工作中,我们在基于表格的事实验证任务上,提出了一个基于逻辑证据检索和基于图神经验证网络的模型。具体来说,我们将该任务定义为了一个证据检索-推理的框架,通过将逻辑表达式定义为表格的补充证据来加强对表格数据的理解。此外,我们利用逻辑表达式的结构构建了图来捕获实体与逻辑运算之间的关系,并提出了一个基于图的验证网络来对不同来源的信息进行整合。未来工作中,我们将探索利用表格中派生出的证据来进行预训练,从而来实现对表格数据的进一步理解。

参考文献

[1] Chen W, Wang H, Chen J, et al. Tabfact: A large-scale dataset for table-based fact verification. arXiv:1909.02164, 2019.

[2] Zhong W, Tang D, Feng Z, et al. LogicalFactChecker: Leveraging Logical Operations for Fact Checking with Graph Module Network. ACL 2020.

[3] Shi Q, Zhang Y, Yin Q, et al. Learn to combine linguistic and symbolic information for table-based fact verification. COLING 2020.

[4] Zhang H, Wang Y, Wang S, et al. Table fact verification with structure-aware transformer. EMNLP 2020.

[5] Yang X, Nie F, Feng Y, et al. Program Enhanced Fact Verification with Verbalization and Graph Attention Network. EMNLP 2020.

本期责任编辑:冯骁骋

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“LGFV” 就可以获取《EMNLP 2021 | 基于证据检索和图神经验证网络的表格事实验证模型》专知下载链接