天池大赛—商场中精确定位用户所在店铺 作品分享

向AI转型的程序员都关注了这个号👇👇👇

大数据挖掘DT数据分析 公众号: datadw

本文初赛、决赛代码 github 地址

在公众号 datadw 里 回复 定位 即可获取。

题目回顾

题目地址:

题目要求给定一条用户的消费记录,求该用户当前所在的店铺。

下面介绍题目数据和评测方式

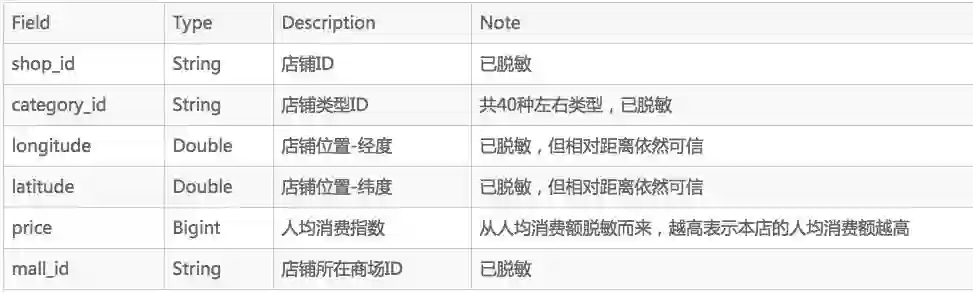

1. 店铺和商场信息表(mall)

2. 用户店铺内交易表(train)

3. 评测集(test)

评测集和和表2差不多,只是把shop_id改为了mall_id

我们的模型需要预测出该数据每一行用户记录的shop_id,并进行提交。

比赛分为A | B榜,A榜数据是9月份第一周数据,B榜数据是9月份第二周数据。

4. 评测方法

比赛的评测方法采用的是accuracy

比赛历程

初赛排名 13 / 2845

拿到这个赛题,第一个想法就是利用经纬度信息,首先水了个经纬度的KNN版本,准确率大概在0.66左右吧。太低。

然后把每条记录的wifi分开,看成一个个的词,类似于NLP中的BOW模型,展开,跑RandomForest多分类,然而内存炸了,果断分mall,就到了0.90。 加上经纬度特征就0.905。 挖到强特就是爽哈哈哈~ 要注意的是wifi强度是负数,我修正为正数了(直接+120)。

此时为了日后能方便的增删特征,尝试不同分类器,于是我重构了代码:

新特征只要继承XXToVec纯虚类,实现 _fit_transform 和_transform结构就行(模仿sklearn的接口)

抽象测试类。 ModelBase,可以设置使用什么分类器、保存模型。最棒的是关于特征只需要传一个list。如

1 2 3 |

task = ModelTest(save_model=False, use_multiprocess=False, save_result_proba=True) vecs = [LocationToVec2(), WifiToVec(), WifiStrongToVec(), WifiKStrongToVec(), PriceToVec(), CategoryToVec2() ] task.train_test(vecs) |

上述的代码使用vecs里的特征,就可以进行训练并评价。(内部就是遍历vecs,然后对每个vec直接调用fit_transform和transform即可)

我感觉我代码写的很好~有了这个框架,之后挖特征写代码就很容易啦。非常松的耦合~代码还不会乱七八糟的。

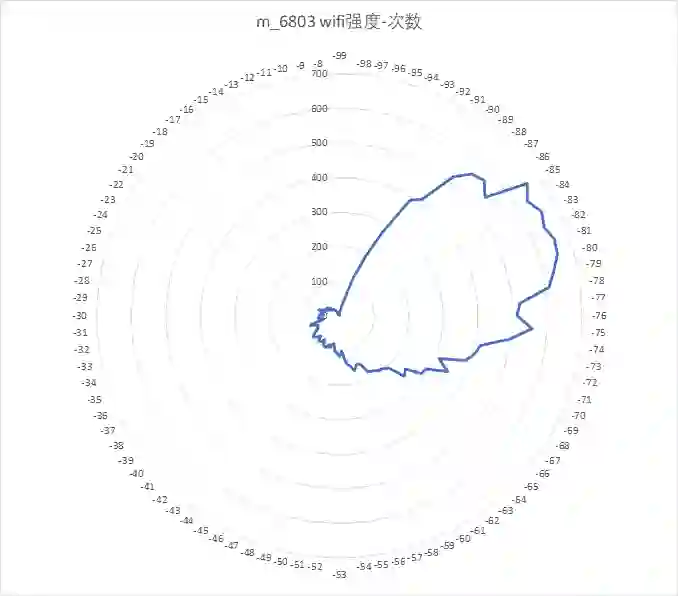

之后开始进行数据的查看,比如同一商场多个bssid如何处理,不同商场有同一个bssid。有的商场得分特别低画出雷达图查看可能是强度普遍偏弱照成的。

然后画出了全部商场的location信息和各个商场中用户和商店的经纬度信息。下图是某mall的可视化结果:

圆形为商家自己提供的经纬度坐标。而三角形是交易发生时的经纬度。中间的矩形则是算出来的商场中心。可以看出,很多用户偏离商店非常远。这和室内GPS信号不好有很大关系。

看到这个我自然就想到要“修正”那些离群点。我的做法是: 如果一个用户a距离商店中心过远,超过商店的长度(用最远商店距离算)一定倍数,那么需要修正。通过wifi信号来计算最近的那个用户b,将b的经纬度写成a的即可。这个修正后有小幅提升。

然后联想到wifi空值处理,取最近经纬度用户的wifi来填充。

队友超超弄了个wifi强度和时间特征,只取最强的那个给我,然后我忘记加时间特征,一交0.9116,下午才发现要是加了时间特征反而更低。然后把wifi空值处理、经纬度修正加上去,立马升到了0.9139嘿嘿,上分美滋滋。

接着队友wqs调参成功,rf的个数400,0.9144。 原来都100的跑。。。

然后我去新中关还有欧美汇实地考察商场,哈哈哈,其实是去吃东西,顺便下了个APP记录wifi信息。

期间超超说做到了0.96,我问怎么做到的,就是他把训练数据中每一条记录对应的shop_id对应的类别作为特征,之后又把price也作为特征,到了0.99几乎全对。然而这个做法是错误的,因为测试数据不知道shop_id,因此也不知道每一条记录对应的category和price。但给我启发:假如我预测出category和price呢?会因为累积误差炸了么?

预测类别一开始失败了,但是回归预测price成功了,提交price的特征版本线上0.9161.

接着看群里影帝的表演,从言语中观察他们应该用的是二分类的方法,于是我也做简单的尝试,采用OneVsRest,线上0.9175,线下0.915269.

这期间麦芽开源了多分类的xgboost版本的baseline,这个baseline线上0.91左右,方法和我们的类似,感觉药丸。 后面的追分真可怕。

然后超超发现bootstrap = false,再跑二分类 线上0.9196,线下0.9174。期间我在试stacking,以及 wifi的tf-idf特征、lightgbm(可能参数没有调好)、PCA等,但是都没啥用。去除了移动热点有小幅提升。然后为了提高代码效率,尝试并行化 data_to_vec和predict,但是Python GIL真是坑,线程不快,进程大量数据传输反而拖慢。然后用生产者、消费者模式加速data_to_vec和predict过程(predict的传递classifier内存会炸,服务器大内存会说太大之类的)。 感觉Python效率真的是卧槽。xgboost跑了几个grid search,太慢了都要放弃了。队友新特征也木有挖出有用的。

没办法了,我上融合把,稳住第一页,用的是比例融合的方式(rf, binary rf, binary xgboost),线上到了0.9234!

这时候我又重新跑了十则的price和category,category终于有用,0.9243!

然后期间还试二分类候选集的,效果不好。接着统计用户特征,做用户偏好,没有考虑冷启动问题,最简单的直接计数法。。。线上0.9264!

这时候开始B榜了,被df的小哥骗了,说会自动抓取之前最好的A榜来计算B榜的。结果木有,浪费了一次机会。提交掉了快6个千,0.9207…

最后融了一个新的多分类xgboost,到了0.92115. 排名13

最后模型如下:

1 2 |

models = ['random forest not price 0.9199', 'binary random forest not price 0.91998', 'binary xgb 0.9149','xgb 0.9123'] weights = [78, 80, 34, 5] # Mean: 0.9240684683620611 |

第二赛季就没怎么打了,线上赛用的PAI平台太坑了。。Create table都要十几分钟。资源限制太不合理了。都没法玩。。对hive也不熟,UDF也不会,分wifi都搞了半天,特征也限制列数不能超过1200好像。也就是BOW wifi会GG。最后水了各个mall取了wifi top 1000,加上经纬度,直接RF多分类,(ps: 用python生成的各个mall的代码)。排45名,挺差的,不过也不怎么在意。

冠军队的做法对比

候选集直接选取目标mall中所有的shop作为候选,为了避免训练集数据量过大,在训练集中进行样本抽样。具体方法是,保留全部正样本,负样本中随机抽取一定比例加入训练集。实际测试,抽样对于模型的精度影响不大。而预测的时候没有抽样,因为速度快。PS: 多分类用商店的特征得展开,二分类就不用。

训练集和测试集的构造方法图示如下:

训练:

| row_id | 候选 | 特征 | label |

| 1 | shop_1 | … | 1 |

| 1 | shop_2 | … | 0 |

| 1 | shop_3 | … | 0 |

| 2 | shop_1 | … | 0 |

| 2 | shop_2 | … | 1 |

| 2 | shop_3 | … | 0 |

测试:

| row_id | 候选 | 特征 | 输出概率 | 预测 |

| 3 | shop_1 | … | 0.6 | |

| 3 | shop_2 | … | 0.8 | |

| 3 | shop_3 | … | 0.9 | √ |

| 4 | shop_1 | … | 0.1 | |

| 4 | shop_2 | … | 0.9 | √ |

| 4 | shop_3 | … | 0.2 |

特征的差异不说,多分类的输出概率作为二分类的特征。

复赛中不一样的,记录如下:

分离信号强度为null的数据。对于信号强度为null的那些数据,强度不论填成多少,对于模型都是个干扰。所以直接去除这一部分数据,用剩下的数据来训练。(我们没有排除。。。)

分区表存储训练数据。如果为每个mall都单独生成一张训练数据表,那么表会太多,而且不断的生成、删除表,会增加任务提交的排队时间。我们的解决方案是用分区表存储所有mall的训练数据,以mall_id作为分区列。模型训练时可以直接指定分区,这样避免了反复的生成表、删除表。

一点感想

第一次打数据挖掘的比赛,得了13名感觉还可以。初赛基本都保持在第一页,每次掉出第一页马上又能冲回去。

不过也犯了一些错误:比如线下的数据集划分不是很好,一开始直接排序取后20%作为验证集,其实最好还是按照线上的取最后一周这样比较好。特征感觉不够多啊。

还有模型的建立缺乏经验,本题确实多分类不如二分类的好。

这比赛学到了很多东西~原来都木有用过xgboost,lightgbm,stacking等~

本文来自 微信公众号 datadw 【大数据挖掘DT数据分析】

比赛经验很重要,对业务理解很重要。前者可以看看别人的比赛的经验学习学习。这比赛中商家提供的经纬度某商场竟然有40多个一样的! (这题给的经纬度精度都达到了分米的级别了!) 不可能49楼大商场把。。我也实地逛了几个商场,感觉是有那种移动的摊位,今天这个,明天那个。然后一开始拿到题目就想到了经纬度肯定有一样的,还想要把商店进行上下分层,为此采集了新中关和欧美汇部分商店的wifi信息。不过我没有时间实践这个想法了,队友后面也没啥激情做这比赛,放弃这想法挺可惜的。后面听经验分享觉得很有道理,不要太早组队,因为你不能确定你的队友到后面是不是很努力,已经组队了都不好意思踢,而且比较后面组队大家想法不太一样,模型融合起来也会比较好。

还有就是机器性能也很重要。实验室两台机器,女票那还有服务器,感觉美滋滋~

还是要多学习才能更厉害~

https://www.hrwhisper.me/tianchi-contest-location-at-mall/

人工智能大数据与深度学习

搜索添加微信公众号:weic2c

长按图片,识别二维码,点关注

大数据挖掘DT数据分析

搜索添加微信公众号:datadw

教你机器学习,教你数据挖掘

长按图片,识别二维码,点关注