超越反向传播,LSTM登顶20世纪AI论文高引No.1,光今年就近7千次

郭一璞 十三 发自 凹非寺

量子位 报道 | 公众号 QbitAI

经典也会被经典超越。

20世纪深度学习研究中,引用最多的论文不再是反向传播。

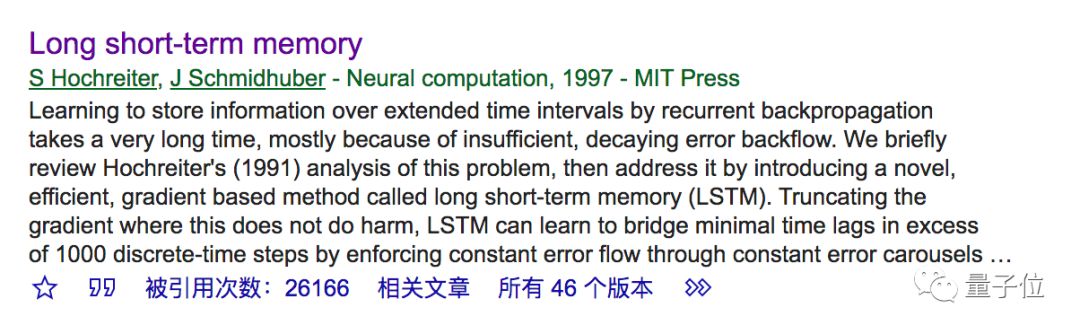

新的宠儿,是1997年Hochreiter和Schmidhuber发表的Long short-term memory。

大名鼎鼎的LSTM。

超越反向传播

LSTM的引用量,目前已经超过了26000。

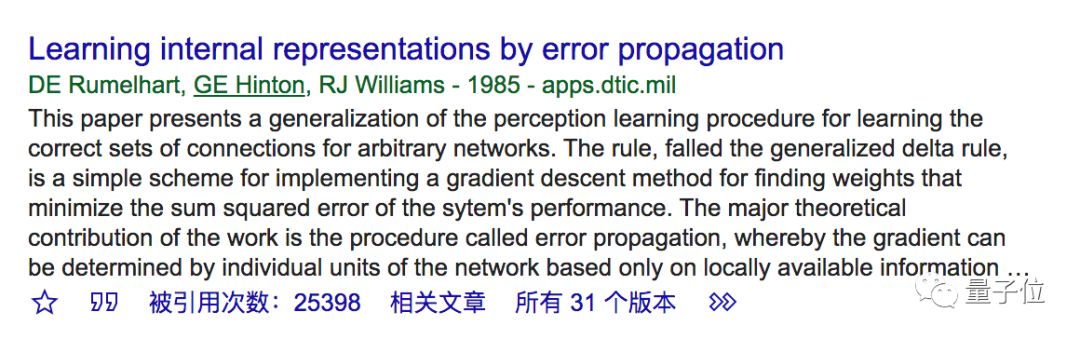

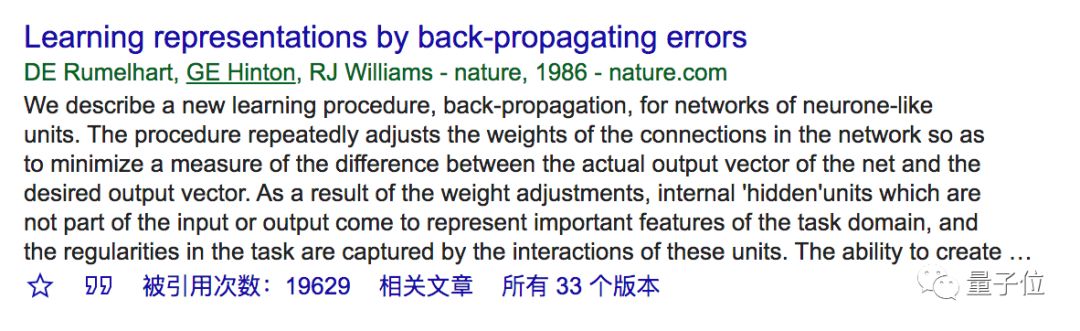

而反向传播,相关的论文虽然不少,但都不再比LSTM高:

如果只算一年,比如马上结束的2019年,根据Google Scholar的结果,DE Rumelhart、GE Hinton、RJ Williams三人组的两篇反向传播论文,今年一整年的引用量加起来足足有3085次。

但新宠LSTM被引用了6750次。

超过前者的两倍。

因此,当一位吃瓜人士将这个数据发布到Reddit的机器学习版块后,它迅速成为了讨论的焦点。

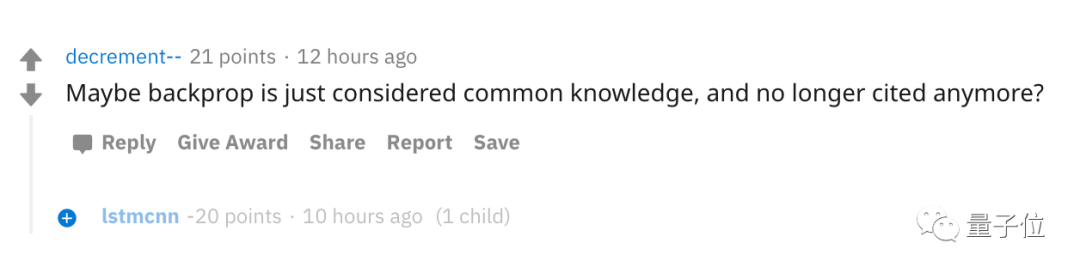

不过,至于反向传播与LSTM两者的地位,在人们心中尚无定论。

有人觉得,可能反向传播引用的太多,历史地位太高,已经被当做了一个常识,所以干脆后来的论文作者们就不引用它了。

但深度学习走到如今这个时代,LSTM有着更广泛的作用。

它部署在了每部智能手机上,它让DeepMind拿到了《星际II》冠军,让OpenAI拿到了Dota冠军。

Schmidhuber的LSTM

1997年,Hochreater和Schmidhuber提出了长短期记忆网络。

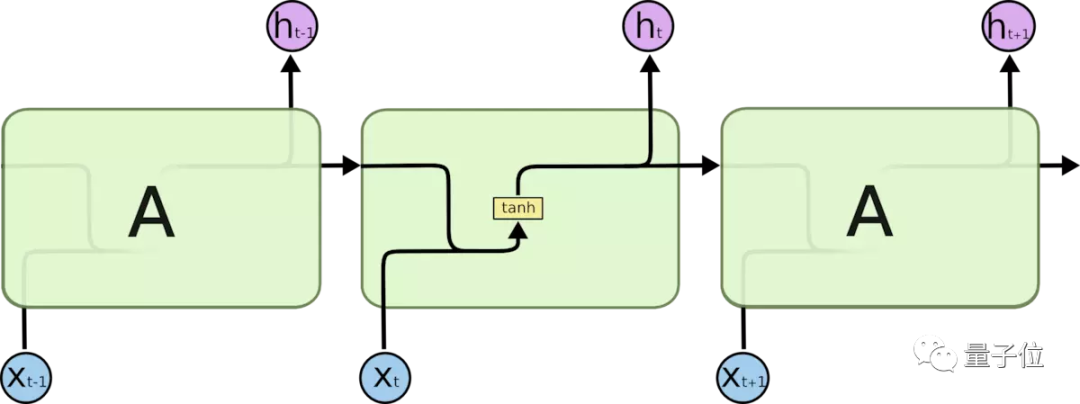

这是一种时间循环神经网络,主要是为了解决一般RNN所存在的长期依赖问题:

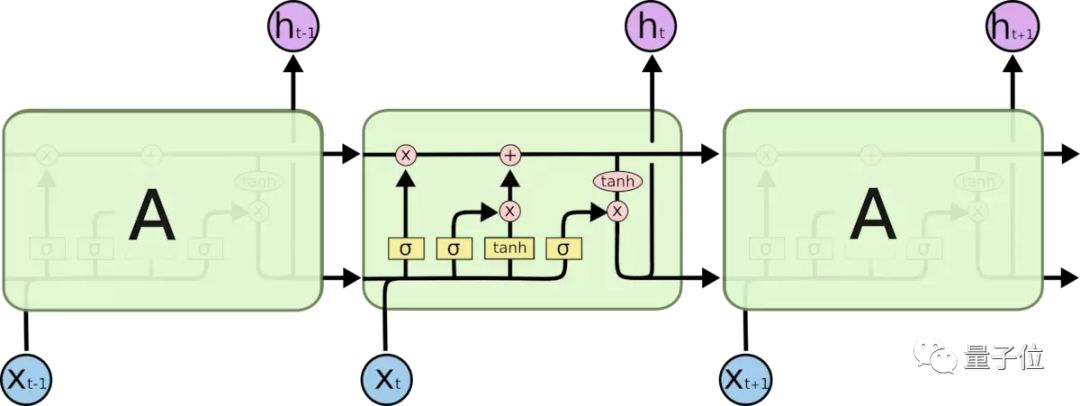

所有的RNN都具有一种重复神经网络模块的链式形式。

在标准的 RNN 中,这个重复的模块只有一个非常简单的结构,例如一个 tanh 层。

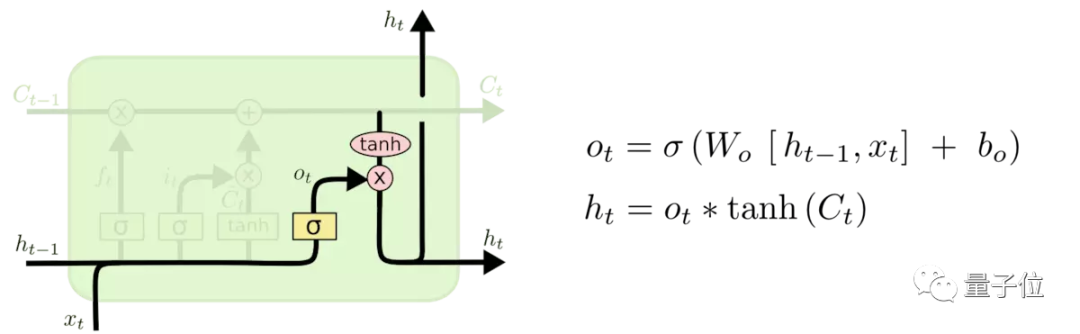

而LSTM也是类似的结构,不同点在于重复模块的结构。

与单一的神经网络层不同,LSTM有四个类似tanh的层,并以一种非常特殊的方式进行交互。

LSTM通过各种门(gate)来实现信息的添加与删除。

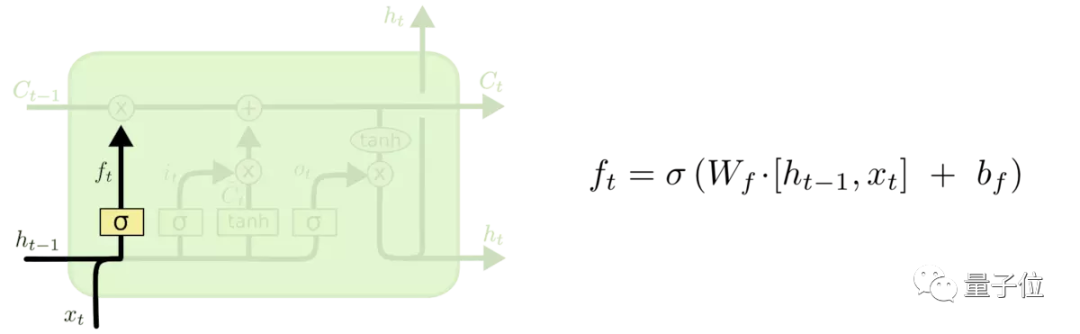

根据谷歌的测试表明,LSTM中最重要的是遗忘门(Forget gate),其次是输入门(Input gate),最后是输出门(Output gate)。

遗忘门

遗忘门决定会从上一个细胞状态中丢弃什么信息,也就是说决定要记住什么和要遗忘什么。

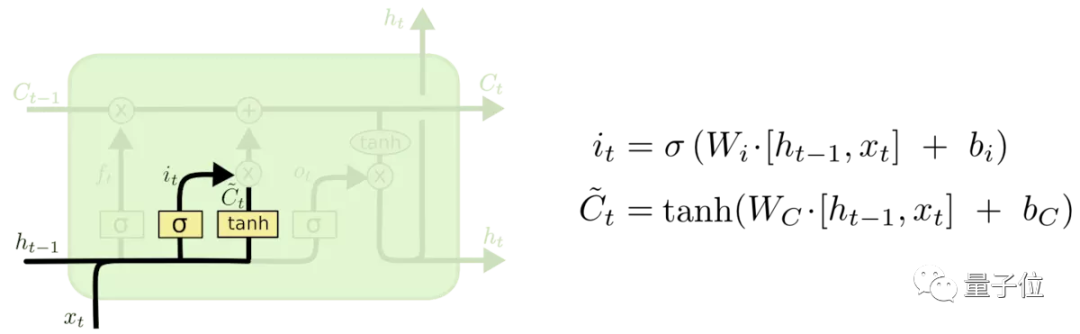

输入门

输入门决定让多少新的信息加入到cell状态中。

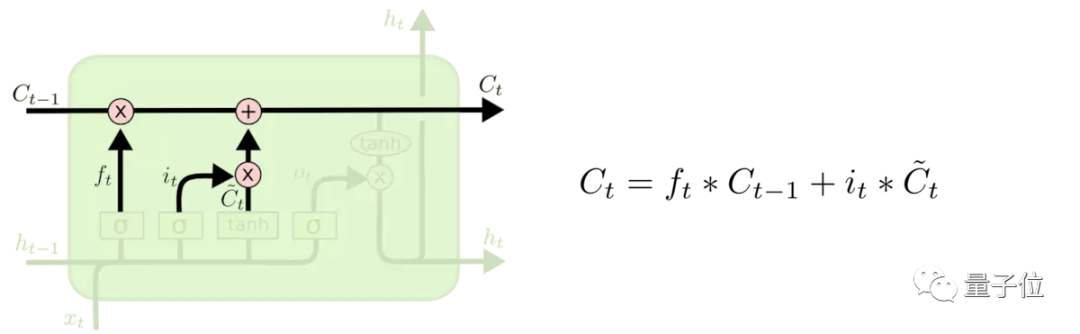

更新细胞状态

把旧状态与ft相乘,丢弃掉确定需要丢弃的信息,再加上经过筛选后的新信息,就得到了当前cell的状态。

输出门

此时,就基于当前的cell状态进行输出。

LSTM的表现通常比时间递归神经网络及隐马尔科夫模型(HMM)更好,还普遍用于自主语音识别,可作为复杂的非线性单元用于构造更大型深度神经网络。

两位传奇作者

LSTM的作者Sepp Hochreiter和Juergen Schmidhuber二人都来自德国,

Sepp Hochreiter,现在是奥地利约翰内斯开普勒大学机器学习研究所的负责人,LSTM是他在慕尼黑工业大学的硕士毕业论文。

博士毕业后他也曾在柏林科技大学、科罗拉多大学、慕尼黑工业大学等高校任职,对强化学习、计算机视觉、NLP和生物信息学方面都有研究。

而他的老师,LSTM共同作者Juergen Schmidhuber则是一位充满争议的大牛,他现在是达勒·莫尔人工智能研究所的负责人,也曾在卢加诺大学、慕尼黑工业大学任教,开了自己的公司NNAISENSE。

不过,之所以说他充满争议,是因为他的研究总是和其他人的研究莫名撞车,和深度学习三巨头、图灵奖得主Yoshua Bengio、Geoffrey Hinton、Yann LeCun都有过纠纷,还曾跟Ian Goodfellow争吵过GAN到底算谁的。

贵圈有点复杂。

One More Thing

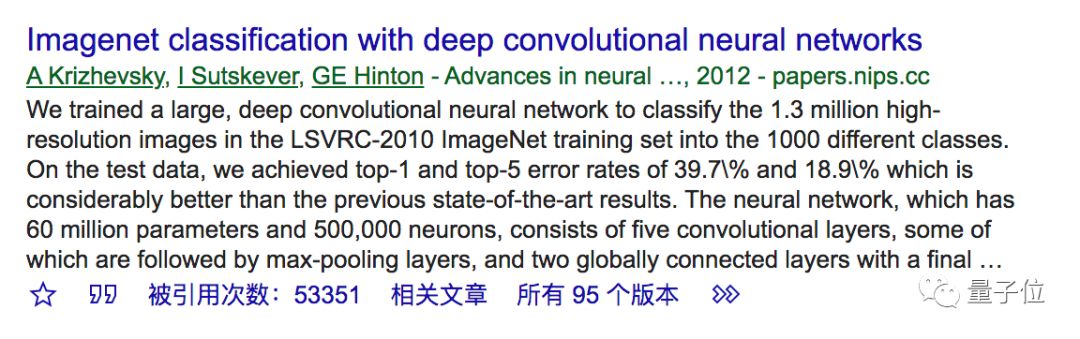

最后,说了这么多上世纪最火论文,你知道本世纪最火的深度学习论文是哪篇吗?

Hinton等大佬发在NeurIPS 2012上的Imagenet classification with deep convolutional neural networks,引用超过53000。

毕竟也是有历史意义的ImageNet 2012得胜选手。

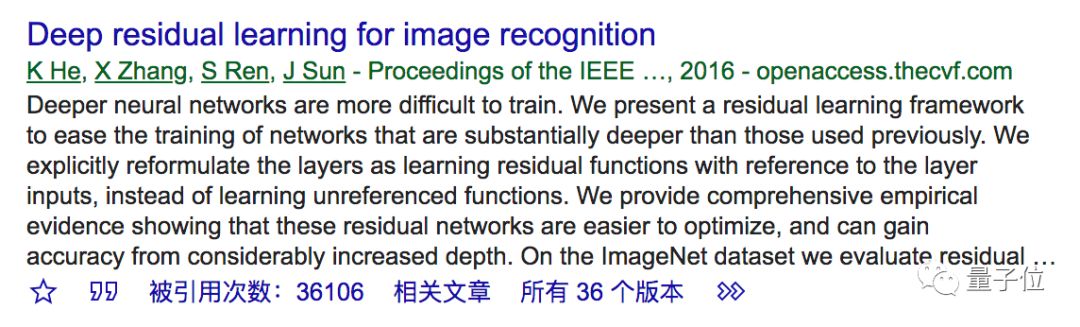

另外,CVPR 2016最佳论文Deep Residual Learning for Image Recognition,引用次数也超过了36000。

这几位作者何恺明、张祥雨、任少卿、孙剑也都是当今华人AI圈的佼佼者了。

参考链接:

https://www.reddit.com/r/MachineLearning/comments/eg8mmn/d_the_1997_lstm_paper_by_hochreiter_schmidhuber/

https://en.wikipedia.org/wiki/Long_short-term_memory

— 完 —

AI内参|把握AI发展新机遇

拓展优质人脉,获取最新AI资讯&论文教程,欢迎加入AI内参社群一起学习~

跟大咖交流 | 进入AI社群

量子位 QbitAI · 头条号签约作者

վ'ᴗ' ի 追踪AI技术和产品新动态

喜欢就点「在看」吧 !