从AlexNet到胶囊网络,CNN这五年(视频详解)

大数据文摘字幕组作品

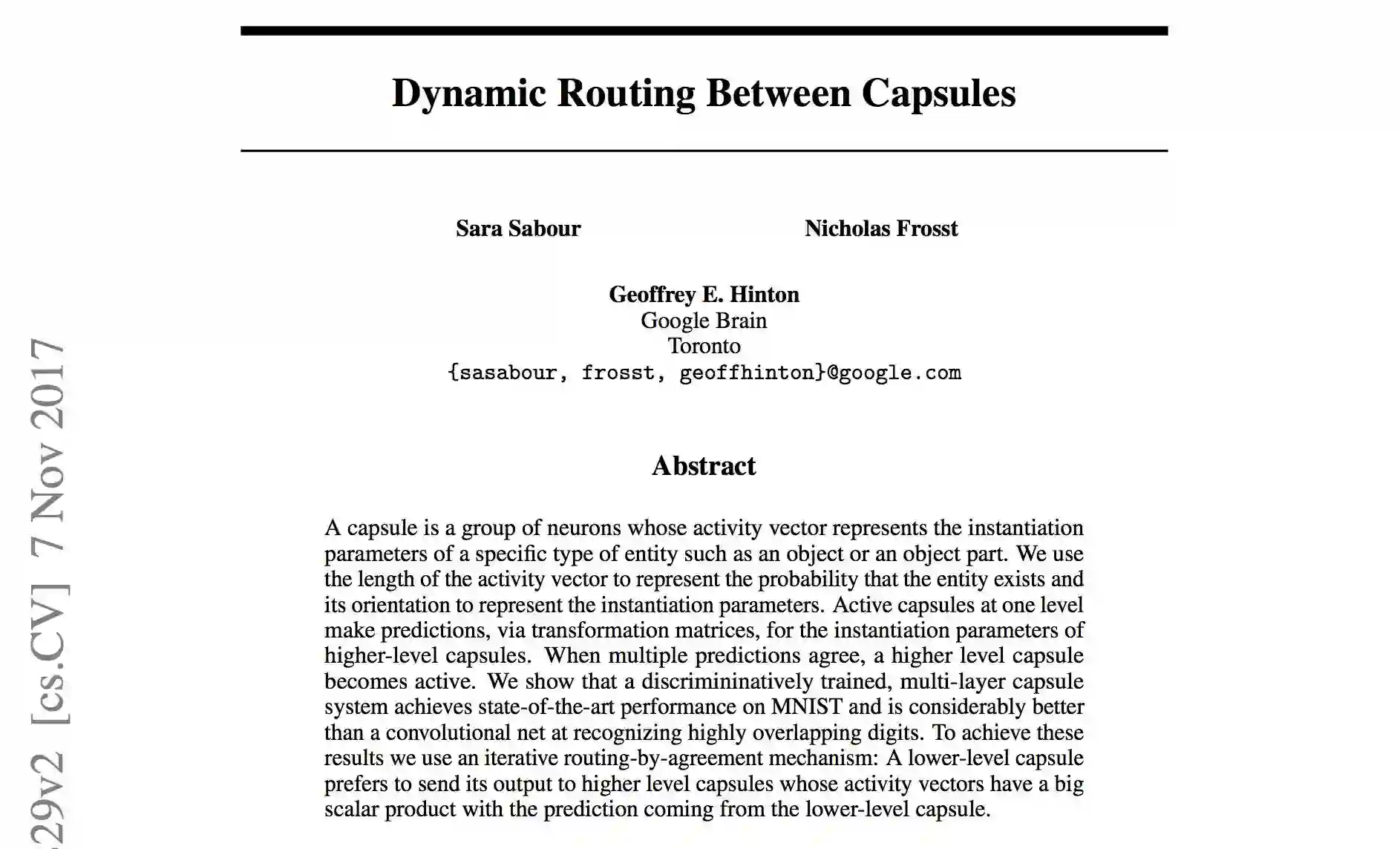

今年11月7日,Geoffrey Hinton老爷子发表了“Dynamic Routing Between Capsules”的论文,提出了“胶囊网络”,胶囊网络在MNIST手写数字识别上的表现超过了CNN,一时引发了热议。

毕竟,如果Hinton说这玩意儿好用,那它很有可能真的好用!

Hinton现任加拿大多伦多大学教授,同时是谷歌大脑在加拿大的负责人。听起来好像没啥特别的 (⊙ˍ⊙)

不过随便一搜,1947年出生的他有各种头衔加持:”深度学习之父“、”开山鼻祖“……对,他就是在80年代就提出了反向传播算法,不久前又选择抛弃它的那个老头😆

左起Yann LeCun,Geoffrey Hinton,Yoshua Bengio,Andrew Ng(图片来自吴恩达Facebook页面)

第一波推动CNN应用的Yann LeCun(Facebook人工智能实验室主任、纽约大学教授),就是Hinton的博士后。

此外,据传伯克利的Michael I.Jordan教授(吴恩达的导师)当年申请Hinton的博士后没有被录取⊙o⊙ Michael I.Jordan教授不久前曾到清华大学授课,点这里查看独家听课笔记。

那么,胶囊网络到底有什么特别呢?为什么Hinton认为它比CNN还牛?

大数据文摘字幕组经授权翻译了YouTube网红Siraj Raval的一段详解胶囊网络的视频,试图从CNN的历史沿革开始,通过几次大的性能提升告诉你胶囊网络和此前的CNN有什么不同。

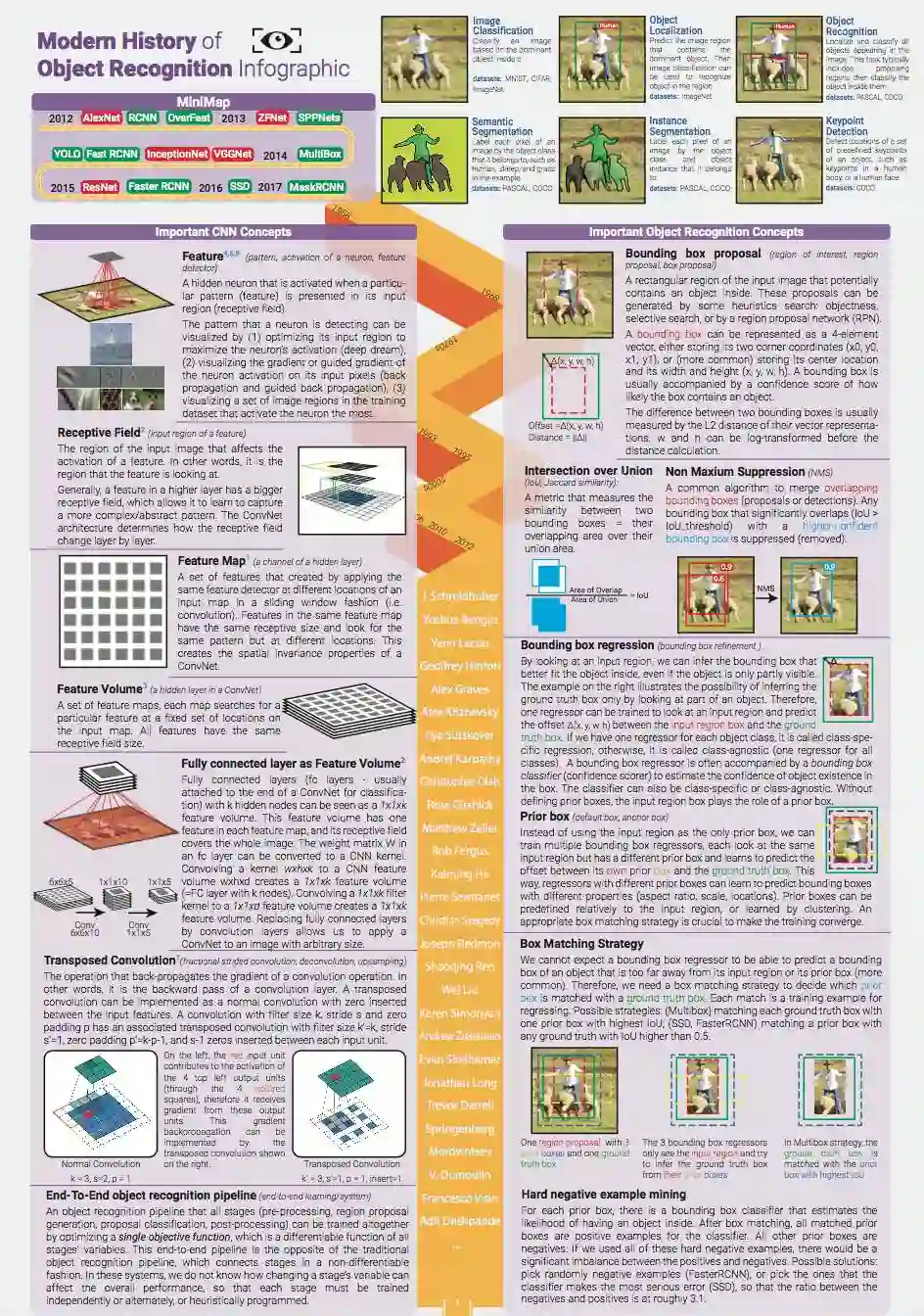

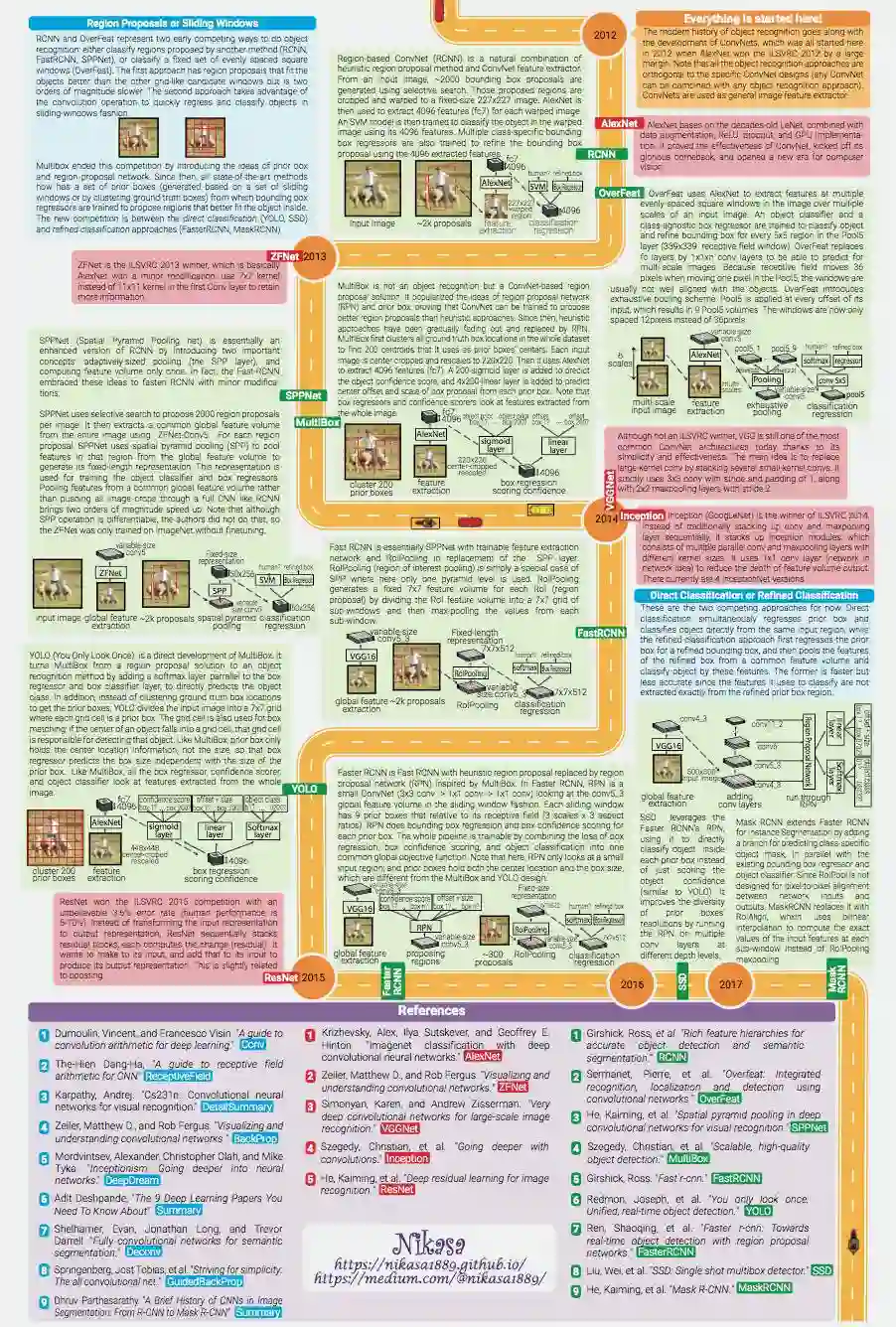

让我们先来看一张大图。

图:物体识别简明史,来源见文末。

进入大数据文摘公众号,后台对话框回复“大图”,获取大图高清PDF版

虽然相关算法80年代就已经提出,让神经网络这一玩儿法真正进入了人们的视野的,是数据量和算力极大扩充之后,在2012年横扫ImageNet比赛的AlexNet。AlexNet加入了ReLU和Dropout的概念,从而解决了权值消失的问题,并能防止过拟合。

在这之后一个大的提升是VGG网络,它增加了很多很多层(^._.^)ノ

再然后,GoogleNet在一个层的输入上进行了多个不同内核大小的卷积操作,最后把这些操作的结果连接起来,作为下一层的输入。

在这之后是ResNet。ResNet的思想是,如果我们不断的叠加网络,接下来如果你继续添加更多的层,网络性能会开始下降。那么就在每两层后加入一个加法运算,这样就改善了梯度消失的问题。

网络被设计得越来越深了,但卷积神经网络在识别带有旋转角度、颠倒等”不正常“的图片时表现特别不好。我们需要一个更加泛化的算法。这对目前无人驾驶的应用来说尤为重要——我们不能总是期待图像是正着出现的。

卡戴珊的眼睛和嘴互换位置,这张图仍被CNN识别为“person”

于是,我们有了Hinton的胶囊网络。它可以被理解为“张量神经元”,即输入和输出都是张量。

更多关于胶囊网络的详细解释

请点击观看视频

时长22分钟

▼

视频还附有胶囊网络论文在TensorFlow上的实现代码哟!

原视频地址:

https://www.youtube.com/watch?v=VKoLGnq15RM

物体识别简明史大图:

https://medium.com/@nikasa1889/the-modern-history-of-object-recognition-infographic-aea18517c318

胶囊网络论文的TensorFlow实现代码地址:

https://github.com/naturomics/CapsNet-Tensorflow

翻 译 | Carrey 王、qz517、雪梨兔、周杨、Jenny

校 对 | 糖竹子

时间轴+后期 | 龙牧雪

文案+统筹 | 龙牧雪

稀牛学院+网易云课堂

隆重推出人工智能系列公开课

业内一线大咖

稀牛王牌讲师

带给你最贴心的全套学习指南!

入门 转行 应用

资料 答疑 互动

扫码了解详细信息哦~

志愿者介绍

回复“志愿者”加入我们

往期精彩文章

点击图片阅读

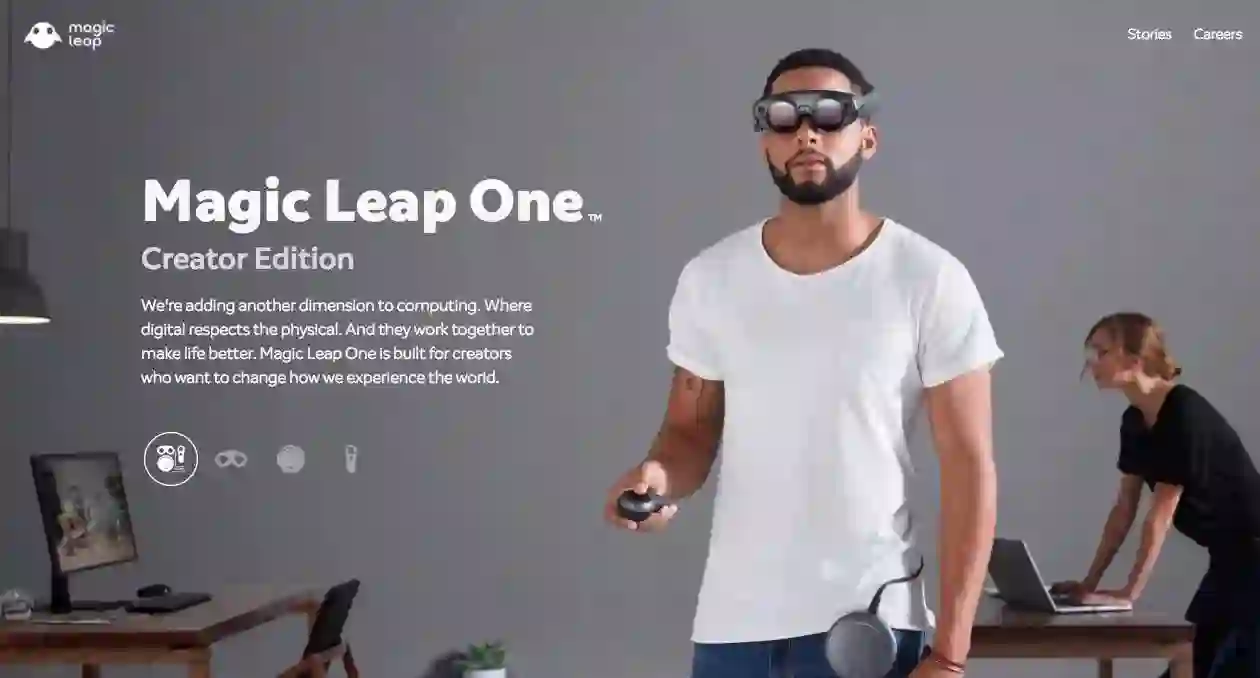

那个让鲸鱼跃出篮球场的Magic Leap,终于发布了一款AR眼镜