一键即运行!清华团队推出图深度学习工具包CogDL v0.1

一行代码命令可以做什么?

“一行命令可以实现‘一条龙’运行实验。”

访问 github.com/THUDM/cogdl 一键体验!

但是,由于许多项目的代码并未开源或者开源代码的风格多种多样,研究者和使用者在使用这些方法的过程中会遇到各种各样的问题,比如实验复现以及如何在自己的数据集上运行模型等。

具体而言(以学术研究为例),研究者和使用者在从事研究过程中需要将自己提出的模型与其他模型进行对比,来验证所提出模型的有效性。但在对比过程中,他们需要选定若干个下游任务,在每个任务下,通过公平的评估方式来对比不同模型的性能,由于不同模型在提出时可能会使用不完全一致的下游任务或者评估方式,他们需要花费大量精力修改基线模型来进行适配。

那么,如何快速、便捷地复现出基线模型(baseline)的结果,并将这些模型应用到自定义的数据集上?

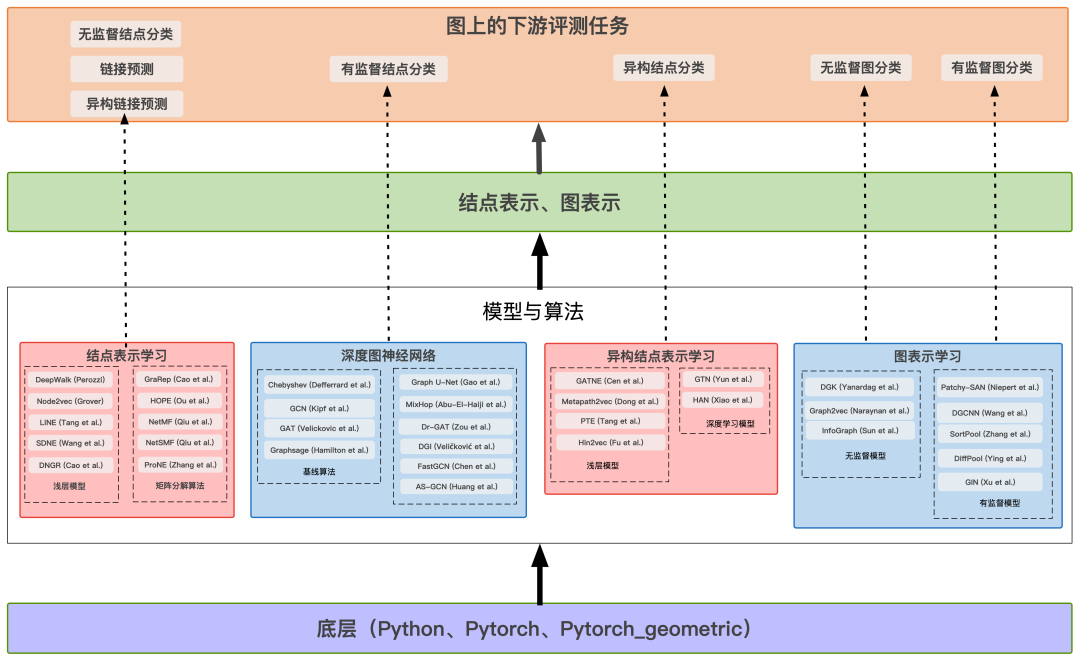

为此,清华大学知识工程实验室(KEG)联合北京智源人工智能研究院(BAAI)开发了一种基于图深度学习的开源工具包——CogDL(底层架构为 PyTorch,编程语言为 Python)。

据 CogDL 开发者介绍,该工具包通过整合多种不同的下游任务,同时搭配合适的评估方式,使得研究者和使用者可以方便、快速地运行出各种基线模型的结果,进而将更多精力投入研发新模型的工作之中。

“ 对图领域中每种任务,我们提供了一套完整的“数据处理-模型搭建-模型训练-模型评估”的方案,易于研发人员做相关的实验。 比如对于图上半监督节点分类任务,我们整合了常用的数据集 Cora、Citeseer、Pubmed,提供了经典的/前沿的各种模型(包括GCN、GAT、GCNII 等),提供了相应的训练脚本,并且整理出了一个相应的排行榜作为参考。” CogDL 开发者说。

CogDL 最特别的一点在于它以任务(task)为导向来集成所有算法,将每一个算法分配在一个或多个任务下,从而构建了 “数据处理-模型搭建-模型训练和验证” 一条龙的实现。

# GCN 和 GAT 在 Cora 和 Citeseer 上的实验python scripts/train.py --task node_classification --dataset cora citeseer --model gcn gat

-

有监督节点分类任务(node classification):包括 GCN、GAT、GraphSAGE、MixHop 和 GRAND 等; -

无监督节点分类任务(unsupervised node classification):包括 DGI、GraphSAGE(无监督实现),以及 Deepwalk、Node2vec、ProNE 等; -

有监督图分类任务(graph classification):包括 GIN、DiffPool、SortPool 等; -

无监督图分类任务(unsupervised graph classification):包括 InfoGraph、DGK、Graph2Vec 等; -

链接预测任务(link prediction):包括 RGCN、CompGCN、GATNE 等; -

异构节点分类(multiplex node classification):包括 GTN、HAN、Metapath2vec 等。

CogDL 还包括图上的预训练模型 GCC,GCC 主要利用图的结构信息来预训练图神经网络,从而使得该网络可以迁移到其他数据集上,来取得较好的节点分类和图分类的效果。

跟进 SOTA。 CogDL 跟进最新发布的算法,包含不同任务下 SOTA 的实现,同时建立了不同任务下所有模型的 leaderboard(排行榜),研究人员和开发人员可以通过 leaderboard 比较不同算法的效果。

自定义模型和数据。 “数据-模型-训练”三部分在 CogDL 中是独立的,研究者和使用者可以自定义其中任何一部分,并复用其他部分,从而提高开发效率。

# 监督GraphSAGEpython scripts/train.py --task node_classification --dataset pubmed --model graphsage -seed 0 1 2 3 4 5# 无监督GraphSAGEpython scripts/train.py --task unsupervised_node_classification --dataset pubmed --model unsup_graphsage# DeepWalk + Node2Vec算法 + BlogCatalog + Wikipedia数据集python script/train.py --task unsupervised_node_classificatoin --dataset blogcatalog wikipedia --model deepwalk node2vec

# 获取模型/数据/训练的参数args = get_default_args()args.task = 'node_classification'args.dataset = 'cora'args.model = 'gcn'# 建立数据集dataset = build_dataset(args)args.num_features = dataset.num_featuresargs.num_classes = dataset.num_classesargs.num_layers = 2# 建立模型model = build_model(args)# 训练+验证task = build_task(args, dataset=dataset, model=model)ret = task.train()

CogDL 开发者表示,“起初,我们只是整合了实验室内部从事相关领域研究的同学所使用的相关代码,为了方便实验室其余的同学运行相关的实验。后来,我们决定将代码开源出来,让更多的研究和开发人员能够借助我们的代码从事相关工作。”

如今,CogDL 已经上线了 CogDL v0.1.1。

“我们增加了一些最前沿的图神经网络模型,包括图自监督模型、图预训练模型。用户可以利用图上预训练好的模型做不同的下游任务。在下游任务方面,我们增加了知识图谱的链接预测任务,方便从事知识图谱领域的用户进行相关实验。” CogDL 开发者说。

具体而言,在监督节点分类任务上,增加了 GRAND 和 DisenGCN,GRAND 在 Cora、PubMed、Citeseer 上取得了 SOTA 或者接近 SOTA 的效果;无监督节点分类任务上,增加了 DGI、MVGRL、GraphSAGE(无监督实现);在链接预测任务上,增加了知识图谱上的链接预测 GNN 模型 RGCN 和 CompGCN;以及增加了图上的预训练模型 GCC。

另外,CogDL 也提供了使用 optuna 进行超参数搜索的 example,通过指定 "模型,数据集,参数" 即可自动实现超参数的搜索。

接下来,CogDL 研究者希望在现有基础上,继续补充其余的图领域的下游任务,添加更多的数据集,更新每个任务的排行榜;同时增加最前沿的关于预训练的图神经网络模型,支持用户直接使用预训练好的模型来进行相关应用;以及完善 CogDL 的教程和文档,让刚接触图领域的初学者能够快速上手。

谈及最终的愿景,CogDL 研究者表示,一方面希望从事图数据领域的研究人员可以方便地利用 CogDL 来做实验,另一方面希望面向实际应用的开发人员可以利用 CogDL 来快速地搭建相关下游应用, 最终打造一个完善的图领域的研发生态。

https://github.com/THUDM/cogdl

CogDL 0.1.1 release 详细信息

https://github.com/THUDM/cogdl/releases/tag/0.1.1

登录查看更多

相关内容

Arxiv

0+阅读 · 2021年1月28日